- •1 Автоматизированная система управления цехом в информационной системе«Производственный менеджмент».

- •2 Адаптивное и интеллектуальное программное обеспечение (по). Прикладные программы с высокой степенью автоматизации управления. Основные направления интеллектуализации по.

- •3 Анализ использования материальных ресурсов.

- •4 Анализ ритмичности работы организации

- •5 Анализ себестоимости продукции, работ и услуг

- •7 Архитектура case-средств. Классификация case-средств. Аспекты выбора case-средств для проектирования экономической информационной системы (эис).

- •8 Архитектура системы «эод», действующей в налоговых органах местного уровня

- •9 Архитектура субд. Функции субд. Встроенный sql

- •10 Аутентификация пользователей на основе паролей

- •11 Аутентификация пользователей по их биометрическим характеристикам

- •12 Базы данных. Определение. Классификация. Этапы развития

- •13 Биологический и формальный нейрон

- •14 Биржевая и финансовая информация: поставщики и потребители

- •15 Блок-схема. Используемые символы (в соответствии с гост 19.701-90).

- •16 Бухгалтерский баланс

- •17 Виды активных и пассивных операций банков с ценными бумагами.

- •18 Виды и этапы процесса контроля достижения организацией своих целей

- •19 Виды информации, хранимой в Интернет и профессиональных базах

- •20 Виды коммуникаций, используемых в процессе управления организацией. Отметьте достоинства и недостатки.

- •21 Виды организационных структур и их характеристики. Какое программное обеспечение можно использовать для построения организационной структуры предприятия.

- •22 Виды рынков товаров

- •24 Виртуальные машины. Основные термины и определения. Примеры виртуальных машин.

- •25 Вирусы в файлах документов

- •26 Внутренние и внешние ситуационные переменные организации

- •27 Вредоносные программы и их классификация

- •28 Геоинформационные системы.

- •29 Группы процессов жизненного цикла экономической информационной системы (эис) (основные, вспомогательные, организационные).

- •30 Дайте комментарий и представьте график жизненного цикла товара

- •31 Дайте определение понятию «интеллектуальный капитал»

- •32 Дайте определение понятию «маркетинг менеджмент»

- •33 Дайте определение понятию «управление» с позиций процессного подхода.

- •34 Дайте определения понятиям «лидерство», «власть» и «влияние».

- •35 Даталогическое проектирование базы данных.

- •36 Дебетовое и кредитовое сальдо. По каким счетам(активным/ пассивным) оно отражается по дебету счета, а покаким – по кредиту счета.

- •37 Демоны Linux.

- •38 Динамическая память и указатели.

- •39 Динамические структуры данных.

- •40 Документальное оформление наличия и движения материально-производственных запасов.

- •41 Документальное оформление наличия и движения основных средств.

- •42 Документальные информационные системы.

- •43 Жизненный цикл (жц) экономической информационной системы (эис). Модели жц эис. Стадии и этапы разработки эис.

- •44 Жизненный цикл информационных систем.

- •45 Жизненный цикл программного обеспечения (по). Определение жизненного цикла по.

- •46 Жизненный цикл проекта.

- •47 Загрузочные и файловые вирусы.

- •48 Задачи информационного менеджмента в управлении и формировании организационных структур информационных систем.

- •49 Записи (структуры) (Pascal, c, c#).

- •51 Защита информации в банковских сетях.

- •52 Идентификаторы, комментарии, арифметические операции (Pascal, c, c#).

- •53 Иерархия планов предприятия. Отличия стратегического плана от бизнес-плана предприятия.

- •54 Индексирование данных.

- •55 Индустриальное проектирование экономических информационных систем.

- •56 Инструменты проведения денежно-кредитнойполитики.

- •57 Интегрированная система моделирования технологических процессов на предприятии aris.

- •58 Интернет-реклама. Особенности. Виды. Оценка эффективности.

- •59 Инфологическое проектирование базы данных.

- •61 Информационно-поисковые языки.

- •62 Информационные ресурсы сети Интернет. Классификация и примеры.

- •63 Информационные системы инвестиционного менеджмента. Характеристика программного продукта Про-Инвест – ProjectExpert.

- •64 Информационный менеджмент. Его место. Предмет. Задачи. Возникновение информационного менеджмента как самостоятельной дисциплины.

- •65 Инфраструктура сетевой экономики.

- •66 Исключения в объектно-ориентированном программировании.

- •67 История вычислительной техники. Этапы развития эвм. Поколения эвм. Архитектура фон Неймана.

- •68 История развития операционных систем.

- •69 История развития семейства oc Windows. Версии Windows.

- •70 Как называют класс информационных систем, обеспечивающих маркетинговую концепцию взаимодействия. Перечислите состав основных модулей по и их назначение.

- •71 Как определить эффективность деятельности предприятия. В чем отличие показателей эффективности от результативности. Приведите примеры индикаторов эффективности.

- •72 Какие виды обеспечения ссуд наиболее распространены в отечественной практике на сегодняшний день.

- •73 Какие операции банков с ценными бумагами относятся к инвестиционным.

- •74 Какие факторы следует учитывать при анализе внешней среды организации.

- •75 Какие факторы следует учитывать при обследовании внутренних сторон организации.

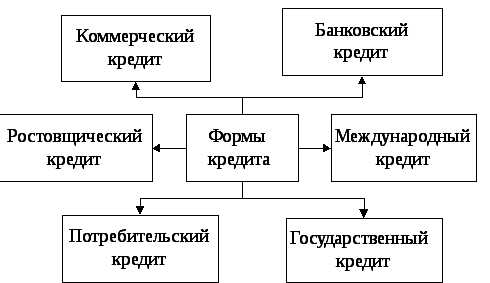

- •76 Какие формы кредита, и какие методы кредитования получили наибольшее распространение в практике отечественных банков настоящее время.

- •77 Какими этапами характеризуются системы развития автоматизированных банковских систем (абс).

- •78 Какую роль в формировании ресурсной базы банка играют собственные и привлеченные средства.

- •79 Каноническая и индустриальные технологии проектирования.

- •80 Кассовое планирование. С какой целью оно проводится и как осуществляется прогноз движения наличности.

- •82 Классификация методов менеджмента.

- •84 Классификация производственных затрат.

- •85 Классификация стандартов. Международные организации, разрабатывающие стандарты. Национальные организации, разрабатывающие стандарты.

- •86 Классические криптографические системы. Классификация шифров. Методы криптоанализа классических шифров.

- •87 Количественные и качественные оценки стратегического плана.

- •88 Комплексная система автоматизации управления предприятием «Галактика». Характеристика основных контуров системы «Галактика».

- •89 Концепции объектно-ориентированного программирования (классы, инкапсуляция свойств объекта).

- •90 Кредитный портфель банка и от чего зависит его структура.

- •91 Криптографические системы с открытым ключом. Общая схема коммуникации с использованием асимметричных ключей.

- •Преимущества открытых ключей

- •92 Массивы (Pascal, c, c#).

- •93 Математическая модель формального нейрона. Математическое описание нейронной сети. Схемотехника нейронных сетей.

- •94 Материально-производственные запасы и их классификация.

- •95 Международные организации, разрабатывающие стандарты. Национальные организации, разрабатывающие стандарты. Внутрифирменные (внутри корпоративные) стандарты.

- •96 Место и роль банков в денежном обращении.

- •97 Методы анализа аудитории проекта.

- •98 Методы и модели представления знаний. Логическая модель представления знаний. Семантическая модель представления знаний. Фреймовая модель представления знаний.

- •100 Методы и технологии создания программного обеспечения и их определение и характеристика.

- •101 Методы калькулирования себестоимости продукции.

- •102 Методы обучения нейронных сетей.

- •103 Методы поиска решений в экспертных системах. Логический и эвристический методы поиска решений в экспертных системах.

- •104 Методы практического извлечения знаний.

- •105 Методы продвижение проекта.

- •107 Методы трансляции. Краткая характеристика. Преимущества и недостатки. Компоновщик.

- •108 Методы, используемые для реализации стратегического плана предприятия.

- •109 Механизм поддержания достоверной информации в системе управления участком, цехом, предприятием.

- •110 Множественное наследование в объектно-ориентированном программировании.

- •111 Модели данных (er, иерархическая, сетевая, реляционная и т.Д.).

- •112 Модели и методы управления организацией. Применение экспертных систем и нейросетевых методов в задачах принятия решений.

- •113 Модели и стадии жизненного цикла (жц) программного обеспечения (по). Взаимосвязи между стадиями и процессами жц.

- •114 Модели транзакций. Распределённая обработка данных.

- •115 Модели электронного бизнеса b2b, b2c иC2c.

- •116 Модель osi. Топология. Методы доступа к среде передачи.

- •117 Модульное программирование.

- •118 Надежность программного обеспечения (по). Математические модели оценки характеристик качества и надежности по.

- •119 Назначение и состав программного комплекса «Регион», функционирующего в фнс на региональном уровне.

- •120 Назначение и характеристика программы 1с:Бухгалтерия предприятия 8.

- •121 Назначение и характеристика программы 1с:Зарплата и управление персоналом 8.

- •122 Назначение и характеристика программы 1с:Управление торговлей 8.

- •123 Назначение эмиссионных ценных бумаг (денежных суррогатов), их роль в организации бизнес-процессов.

- •124 Назначение, состав и функции операционных систем.

- •125 Назначение, состав и функции программного средства «Налогоплательщик юл».

- •126 Наиболее распространенные методы управления банковскими рисками.

- •127 Направления развития отечественных и зарубежных экономических информационных систем организаций.

- •128 Научно – техническая информация в рф.

- •129 Нематериальные активы и их классификация.

- •130 Обзор основных дистрибутивов Linux.

- •131 Области знаний по управлению проектами.

- •132 Оборотные средства организации и их классификация.

- •133 Общая структура организации работ по проектированию экономической информационной системы (эис). Управление проектом и его характеристика.

- •134 Общая характеристика и классификация case – средств. Характеристики case – средств erwin, bpwin. Характеристика case – средства rational rose.

- •135 Общая характеристика комплекса «Нормативные расчеты»информационной системы«Производственный менеджмент», характеристика нормативных показателей.

- •136 Общая характеристика комплекса «Плановые расчеты»информационной системы«Производственный менеджмент», характеристика плановых показателей.

- •138 Общие положения о стандартах на разработку программного обеспечения (по). Нормативные документы по стандартам, виды и классификация стандартов.

- •140 Объектно-ориентированные методы анализа и проектирования программного обеспечения (по). Унифицированный язык моделирования uml. Диаграммы языка моделирования uml.

- •141 Объектный и функциональный подходы при создании информационных систем организаций. Классификация современных систем управления предприятием (mrp, mrp II, erp, csrp, crm).

- •142 Односвязный линейный список. Добавление, удаление элементов. Вывод на экран.

- •Связные списки

- •143 Оператор варианта (варианта) (Pascal, c, c#).

- •144 Оператор условного перехода (Pascal, c, c#).

- •145 Операторы (операции) присваивания, ввода-вывода (Pascal, c, c#).

- •146 Операторы циклов (Pascal, c, c#).

- •Цикл for

- •147 Описание программной платформы 1с 8.2. Основные функции, возможности, варианты функционирования.

- •148 Определение кредитного потенциала банка.

- •150 Определение понятия «сегментирование». Основные признаки сегментирования.

- •151 Определение финансового результата от основного вида деятельности.

- •152 Определите роль и место информационно-управляющих систем (иус) в управленческой деятельности. Дайте классификацию иус.

- •153 Организационные, экономические и правовые гарантии объективности биржевой деятельности.

- •154 Организация учета труда и его оплаты в организации.

- •155 Основные инструменты реализации стратегического плана.

- •156 Основные информационные ресурсы, поддерживаемые в налоговых органах России.

- •157 Основные каналы товародвижения. Охарактеризуйте роль посредников в каждом случае.

- •159 Основные концепции маркетинга и этапы его развития.

- •160 Основные направления искусственного интеллекта и их характеристика. Состояние работ в области экспертных систем и направлений искусственного интеллекта.

- •161 Основные направления развития дистанционного управления счетом в банке.

- •162 Основные определения автоматизированных информационных систем (асу, асуп, сапр, астпп, асутп, гпс, иасу).

- •163 Основные определения понятия «маркетинг». Дайте комментарий к каждому определению.

- •164 Основные понятия и классификации case-технологий автоматизированного проектирования. Преимущества case-технологий. Методы, нотации и инструментальные средства case-технологий.

- •165 Основные понятия: информационный ресурс; информация как товар; потребитель информационного ресурса.

- •166 Основные проблемы современной банковской системы России.

- •167 Основные свойства качественного программного изделия (пи). Оценка качественных и количественных характеристик программного обеспечения.

- •168 Основные средства и их классификация.

- •169 Основные стратегии охвата рынка. Приведите примеры.

- •171 Основные термины и определения операционных систем.

- •172 Основные типы проектов, которые могут создаваться с помощью Microsoft VisualStudio, их характерные особенности.

- •173 Основные факторы воздействия микро- и макросреды маркетинга.

- •175 Основные функции и состав системы электронного документооборота «сэд», действующей в налоговых органах России.

- •176 Основные функции кредита.

- •177 Основные функции менеджмента.

- •2. Организация.

- •3. Контроль.

- •4. Мотивация.

- •5. Стимулирование.

- •179 Основные цели и задачи банковского надзора.

- •180 Основные элементы интегрированной среды разработки Microsoft VisualStudio, их назначение и порядок использования.

- •181 Основные этапы анализа производства и реализации продукции.

- •182 Основные этапы стратегического маркетинга. Раскройте содержание каждого из этапов.

- •183 Особенности построения информационной модели банка

- •184 Отличие банковской ссуды от лизинговых и факторинговых сделок.

- •185 Отличие денежной эмиссии от кредитной эмиссии.

- •186 Отличие рынка спот от срочного валютного рынка.

- •187 Отличия коммерческого банка от центрального банка и от предприятия.

- •188 Отличия между рациональным решением проблемы и решением, основанном на суждении. Этапы рационального решения проблем.

- •189 Охарактеризуйте методы управления формальными и неформальными организациями.

- •190 Охарактеризуйте роль и значение проведения маркетинговых исследований. Перечислите виды и этапы проведения.

- •192 Первичный, аналитический и синтетический учет затрат на производстве.

- •193 Перечислите основные функции Банка России, укажите базовые функции в соответствии с положением Конституции рф.

- •194 Перечислите перспективы и ключевые индикаторы стратегической карты сбалансированной системы показателей.

- •195 Перечислите составляющие комплекса маркетинга. Раскройте содержание раздела «Продукт» («Товар»).

- •196 Перечислите составляющие комплекса маркетинга. Раскройте содержание раздела «Ценообразование» («Цена»).

- •197 Перечислите составляющие комплекса маркетинга. Раскройте содержание раздела «Товародвижение» («Место»).

- •198 Перечислите составляющие комплекса маркетинга. Раскройте содержание раздела «Продвижение» («Коммуникации»).

- •199 Перечислите составляющие модули и охарактеризуйте механизм работы электронного магазина.

- •200 Платежная система рф. Что такое валовые и нетто-расчеты. Основные принципы проведения этих расчетов.

- •204 Подпрограммы (Pascal, c, c#).

- •205 Поисковая система в Internet: структура баз, технология пополнения и поиска.

- •206 Показатели оценки эффективности технологических процессов обработки данных и выбор варианта организации технологических процессов.

- •207 Полиморфизм. Перегрузка операций.

- •208 Политика информационной безопасности банка.

- •209 Понятие алгоритма, свойства алгоритма.

- •210 Понятие базы знаний экспертных систем. Организация базы знаний.

- •211 Понятие Единой системы классификации и кодирования (ескк). Схема структуры ескк.

- •213 Понятие и определение нечетких знаний. Понятие лингвистической переменной. Понятие и определение нечеткого множества. Понятие функции принадлежности. Операции с нечеткими знаниями.

- •214 Понятие интеллектуальной информационной системы (иис). Основные свойства иис. Классификация иис.

- •215 Понятие налога. Функции налоговой системы. Роль налогов в экономике.

- •216 Понятие нейроинформатики, история развития. Нейронные сети.

- •217 Понятие платежной системы

- •218 Понятие программного изделия (пи). Основные требования, предъявляемые к программному изделию, как к продукту производственно-технического назначения.

- •219 Понятие проекта, управления проектами.

- •221 Понятие штрихкода. Технология использования штрихового кодирования экономической информации.

- •222 Понятие экономической информационной системы (эис).

- •223 Понятие экспертных систем (эс). Назначение экспертных систем.

- •Эс предназначены для решения т.Н. Неформализованных задач. К неформальным задачам относятся те, которые обладают 1 или несколькими хар-ми:

- •224 Понятия показателя, задачи, функции, функциональной подсистемы, информационной системы. Функциональные матрицы и их применение при проектирование экономической информационной системы (эис).

- •225 Порядок осуществления расчетных операций через расчетную сеть Банка России?

- •226 Порядок электронного обмена между налогоплательщиками и налоговыми органами.

- •227 Постановка задач. Состав и содержание документа «Постановка задачи».

- •228 Почему необходима организация Платежной системы и платежного оборота. На какой институт в России возложена ответственность за эту организацию.

- •230 Предпринимательство – как фактор производства. Содержание и мотивы предпринимательской деятельности.

- •231 При каком условии банки могут стать участниками валютного рынка и какие функции они выполняют как участники?

- •240 Проектирование классификаторов технико-экономической информации экономической информационной системы (эис). Основные понятия классификации и кодирования экономической информации.

- •241 Проектирование клиент - серверных корпоративных экономических информационных систем(эис).

- •242 Проектирование нейросетевыхинтеллектуальных компонентов. Особенности проектирования нейросетевых интеллектуальных компонентов информационных систем.

- •243 Проектирование процессов автоматизированного ввода бумажных документов. Основные стадии и операции автоматизированного чтения и ввода бумажных документов.

- •244 Проектирование процессов защиты данных. Основные понятия и методы защиты данных. Стандарты на создание систем защиты данных. Этапы работ при проектировании системы защиты информации.

- •245 Проектирование процессов получения первичной информации, создания и ведения информационной базы.

- •246 Проектирование систем оперативного анализа данных. Информационные хранилища (их). Технологии оперативного анализа данных (olap).

- •247 Проектирование системы экономической документации. Понятие и проектирование унифицированной системы документации.

- •249 Проектирование технологических процессов обработки данных в пакетном режиме. Технологическая сеть проектирования процесса обработки информации в пакетном режиме.

- •251 Проектирование функциональной архитектуры экономической информационной системы (эис). Этапы проектирования функциональных подсистем.

- •252 Проектирование экранных форм электронных документов. Создание эффективных пользовательских интерфейсов. Адаптивные, интеллектуальные интерфейсы.

- •253 Производные классы: одиночное наследование

- •254 Производственная мощность предприятия.

- •255 Протокольный стек tcp/ip

- •257 Процессы управления проектом.

- •258 Работа с поручениями в системе электронного документооборота «сэд фнс», действующей в налоговых органах России.

- •259 Работа с файлами (Pascal, c, c#).

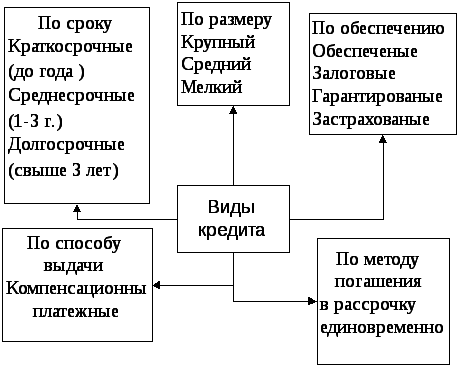

- •260 Различие видов и форм кредитов.

- •261 Различие между ликвидностью и платежеспособностью коммерческого банка?

- •262 Различие между целями и стратегиями организации.

- •263 Разновидности нейронных сетей и их обучение.

- •264 Разработка требований и внешнее проектирование программного обеспечения (по). Внутреннее проектирование (проектирование структуры по). Проектирование и программирование модулей.

- •265 Разработки центра Информационных систем и технологий кафедры исэ АлтГту: «Бизнес-аналитик» и «Нейро-аналитик».

- •266 Растровая и векторная графика.

- •Способы представления изображений в памяти эвм

- •267 Расчетно-кассовый центр(ркц) и его функции.

- •268 Реестр Windows.

- •271 Реляционная модель данных.

- •272 Роль банков в хозяйственном механизме. Кредитная эмиссия.

- •273 Роль специализированного оператора связи в электронном обмене между налогоплательщиками и налоговыми органами. Порядок функционирования системы Контур-Экстерн.

- •274С какой целью была введена обязательная продажа валютной выручки и почему она отменена?

- •275 С какой целью проводится маркетинговое исследование и каково его содержание?

- •276 Свойства информации как объекта защиты. Виды угроз безопасности информации.

- •277 Сетевая операционная система. Определение. Структура

- •278 Система программ 1с. Общие сведение, особенности.

- •279 Системный подход к проектированию программного обеспечения (по). Понятие по, проекта и проектирования по. Основные особенности проектов современных систем по.

- •280 Системы классификации экономической информации, их свойства. Иерархическая система классификации. Многоаспектные системы классификации: фасетная и дескрипторная.

- •282 Службы Windows.

- •283 События в объектно-ориентированном программировании.

- •284 Содержание этапов разработки форм первичных и результатных документов.

- •285 Создание, использование, развитие информационных систем. Проблемы информационного менеджмента.

- •286 Состав и содержание операций проектирования классификаторов.

- •287 Состав и содержание стадии «Техническое проектирование экономической информационной системы (эис)».

- •288 Состав и содержание стадии: «Рабочее проектирование экономической информационной системы (эис)».

- •289 Состав и содержание стадий: «Внедрение», «Эксплуатация» экономической информационной системы (эис).

- •290 Состав и содержание технико-экономического обоснования (тэо).

- •291 Состав и содержание технического задания (тз).

- •292 Состав и структура нейросетевого интеллектуального блока. Характеристика основных его элементов.Я

- •293 Состав и структура экономической информационной системы (эис): функциональные и обеспечивающие подсистемы.

- •294 Состав основных стадий канонического проектирования экономической информационной системы (эис).

- •295 Состав расходов, включаемых в себестоимость продукции и учитываемых при налогообложении прибыли

- •296 Составные части экспертной системы: база знаний, механизм вывода, механизмы приобретения и объяснения знаний, интеллектуальный интерфейс. Статические и динамические экспертные системы.

- •297 Способы аутентификации пользователей в компьютерных системах.

- •Различные способы аутентификации пользователей.

- •298 Способы и примеры стимулирования продаж.

- •299 Способы начисления амортизации основных средств.

- •302 Стандартизация и метрология в разработке программного обеспечения. Стандартизация информационных технологий.

- •303 Стандарты в области документирования программных средств и информационных систем.

- •304 Стандарты в области жизненного цикла информационных систем и программного обеспечения.

- •1 Понятие жизненного цикла ис

- •2 Стандарты, регламентирующие жизненный цикл ис

- •306 Стратегии получения знаний. Извлечение знаний из данных, приобретение знаний, формирование знаний.

- •308 Структура автоматизированной системы управления предприятием (акционерным обществом) по уровням управления.

- •309 Структура налоговых органов России.

- •310 Структура системы расчетов пластиковыми карточками.

- •311 Структурированные кабельные системы.

- •312 Структурное программирование.

- •314 Структурный подход в программировании

- •315 Сущность и содержание эмиссионно-кассового регулирования цб рф.

- •316 Сущность и функции стратегического планирования.

- •318 Сущность маркетинга. Основные принципы маркетинга.

- •319 Сущность методологии структурного, функционально-ориентированного проектирования экономической информационной системы (эис). Характеристика стандартов и диаграмм структурного проектирования.

- •320 Сущность науки управления. Этапы научного метода исследования.

- •322 Схема информационно-программных комплексов системы управления производством. Состав и структура базы данных информационной системы«Производственный менеджмент».

- •323 Схема информационных потоков в налоговых органах России.

- •324 Схема работы интеллектуального компонента прогнозирования временных рядов показателей.

- •325 Схема рыночного механизма: структура, принципы функционирования.

- •326 Счета бухгалтерского учета и двойная запись

- •327 Счета учета расчетов с контрагентами

- •328 Тенденции и перспективы развития операционных систем.

- •329 Теоретические аспекты извлечения знаний.

- •330 Теория нормальных форм. Нормализации

- •330 Тестирование, отладка и сборка программного обеспечения (по). Содержание процесса сборки, отладки и тестирования, их взаимосвязь. Принципы тестирования.

- •331 Технологии широкополосного доступа:

- •332 Технология Ethernet (Fast Ethernet, Gigabyte Ethernet).

- •333 Технология поиска информации в Интернете и профессиональных базах.

- •335 Технология создания Интернет ресурса.

- •336 Типовое проектирование экономической информационной системы (эис). Основные понятия и классификация методов типового проектирования.

- •337 Типы алгоритмов. Способы записи алгоритма.

- •338 Типы нейронных сетей и их обозначение. Понятие логически прозрачных нейронных сетей.

- •339 Угрозы утечки информации. Угрозы воздействия на источник информации.

- •Внешние угрозы

- •Внутренние угрозы

- •341 Системный подход к проектированию программного обеспечения (по). Понятие по, проекта и проектирования по. Основные особенности проектов современных систем по.

- •342 Управление разработкой программного обеспечения (по). Понятие рынка программных средств, маркетинг по, задачи маркетинга по. Сертификация по.

- •343 Управление рисками проекта.

- •344 Управление содержанием проекта.

- •345 Управление сроками проекта.

- •346 Управление стоимостью проекта.

- •347 Управление человеческими ресурсами проекта.

- •348 Устройства ввода информации.

- •349 Устройства вывода информации.

- •350 Устройства хранения информации.

- •351 Учет денежных средств в кассе организации.

- •352 Учет денежных средств на расчетном счете организации.

- •353 Учетная политика организации.

- •355 Физические, арифметические и логические способы представления информации в эвм.

- •356 Физическое проектирование базы данных.

- •357 Финансово-экономические кризисы. Природа, схема развития.

- •358 Функции и операции кредитно-финансовых институтов присущи только банкам?

- •359 Функции службы безопасности в банке.

- •360 Функции, операции и сделки в соответствии с законодательством могут выполнять отечественные банки?

- •361 Функциональные модули автоматизированных банковских систем (абс) и их назначение.

- •362 Функционирование нейросетевого решателя в режиме автоматического обучения. Методы формирования значений выходных параметров нейросети.

- •363 Характеристика и определения основных понятий маркетинга - нужда, потребность, товар, спрос, обмен, рынок.

- •366 Характеристика комплекса «Обработка информации оперативного учета». Общая характеристика фактических учетных показателей информационной системы«Производственный менеджмент».

- •367 Характеристика предпроектной стадии создания эис. Этап «Сбор материалов обследования». Разработка модели процессов функционирования системы «Как есть (as_is)».

- •368 Характеристика предпроектной стадии создания эис. Этап «Анализ материалов обследования Разработка моделей процессов функционирования системы «Как должно быть (to_be)».

- •369 Характеристика стадий разработки прототипа экспертной системы.

- •370 Цели государственной регламентации видов организационно-правовых форм предпринимательской деятельности, правил их функционирования и контроля общественной эффективности бизнес-структур.

- •371 Цели и основные задачи маркетинговой службы на предприятии.

- •372 Цель и задачи предпринимательской деятельности.

- •373 Что общего и в чем отличия в понятиях «мотивация» и «стимулирование».

- •374 Что общее и в чем отличие у школ человеческих отношений и поведенческих наук.

- •375 Что означают термины «комплекс» и «система»? Дайте комментарий понятию «комплексная система управления предприятием».

- •376 Что такое депозит и по каким критериям могут быть классифицированы депозиты?

- •377 Экономическая сущность банков как элемента рыночной инфраструктуры.

- •378 Экономическая сущность биржевой деятельности в товарном производстве.

- •379 Экономическая сущность и задачи фондового рынка.

- •380 Экономическая эффективность информационных систем.

- •382 Электронные платежные системы.

- •WebMoney

- •PayCash (работают под маркой Яндекс-деньги)

- •384 Этапы развития мирового рынка информационных услуг.

- •385 Этапы реинжиниринга бизнес-процессов. Идентификация бизнес-процессов. Обратный реинжиниринг. Прямой реинжиниринг.

- •386 Этапы стратегического планирования.

- •387 Язык PowerShell. История развития. Основные возможности.

- •389 Язык запросов sql

- •390 Язык программирования с#.Классы в языке с#.

- •391 Языки программирования низкого, высокого уровня (с примерами).

260 Различие видов и форм кредитов.

261 Различие между ликвидностью и платежеспособностью коммерческого банка?

Понятие ликвидностьбанка означает возможность банка своевременно и полно обеспечивать выполнение своих долговых и финансовых обязательств перед всеми контрагентами, что определяется наличием достаточного собственного капитала банка, оптимальным размещением и величиной средств по статьям актива и пассива баланса с учетом соответствующих сроков.

Ликвидность оценивается на основе способности банка превращать свои активы в денежные или другие платежные средства для оплаты предъявляемых обязательств в случае, если имеющихся в наличии платежных средств для этого не хватает.

Платежеспособность банка– это способность банка в должные сроки и полностью отвечать по всем своим обязательствам.

На первый взгляд, ликвидность коммерческого банка в такой трактовке не отличается от платежеспособности, т.е. способности банка ответить по своим обязательствам на конкретный момент времени (сегодняшний или вчерашний день). Но ликвидность понятие более широкое, оно включает в себя платежеспособность не только в прошлом, настоящем, но и в будущем.

Ликвидность банка лежит в основе его платежеспособности

262 Различие между целями и стратегиями организации.

Цели организации - результаты, которых стремится достичь организация, и на достижение которых направлена ее деятельность.

Стратегияорганизации - взаимосвязанный комплекс долгосрочных мер или подходов во имя укрепления жизнеспособности и мощи организации по отношению к ее конкурентам. Стратегия организации - по существу - набор правил для принятия решений, которыми организация руководствуется в своей деятельности

263 Разновидности нейронных сетей и их обучение.

Одной из первых искусственных сетей, способных к восприятию и формированию реакции на воспринятый стимул, явился PERCEPTRON Розенблатта.

Простейший классический персептрон содержит эл-ты 3 типов, назначение которых соответствует нейронам рефлекторной нейронной сети. S-элементы формируют сетчатку сенсорных клеток, принимающих двоичные сигналы от внешнего мира. Далее сигналы поступают в слой ассоциативных или A-элементов. Только ассоциативные элементы, представляющие собой формальные нейроны, выполняют нелинейную обработку информации и имеют изменяемые веса связей. R-элементы с фиксированными весами формируют сигнал реакции персептрона на входной стимул. Представленная сеть называется однослойной, т.к. имеет только 1 слой нейропроцессорных эл-тов. Однослойный персептрон хар-тся матрицей синоптических связей W от S- к A-элементам. Эл-т матрицы Wij отвечает связи, ведущей от i-го S-элемента к j-му A-элементу.

Теорема об обучении персептрона.Предложенный Ф. Розенблаттом метод обучения состоит в итерационной подстройке матрицы весов, последовательно уменьшающей ошибку в выходных векторах. Пусть имеется набор пар векторов (x,y),=1..p, называемый обучающей выборкой. Будем называть нейронную сеть обученной на данной обучающей выборке, если при подаче на входы сети каждого вектора xна выходах получается соответствующий вектор y.

Рассмотрим иер-ую сетевую стр-ру, в которой связанные между собой нейроны объединены в несколько слоев. Межнейронные синоптические связи сети устроены т. о., что каждый нейрон на данном уровне иерархии принимает и обрабатывает сигналы от каждого нейрона более низкого уровня. Т.о., в данной сети имеется выделенное направление распространения нейроимпульсов - от вход. слоя через 1 (или несколько) скрытых слоев к выход. слою нейронов. НС такой топологии назыв-ся обобщенным многослойным персептроном.

Персептрон предст. собой сеть, сост-ю из нескольких посл-но соед-х слоев формальных нейронов МакКаллока и Питтса. На низшем уровне иерархии находится вход. слой, сост-й из сенсорных эл-тов. Далее имеются 1 или, несколько скрытых слоев. Каждый нейрон на скрытом слое имеет несколько входов, соед-х с выход. нейронов пред-го слоя или непоср-но со вход. сенсорами X1..Xn, и 1 выход. Нейрон хар-ся уник-ым вектором весовых коэфф-ов w. Веса всех нейронов слоя формируют матрицу, которую будем обозначать V или W. Функция нейрона состоит в вычислении взвешенной суммы его входов с дальнейшим нелинейным преобразованием ее в выход. сигнал.

Обучение методом обратного распространения ошибок.Для обучения многослойной сети в 1986 г. Руммельхартом и Хинтоном - алгоритм обратного распространения ошибок. Основная идея обратного распр-ния состоит в том, как получить оценку ошибки для нейронов скрытых слоев. Известные ошибки, делаемые нейронами выход. слоя, возникают вследствие неизвестных ошибок нейронов скрытых слоев. Чем больше значение синоптической связи между нейроном скрытого слоя и выход. нейроном, тем сильнее ошибка 1 влияет на ошибку 2. Следовательно, оценку ошибки эл-ов скрытых слоев можно получить, как взвешенную сумму ошибок последующих слоев. При обучении инф-ция распространяется от низших слоев иерархии к высшим, а оценки ошибок, делаемые сетью - в обратном направлении, что и отражено в названии метода.

Модель Кохоненавыполняет обобщение предъявляемой инф-ции. В результате работы НС Кохонена получается образ, представляющий собой карту распределения векторов из обучающей выборки. Т.о., в модели Кохонена выполняется решение задачи нахождения кластеров в пространстве вход. образов.

Данная сеть обучается без учителя на основе самоор-ции. По мере обучении вектора весов нейронов стремятся к центрам кластеров - групп векторов обучающей выборки. На этапе решения инф-ных задач сеть относит новый предъявленный образ к одному из сформированных кластеров, указывая тем самым категорию, к которой он принадлежит.

Сеть Кохонена, также как и сеть Липпмана-Хемминга, состоит из 1 слоя нейронов. Число входов каждого нейрона = размерности входного образа. Кол-во нейронов определяется той степенью подробности с которой требуется выполнить кластеризацию набора библ-ных образов. При достаточном кол-ве нейронов и удачных параметрах обучения НС Кохонена может не только выделить основные группы образов, но и установить "тонкую структуру" полученных кластеров. При этом близким входным образам будет соответствовать близкие карты нейронной активности.

Обучение начинается с задания случайных значений матрице связей . В дальнейшем происходит процесс самоор-ции, состоящий в модификации весов при предъявлении на вход векторов обучающей выборки. Для каждого нейрона можно определить его расстояние до вектора входа Далее выбирается нейрон m=m*, для которого это расстояниеmin. На текущем шаге обучения t будут модифицироваться только веса нейронов из окрестности нейрона m*Первоначально в окрестности любого из нейронов находятся все НС, в последствии эта окрестность сужается. В конце этапа обучения подстраиваются только веса самого ближайшего нейрона. Темп обучения(t)<1 с течением времени также уменьшается. Образы обучающей выборки предъявляются последовательно, и каждый раз происходит подстройка весов. НС Кохонена может обучаться и на искаженных версиях вход. векторов, в процессе обучения искажения, если они не носят систематический характер, сглаживаются.