- •В. Г. Потемкин

- •Предисловие

- •Введение

- •Используемые обозначения

- •Часть 1. Ппп Neural Network Toolbox

- •1. Система matlab 6

- •1.1. Операционная среда matlab 6

- •Командное окно

- •Окно предыстории

- •Окно запуска

- •Окно текущего каталога

- •Окно рабочей области

- •Справочная подсистема

- •1.3. Демонстрационные примеры ппп nnt

- •2. Модель нейрона и архитектура сети

- •2.1. Модель нейрона

- •2.1.1. Простой нейрон

- •2.1.2. Функция активации

- •2.1.3. Нейрон с векторным входом

- •2.2. Архитектура нейронных сетей

- •2.2.1. Однослойные сети

- •2.2.2. Многослойные сети

- •2.2.3. Сети с прямой передачей сигнала

- •2.3. Создание, инициализация и моделирование сети Формирование архитектуры сети

- •Инициализация сети

- •Моделирование сети

- •3. Обучение нейронных сетей

- •3.1. Процедуры адаптации и обучения

- •Явление переобучения

- •Свойство обобщения

- •3.1.1. Способы адаптации и обучения

- •Адаптация нейронных сетей

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel(' Циклы'), ylabel('Ошибка'),grid

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel('Циклы'), ylabel('Ошибка'),grid

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel('Циклы'), ylabel('Ошибка'),grid

- •Обучение нейронных сетей

- •3.2. Методы обучения

- •3.2.1. Обучение однослойной сети

- •3.2.2. Обучение многослойной сети

- •Метод обратного распространения ошибки

- •Характеристика методов обучения

- •3.3. Алгоритмы обучения

- •3.3.1. Градиентные алгоритмы обучения Алгоритм gd

- •Алгоритм gdm

- •Алгоритм gda

- •Алгоритм Rprop

- •3.3.2. Алгоритмы метода сопряженных градиентов

- •Алгоритм cgf

- •Алгоритм cgp

- •Алгоритм cgb

- •Алгоритм scg

- •3.3.3. Квазиньютоновы алгоритмы Алгоритм bfgs

- •Алгоритм oss

- •Алгоритм lm

- •3.3.4. Алгоритмы одномерного поиска

- •Алгоритм gol

- •Алгоритм bre

- •Алгоритм hyb

- •Алгоритм cha

- •Алгоритм bac

- •3.3.5. Расширение возможностей процедур обучения

- •Переобучение

- •Метод регуляризации

- •Формирование представительной выборки

- •Предварительная обработка и восстановление данных

- •Пример процедуры обучения

- •4. Персептроны

- •4.1. Архитектура персептрона

- •4.2. Модель персептрона

- •Моделирование персептрона

- •Инициализация параметров

- •4.3. Процедуры настройки параметров

- •Правила настройки

- •Процедура адаптации

- •5. Линейные сети

- •5.1. Архитектура линейной сети

- •5.2. Создание модели линейной сети

- •5.3. Обучение линейной сети

- •Процедура настройки

- •Процедура обучения

- •5.4. Применение линейных сетей Задача классификации векторов

- •Фильтрация сигнала

- •Предсказание сигнала

- •Подавление шумов

- •Многомерные цифровые фильтры

- •6. Радиальные базисные сети

- •Модель нейрона и архитектура сети

- •Создание сети

- •Радиальная базисная сеть с нулевой ошибкой

- •Итерационная процедура формирования сети

- •Примеры радиальных базисных сетей

- •6.1. Сети grnn

- •Архитектура сети

- •Синтез сети

- •6.2. Сети pnn

- •Архитектура сети

- •Синтез сети

- •7. Сети кластеризации и классификации данных

- •7.1. Самоорганизующиеся нейронные сети

- •7.1.1. Слой Кохонена

- •Архитектура сети

- •Создание сети

- •Правило обучения слоя Кохонена

- •Правило настройки смещений

- •Обучение сети

- •7.1.2. Карта Кохонена

- •Топология карты

- •Функции для расчета расстояний

- •Архитектура сети

- •Создание сети

- •Обучение сети

- •Одномерная карта Кохонена

- •Двумерная карта Кохонена

- •Архитектура сети

- •Создание сети

- •Обучение сети Правила настройки параметров

- •Процедура обучения

- •8. Рекуррентные сети

- •8.1. Сети Элмана

- •Архитектура

- •Создание сети

- •Обучение сети

- •Проверка сети

- •8.2. Сети Хопфилда

- •Архитектура сети

- •Синтез сети

- •9. Применение нейронных сетей

- •9.1. Аппроксимация и фильтрация сигналов

- •9.1.1. Предсказание стационарного сигнала Постановка задачи

- •Синтез сети

- •Проверка сети

- •9.1.2. Слежение за нестационарным сигналом

- •Инициализация сети

- •Проверка сети

- •9.1.3. Моделирование стационарного фильтра

- •Постановка задачи

- •Синтез сети

- •Проверка сети

- •9.1.4. Моделирование нестационарного фильтра

- •Постановка задачи

- •Инициализация сети

- •Проверка сети

- •9.2. Распознавание образов

- •Постановка задачи

- •Нейронная сеть

- •Архитектура сети

- •Инициализация сети

- •Обучение

- •Обучение в отсутствие шума

- •Обучение в присутствии шума

- •Повторное обучение в отсутствие шума

- •Эффективность функционирования системы

- •9.3. Нейронные сети и системы управления

- •9.3.1. Регулятор с предсказанием

- •9.3.2. Регулятор narma-l2

- •9.3.3. Регулятор на основе эталонной модели

- •Часть2. Операторы, функции и команды

- •10. Вычислительная модель нейронной сети

- •10.1. Описание сети Описание архитектуры

- •Функции инициализации, адаптации и обучения

- •10.2. Описание элементов сети

- •Описание входов

- •Описание слоев

- •Описание выходов

- •Описание целей

- •Описание смещений

- •Описание весов входа

- •Описание весов слоя

- •Матрицы весов и векторы смещений

- •Информационные поля

- •11. Формирование моделей нейронных сетей

- •11.1. Модели сетей

- •11.1.1. Однослойные сети Персептрон

- •Линейные сети

- •11.1.2. Многослойные сети

- •Радиальные базисные сети

- •Самоорганизующиеся сети

- •Сети – классификаторы входных векторов

- •Рекуррентные сети

- •11.2. Функции активации

- •Персептрон

- •Линейные сети

- •Радиальные базисные сети

- •Самоорганизующиеся сети

- •Рекуррентные сети

- •11.3. Синаптические функции

- •Функции взвешивания и расстояний

- •Функции накопления

- •11.4. Функции инициализации

- •11.5. Функции адаптации и обучения Функции адаптации

- •Функции обучения

- •Градиентные алгоритмы обучения

- •Алгоритмы метода сопряженных градиентов

- •Квазиньютоновы алгоритмы обучения

- •11.5.1. Функции оценки качества обучения

- •11.6. Функции настройки параметров

- •11.6.1. Функции одномерного поиска

- •11.7. Масштабирование и восстановление данных

- •11.8. Вспомогательные функции

- •Утилиты вычислений

- •Операции с массивами данных

- •Графические утилиты

- •Информация о сети и ее топологии

- •11.9. Моделирование нейронных сетей и система Simulink Функции моделирования сети

- •11.9.1. Применение системы Simulink

- •Библиотеки блоков для моделирования нейронных сетей

- •Построение моделей нейронных сетей

- •Индексный указатель Команды, функции и операторы ппп Neural Network Toolbox

- •Предметный указатель

- •Литература Книги на английском языке:

- •Книги на русском языке:

- •Оглавление

11.1.2. Многослойные сети

|

NEWFF |

Сеть прямой передачи FF |

Синтаксис:

net = newff(PR,[S1 S2...SNl],{TF1 TF2...TFNl},btf,blf,pf)

Описание:

Функция newffпредназначена для создания многослойных нейронных сетей прямой передачи сигнала с заданными функциями обучения и настройки, которые используют метод обратного распространения ошибки.

Функция net = newff(PR, [S1 S2 ... SNl], {TF1 TF2 ... TFNl},btf,blf,pf) формирует многослойную нейронную сеть.

Входные аргументы:

PR – массив размера R2 минимальных и максимальных значений для R векторов входа;

Si – количество нейронов в слоеi;

TFi– функция активации слояi, по умолчаниюtansig;

btf– обучающая функция, реализующая метод обратного распространения, по умолчаниюtrainlm;

blf– функция настройки, реализующая метод обратного распространения, по умолчаниюlearngdm;

pf– критерий качества обучения, по умолчаниюmse.

Выходные аргументы:

net– объект классаnetwork object многослойной нейронной сети.

Свойства сети:

Функциями активации могут быть любые дифференцируемые функции, например tansig,logsigилиpurelin.

Обучающими функциями могут быть любые функции, реализующие метод обратного распространения: trainlm,trainbfg,trainrp,traingdи др.

Функция trainlmявляется обучающей функцией по умолчанию, поскольку обеспечивает максимальное быстродействие, но требует значительных ресурсов памяти. Если ресурсы памяти недостаточны, воспользуйтесь следующими рекомендациями:

установите значение свойства net.trainParam.mem_reducравным 2 или более, что снизит требования к памяти, но замедлит обучение;

воспользуйтесь обучающей функцией trainbfg, которая работает медленнее, но требуетменьшей памяти, чем М-функцияtrainlm;

перейдите к обучающей функции trainrp,которая работает медленнее, но требует меньшей памяти, чем М-функцияtrainbfg.

Функциями настройки могут быть функции, реализующие метод обратного распространения: learngd,learngdm.

Критерием качества обучения может быть любая дифференцируемая функция: mse, msereg.

Пример:

Создать нейронную сеть, чтобы обеспечить следующее отображение последовательности входа P в последовательность целей T:

P = [0 1 2 3 4 5 6 7 8 9 10];

T = [0 1 2 3 4 3 2 1 2 3 4];

Архитектура нейронной сети: двухслойная сеть с прямой передачей сигнала; первый слой – 5 нейронов с функцией активации tansig; второй слой – 1 нейрон с функцией активации purelin; диапазон изменения входа [0 10].

net = newff([0 10],[5 1],{'tansig' 'purelin'});

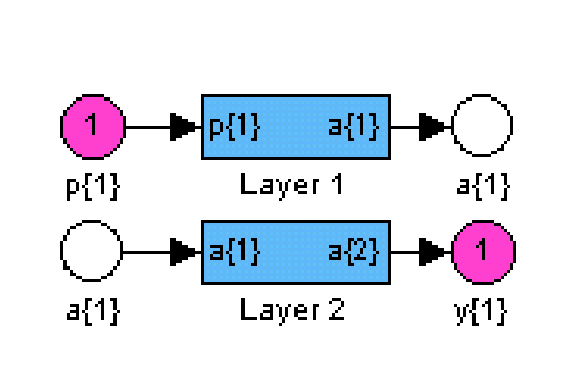

gensim(net) % Рис.11.12

|

|

|

|

|

|

Рис. 11.12

Выполним моделирование сети и построим графики сигналов выхода и цели (рис. 11.13):

Y = sim(net,P);

plot(P, T, P, Y, 'o') % Рис.11.13

Рис. 11.13

Рис. 11.13

Обучим сеть в течение 50 циклов:

net.trainParam.epochs = 50;

net = train(net,P,T);

Характеристика точности обучения показана на рис. 11.14; установившаяся среднеквадратичная ошибка составляет приблизительно 0.02.

Рис. 11.14

Рис. 11.14

Выполним моделирование сформированной двухслойной сети, используя обучающую последовательность входа:

Y = sim(net,P);

plot(P,T,P,Y,'o') % Рис.11.15

Результаты моделирования показаны на рис. 11.15 и свидетельствуют о хорошем отображении входной последовательности в выходную последовательность.

Рис. 11.15

Рис. 11.15

Алгоритм:

Многослойная сеть прямой передачи сигнала включает Nlслоев с функциями взвешиванияdotprod, накопленияnetsumи заданными пользователем функциями активации.

Первый слой характеризуется матрицей весов входа, другие слои – матрицами весов выхода предшествующего слоя; все слои имеют смещения. Выход последнего слоя является выходом сети. Веса и смещения каждого слоя инициализируются с помощью М-функции initnw.

Режим адаптации реализуется М-функцией adaptwb. Для режима обучения выбираетсяобучающая функция, реализующая метод обратного распространения ошибки.

Оценка качества обучения основана на функциях оценки качества, выбираемых из списка {mae|mse| msereg|sse}.

Сопутствующие функции: NEWCF, NEWELM, SIM, INIT, ADAPT, TRAIN.

|

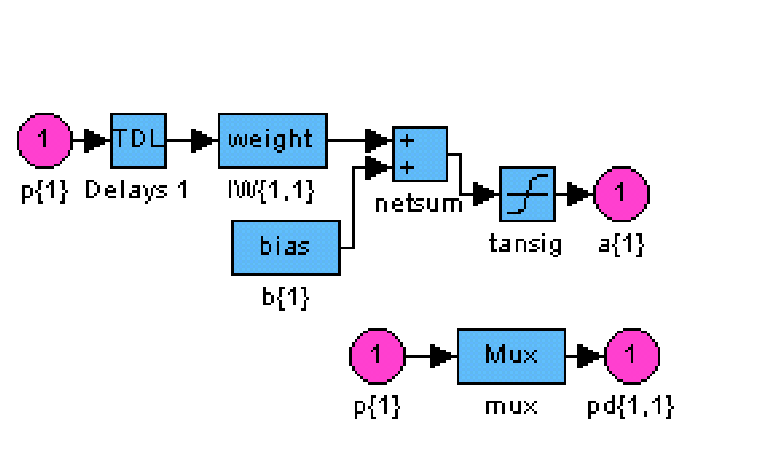

neWFFTD |

Динамическая нейронная сеть FFTD |

Сеть прямой передачи с запаздыванием

Синтаксис:

net = newfftd(PR, ID, [S1 S2 ... SNl], {TF1 TF2 ... TFNl}, btf, blf, pf)

Описание:

Функция newfftd предназначена для создания многослойных нейронных сетей прямой передачи сигнала с линиями задержки и заданными функциями обучения и настройки, использующими метод обратного распространения ошибки.

Функция net = newfftd(PR, ID, [S1 S2 ... SNl], {TF1 TF2 ... TFNl}, btf, blf, pf) формирует динамическую многослойную нейронную сеть.

Входные аргументы:

PR – массив размера R2 минимальных и максимальных значений для R векторов входа;

ID– вектор параметров линии задержки на входе сети;

Si – количество нейронов в слоеi;

TFi– функция активации слояi, по умолчаниюtansig;

btf– обучающая функция, реализующая метод обратного распространения, по умолчаниюtrainlm;

blf– функция настройки, реализующая метод обратного распространения, по умолчаниюlearngdm;

pf– критерий качества обучения, по умолчаниюmse.

Выходные аргументы:

net – объект класса network object динамической многослойной нейронной сети.

Свойства сети:

Функциями активации могут быть любые дифференцируемые функции, например tansig,logsigилиpurelin.

Обучающими функциями могут быть любые функции, реализующие метод обратного распространения: trainlm,trainbfg,trainrp,traingdи др.

Функция trainlm является обучающей функцией по умолчанию, поскольку обеспечивает максимальное быстродействие, но требует значительных ресурсов памяти. Если ресурсы памяти недостаточны, воспользуйтесь следующими рекомендациями:

установите значение свойства net.trainParam.mem_reducравным 2 или более, что снизит требования к памяти, но замедлит обучение;

воспользуйтесь обучающей функцией trainbfg, которая работает медленнее, но требуетменьшей памяти, чем М-функцияtrainlm;

перейдите к обучающей функции trainrp,которая работает медленнее, но требует меньшей памяти, чем М-функцияtrainbfg.

Функциями настройки могут быть функции, реализующие метод обратного распространения: learngd,learngdm.

Критерием качества обучения может быть любая дифференцируемая функция: mse, msereg.

Пример:

Создать нейронную сеть, чтобы обеспечить следующее отображение последовательности входа P в последовательность целей T:

P = {1 0 0 1 1 0 1 0 0 0 0 1 1 0 0 1};

T = {1 –1 0 1 0 –1 1 –1 0 0 0 1 0 –1 0 1};

Архитектура нейронной сети: двухслойная сеть с прямой передачей сигнала и линией задержки [0 1]; первый слой – 5 нейронов с функцией активации tansig; второй слой – 1 нейрон с функцией активации purelin; диапазон изменения входа [0 10].

net = newfftd([0 1],[0 1],[5 1],{'tansig' 'purelin'}); % Рис.11.16

|

|

|

|

|

|

|

| |

Обучим сеть в течение 50 циклов и промоделируем, используя в качестве теста обучающую последовательность входа:

net.trainParam.epochs = 50;

net = train(net,P,T);

Y = sim(net,P)

Y = [1] [–1] [0] [1] [0] [–1] [1] [–1] [0] [0] [0] [1] [0] [–1] [0] [1]

Выход сети точно совпадает с целевой последовательностью.

Алгоритм:

Многослойная динамическая сеть прямой передачи включает Nlслоев с функциями взвешиванияdotprod, функциями накопленияnetsumи заданными пользователем функциями активации.

Первый слой характеризуется матрицей весов входа, другие слои – матрицами весов выхода предшествующего слоя; все слои имеют смещения. Выход последнего слоя является выходом сети. Веса и смещения каждого слоя инициализируются с помощью М-функции initnw.

Режим адаптации реализуется М-функцией adaptwb. Для режима обучения выбирается обучающая функция, использующая метод обратного распространения ошибки.

Оценка качества обучения основана на функциях оценки качества, выбираемых из списка {mae|mse| msereg|sse}.

Сопутствующие функции: NEWCF, NEWELM, SIM, INIT, ADAPT, TRAIN.

|

neWCF |

Каскадная сеть прямой передачи CF |

Синтаксис:

net = newcf(PR,[S1 S2...SNl],{TF1 TF2...TFNl},btf,blf,pf)

Описание:

Функция newcf предназначена для создания каскадных нейронных сетей прямой передачи сигнала с заданными функциями обучения и настройки, использующими метод обратного распространения ошибки.

Функция net = newcf(PR, [S1 S2 ... SNl], {TF1 TF2 ... TFNl}, btf, blf, pf) формирует каскадную нейронную сеть.

Входные аргументы:

PR – массив размера R2 минимальных и максимальных значений для R векторов входа;

Si – количество нейронов в слоеi;

TFi– функция активации слояi, по умолчаниюtansig;

btf– обучающая функция, реализующая метод обратного распространения, по умолчаниюtrainlm;

blf– функция настройки, реализующая метод обратного распространения, по умолчаниюlearngdm;

pf– критерий качества обучения, по умолчаниюmse.

Выходные аргументы:

net– объект классаnetwork objectкаскадной нейронной сети с прямой передачей и обучением методом обратного распространения.

Свойства сети:

Функциями активации могут быть любые дифференцируемые функции, например tansig,logsigилиpurelin.

Обучающими функциями могут быть любые функции, реализующие метод обратного распространения: trainlm,trainbfg,trainrp,traingdи др.

Функция trainlm является обучающей функцией по умолчанию, поскольку обеспечивает максимальное быстродействие, но требует значительных ресурсов памяти. Если ресурсы памяти недостаточны, воспользуйтесь следующими рекомендациями:

установите значение свойства net.trainParam.mem_reducравным 2 или более, что снизит требования к памяти, но замедлит обучение;

воспользуйтесь обучающей функцией trainbfg, которая работает медленнее, но требует меньшей памяти, чем М-функцияtrainlm;

перейдите к обучающей функции trainrp,которая работает медленнее, но требует меньшей памяти, чем М-функцияtrainbfg.

Функциями настройки могут быть функции, реализующие метод обратного распространения: learngd,learngdm

Критерием качества обучения может быть любая дифференцируемая функция: mse,msereg.

Пример:

Создать каскадную нейронную сеть, чтобы обеспечить следующее отображение последовательности входа P в последовательность целей T:

P = [0 1 2 3 4 5 6 7 8 9 10];

T = [0 1 2 3 4 3 2 1 2 3 4];

Архитектура нейронной сети: каскадная двухслойная сеть с прямой передачей сигнала; первый слой – 5 нейронов с функцией активации tansig; второй слой – 1 нейрон с функцией активацииpurelin; диапазон изменения входа [0 10].

net = newcf([0 10],[5 1],{'tansig' 'purelin'});

gensim(net) % Рис.11.17

Результат представлен на рис. 11.17.

|

|

|

|

|

|

Рис. 11.17

Обучим сеть в течение 50 циклов:

net.trainParam.epochs = 50;

net = train(net,P,T);

Характеристика точности обучения показана на рис. 11.18; установившаяся среднеквадратичная ошибка составляет приблизительно 0.002, что на порядок выше, чем для сети FF( см. рис. 11.14).

Рис. 11.18

Рис. 11.18

Выполним моделирование каскадной двухслойной сети, используя обучающую последовательность входа:

Y = sim(net,P);

plot(P,T,P,Y,'o')

Результат моделирования представлен на рис. 11.19.

Рис. 11.19

Рис. 11.19

Алгоритм:

Каскадная сеть прямой передачи использует функции взвешивания dotprod, накопленияnetsumи заданные пользователем функции активации.

Первый каскад характеризуется матрицей весов входа, другие каскады – матрицами весов выхода предшествующего каскада; все каскады имеют смещения. Выход последнего каскада является выходом сети. Веса и смещения инициализируются с помощью М-функции initnw.

Режим адаптации реализуется М-функцией adaptwb. Для режима обучения выбирается обучающая функция, реализующая метод обратного распространения ошибки.

Оценка качества обучения основана на функциях оценки качества, выбираемых из списка {mae|mse| msereg|sse}.

Сопутствующие функции: NEWFF, NEWELM, SIM, INIT, ADAPT, TRAIN.

Рис. 11.16

Рис. 11.16