- •В. Г. Потемкин

- •Предисловие

- •Введение

- •Используемые обозначения

- •Часть 1. Ппп Neural Network Toolbox

- •1. Система matlab 6

- •1.1. Операционная среда matlab 6

- •Командное окно

- •Окно предыстории

- •Окно запуска

- •Окно текущего каталога

- •Окно рабочей области

- •Справочная подсистема

- •1.3. Демонстрационные примеры ппп nnt

- •2. Модель нейрона и архитектура сети

- •2.1. Модель нейрона

- •2.1.1. Простой нейрон

- •2.1.2. Функция активации

- •2.1.3. Нейрон с векторным входом

- •2.2. Архитектура нейронных сетей

- •2.2.1. Однослойные сети

- •2.2.2. Многослойные сети

- •2.2.3. Сети с прямой передачей сигнала

- •2.3. Создание, инициализация и моделирование сети Формирование архитектуры сети

- •Инициализация сети

- •Моделирование сети

- •3. Обучение нейронных сетей

- •3.1. Процедуры адаптации и обучения

- •Явление переобучения

- •Свойство обобщения

- •3.1.1. Способы адаптации и обучения

- •Адаптация нейронных сетей

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel(' Циклы'), ylabel('Ошибка'),grid

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel('Циклы'), ylabel('Ошибка'),grid

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel('Циклы'), ylabel('Ошибка'),grid

- •Обучение нейронных сетей

- •3.2. Методы обучения

- •3.2.1. Обучение однослойной сети

- •3.2.2. Обучение многослойной сети

- •Метод обратного распространения ошибки

- •Характеристика методов обучения

- •3.3. Алгоритмы обучения

- •3.3.1. Градиентные алгоритмы обучения Алгоритм gd

- •Алгоритм gdm

- •Алгоритм gda

- •Алгоритм Rprop

- •3.3.2. Алгоритмы метода сопряженных градиентов

- •Алгоритм cgf

- •Алгоритм cgp

- •Алгоритм cgb

- •Алгоритм scg

- •3.3.3. Квазиньютоновы алгоритмы Алгоритм bfgs

- •Алгоритм oss

- •Алгоритм lm

- •3.3.4. Алгоритмы одномерного поиска

- •Алгоритм gol

- •Алгоритм bre

- •Алгоритм hyb

- •Алгоритм cha

- •Алгоритм bac

- •3.3.5. Расширение возможностей процедур обучения

- •Переобучение

- •Метод регуляризации

- •Формирование представительной выборки

- •Предварительная обработка и восстановление данных

- •Пример процедуры обучения

- •4. Персептроны

- •4.1. Архитектура персептрона

- •4.2. Модель персептрона

- •Моделирование персептрона

- •Инициализация параметров

- •4.3. Процедуры настройки параметров

- •Правила настройки

- •Процедура адаптации

- •5. Линейные сети

- •5.1. Архитектура линейной сети

- •5.2. Создание модели линейной сети

- •5.3. Обучение линейной сети

- •Процедура настройки

- •Процедура обучения

- •5.4. Применение линейных сетей Задача классификации векторов

- •Фильтрация сигнала

- •Предсказание сигнала

- •Подавление шумов

- •Многомерные цифровые фильтры

- •6. Радиальные базисные сети

- •Модель нейрона и архитектура сети

- •Создание сети

- •Радиальная базисная сеть с нулевой ошибкой

- •Итерационная процедура формирования сети

- •Примеры радиальных базисных сетей

- •6.1. Сети grnn

- •Архитектура сети

- •Синтез сети

- •6.2. Сети pnn

- •Архитектура сети

- •Синтез сети

- •7. Сети кластеризации и классификации данных

- •7.1. Самоорганизующиеся нейронные сети

- •7.1.1. Слой Кохонена

- •Архитектура сети

- •Создание сети

- •Правило обучения слоя Кохонена

- •Правило настройки смещений

- •Обучение сети

- •7.1.2. Карта Кохонена

- •Топология карты

- •Функции для расчета расстояний

- •Архитектура сети

- •Создание сети

- •Обучение сети

- •Одномерная карта Кохонена

- •Двумерная карта Кохонена

- •Архитектура сети

- •Создание сети

- •Обучение сети Правила настройки параметров

- •Процедура обучения

- •8. Рекуррентные сети

- •8.1. Сети Элмана

- •Архитектура

- •Создание сети

- •Обучение сети

- •Проверка сети

- •8.2. Сети Хопфилда

- •Архитектура сети

- •Синтез сети

- •9. Применение нейронных сетей

- •9.1. Аппроксимация и фильтрация сигналов

- •9.1.1. Предсказание стационарного сигнала Постановка задачи

- •Синтез сети

- •Проверка сети

- •9.1.2. Слежение за нестационарным сигналом

- •Инициализация сети

- •Проверка сети

- •9.1.3. Моделирование стационарного фильтра

- •Постановка задачи

- •Синтез сети

- •Проверка сети

- •9.1.4. Моделирование нестационарного фильтра

- •Постановка задачи

- •Инициализация сети

- •Проверка сети

- •9.2. Распознавание образов

- •Постановка задачи

- •Нейронная сеть

- •Архитектура сети

- •Инициализация сети

- •Обучение

- •Обучение в отсутствие шума

- •Обучение в присутствии шума

- •Повторное обучение в отсутствие шума

- •Эффективность функционирования системы

- •9.3. Нейронные сети и системы управления

- •9.3.1. Регулятор с предсказанием

- •9.3.2. Регулятор narma-l2

- •9.3.3. Регулятор на основе эталонной модели

- •Часть2. Операторы, функции и команды

- •10. Вычислительная модель нейронной сети

- •10.1. Описание сети Описание архитектуры

- •Функции инициализации, адаптации и обучения

- •10.2. Описание элементов сети

- •Описание входов

- •Описание слоев

- •Описание выходов

- •Описание целей

- •Описание смещений

- •Описание весов входа

- •Описание весов слоя

- •Матрицы весов и векторы смещений

- •Информационные поля

- •11. Формирование моделей нейронных сетей

- •11.1. Модели сетей

- •11.1.1. Однослойные сети Персептрон

- •Линейные сети

- •11.1.2. Многослойные сети

- •Радиальные базисные сети

- •Самоорганизующиеся сети

- •Сети – классификаторы входных векторов

- •Рекуррентные сети

- •11.2. Функции активации

- •Персептрон

- •Линейные сети

- •Радиальные базисные сети

- •Самоорганизующиеся сети

- •Рекуррентные сети

- •11.3. Синаптические функции

- •Функции взвешивания и расстояний

- •Функции накопления

- •11.4. Функции инициализации

- •11.5. Функции адаптации и обучения Функции адаптации

- •Функции обучения

- •Градиентные алгоритмы обучения

- •Алгоритмы метода сопряженных градиентов

- •Квазиньютоновы алгоритмы обучения

- •11.5.1. Функции оценки качества обучения

- •11.6. Функции настройки параметров

- •11.6.1. Функции одномерного поиска

- •11.7. Масштабирование и восстановление данных

- •11.8. Вспомогательные функции

- •Утилиты вычислений

- •Операции с массивами данных

- •Графические утилиты

- •Информация о сети и ее топологии

- •11.9. Моделирование нейронных сетей и система Simulink Функции моделирования сети

- •11.9.1. Применение системы Simulink

- •Библиотеки блоков для моделирования нейронных сетей

- •Построение моделей нейронных сетей

- •Индексный указатель Команды, функции и операторы ппп Neural Network Toolbox

- •Предметный указатель

- •Литература Книги на английском языке:

- •Книги на русском языке:

- •Оглавление

Xlabel(''), ylabel('Выходыa(I)'),grid

subplot(3,1,2)

plot(0:30,[[0 0]; W],'k') % Рис3.1,б

Xlabel(''), ylabel('Весавходовw(I)'),grid

subplot(3,1,3)

for i=1:30, E(i) = mse(e{i}); end

semilogy(1:30, E,'+k') % Рис. 3.1,в

Xlabel(' Циклы'), ylabel('Ошибка'),grid

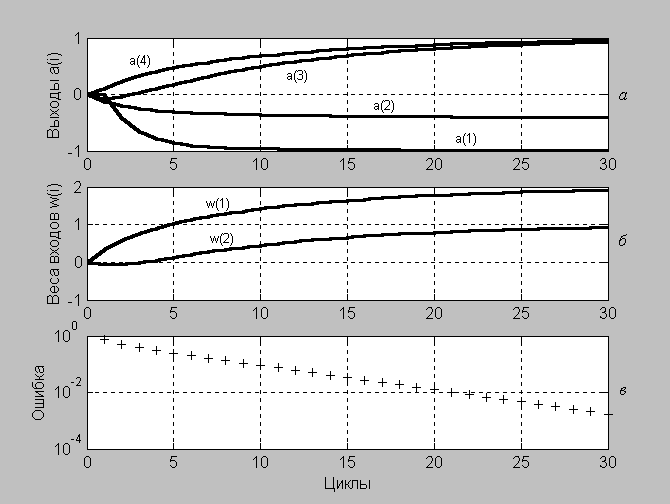

Рис. 3.1

Первый выход тот же, что и при нулевом значении параметра скорости настройки, так как до предъявления сети первого входа никаких модификаций не происходит. Второй выход отличается, так как параметры сети были модифицированы. Веса продолжают изменяться при подаче нового входа. Если сеть соответствует задаче, корректно заданы обучающие последовательности, начальные условия и параметр скорости настройки, то в конечном счете погрешность может быть сведена к нулю.

В этом можно убедиться, изучая процесс адаптации, показанный на рис. 3.1. Условие окончания адаптации определяется погрешностью приближения к целевому вектору; в данном случае мерой такой погрешности является среднеквадратичная ошибка mse(e{i}), которая должна быть меньше 0.015.

На рис. 3.1, апоказаны выходы нейронов в процессе адаптации сети, на рис. 3.1,б– коэффициенты восстанавливаемой зависимости, которые соответствуют элементам вектора весов входа, а на рис. 3.1,в– ошибка обучения. Как следует из анализа графиков, за 12 шагов получена ошибка обучения 1.489e–3.

Предлагаем читателю самостоятельно убедиться, что для исследуемой зависимости обучающие последовательности вида

P = {[–1; 1] [–1/2; 1/2] [1/2; –1/2] [1; –1]}; % Массив векторов входа

T = {–1 –1/2 1/2 1}; % Массив векторов цели

не являются представительными.

Групповой способ.Рассмотрим случай группового представления обучающей последовательности. В этом случае входы и целевой вектор формируются в виде массива формата double.

P = [–1 –1/3 1/2 1/6; 1 1/4 0 2/3];

T = [–1 –5/12 1 1];

Используется та же модель статической сети с теми же требованиями к погрешности адаптации. При обращении к М-функции adapt по умолчанию вызываются функцииadaptwbиlearnwh; последняя выполняет настройку параметров сети на основе алгоритма WH, реализующего правило Уидроу – Хоффа (Widrow – Hoff).

Основной цикл адаптации сети с заданной погрешностью выглядит следующим образом:

% Групповой способ адаптации сети с входами P и целями T

net3 = newlin([–1 1;–1 1],1, 0, 0.2);

net3.IW{1} = [0 0]; % Присваивание начальных весов

net3.b{1} = 0; % Присваивание начального смещения

net3.inputWeights{1,1}.learnParam.lr = 0.2;

P = [–1 –1/3 1/2 1/6; 1 1/4 0 2/3];

T = [–1 –5/12 1 1];

EE = 10; i=1;

while EE > 0.0017176

[net3,a{i},e{i},pf] = adapt(net3,P,T);

W(i,:) = net3.IW{1,1};

EE = mse(e{i});

ee(i)= EE;

i = i+1;

end

Результатом адаптации при заданной погрешности являются следующие значения коэффициентов линейной зависимости, значений выходов нейронной сети, приближающихся к значениям желаемого выхода, а также среднеквадратичная погрешность адаптации:

W(63,:)

ans = 1.9114 0.84766

cell2mat(a(63))

ans = –1.003 –0.36242 1.0172 0.94256

EE = mse(e{63})

EE = 0.0016368

mse(e{1})

ans = 0.7934

Процедура адаптации выходов и параметров нейронной сети иллюстрируется рис. 3.2.

subplot(3,1,1)

plot(0:63,[zeros(1,4); cell2mat(a')],'k') % Рис.3.2,a