- •В. Г. Потемкин

- •Предисловие

- •Введение

- •Используемые обозначения

- •Часть 1. Ппп Neural Network Toolbox

- •1. Система matlab 6

- •1.1. Операционная среда matlab 6

- •Командное окно

- •Окно предыстории

- •Окно запуска

- •Окно текущего каталога

- •Окно рабочей области

- •Справочная подсистема

- •1.3. Демонстрационные примеры ппп nnt

- •2. Модель нейрона и архитектура сети

- •2.1. Модель нейрона

- •2.1.1. Простой нейрон

- •2.1.2. Функция активации

- •2.1.3. Нейрон с векторным входом

- •2.2. Архитектура нейронных сетей

- •2.2.1. Однослойные сети

- •2.2.2. Многослойные сети

- •2.2.3. Сети с прямой передачей сигнала

- •2.3. Создание, инициализация и моделирование сети Формирование архитектуры сети

- •Инициализация сети

- •Моделирование сети

- •3. Обучение нейронных сетей

- •3.1. Процедуры адаптации и обучения

- •Явление переобучения

- •Свойство обобщения

- •3.1.1. Способы адаптации и обучения

- •Адаптация нейронных сетей

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel(' Циклы'), ylabel('Ошибка'),grid

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel('Циклы'), ylabel('Ошибка'),grid

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel('Циклы'), ylabel('Ошибка'),grid

- •Обучение нейронных сетей

- •3.2. Методы обучения

- •3.2.1. Обучение однослойной сети

- •3.2.2. Обучение многослойной сети

- •Метод обратного распространения ошибки

- •Характеристика методов обучения

- •3.3. Алгоритмы обучения

- •3.3.1. Градиентные алгоритмы обучения Алгоритм gd

- •Алгоритм gdm

- •Алгоритм gda

- •Алгоритм Rprop

- •3.3.2. Алгоритмы метода сопряженных градиентов

- •Алгоритм cgf

- •Алгоритм cgp

- •Алгоритм cgb

- •Алгоритм scg

- •3.3.3. Квазиньютоновы алгоритмы Алгоритм bfgs

- •Алгоритм oss

- •Алгоритм lm

- •3.3.4. Алгоритмы одномерного поиска

- •Алгоритм gol

- •Алгоритм bre

- •Алгоритм hyb

- •Алгоритм cha

- •Алгоритм bac

- •3.3.5. Расширение возможностей процедур обучения

- •Переобучение

- •Метод регуляризации

- •Формирование представительной выборки

- •Предварительная обработка и восстановление данных

- •Пример процедуры обучения

- •4. Персептроны

- •4.1. Архитектура персептрона

- •4.2. Модель персептрона

- •Моделирование персептрона

- •Инициализация параметров

- •4.3. Процедуры настройки параметров

- •Правила настройки

- •Процедура адаптации

- •5. Линейные сети

- •5.1. Архитектура линейной сети

- •5.2. Создание модели линейной сети

- •5.3. Обучение линейной сети

- •Процедура настройки

- •Процедура обучения

- •5.4. Применение линейных сетей Задача классификации векторов

- •Фильтрация сигнала

- •Предсказание сигнала

- •Подавление шумов

- •Многомерные цифровые фильтры

- •6. Радиальные базисные сети

- •Модель нейрона и архитектура сети

- •Создание сети

- •Радиальная базисная сеть с нулевой ошибкой

- •Итерационная процедура формирования сети

- •Примеры радиальных базисных сетей

- •6.1. Сети grnn

- •Архитектура сети

- •Синтез сети

- •6.2. Сети pnn

- •Архитектура сети

- •Синтез сети

- •7. Сети кластеризации и классификации данных

- •7.1. Самоорганизующиеся нейронные сети

- •7.1.1. Слой Кохонена

- •Архитектура сети

- •Создание сети

- •Правило обучения слоя Кохонена

- •Правило настройки смещений

- •Обучение сети

- •7.1.2. Карта Кохонена

- •Топология карты

- •Функции для расчета расстояний

- •Архитектура сети

- •Создание сети

- •Обучение сети

- •Одномерная карта Кохонена

- •Двумерная карта Кохонена

- •Архитектура сети

- •Создание сети

- •Обучение сети Правила настройки параметров

- •Процедура обучения

- •8. Рекуррентные сети

- •8.1. Сети Элмана

- •Архитектура

- •Создание сети

- •Обучение сети

- •Проверка сети

- •8.2. Сети Хопфилда

- •Архитектура сети

- •Синтез сети

- •9. Применение нейронных сетей

- •9.1. Аппроксимация и фильтрация сигналов

- •9.1.1. Предсказание стационарного сигнала Постановка задачи

- •Синтез сети

- •Проверка сети

- •9.1.2. Слежение за нестационарным сигналом

- •Инициализация сети

- •Проверка сети

- •9.1.3. Моделирование стационарного фильтра

- •Постановка задачи

- •Синтез сети

- •Проверка сети

- •9.1.4. Моделирование нестационарного фильтра

- •Постановка задачи

- •Инициализация сети

- •Проверка сети

- •9.2. Распознавание образов

- •Постановка задачи

- •Нейронная сеть

- •Архитектура сети

- •Инициализация сети

- •Обучение

- •Обучение в отсутствие шума

- •Обучение в присутствии шума

- •Повторное обучение в отсутствие шума

- •Эффективность функционирования системы

- •9.3. Нейронные сети и системы управления

- •9.3.1. Регулятор с предсказанием

- •9.3.2. Регулятор narma-l2

- •9.3.3. Регулятор на основе эталонной модели

- •Часть2. Операторы, функции и команды

- •10. Вычислительная модель нейронной сети

- •10.1. Описание сети Описание архитектуры

- •Функции инициализации, адаптации и обучения

- •10.2. Описание элементов сети

- •Описание входов

- •Описание слоев

- •Описание выходов

- •Описание целей

- •Описание смещений

- •Описание весов входа

- •Описание весов слоя

- •Матрицы весов и векторы смещений

- •Информационные поля

- •11. Формирование моделей нейронных сетей

- •11.1. Модели сетей

- •11.1.1. Однослойные сети Персептрон

- •Линейные сети

- •11.1.2. Многослойные сети

- •Радиальные базисные сети

- •Самоорганизующиеся сети

- •Сети – классификаторы входных векторов

- •Рекуррентные сети

- •11.2. Функции активации

- •Персептрон

- •Линейные сети

- •Радиальные базисные сети

- •Самоорганизующиеся сети

- •Рекуррентные сети

- •11.3. Синаптические функции

- •Функции взвешивания и расстояний

- •Функции накопления

- •11.4. Функции инициализации

- •11.5. Функции адаптации и обучения Функции адаптации

- •Функции обучения

- •Градиентные алгоритмы обучения

- •Алгоритмы метода сопряженных градиентов

- •Квазиньютоновы алгоритмы обучения

- •11.5.1. Функции оценки качества обучения

- •11.6. Функции настройки параметров

- •11.6.1. Функции одномерного поиска

- •11.7. Масштабирование и восстановление данных

- •11.8. Вспомогательные функции

- •Утилиты вычислений

- •Операции с массивами данных

- •Графические утилиты

- •Информация о сети и ее топологии

- •11.9. Моделирование нейронных сетей и система Simulink Функции моделирования сети

- •11.9.1. Применение системы Simulink

- •Библиотеки блоков для моделирования нейронных сетей

- •Построение моделей нейронных сетей

- •Индексный указатель Команды, функции и операторы ппп Neural Network Toolbox

- •Предметный указатель

- •Литература Книги на английском языке:

- •Книги на русском языке:

- •Оглавление

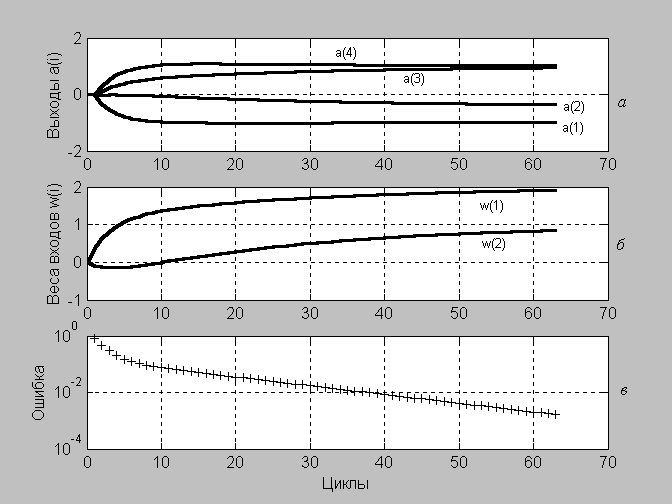

Xlabel(''), ylabel('Выходыa(I)'),grid

subplot(3,1,2)

plot(0:63,[[0 0]; W],'k') % Рис.3.2,б

Xlabel(''), ylabel('Весавходовw(I)'),grid

subplot(3,1,3)

semilogy(1:63, ee,'+k') % Рис.3.2,в

Xlabel('Циклы'), ylabel('Ошибка'),grid

Рис. 3.2

Как следует из анализа графиков, для достижения требуемой точности адаптации требуется 12 шагов. Сравнивая рис. 3.2 и 3.1, можно убедиться, что существует различие в динамике процедур адаптации при последовательном и групповом представлении данных.

Динамические сети.Эти сети характеризуются наличием линий задержки, и для них последовательное представление входов является наиболее естественным.

Последовательный способ.Обратимся к линейной модели нейронной сети с одним входом и одним элементом запаздывания. Установим начальные условия на линии задержки, а также для весов и смещения равными 0, а параметр скорости настройки равным 0.5:

net = newlin([–1 1],1,[0 1],0.5);

Pi = {0}; % Начальное условие для элемента запаздывания

net.IW{1} = [0 0]; % Значения весов

net.biasConnect = 0; % Значение смещения

Чтобы применить последовательный способ адаптации, представим входы и цели как массивы ячеек:

P = {–1/2 1/3 1/5 1/4}; % Вектор входа

T = { –1 1/6 11/15 7/10}; % Вектор цели

Попытаемся приспособить сеть для формирования нужного выхода на основе следующего соотношения:

y(t) = 2p(t) + p(t–1).

Используем для этой цели М-функцию adapt и основной цикл адаптации сети с заданной погрешностью, как это уже было описано выше:

EE = 10; i = 1;

while EE > 0.0001

[net,a{i},e{i},pf] = adapt(net,P,T);

W(i,:)=net.IW{1,1};

EE = mse(e{i});

ee(i) = EE;

i = i+1;

end

Сеть адаптировалась за 22 цикла. Результатом адаптации при заданной погрешности являются следующие значения коэффициентов линейной зависимости, значений выходов нейронной сети, приближающихся к значениям желаемого выхода, а также среднеквадратичная погрешность адаптации:

W(22,:)

ans = 1.983 0.98219

a{22}

ans = [–0.98955] [0.17136] [0.72272] [0.69177]

EE

EE = 7.7874e–005

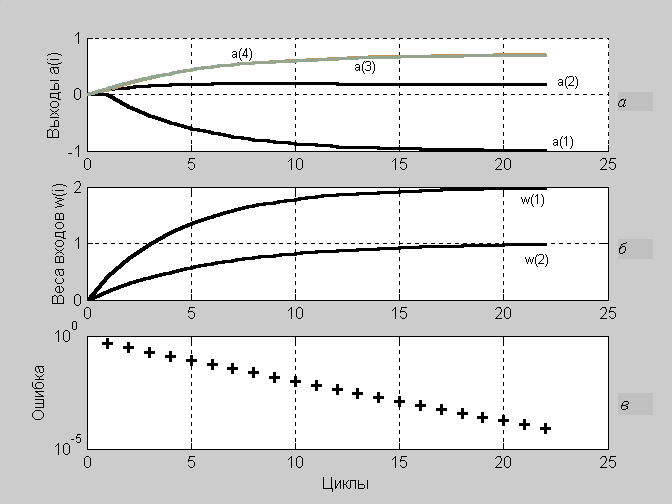

Построим графики зависимости выходов системы и весовых коэффициентов от числа циклов обучения (рис. 3.3):

subplot(3,1,1)

plot(0:22,[zeros(1,4); cell2mat(cell2mat(a'))],'k') % Рис.3.3,a

Xlabel(''), ylabel('Выходыa(I)'),grid

subplot(3,1,2)

plot(0:22,[[0 0]; W],'k') % Рис.3.3,б

Xlabel(''), ylabel('Весавходовw(I)'),grid

subplot(3,1,3)

semilogy(1:22,ee,'+k') % Рис.3.3,в

Xlabel('Циклы'), ylabel('Ошибка'),grid

Рис. 3.3

На рис. 3.3, апоказаны выходы нейронов в процессе адаптации сети, а на рис. 3.3,б– коэффициенты восстанавливаемой зависимости, которые соответствуют элементам вектора весов входа.

Групповой способпредставления обучающего множества для адаптации динамических систем не применяется.

Обучение нейронных сетей

Статические сети.Воспользуемся рассмотренной выше моделью однослойной линейной сети с двухэлементным вектором входа, значения которого находятся в интервале [–1 1], и нулевым параметром скорости настройки, как это было для случая адаптации:

% Формирование однослойной статической линейной сети с двумя входами

% и нулевым параметром скорости настройки

net = newlin([–1 1;–1 1],1, 0, 0);

net.IW{1} = [0 0]; % Значения весов

net.b{1} = 0; % Значения смещений

Требуется обучить параметры сети так, чтобы она формировала линейную зависимость вида

![]()

Последовательный способ. Для этого представим обучающую последовательность в виде массивов ячеек

P = {[–1; 1] [–1/3; 1/4] [1/2; 0] [1/6; 2/3]}; % Массив векторов входа

T = {–1 –5/12 1 1}; % Массив векторов цели

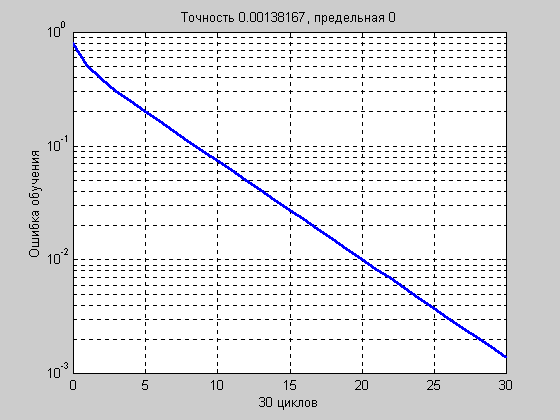

Теперь все готово к обучению сети. Будем обучать ее с помощью функции trainв течение 30 циклов.

В этом случае для обучения и настройки параметров сети используются функции trainwb и learnwh соответственно.

% Параметр скорости настройки весов

net.inputWeights{1,1}.learnParam.lr = 0.2;

net.biases{1}.learnParam.lr = 0; % Параметр скорости настройки смещений

net.trainParam.epochs = 30; % Число циклов обучения

net1 = train(net,P,T);

Параметры сети после обучения равны следующим значениям:

W = net1.IW{1}

W = 1.9214 0.92599

y = sim(net1, P)

y = [–0.99537] [–0.40896] [0.96068] [0.93755]

EE = mse([y{:}]–[T{:}])

EE = 1.3817e–003

Зависимость величины ошибки обучения от числа циклов обучения приведена на рис. 3.4.

Рис. 3.4

Рис. 3.4

Это тот же самый результат, который был получен для группового способа адаптации с использованием функции adapt.

Групповой способ. Для этого представим обучающую последовательность в виде массивов форматаdoublearray:

P = [–1 –1/3 1/2 1/6; 1 1/4 0 2/3];

T = [–1 –5/12 1 1];

net1 = train(net,P,T);

TRAINWB, Epoch 0/10, MSE 0.793403/0.

TRAINWB, Epoch 10/10, MSE 0.00243342/0.

TRAINWB, Maximum epoch reached.

Параметры сети после обучения равны следующим значениям:

W = net1.IW{1}

W = 1.9214 0.92599

y = sim(net1, P)

y = –0.99537 –0.40896 0.96068 0.93755

EE = mse(y–T)

EE = 1.3817e–003

Этот результат полностью совпадает с результатом последовательного обучения этой же сети.

Динамические сети.Обучение динамических сетей выполняется аналогичным образом с использованием методаtrain.

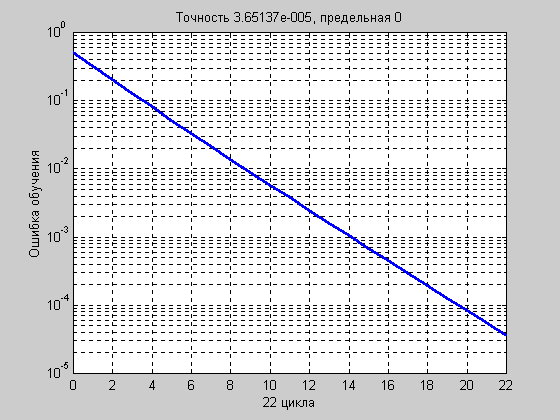

Последовательный способ.Обратимся к линейной модели нейронной сети с одним входом и одним элементом запаздывания.

Установим начальные условия для элемента запаздывания, весов и смещения равными 0, а параметр скорости настройки равным 0.5:

net = newlin([–1 1],1,[0 1],0.5);

Pi = {0}; % Начальное условие для элемента запаздывания

net.IW{1} = [0 0]; % Значения весов

net.biasConnect = 0; % Значение смещения

net.trainParam.epochs = 22;

Чтобы применить последовательный способ обучения, представим входы и цели как массивы ячеек:

P = {–1/2 1/3 1/5 1/4}; % Вектор входа

Обучим сеть формировать нужный выход на основе соотношения y(t) = 2p(t) + p(t–1), тогда

T = { –1 1/6 11/15 7/10}; % Вектор цели

Используем для этой цели М-функцию train:

net1 = train(net, P, T, Pi);

Параметры сети после обучения равны следующим значениям:

W = net1.IW{1}

W = 1.9883 0.98414

y = sim(net1, P)

y = [–0.99414] [0.17069] [0.7257] [0.6939]

EE = mse([y{:}]–[T{:}])

EE = 3.6514e–005

График зависимости ошибки обучения от числа циклов приведен на рис. 3.5.

Рис. 3.5

Рис. 3.5

Предлагаем читателю самостоятельно выполнить сравнение результатов обучения с результатами адаптации этой же сети.

Групповой способ представления обучающей последовательности для обучения динамических систем не применяется.