- •В. Г. Потемкин

- •Предисловие

- •Введение

- •Используемые обозначения

- •Часть 1. Ппп Neural Network Toolbox

- •1. Система matlab 6

- •1.1. Операционная среда matlab 6

- •Командное окно

- •Окно предыстории

- •Окно запуска

- •Окно текущего каталога

- •Окно рабочей области

- •Справочная подсистема

- •1.3. Демонстрационные примеры ппп nnt

- •2. Модель нейрона и архитектура сети

- •2.1. Модель нейрона

- •2.1.1. Простой нейрон

- •2.1.2. Функция активации

- •2.1.3. Нейрон с векторным входом

- •2.2. Архитектура нейронных сетей

- •2.2.1. Однослойные сети

- •2.2.2. Многослойные сети

- •2.2.3. Сети с прямой передачей сигнала

- •2.3. Создание, инициализация и моделирование сети Формирование архитектуры сети

- •Инициализация сети

- •Моделирование сети

- •3. Обучение нейронных сетей

- •3.1. Процедуры адаптации и обучения

- •Явление переобучения

- •Свойство обобщения

- •3.1.1. Способы адаптации и обучения

- •Адаптация нейронных сетей

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel(' Циклы'), ylabel('Ошибка'),grid

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel('Циклы'), ylabel('Ошибка'),grid

- •Xlabel(''), ylabel('Выходыa(I)'),grid

- •Xlabel(''), ylabel('Весавходовw(I)'),grid

- •Xlabel('Циклы'), ylabel('Ошибка'),grid

- •Обучение нейронных сетей

- •3.2. Методы обучения

- •3.2.1. Обучение однослойной сети

- •3.2.2. Обучение многослойной сети

- •Метод обратного распространения ошибки

- •Характеристика методов обучения

- •3.3. Алгоритмы обучения

- •3.3.1. Градиентные алгоритмы обучения Алгоритм gd

- •Алгоритм gdm

- •Алгоритм gda

- •Алгоритм Rprop

- •3.3.2. Алгоритмы метода сопряженных градиентов

- •Алгоритм cgf

- •Алгоритм cgp

- •Алгоритм cgb

- •Алгоритм scg

- •3.3.3. Квазиньютоновы алгоритмы Алгоритм bfgs

- •Алгоритм oss

- •Алгоритм lm

- •3.3.4. Алгоритмы одномерного поиска

- •Алгоритм gol

- •Алгоритм bre

- •Алгоритм hyb

- •Алгоритм cha

- •Алгоритм bac

- •3.3.5. Расширение возможностей процедур обучения

- •Переобучение

- •Метод регуляризации

- •Формирование представительной выборки

- •Предварительная обработка и восстановление данных

- •Пример процедуры обучения

- •4. Персептроны

- •4.1. Архитектура персептрона

- •4.2. Модель персептрона

- •Моделирование персептрона

- •Инициализация параметров

- •4.3. Процедуры настройки параметров

- •Правила настройки

- •Процедура адаптации

- •5. Линейные сети

- •5.1. Архитектура линейной сети

- •5.2. Создание модели линейной сети

- •5.3. Обучение линейной сети

- •Процедура настройки

- •Процедура обучения

- •5.4. Применение линейных сетей Задача классификации векторов

- •Фильтрация сигнала

- •Предсказание сигнала

- •Подавление шумов

- •Многомерные цифровые фильтры

- •6. Радиальные базисные сети

- •Модель нейрона и архитектура сети

- •Создание сети

- •Радиальная базисная сеть с нулевой ошибкой

- •Итерационная процедура формирования сети

- •Примеры радиальных базисных сетей

- •6.1. Сети grnn

- •Архитектура сети

- •Синтез сети

- •6.2. Сети pnn

- •Архитектура сети

- •Синтез сети

- •7. Сети кластеризации и классификации данных

- •7.1. Самоорганизующиеся нейронные сети

- •7.1.1. Слой Кохонена

- •Архитектура сети

- •Создание сети

- •Правило обучения слоя Кохонена

- •Правило настройки смещений

- •Обучение сети

- •7.1.2. Карта Кохонена

- •Топология карты

- •Функции для расчета расстояний

- •Архитектура сети

- •Создание сети

- •Обучение сети

- •Одномерная карта Кохонена

- •Двумерная карта Кохонена

- •Архитектура сети

- •Создание сети

- •Обучение сети Правила настройки параметров

- •Процедура обучения

- •8. Рекуррентные сети

- •8.1. Сети Элмана

- •Архитектура

- •Создание сети

- •Обучение сети

- •Проверка сети

- •8.2. Сети Хопфилда

- •Архитектура сети

- •Синтез сети

- •9. Применение нейронных сетей

- •9.1. Аппроксимация и фильтрация сигналов

- •9.1.1. Предсказание стационарного сигнала Постановка задачи

- •Синтез сети

- •Проверка сети

- •9.1.2. Слежение за нестационарным сигналом

- •Инициализация сети

- •Проверка сети

- •9.1.3. Моделирование стационарного фильтра

- •Постановка задачи

- •Синтез сети

- •Проверка сети

- •9.1.4. Моделирование нестационарного фильтра

- •Постановка задачи

- •Инициализация сети

- •Проверка сети

- •9.2. Распознавание образов

- •Постановка задачи

- •Нейронная сеть

- •Архитектура сети

- •Инициализация сети

- •Обучение

- •Обучение в отсутствие шума

- •Обучение в присутствии шума

- •Повторное обучение в отсутствие шума

- •Эффективность функционирования системы

- •9.3. Нейронные сети и системы управления

- •9.3.1. Регулятор с предсказанием

- •9.3.2. Регулятор narma-l2

- •9.3.3. Регулятор на основе эталонной модели

- •Часть2. Операторы, функции и команды

- •10. Вычислительная модель нейронной сети

- •10.1. Описание сети Описание архитектуры

- •Функции инициализации, адаптации и обучения

- •10.2. Описание элементов сети

- •Описание входов

- •Описание слоев

- •Описание выходов

- •Описание целей

- •Описание смещений

- •Описание весов входа

- •Описание весов слоя

- •Матрицы весов и векторы смещений

- •Информационные поля

- •11. Формирование моделей нейронных сетей

- •11.1. Модели сетей

- •11.1.1. Однослойные сети Персептрон

- •Линейные сети

- •11.1.2. Многослойные сети

- •Радиальные базисные сети

- •Самоорганизующиеся сети

- •Сети – классификаторы входных векторов

- •Рекуррентные сети

- •11.2. Функции активации

- •Персептрон

- •Линейные сети

- •Радиальные базисные сети

- •Самоорганизующиеся сети

- •Рекуррентные сети

- •11.3. Синаптические функции

- •Функции взвешивания и расстояний

- •Функции накопления

- •11.4. Функции инициализации

- •11.5. Функции адаптации и обучения Функции адаптации

- •Функции обучения

- •Градиентные алгоритмы обучения

- •Алгоритмы метода сопряженных градиентов

- •Квазиньютоновы алгоритмы обучения

- •11.5.1. Функции оценки качества обучения

- •11.6. Функции настройки параметров

- •11.6.1. Функции одномерного поиска

- •11.7. Масштабирование и восстановление данных

- •11.8. Вспомогательные функции

- •Утилиты вычислений

- •Операции с массивами данных

- •Графические утилиты

- •Информация о сети и ее топологии

- •11.9. Моделирование нейронных сетей и система Simulink Функции моделирования сети

- •11.9.1. Применение системы Simulink

- •Библиотеки блоков для моделирования нейронных сетей

- •Построение моделей нейронных сетей

- •Индексный указатель Команды, функции и операторы ппп Neural Network Toolbox

- •Предметный указатель

- •Литература Книги на английском языке:

- •Книги на русском языке:

- •Оглавление

6.2. Сети pnn

Нейронные сети PNN(Probabilistic Neural Networks) описаны в работе [43] и предназначены для решения вероятностных задач, и в частности задач классификации.

Архитектура сети

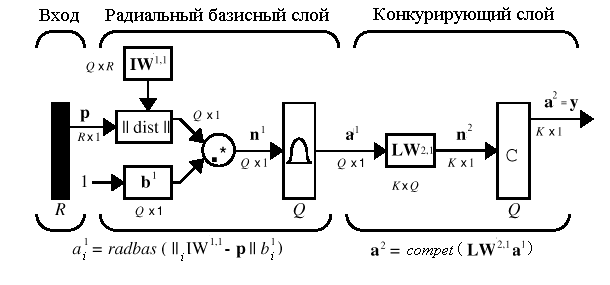

Архитектура сети PNNбазируется на архитектуре радиальной базисной сети, но в качестве второго слоя использует так называемыйконкурирующий слой, который подсчитывает вероятность принадлежности входного вектора к тому или иному классу и в конечном счете сопоставляет вектор с тем классом, вероятность принадлежности к которому выше. Структура сетиPNNпредставлена на рис. 6.14.

Рис. 6.14

Рис. 6.14

Предполагается, что задано обучающее множество, состоящее из Qпар векторов вход/цель. Каждый вектор цели имеетKэлементов, указывающих класс принадлежности, и, таким образом, каждый вектор входа ставится в соответствие одному изKклассов. В результате может быть образована матрица связностиT размераKQ, состоящая из нулей и единиц, строки которой соответствуют классам принадлежности, а столбцы – векторам входа. Таким образом, если элементT(i,j) матрицы связности равен 1, то это означает, чтоj-й входной вектор принадлежит к классуi.

Весовая матрица первого слоя IW11(net.IW{1,1}) формируется с использованием векторов входа из обучающего множества в виде матрицыP'. Когда подается новый вход, блок ||dist|| вычисляет близость нового вектора к векторам обучающего множества; затем вычисленные расстояния умножаются на смещения и подаются на вход функции активацииradbas. Вектор обучающего множества, наиболее близкий к вектору входа, будет представлен в векторе выходаa1числом, близким к 1.

Весовая матрица второго слоя LW21(net.LW{2,1}) соответствует матрице связностиT, построенной для данной обучающей последовательности. Эта операция может быть выполнена с помощью М-функцииind2vec, которая преобразует вектор целей в матрицу связностиT. ПроизведениеT*a1определяет элементы вектораa1, соответствующие каждому изKклассов. В результате конкурирующая функция активации второго слояcompetформирует на выходе значение, равное 1, для самого большого по величине элемента вектораn2и 0 в остальных случаях. Таким образом, сетьPNNвыполняет классификацию векторов входа поKклассам.

Синтез сети

Для создания нейронной сети PNN предназначена М-функция newpnn. Определим 7 следующих векторов входа и соотнесем каждый из них с одним из трех классов:

P = [0 0;1 1;0 3;1 4;3 1;4 1;4 3]';

Tc = [1 1 2 2 3 3 3];

Вектор Тсназовемвектором индексов классов. Этому индексному вектору можно поставить в соответствие матрицу связностиTв виде разреженной матрицы вида

T = ind2vec(Tc)

T =

(1,1) 1

(1,2) 1

(2,3) 1

(2,4) 1

(3,5) 1

(3,6) 1

(3,7) 1

которая определяет принадлежность первых двух векторов к классу 1, двух последующих –к классу 2 и трех последних – к классу 3. Полная матрицаТимеет вид:

Т = full(T)

Т =

1 1 0 0 0 0 0

0 0 1 1 0 0 0

0 0 0 0 1 1 1

Массивы РиТзадают обучающее множество, что позволяет выполнить формирование сети, промоделировать ее, используя массив входовP, и удостовериться, что сеть правильно решает задачу классификации на элементах обучающего множества. В результате моделирования сети формируется матрица связности, соответствующая массиву векторов входа. Для того чтобы преобразовать ее в индексный вектор, предназначена М-функцияvec2ind:

net = newpnn(P,T);

net.layers{1}.size % Число нейронов в сети PNN

ans = 7

Y = sim(net,P);

Yc = vec2ind(Y)

Yc = 1 1 2 2 3 3 3

Результат подтверждает правильность решения задачи классификации.

Выполним классификацию некоторого набора произвольных векторов р, не принадлежащих обучающему множеству, используя ранее созданную сеть PNN:

p = [1 3; 0 1; 5 2]';

Выполняя моделирование сети для этого набора векторов, получаем

a = sim(net,p);

ac = vec2ind(a)

ac = 2 1 3

Фрагмент демонстрационной программы demopnn1 позволяет проиллюстрировать результаты классификации в графическом виде:

clf reset, drawnow

p1 = 0:.05:5;

p2 = p1;

[P1,P2]=meshgrid(p1,p2);

pp = [P1(:) P2(:)];

aa = sim(net,pp');

aa = full(aa);

m = mesh(P1,P2,reshape(aa(1,:),length(p1),length(p2)));

set(m,'facecolor',[0.75 0.75 0.75],'linestyle','none');

hold on

view(3)

m = mesh(P1,P2,reshape(aa(2,:),length(p1),length(p2)));

set(m,'facecolor',[0 1 0.5],'linestyle','none');,

m = mesh(P1,P2,reshape(aa(3,:),length(p1),length(p2)));

set(m,'facecolor',[0 1 1],'linestyle','none');

plot3(P(1,:),P(2,:),ones(size(P,2))+0.1,'.','markersize',30)

plot3(p(1,:),p(2,:),1.1*ones(size(p,2)),'*','markersize',20,...'color',[1 0 0])

hold off

view(2)

Результаты классификации представлены на рис.6.15 и показывают, что 3 представленных сети вектора, отмеченные звездочками, классифицируются сетью PNN, состоящей из семи нейронов, абсолютно правильно.

Рис. 6.15

Рис. 6.15

В заключение отметим, что сети PNN могут весьма эффективно применяться для решения задач классификации. Если задано достаточно большое обучающее множество, то решения, генерируемые сетями, сходятся к решениям, соответствующим правилу Байеса. Недостаток сетей GRNNи PNN заключается в том, что работают они относительно медленно, поскольку выполняют очень большие объемы вычислений по сравнению с другими типами нейронных сетей.