- •1. Передача информации между двумя оконечными устройствами. Тип соединения оконечных устройств

- •2. Основные определения: информация, сообщение, система связи, сигнал, алфавит.

- •3. Обобщенная структура схемы системы связи

- •4. Источники сообщения в системах связи. Вероятностный характер источников сообщений.

- •5. Форматирование информации. Форматирование текстовых данных. Существующие стандарты.

- •6. Передача сообщений по каналу, искажения, краевые искажения, дробление

- •7. Аналоговые источники сообщений. Преобразование аналоговых сигналов в цифровые. Квантование по уровню. Ошибка квантования.

- •8. Дискретизация аналоговых сигналов по времени. Понятие о теореме Котельникова.

- •9. Преобразование аналоговых сигналов в цифровые. Дискретизация по методу «выборка-хранение». (доработать)

- •10. Сигнал, как реализация процесса. Классификация процессов.

- •11. Классификация процессов. Детерминированные процессы. Гармонические и переходные непериодические процессы.

- •12. Полигармонические и непериодические процессы их спектральные характеристики.

- •13. Определение случайного процесса. Непрерывные и дискретные случайные процессы.

- •14. Измерение случайных процессов.

- •15. Числовые характеристики случайных процессов, их инженерно-физический смысл.

- •16.Законы распределения и основные характеристики случайных процессов

- •17. Автокорреляционная функция случайного процесса. Примеры автокорр. Функций.

- •18. Взаимная корреляционная функция случайных процессов. Примеры применения корреляционных характеристик.

- •19. Усреднение по ансамблю и по времени. Эргодическое свойство случайных процессов.

- •20. Стационарность случайных процессов. Стационарность в широком и узком смыслах.

- •21. Информационные модели сигналов. Формула Хартли.

- •22. Информационные модели сигналов. Формула Шеннона.

- •23. Энтропия источника сообщений. Свойства энтропии источника дискретных сообщений.

- •24. Избыточность при передаче сообщений. Роль избыточности при передаче информации.

- •25. Математические модели сигналов. Временное и частотное представление сигналов.

- •26. Ряд Фурье по произвольной ортогональной системе функций.

- •31. Спектральные характеристики непериодического сигнала. Прямое и обратное преобразования Фурье.

- •32. Оценивание спектральной плотности с помощью дпф

- •33. Дискретное преобразование Фурье (дпф). Гармонический анализ.

- •34. Примеры ортогональных базисов. Функции Уолша.

- •35. Модуляция. Зачем она нужна

- •36. Амплитудная модуляция.Спектр ам сигнала. Примеры модуляторов.

- •37 Амплитудно-модулируемый сигнал сложной формы, его спектр.

- •38 Демодуляция ам сигнала. Работа простейшего амплитудного детектора.

- •43. Спектр колебаний с угловой модуляцией

- •44. Сравнение методов амплитудной и угловой модуляций

- •45. Двоичное представление информации. Механизм восстановления двоичных импульсов.

- •46. Спектральные характеристики случайных процессов.

- •47. Преобразование кодов.

- •48. Корректирующие коды. Ход Хемминга

- •49. Неравномерные коды. Код Хаффмана.

- •50. Неравномерные коды. Код Шеннона-Фано

- •51. Дискретизация аналоговых сигналов по времени. Понятие о теореме котельникова.

- •52. Спектр прямоугольного сиганала

- •53. Свойства энтропии источника дискретных сообщений.

22. Информационные модели сигналов. Формула Шеннона.

Информация проявляется, хранится и передается от одного объекта к другому в материально - энергетической форме в виде сигналов. Сигнал – физический процесс, используемый для передачи сообщений. Сигнал формируется с помощью изменения какого-либо физического параметра. Сигнал всегда описывается как функция t. Сигналом, как материальным носителем информации, может быть любой физический процесс (электрический, магнитный, оптический, акустический и пр.), определенные параметры которого (амплитуда, частота, энергия, интенсивность и др.) однозначно отображают информационные данные (сообщения).

Формула Шеннона.

Степень неопределенности состояния объекта (или так называемого источника информации) зависит не только от числа его возможных состояний, но и от вероятности этих состояний. При неравновероятных состояниях свобода выбора для источника ограничивается. Так, если из двух возможных состояний вероятность одного из них равна 0.999, то вероятность другого состояния соответственно равна 1-0.999 = 0.001, и при взаимодействии с таким источником результат практически предрешен.

В общем случае, в соответствии с теорией вероятностей, источник информации однозначно и полно характеризуется ансамблем состояний U = {u1, u2,..., uN} с вероятностями состояний соответственно {р(u1), р(u2),..., р(uN)} при условии, что сумма вероятностей всех состояний равна 1. Мера количества информации, как неопределенности выбора дискретным источником состояния из ансамбля U, предложена К. Шенноном в 1946 году и получила название энтропии дискретного источника информации или энтропии конечного ансамбля:

H(U)

= -![]() pn

log2

pn

pn

log2

pn

Мера энтропии Шеннона является обобщением меры Хартли на случай ансамблей с неравновероятными состояниями. Энтропия конечного ансамбля H(U) характеризует неопределенность, приходящуюся в среднем на одно состояние ансамбля.

23. Энтропия источника сообщений. Свойства энтропии источника дискретных сообщений.

Степень неопределенности состояния объекта (или так называемого источника информации) зависит не только от числа его возможных состояний, но и от вероятности этих состояний. При неравновероятных состояниях свобода выбора для источника ограничивается. Так, если из двух возможных состояний вероятность одного из них равна 0.999, то вероятность другого состояния соответственно равна 1-0.999 = 0.001, и при взаимодействии с таким источником результат практически предрешен.

В общем случае, в соответствии с теорией вероятностей, источник информации однозначно и полно характеризуется ансамблем состояний U = {u1, u2,..., uN} с вероятностями состояний соответственно {р(u1), р(u2),..., р(uN)} при условии, что сумма вероятностей всех состояний равна 1. Мера количества информации, как неопределенности выбора дискретным источником состояния из ансамбля U, предложена К. Шенноном в 1946 году и получила название энтропии дискретного источника информации или энтропии конечного ансамбля: H(U) = - pn log2 pn

Основные свойства энтропии:

1. Энтропия является величиной вещественной и неотрицательной, т.к. значения вероятностей pn находятся в интервале 0-1, значения log pn всегда отрицательны, а значения -pn log pn соответственно положительны.

2. Энтропия - величина ограниченная, т.к. при pn 0 значение -pnlog pn также стремится к нулю, а при 0 < pn 1 ограниченность суммы всех слагаемых очевидна.

3. Энтропия равна 0, если вероятность одного из состояний источника информации равна 1, и тем самым состояние источника полностью определено (вероятности остальных состояний источника равны нулю, т.к. сумма вероятностей должна быть равна 1).

4. Энтропия максимальна при равной вероятности всех состояний источника информации: Hmax(U) = - (1/N) log (1/N) = log N.

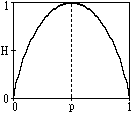

Рис. 1.4.1.

H(U) = -[p log p + (1-p) log (1-p)],

и изменяется от 0 до 1, достигая максимума при равенстве вероятностей. График изменения энтропии приведен на рис. 1.4.1.

6. Энтропия объединенных статистически независимых источников информации равна сумме их энтропий.

7. Энтропия характеризует среднюю неопределенность выбора одного состояния из ансамбля, игнорируя содержательную сторону ансамбля. Это расширяет возможности использования энтропии при анализе самых различных явлений, но требует определенной дополнительной оценки возникающих ситуаций, т.к. из рис. 1.4.1 следует, что энтропия состояний может быть неоднозначной.