- •Федеральное агентство связи

- •«Поволжский государственный университет телекоммуникаций и информатики»

- •Системы и сети передачи дискретных сообщений

- •1. Принципы построения и основные характеристики систем передачи дискретных сообщений

- •1.1. Основные понятия: информация, сообщение, сигнал

- •1.2. Первичное кодирование дискретных сообщений

- •1.3. Основные преобразования в системе пдс

- •1.4. Структурная схема системы пдс

- •1.5. Стыки в системах пдс

- •1.6. Способы передачи и обработки сигналов в системах пдс

- •1.7. Внешние и внутренние параметры систем пдс

- •2. Характеристики каналов систем передачи дискретных сообщений

- •2.1. Непрерывные каналы связи

- •2.2. Дискретный канал непрерывного времени и искажения единичных

- •2.2.1. Аналитическое описание краевых искажений

- •2.2.2. Аналитическое описание дроблений

- •2.3. Методы регистрации единичных элементов.

- •2.3.1. Регистрация методом стробирования

- •2.3.2. Интегральный метод регистрации

- •2.3.3. Комбинированный метод регистрации

- •2.3.4. Регистрация со стиранием

- •2.4. Классификация и основные характеристики дискретных каналов

- •2.4.1. Пропускная способность дискретного канала

- •2.5.Основные аналитические модели дискретных каналов

- •2.5.1 Модель канала с независимыми ошибками

- •2.5.2. Модель неоднородного канала

- •2.5.3. Двухпараметрическая модель(модель вкас, модель Пуртова)

- •3.Методы сопряжения источников дискретных сообщений с дискретными каналами

- •3.1 Основы эффективного кодирования

- •3.2. Метод Шеннона-Фано

- •3.3. Метод Хаффмена

- •3.4.Особенности сопряжения источников дискретных сообщений с асинхронными и синхронными дискретными каналами

- •3.4.1. Сопряжение синхронного оу с синхронным дк

- •3.4.2. Сопряжение стартстопных оу с синхронным дк (метод наложения)

- •3.4.3. Сопряжение стартстопных оу с синхронными дк (метод скользящего индекса)

- •1 Зоне – 00

- •2 Зоне – 01

- •3 Зоне – 10

- •4 Зоне – 11

- •4.Принципы построения и техническая реализация корректирующих кодов

- •4.1 Основные характеристики спдс

- •4.2. Классификация методов повышения верности

- •4.3 Системы пдс без ос с многократным повторением

- •4.4. Системы пдс без ос с корректирующими кодами

- •Для биномиальной модели дискретного канала

- •4.3.1. Декорреляция ошибок в системах пдс

- •4.4. Принципы помехоустойчивого кодирования

- •4.5. Основные характеристики помехоустойчивых кодов

- •4.6. Классификация помехоустойчивых кодов

- •4.7. Коды Хемминга

- •4.8. Матричное представление кодов с поэлементным формированием проверочных разрядов

- •4.10 Техническая реализация кодов Хэмминга

- •1 Dc 1

- •1 2 3 4 5 6 7 8 9

- •4.11. Циклические коды

- •4.12. Выбор образующего полинома

- •4.13. Определение места ошибки в кк циклического кода

- •4.14 Матричное представление кодов с формированием проверочных элементов в целом

- •4.15 Техническая реализация циклических кодов

- •4.16. Итеративные коды

- •5. Адаптация в системах передачи дискретных сообщений

- •5.1. Принципы адаптации. Классификация систем пдс с ос

- •5.2 Основные параметры систем с ос.

- •5.3 Система пдс с рос – ож. Алгоритм работы.

- •5.4. Структурная схема системы пдс с рос – ож.

- •5.5 Основные параметры системы рос-ож

- •5.6. Система пдс с рос-пп (нп)

- •5.7. Алгоритмы работы систем пдс с рос-пПбл

- •5.8. Структурная схема системы рос-пПбл

- •5.9. Параметры системы рос-пПбл

- •5.10. Системы пдс с рос и накоплением правильно принятых комбинаций

- •5.11. Система пдс с рос и адресным переспросом ( рос – ап)

- •5.12. Сравнение методов повышения верности в системах пдс

- •6. Методы и устройства синхронизации и фазирования

- •6.1. Задачи синхронизации и фазирования в системах пдс

- •6.2. Классификация методов реализации утс

- •6.3. Резонансные утс

- •6.4. Замкнутые утс с непосредственным воздействием на задающий генератор (зг)

- •6.5. Замкнутые утс без непосредственного воздействия на зг

- •6.6. Влияние погрешности тактовой синхронизации на достоверность приема

- •6.8. Системы фазирования по циклам. Предъявляемые требования

- •6.9. Классификация уцф.

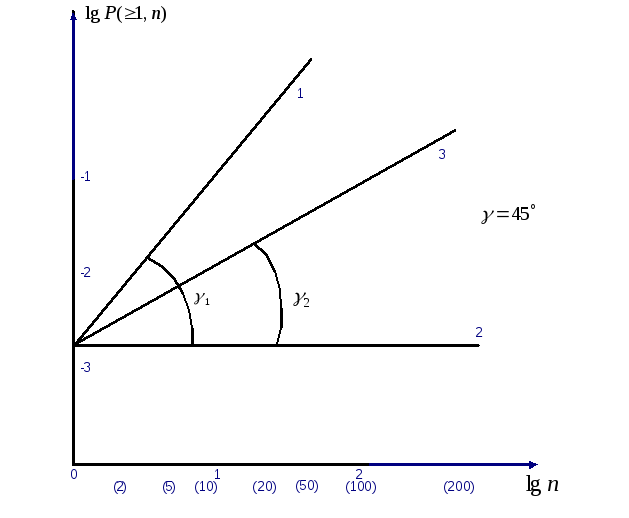

2.5.3. Двухпараметрическая модель(модель вкас, модель Пуртова)

Экспериментальные

исследования показали, что зависимость

![]() приn

от 1до 500 хорошо аппроксимируется прямыми

линиями при логарифмическом масштабе

по обеим осям координат.

приn

от 1до 500 хорошо аппроксимируется прямыми

линиями при логарифмическом масштабе

по обеим осям координат.

Рассмотрим подобную

зависимость для коммутируемого канала

ТЧ кабельной линии при вероятности

ошибки

![]() -

(рис 2.15) –прямая 3.

-

(рис 2.15) –прямая 3.

Рис.2.15 Зависимость

![]()

На рис.2.3 показаны два предельных варианта. Первый вариант - равномерное распределение независимых ошибок (прямая 1 ), а второй вариант - группирование ошибок в одну пачку (прямая 2).

Прямая

1 отражает зависимость

![]() (См.формулу (2.39).

(См.формулу (2.39).

Действительно:

![]() (2.42)

(2.42)

Это есть уравнение

прямой пересекающей ось ординат под

углом

![]() в точке

в точке![]() Еще раз напоминаем, что данная прямая

описывает симметричный ДК с равномерно

распределенными независимыми ошибками.

Еще раз напоминаем, что данная прямая

описывает симметричный ДК с равномерно

распределенными независимыми ошибками.

Прямая 2 - описывает

канал, в котором ошибки появляются

плотной группой. В этом случае (см. табл.

и рис.2.15) вероятность появления искажения

КК

![]() не зависит от длины КК-“n”.

не зависит от длины КК-“n”.

Поэтому:

![]() (2.43)

(2.43)

Это есть уравнение прямой, параллельной

оси абсцисс и пересекающейся с осью

ординат в точке

![]()

Прямая 3- экспериментальная зависимость.

Она находится между указанными границами

и имеет угловой наклон

![]() .

Уравнение этой прямой имеет вид

.

Уравнение этой прямой имеет вид

![]()

Обозначим

![]() и проведем операцию, обратную

логарифмированию, получим:

и проведем операцию, обратную

логарифмированию, получим:

![]() (2.44)

(2.44)

Величина

![]() называется показателем группирования

ошибок.

называется показателем группирования

ошибок.

Если

![]() =0-

то ошибки независимы и равномерно

распределены, т.е. приходим к формуле

(1.10) (прямая 1).

=0-

то ошибки независимы и равномерно

распределены, т.е. приходим к формуле

(1.10) (прямая 1).

Если

![]() =1

, то это другой предельный случай –все

ошибки сгруппированы в одну пачку

(прямая 2).

=1

, то это другой предельный случай –все

ошибки сгруппированы в одну пачку

(прямая 2).

В реальных каналах

![]() лежит в пределах

лежит в пределах![]()

Например, для

коммутируемых ТЧ (телефонных) каналов

![]()

для радиорелейных

каналов

![]()

Для определения вероятности появления L и более ошибок в КК длиной « n » можно воспользоваться формулой:

![]() (2.45)

(2.45)

Вероятность появления точно L ошибок определяется выражением :

![]() (2.46)

(2.46)

Модель Пуртова

достаточно хорошо отражает основные

свойства ДКС. Однако коэффициент

![]() может быть определен только экспериментально.

может быть определен только экспериментально.

3.Методы сопряжения источников дискретных сообщений с дискретными каналами

3.1 Основы эффективного кодирования

В технике передачи дискретных сообщений приходится решать задачу сопряжения (согласования) источников дискретных сообщений с каналом. Решение этой задачи связано с поиском путей передачи информации со скоростью, возможно более близкой к предельной.

Для большинства источников дискретных сообщений, характеризующихся информационной избыточностью, максимальная скорость передачи может быть достигнута в результате устранения избыточности в передаваемом сообщении. Процедуры, направленные на устранение избыточности источника дискретных сообщений, передаваемых по каналу без помех, называются эффективным кодированием.

Пусть имеется

сообщение, записанное с помощью букв

некоторого первичного алфавита

![]() содержащего К букв.

содержащего К букв.

Требуется закодировать это сообщение, т.е. указать правило сопоставления каждой букве первичного алфавита последовательности «0» и «1» , образующих вторичный алфавит.

При передаче

дискретных сообщений по каналам связи

буквы алфавита обычно отображаются

кодовыми комбинациями постоянной длины

(равномерное кодирование). Длина кодовой

комбинации n

выбирается из условия

![]()

Применение эффективного кодирования позволяет уменьшить среднее число l двоичных символов на букву сообщения:

![]() (3.1)

(3.1)

где

![]() -длина

кодовой комбинации, отображающейi-ю

букву;

-длина

кодовой комбинации, отображающейi-ю

букву;

![]() -вероятность

появления i-ой

буквы.

-вероятность

появления i-ой

буквы.

Уменьшение средней длины кодовой комбинации, отображающей букву сообщения, позволяет увечить скорость передачи.

Эффективное кодирование базируется на теореме Шеннона для каналов без шума.

Согласно этой теореме ( основной теореме кодирования), сообщения, составленные из букв некоторого алфавита, можно закодировать так, что среднее число l двоичных символов, приходящихся на букву, будет сколь угодно близко к энтропии источников этих сообщений Н(А), но не менее этой величины , т.е.

![]() (3.2)

(3.2)

![]()

Под энтропией дискретного источника Н(А) понимается среднее количество информации, приходящееся на одну букву сообщения:

![]() (3.3)

(3.3)

Для построения эффективных кодов наибольшее распространение нашли методики Шеннона-Фано и Хаффмена.