- •Предисловие

- •1.1. Постановка и классификация задач

- •1.2. Основные определения

- •1.3. Классический метод определения экстремума функции

- •Контрольные вопросы и задания

- •Глава 2. Одномерная оптимизация

- •2.1. Интервал неопределенности

- •2.2. Метод дихотомии

- •2.3. Метод фибоначчи

- •2.4. Метод золотого сечения

- •2.5. Метод квадратичной интерполяции

- •Контрольные вопросы и задания

- •Глава 3. Оптимизация функций нескольких переменных

- •3.1. Методы прямого поиска

- •3.1.1. Метод покоординатного спуска

- •3.1.2. Метод поиска Хука – Дживса

- •Метод Розенброка (метод вращающихся координат)

- •Метод Нелдера-Мида (метод деформируемого многогранника)

- •Метод сопряженных направлений Пауэлла

- •3.1.6. Методы случайного поиска

- •3.2. Градиентные методы

- •3.2.1. Метод наискорейшего спуска

- •Метод сопряженных градиентов Флетчера и Ривса

- •3.3. Методы второго порядка

- •3.3.1. Метод Ньютона

- •3.3.2.Метод Дэвидона - Флетчера - Пауэлла

- •Итерационная процедура Дэвидона-Флетчер-Пауэлла может быть представлена последовательностью шагов.

- •Контрольные вопросы и задания

- •Глава 4. Условная оптимизация

- •4.1. Множители лагранжа

- •4.2. Условия куна - таккера

- •Методы решения задач условной оптимизации

- •4.3.1. Метод последовательной безусловной оптимизации

- •4.3.2.Метод скользящего допуска

- •Контрольные вопросы и задания

- •Глава 5. Линейное программирование

- •5.1. Постановка задачи лп

- •Тогда задача лп (1) - (3) запишется в виде

- •5..2. Каноническая и стандартная формы задачи лп

- •5.3. Симплекс - метод

- •Порождение начального допустимого базисного решения

- •Двойственность в линейном программировании

- •5.6. Транспортная задача

- •Контрольные вопросы и задания

- •Заключение

- •Библиографический список

- •Глава1. Безусловная оптимизация………..………4

- •Глава 2. Одномерная оптимизация………..….…….9

- •Глава 3. Оптимизация функций нескольких переменных………………………………………..….…..20

- •Глава 4. Условная оптимизация…………………..49

- •Глава 5. Линейное программирование…………..60

- •Лидия Ивановна Лыткина Методы оптимизации с программами в системе mathcad

- •660014, Красноярск, просп. Им. Газ. ”Красноярский рабочий”, 31.

3.2. Градиентные методы

Другая группа методов, разработанная для решения задач безусловной оптимизации, состоит из градиентных методов. Их еще называют методами первого порядка, или методами спуска. Эти методы используют как значения функции, так и значения частных производных первого порядка, поэтому могут быть применены для минимизации только дифференцируемых функций. Методы первого порядка сходятся быстрее методов прямого поиска, так как в них учитываются производные, характеризующие направление наиболее быстрого убывания функции. Рассмотрим некоторые из них.

3.2.1. Метод наискорейшего спуска

Такой метод является одной из наиболее фундаментальных процедур минимизации дифференцируемых функций нескольких переменных.

В

методе наискорейшего спуска в качестве

направления поиска выбирается вектор,

направление которого противоположно

направлению вектора градиента функции

![]() .

Из математического анализа известно,

что вектор

.

Из математического анализа известно,

что вектор![]()

![]() характеризует направление наиболее

быстрого возрастания функции. Поэтому

вектор

характеризует направление наиболее

быстрого возрастания функции. Поэтому

вектор![]()

![]() называется антиградиентом и является

направлением наиболее быстрого ее

убывания. Рекуррентное соотношение, с

помощью которого реализуется метод

наискорейшего спуска, имеет вид

называется антиградиентом и является

направлением наиболее быстрого ее

убывания. Рекуррентное соотношение, с

помощью которого реализуется метод

наискорейшего спуска, имеет вид

![]()

![]() ,

,

где

![]() - величина шага. В зависимости от выбора

величины шага можно получить различные

варианты градиентного метода. Если в

процессе оптимизации величина шага

- величина шага. В зависимости от выбора

величины шага можно получить различные

варианты градиентного метода. Если в

процессе оптимизации величина шага![]() фиксирована, то метод носит название

градиентного метода с дискретным шагом.

Процесс оптимизации на первых итерациях

можно значительно ускорить, если

фиксирована, то метод носит название

градиентного метода с дискретным шагом.

Процесс оптимизации на первых итерациях

можно значительно ускорить, если![]() выбирать из условия

выбирать из условия

![]() .

.

Для

определения

![]() используется любой метод одномерной

оптимизации. В этом случае метод

называется методом наискорейшего

спуска. Как правило, в общем случае

недостаточно одного шага для достижения

минимума функции, процесс повторяют

до тех пор, пока последующие вычисления

позволяют улучшать результат.

используется любой метод одномерной

оптимизации. В этом случае метод

называется методом наискорейшего

спуска. Как правило, в общем случае

недостаточно одного шага для достижения

минимума функции, процесс повторяют

до тех пор, пока последующие вычисления

позволяют улучшать результат.

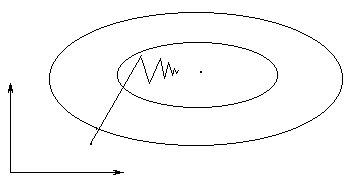

Рис. 14

Если

пространство очень вытянуто по некоторым

переменным, то образуется “овраг”.

Поиск может замедлиться и идти зигзагами

поперек дна “оврага” (рис. 14). Иногда

решение невозможно получить за приемлемое

время. Еще одним недостатком метода

может быть критерий остановки

![]() ,

так как этому условию удовлетворяет и

седловая точка, а не только оптимум.

,

так как этому условию удовлетворяет и

седловая точка, а не только оптимум.

Для ускорения сходимости градиентного метода в настоящее время разработано много различных приемов. Метод сопряженных градиентов один из них.

П ример.Щелкнув по значку,

откроется Mathcad

документ метода наискорейшего спуска,

в котором можно выполнить вычисления.

ример.Щелкнув по значку,

откроется Mathcad

документ метода наискорейшего спуска,

в котором можно выполнить вычисления.

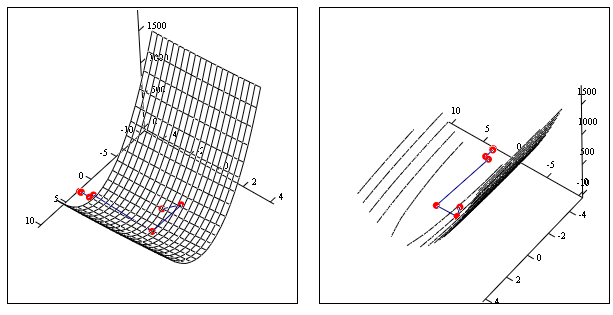

Минимизация функции

![]()

методом наискорейшего спуска

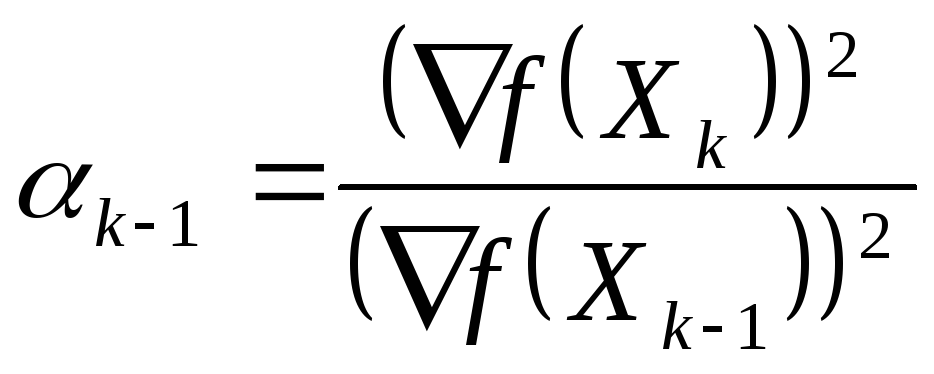

Метод сопряженных градиентов Флетчера и Ривса

В этом методе направление спуска отклоняется от направления антиградиента за счет добавления к нему вектора направления, используемого на предыдущем шаге, умноженного на некоторое положительное число.

Направления поиска на каждой итерации определяются с помощью формулы.

![]() ,

,

где

![]() являются предыдущими направлениями

поиска;

являются предыдущими направлениями

поиска;![]() - параметрами. Значения параметров

выбираются таким образом, чтобы

направление

- параметрами. Значения параметров

выбираются таким образом, чтобы

направление![]() было

было![]() -сопряженным

со всеми построенными ранее направлениями

поиска. Доказано, что это условие будет

выполняться при

-сопряженным

со всеми построенными ранее направлениями

поиска. Доказано, что это условие будет

выполняться при

![]()

![]()

![]() ,

, .

.

Если минимизируемая функция квадратичная и выпуклая, то алгоритм сопряженных градиентов приводит к оптимальному решению не более чем за n выполненных линейных поисков. Практические исследования показали, что этот метод сходится быстрее метода наискорейшего спуска, причем его эффективность возрастает на завершающих этапах поиска минимума функции. Кроме этого, следует отметить, что данный метод может быть использован при минимизации функций с разрывными производными. Поиск “не зависает на изломе”, а идет вдоль линии, соединяющей точки изломов линий уровня, которая, как правило, проходит через точку минимума.

Алгоритм.

Начальный этап.

Выбрать число

> 0 для остановки алгоритма и начальную

точку

![]() .

Положить

.

Положить

![]() =

=

![]() ,

,

![]() = -f(

= -f(![]() ),

k

= j

= 1 и перейти к основному этапу.

),

k

= j

= 1 и перейти к основному этапу.

Основной этап:

Шаг

1.

Если ||f(![]() )||

<

,

то минимум найден. В противном случае

взять в качестве j

оптимальное решение задачи минимизации

функции f(

)||

<

,

то минимум найден. В противном случае

взять в качестве j

оптимальное решение задачи минимизации

функции f(![]() +

+ ![]() )

при

0 и положить

)

при

0 и положить

![]() =

=![]() +j

+j![]() .

Если

.

Если![]() ,

то перейти к шагу 2; в противном случае

перейти

,

то перейти к шагу 2; в противном случае

перейти

к шагу 3.

Шаг 2.

Положить

![]() =-f(

=-f(![]() )+j

)+j![]() ,

где j=||f(

,

где j=||f(![]() )||2/||f(

)||2/||f(![]() )||2.

Заменить j

на j

+ 1 и перейти к шагу 1.

)||2.

Заменить j

на j

+ 1 и перейти к шагу 1.

Шаг

3.

Положить

![]() =

=

![]() =

=

![]() ,

,

![]() =

- f(

=

- f(![]() ),

j=1,

к = к+1 и перейти к шагу 1.

),

j=1,

к = к+1 и перейти к шагу 1.

Пример. Щелкнув по значку, откроется Mathcad документ метода Флетчера-Ривса, в котором можно выполнить вычисления.

Минимизация

функции

![]()

методом Флетчера – Ривса