- •Список обозначений

- •Введение

- •I. Общие вопросы информационного обмена

- •I.1. Информационные поля и коммуникация

- •I.1.1. Фазы обращения информации

- •I.1.2. Виды информации

- •1.1.3.Структура информации

- •I.2. Количество информации

- •I.2.1.Структурные меры информации

- •1.2.2.Традиционные и нетрадиционные системы счисления

- •1.2.4. Информационные показатели измерений и контроля

- •I.2.5. Семантическая мера информации

- •1.3. Задания для самоконтроля и подготовки

- •2. Представление и отображение информации

- •2.1. Проблема передачи информации оператору

- •2.2. Виды информационных каналов

- •2.2.1. Механические каналы

- •2.2.2. Акустические каналы.

- •2.2.3. Оптические каналы

- •2.2.4. Электрические каналы

- •2.2.5. Радиотехнические каналы

- •2.3. Восприятие визуальной информации оператором

- •2.4. Восприятие аудиоинформации оператором

- •2.4.1. Модели слухового восприятия

- •2.4.2. Механическая модель слухового аппарата человека

- •2.4.3.Восприятие гармонических сигналов («чистых» тонов)

- •2.5. Задания для самоконтроля и подготовки

- •3. Звук. Основы информационного обмена в звуковых полях

- •3.1. Линейные характеристики звукового поля

- •3.1.1. Связь звукового давления с колебательной скоростью

- •3.1.2. Плоская волна

- •3.1.3. Модели волн с неплоским фронтом

- •3.2. Отражение и преломление плоских волн

- •3.2.1. Волновые процессы на плоской границе раздела сред

- •3.2.2. Взаимодействие упругих волн с плоским слоем

- •3.2.3. Волновые процессы на границе раздела движущихся сред

- •3.2.4. Явление полного внутреннего отражения

- •3.2.5. Отражение звука неровной поверхностью

- •3.2.6. Отражение звука искривленной поверхностью. Интеграл Кирхгофа

- •3.3. Эффект Доплера

- •Поскольку , то из (3.61) можно записать:

- •3.4. Задания для самоконтроля и подготовки

- •4. Заключение

- •5. Глоссарий

- •Ответы на тестовые задания и методически рекомендации по их выполнению

- •6. Предметный указатель

- •7. Литература

- •Содержание

I.2. Количество информации

Важнейшим вопросом теории информации является установление меры количества и качества информации. Становление категорий информационных мер отвечает трем основным направлениям в подходах теории информации: структурному, статистическому и семантическому.

Структурная теория – рассматривает структурное строение информации и ее измерение на основе простого подсчета информационных элементов (квантов) или с использованием элементарных способов кодирования.

Статистическая теория – оперирует понятием энтропии как меры неопределенности, учитывающей вероятность появления, а, следовательно, и информативность тех или иных событий.

Семантическая теория – опирается на принципы установления связи между информативностью и категориями целесообразности, ценности, полезности, существенности и др. Указанные направления имеют свои области преимущественного использования:

структурная теория – применяется для оценки аппаратных возможностей каналов связи, запоминающих и других устройств вне зависимости от условий их применения.

статистическая теория – дает оценки применяемости информационных систем в конкретных условиях, например, при передаче в системе связи информации с определенными статистическими свойствами и находящейся под воздействием шумов.

семантическая теория – применима, например, к оценке эффективности опыта, осуществляемого логическим путем.

Для оценки количественной меры существенное значение имеет вид сообщения, создаваемого источником.

Дискретные сообщения слагаются из счетного множества элементов, создаваемых источником последовательно во времени. Набор различных элементов принято называть алфавитом источника, а элементы – буквами. Понятие буквы в данном контексте шире, чем в письменности, так как оно включает цифры и другие знаки. Число букв в алфавите называют объемом алфавита. Дискретный источник в конечное время создает конечное множество сообщений. Типичным дискретным сообщением является текст, записанный с помощью алфавита, последовательности чисел или заменяющих знаков.

Непрерывные сообщения отражаются какой-либо физической величиной, изменяющейся в заданном интервале времени. Получение конечного множества сообщений за конечный промежуток времени в данном случае достигается путем дискретизации (во времени) и квантования (по уровню).

I.2.1.Структурные меры информации

При использовании структурных мер учитывается только дискретное строение данного информационного комплекса. Значит, интересуются в особенности количеством содержащихся в нем информационных элементов, связями между ними или комбинациями из них.

Под информационными элементами понимаются неделимые части (кванты) информации в дискретных моделях реальных информационных комплексов.

В структурной теории различаются: геометрическая, комбинаторная и аддитивная меры информации.

Геометрическая мера. Определение количества информации геометрическим методом сводится к измерению элементов формы (длины линии, площади или объема геометрической модели) данного информационного комплекса в количестве дискретных единиц.

Геометрической мерой определяется потенциальное, то есть максимально возможное количество информации в заданных структурных габаритах. Это количество принято называть информационной емкостью исследуемой части информационной системы.

Предположим,

например, что информация отражается

полным комплексом XTN.

Если дискретные отсчеты осуществляются

по осям X,

T

и N

соответственно через интервалы ΔX,

ΔT

и ΔN,

то непрерывные координаты раскладываются

на элементы (кванты), количество которых

составляет:

![]() ;

;

![]() ;

;

![]() .

.

Тогда количество

информации в полном комплексе

![]() ,

определяемое геометрическим методом,

равно:M

= mX

·mT

·mN.

,

определяемое геометрическим методом,

равно:M

= mX

·mT

·mN.

В общем случае дискретизация по осям пространства может быть неравномерной, а сами процессы могут изменяться во времени (нестационарны). Тогда количество информации следует определять по более сложным формулам, следующим из вариативного характера дискретизации.

Комбинаторная мера. К комбинаторной мере целесообразно прибегать тогда, когда требуется оценка возможности передачи информации при помощи различных информационных элементов. Вообще образование комбинаций есть одна из форм кодирования информации.

Количество комбинаций в комбинаторной мере вычисляется как количество комбинаций элементов. Таким образом оценке подвергается свойство потенциального структурного многообразия информационных комплексов. Сочетания из n элементов по m различаются неодинаковым составом элементов. Их возможное число (при n ≥ m) равно:

![]() .

.

Сочетания с повторениями также различаются составом элементов, но элементы могут в них повторяться до “m” раз. Их число равно:

![]() .

.

Перестановки

h

элементов различаются только их порядком.

Число возможных вариантов равно:

![]()

Перестановка с повторениями элементов, причем один из элементов повторяется α раз, другой β раз, и , наконец, последний γ раз, характеризуется возможным числом вариантов:

![]() ,

,

где: α+β+…+γ=h.

Размещения из h элементов по m различаются и по составу элементов и по их порядку. Возможное число размещений:

![]() .

.

Возможное число

размещений с повторениями до m

раз из h

элементов есть:

![]() .

.

При использовании комбинаторной меры количество информации Q совпадает с числом возможных соединений (связей) между элементами. То есть при этом оценивается, в отличие от геометрической меры, не только число квантов, а их структурное многообразие.

Количество информации при том же числе элементов теперь многократно увеличивается.

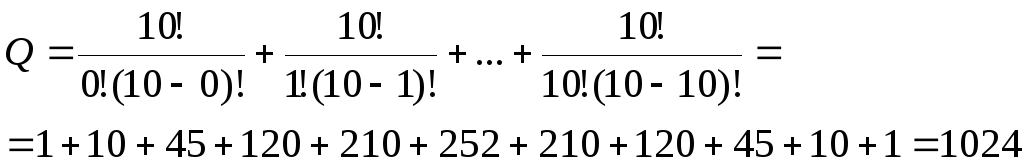

Так, например, в случае простых сочетаний из 10 элементов по 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10 элементов получается следующее количество вариантов, являющееся «идеальной» мерой количества информации:

Перестановки тех же 10 элементов дают: P(10)=10!=3626800.

Размещение 10 элементов по 10 различным позициям дают: Q=1010 образований. Конечно, не всегда все возможные комбинации составляют действительные степени свободы рассматриваемой системы.

Аддитивная мера (мера Хартли). В теории информации важную роль играют комбинаторные схемы для чисел и кодов. Для иллюстрации введем понятие глубины h и длины l числа.

Глубиной h числа называется количество различных элементов (знаков), содержащееся в принятом алфавите. Глубина числа соответствует основанию системы счисления или кодирования. Один полный алфавит занимает одно числовое гнездо, глубина которого равна h. Используем в качестве геометрической модели схему, представленную на рис. 1.7.

Рис. 1.7.

На схеме массива десятизначных дискретных чисел (n=l=h=10) в каждый данный момент реализуется только один какой-либо знак из h возможных. На геометрической модели реализация знака принимает форму выставления в первый ряд нужного знака из глубины гнезда, в котором в определенном порядке хранятся все нужные знаки.

На схеме массива десятизначных дискретных чисел (n=l=h=10) в каждый данный момент реализуется только один какой-либо знак из h возможных. На геометрической модели реализация знака принимает форму выставления в первый ряд нужного знака из глубины гнезда, в котором в определенном порядке хранятся все нужные знаки.

Длиной l называется количество числовых гнезд необходимых и достаточных для представления чисел нужной величины. Один набор из числовых гнезд образует одну числовую гряду, способную представить и хранить одно полное число длиной l. Некоторое количество чисел n представляется числовым полем.

При глубине h

и длине l

количество чисел, которое можно

представить с помощью числовой гряды,

выразится формулой:

![]() ,

то есть емкость гряды экспоненциально

зависит от длины числаl.

Вследствие показательного закона

зависимости Q

от l,

число Q

не является удобной мерой для оценки

информационной емкости. Поэтому Хартли

предложил ввести аддитивную, двоичную

логарифмическую меру, позволяющую

вычислить количество информации в

двоичных единицах «битах». То есть

I=log2Q=llog2h

(бит). I

– количество информации но Хартли. Если

количество разрядов (длина l

числа) равно 1 (h=2),

то 1log22=1бит.

Это и есть единица информации в принятой

системе. Она соответствует одному

элементарному событию, которое может

произойти или не произойти. Помимо битов

применяются единицы: ниты

(натуральный логарифм) и диты

(десятичный логарифм).

,

то есть емкость гряды экспоненциально

зависит от длины числаl.

Вследствие показательного закона

зависимости Q

от l,

число Q

не является удобной мерой для оценки

информационной емкости. Поэтому Хартли

предложил ввести аддитивную, двоичную

логарифмическую меру, позволяющую

вычислить количество информации в

двоичных единицах «битах». То есть

I=log2Q=llog2h

(бит). I

– количество информации но Хартли. Если

количество разрядов (длина l

числа) равно 1 (h=2),

то 1log22=1бит.

Это и есть единица информации в принятой

системе. Она соответствует одному

элементарному событию, которое может

произойти или не произойти. Помимо битов

применяются единицы: ниты

(натуральный логарифм) и диты

(десятичный логарифм).

Аддитивная мера удобна тем, что она обеспечивает возможность сложения информации, поступающей от многих источников, и пропорциональность количества информации длине числа l, то есть количеству числовых гнезд. Введенное количество информации эквивалентно количеству двоичных знаков 0 и 1 при кодировании сообщения по двоичной системе счисления. При наличии нескольких источников информации общее количество информации суммируется: I(Q1, Q2…Qn) = I(Q1) + I(Q2)+…+I(Qn).