Методические указания

.pdf

X |

|

|

|

X k |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

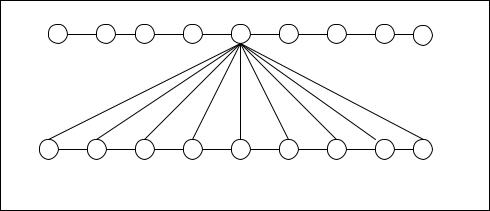

Рис.2.3. |

Взаимо- |

|

X1 |

X2 |

X3 |

|

|

|

|

X i |

|

X m |

||

|

|

|

|

|

связь источников X |

||||||

|

|

|

|

|

|

|

|

|

|

и Y. |

|

Y |

|

|

|

|

|

|

|

|

|

По мере |

возрас- |

|

|

|

|

|

|

|

|

|

тания взаимосвя- |

||

|

|

|

|

|

|

|

|

|

|

зи между |

источ- |

Y1 |

Y2 |

Y3 |

|

|

|

|

Y j |

|

Y n |

никами X и Y |

|

|

|

|

|

|

|

|

|

|

|

увеличивается |

|

разность между значениями условных вероятностей, пределом которого являет- |

|||||||||||

ся такое состояние, когда значению xi будет соответствовать лишь одно значе- |

|||||||||||

ние, например, |

y j , т.е. p(y j / xi ) =1, а все остальные будут равны нулю. |

||||||||||

Совокупность условных вероятностей для конкретного значения xi представля- |

|||||||||||

ет собою частную условную энтропию: |

|

|

|

|

|||||||

|

|

|

H(Y / xi ) =− |

m |

p(y j / xi )log p(y j / xi ) , |

|

|

||||

|

|

|

∑ |

|

|

||||||

|

|

|

|

i=1 |

|

|

|

|

|

||

которая характеризует информационные свойства источника Y после того, как |

|||||||||||

стало известно значение |

xi . |

|

|

|

|

|

|

|

|||

Усредняя частные условные энтропии по всем значениям xi |

можно выразить |

||||||||||

общую условную энтропию источника Y относительно источника X: |

|

||||||||||

|

H(Y / X ) = |

n |

|

|

|

|

|

|

|

||

|

∑ p(xi ) H(Y / xi ) = |

|

|

|

|

||||||

|

|

|

m |

i=1 |

|

|

|

|

|

|

|

|

|

n |

|

|

/ x )logp(y |

|

/ x ) |

|

|

||

|

=− ∑ |

∑ p(x ) p(y |

j |

j |

|

|

|||||

|

|

i=1 j=1 |

i |

|

i |

i |

|

|

|||

|

|

|

|

|

|

|

|

|

|

||

и, так как для статистически зависимых сигналов

p(xi , y j ) = p(xi ) p(y j / xi ), |

|

(2.10) |

||||

то |

m |

|

|

|

|

|

n |

p(x , y |

|

)logp(y |

|

/ x ) (2.11) |

|

H(Y / X ) =− ∑ |

∑ |

j |

j |

|||

|

|

i |

|

i |

||

i=1 j=1

Величина H(Y / X ) показывает, какой энтропией обладает источник Y, если известна энтропия источника X.

32

Зависимость величины условной энтропии от степени взаимосвязи между источниками X и Y.

а). Если статистическая связь между сигналами (символами) источников X и Y отсутствует, то

p(xi , y j ) = p(xi ) p(y j ) |

(2.12) |

Сопоставляя равенства (2.10) и (2.12) получим |

|

p(y j ) = p(y j / xi ) |

(2.13) |

Подставляя равенства (2.12) и (2.13) в выражение (2.11) для условной энтропии, найдем

|

n |

m |

p(x ) p(y |

|

|

)logp(y |

|

) = |

||

H(Y / X ) =− ∑ |

∑ |

j |

j |

|||||||

|

i=1 j=1 |

|

i |

|

|

|

||||

|

|

|

|

|

|

|

|

|

||

n |

m |

|

|

)log p(y |

|

|

)=H(Y) , |

|||

=− ∑ |

p(x ) ∑ p(y |

|

|

|

||||||

i=1 |

i j=1 |

|

j |

|

|

j |

|

|

|

|

|

n |

|

|

|

|

|

|

|

|

|

так как |

∑ p(xi )=1. |

|

|

|

|

|

|

|

|

|

|

i=1 |

|

|

|

|

|

|

|

|

|

Таким образом, в рассматриваемом случае |

|

|

|

|

|

|

||||

|

H(Y / X ) = H(Y) , |

|

|

|

|

(2.14) |

||||

то есть при отсутствии статистической связи между источниками X и Y условная энтропия источника Y относительно источника X равна безусловной энтропии источника Y. Это означает, что вся информация сигналов y j Y яв-

ляется новой по отношению к сигналам xi X .

б). При наличии “жесткой” статистической связи между источниками X и Y возможны только два случая: p(y j / xi ) =0 или p(y j / xi ) =1. И так как при

суммировании по j все слагаемые

p(y j / xi )log p(y j / xi )

в выражении для H(Y / X ) превращаются в нуль, то и H(Y / X ) =0, то есть при наличии “жесткой” статистической связи между источниками X и Y условная энтропия источника Y относительно источника X равна нулю. Это означает, что сигналы y j Y никакой новой информации не содержат относи-

тельно сигналов xi X .

33

Из рассмотрения сущности условной энтропии можно сделать вывод о том, что она может быть использована для статистической оценки воздействия помех при передаче сообщений.

Взаимосвязь между количеством информации и энтропией передаваемого сообщения при наличии помех.

Пусть до приема информации известны только вероятности p(x j ) символов

(уровней сигналов и т.п.) передаваемого сообщения.

Неопределенность сообщения до его приема можно характеризовать энтропией:

H(X ) =− n p(x )log p(x ) ,

∑ j j j=1

При отсутствии помех будет иметь место полное соответствие между принятым и переданным сообщением, вследствие чего неопределенность H(X ) после приема сообщения будет полностью снята, т.е. величина H (X ) станет равной нулю. При этом будет получено количество информации I(Y, X ) равное энтропии H (X ).

Из сказанного следует, что количество информации, полученное в процессе передачи сообщения, будет равно разности энтропий до и после приема сообще-

ния, т.е.

I(Y, X ) = H(X ) −0.

При наличии же помех степень неопределенности на приемном конце, т.е. эн-

тропия, не будет уменьшена до нуля, так как в этом случае

I(Y, X ) ≠ H(X ).

Наличие помех, характеризуемое величиной H(X /Y) приведет к ограничению

количества информации, необходимого для полного снятия неопределенности

при приеме сообщения, т.е.:

I(Y, X ) = H(X ) −H(X /Y).

Из изложенного следует, что энтропия представляет собою меру неопределенности, а количество информации — меру снятия неопределенности при приеме сообщения.

Совместная энтропия статистически зависимых источников сообщений.

Пусть имеются два коррелированных источника X и Y , каждому из которых, соответственно, принадлежат множества сигналов

xi X |

|

n |

при |

∑ p(xi )=1 |

|

|

|

i=1 |

и

34

y j Y |

при |

m |

p(y j )=1. |

∑ |

|||

|

|

j=1 |

|

Если число возможных парных совмещений сигналов составит n m, то энтропия совокупности возможных совмещений сигналов может быть представлена в виде:

|

|

H(X ,Y) =− |

n |

m |

|

p(x , y |

|

)log p(x , y |

|

) |

(2.15) |

||||||

|

|

∑ |

∑ |

|

j |

j |

|||||||||||

|

|

|

|

|

i=1 j=1 |

i |

|

|

i |

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

Так как для рассматриваемого случая: |

|

|

|

|

|

|

|

|

|||||||||

|

|

|

p(xi , y j ) = p(xi ) p(y j / xi ), |

|

|

|

|

|

|||||||||

то |

|

n |

m |

|

|

|

|

|

/ x )log[p(x ) p(y |

|

/ x )]= |

|

|||||

|

|

p(x ) p(y |

|

|

|

||||||||||||

H(X ,Y) =− ∑ |

∑ |

j |

j |

|

|||||||||||||

|

|

i=1 j=1 |

|

i |

|

|

i |

|

i |

|

|

|

i |

|

|||

|

|

|

/ x )[log p(x )+log p(y |

|

/ x )]= |

|

|||||||||||

n |

m |

p(x ) p(y |

|

|

|

||||||||||||

=− ∑ |

∑ |

j |

j |

|

|||||||||||||

i=1 j=1 |

i |

|

i |

|

|

|

i |

|

|

|

i |

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

n |

|

|

|

|

m |

p(y |

|

/ x ) − |

|

|

|

|

|

|

|

|

|

=− ∑ |

p(x )log p(x ) ∑ |

|

|

|

|

|

|

|

|

|

|||||||

i=1 |

|

i |

|

i |

j=1 |

|

|

j |

i |

|

|

|

|

|

|

|

|

n |

|

m |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

− ∑ p(xi ) ∑ p(y j / xi )log p(y j / xi ) = H(X ) +H(Y / X ). |

|

||||||||||||||||

i=1 |

|

j=1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Таким образом: |

H(X ,Y) = H(X ) +H(Y / X ), |

|

|

|

(2.16) |

||||||||||||

|

|

|

|

|

|

||||||||||||

то есть совместная энтропия сигналов двух различных статистически зависимых источников X и Y равна сумме безусловной энтропии H (X ) и условной энтропии H(Y / X ) .

На основании полученного равенства (2.16) можно еще раз пояснить смысл условной энтропии как величины, представляющей собой ту добавочную энтропию, которую дают сигналы y j Y при условии, что энтропия сигналов

xi X уже известна.

Особенности совместной энтропии двух статистически зависимых источников. а). Совместная энтропия двух статистически зависимых источников сообщений обладает свойством “зеркального” или взаимного отображения, состоящего в

выполнении равенства:

H(X ,Y) = H(Y, X ),

35

справедливость которого можно подтвердить, если в равенстве (2.12) поменять местами xi и y j приняв

p(y j , xi ) = p(y j ) p(xi / y j ).

Тогда получим: |

|

H(Y, X ) = H(Y) +H(X /Y) |

(2.17) |

Из равенств (2.16) и (2.17) следует:

H(X ,Y) = H(Y, X ) = H(X ) +H(Y / X ) = H(Y) +H(X /Y)

(2.18)

б). Если источники X и Y статистически независимы, то совместная энтропия

этих источников равна сумме энтропий источников X и Y.

Ранее было показано, что условная энтропия в этом случае равна:

H(Y / X ) = H(Y) ,

вследствие чего

H(X ,Y) = H(X ) +H(Y).

в). При наличии “жесткой” статистической связи между источниками X и Y совместная энтропия равна безусловной энтропии одного из двух источников сообщений.

Как было показано для рассматриваемого случая

H(Y / X ) =0,

вследствие чего:

H(X ,Y) = H(X ).

На основании свойства взаимного отображения источников сообщений можно

записать:

H(X ,Y) = H(X ) = H(Y, X ) = H(Y) .

Таким образом, рассмотренные выше основные свойства энтропии позволяют получить представление о возможности ее использования для математического описания различных случайных вероятностных моделей.

Дифференциальная энтропия одномерного распределения вероятностей есть мера относительной неопределенности (т.е. энтропии) распределения вероятностей непрерывной случайной величины. Ее выражение имеет вид:

∞

h(X ) =−log f (X ) =− ∫ f (x)log f (x)dx , (2.19)

−∞

36

где f (x) — плотность распределения вероятностей случайной величины.

Энтропия законов распределения.

В [1] представлены сведения о наиболее распространенных законах распределения вероятности случайных величин. При этом выделены энтропия непрерывных законов распределения (А) и энтропия дискретных законов распределения

(Б).

37

3. Представление информации.

Исходные положения

Представление информации – это отображение входных или выходных сообщений любого из блоков или устройств ИВС в форме наиболее удобной для дальнейшего использования в отношении точности, быстродействия и достоверности.

Общность вопросов представления информации по отношению к любым блокам ИВС и связанным с ними информационными процессами, определяет местоположение данного раздела.

3.1. Физические характеристики сигналов и каналов.

Идеализированная модель сигнала (рис.3.1) может быть представлена соотношением следующих параметров:

m |

= Smax −Smin =100 ; |

||

s |

S |

δs |

|

|

|

||

n =Tmax −Tmin =100 , |

|||

t |

t |

|

δt |

|

|

||

где m — уровни сигнала, отсчеты (символы сообщения); n — элементы сигнала (сообщения).

Допущения, принимаемые для идеализированной модели:

1). {S, t}=const ;

2). Помехи отсутствуют, т.е. мгновенное значение помехи h =0 , а следовательно, и средняя мощность Ph =0.

3). Инструментальные ошибки отсутствуют.

4). Максимальная (допустимая) скорость изменения сигнала определяется со-

отношением S max = St .

40

5). Непрерывный квантованный сигнал S(t) рассматривается как кодированный унитарным кодом с основанием q , равным разрешающей способности сиг-

нала ms , т.е. {S ≈Sкв}→ f (Nq=ms ).

6). Кусочно-ступенчатая аппроксимация порождает методическую погрешность

δs иδt .

7). Уровни сигнала равновероятны:

p(S j ) = 1 , j =0,1, 2, ..., ms . ms

Обобщенные характеристики сигнала (канала). Разнородные физические характеристики сигнала, такие как: S =Smax −Smin;ms; S;δs;nt ; t;δt ;Ps;Ph и др. с целью более компактного их выражения могут быть представлены в виде трех обобщающих характеристик: динамической составляющей сигнала Ds ,

времени действия сигнала Ts и спектра сигнала Fs . Например:

D |

=log |

S |

=log100; D' =log |

Ps |

; |

|||||||

|

|

|||||||||||

|

s |

|

|

|

S |

δs |

s |

|

Ph |

|||

|

|

|

|

|

|

|

||||||

T |

s |

=n |

t = nt S |

= |

|

nt δs S |

; |

|

|

|||

|

|

|

|

|||||||||

|

|

t |

|

|

|

|

|

|

|

|

||

|

|

|

|

|

|

S max |

100 S max |

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

F |

= |

1 |

=100 S max . |

|

|

|

|

|||||

|

|

|

|

|

||||||||

|

s |

|

t |

|

|

δs S |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

Произведение вышеуказанных параметров может быть использовано для выражения объема сигнала Vs = Ds Ts Fs . Аналогичным образом может быть

представлена емкость канала Vk = Dk Tk Fk , где Fk — полоса пропускания канала.

Условия согласования сигнала и канала могут быть сформулированы в виде:

41

|

D |

≤ D |

||

V ≤V |

|

s |

≤T |

k |

при T |

|

. |

||

{ k s} |

|

s |

k |

|

|

F ≤ F |

|

||

|

|

s |

k |

|

Этим условиям соответствует графическая интерпретация на рис.3.3

Оценка эффективности согласования сигнала и канала может быть выполнена посредством соотношений:

( |

) |

V |

|

( |

) |

( |

) |

V |

η V |

|

=Vs |

; |

ϕ V |

|

=1−η V |

|

=1−Vs , |

|

|

k |

|

|

|

|

|

k |

где η (V );ϕ (V ) — коэффициенты, соответственно, эффективности и избыточности использования сигнала и канала.

Видеальном случае: η (V )=1;ϕ (V )=0.

Вобщем случае:

1≥η V |

) |

≥0 |

|

|

||

( |

|

|

|

(3.1) |

||

( |

|

) |

≤1 |

|

||

|

|

|

||||

0 ≤ϕ V |

|

|

|

|

||

В реальных условиях параметры квантования по уровню и по времени могут быть переменными. При этом, в соответствии с рис.3.2, в результате квантования непрерывных сигналов, возникают ошибки квантования δ Sкв, называемые

иногда “шумами квантования”.

3.2. Физические и математические параметры аналоговой и цифровой форм представления

информации.

Из изложенного ранее следует, что в ИВС (ИВК, ГИВУ) может использоваться как аналоговая, так и цифровая форма представления информации. Каждая из этих форм характеризуется математическими и физическими параметрами. Как следует из рис.3.4 математическими параметрами цифровой формы представления информации, в зависимости от выбранной системы счисления, могут быть двоичный код (N2 ), двоично-десятичный (N2-10 ), восьмеричный (N8) и др.,

т.е.

Np (N2,N2−10,N8,K),

где p =2; 2 −10; 8;K — основание выбранной системы счисления.

42

Математическим параметром аналоговой формы представления информации является унитарный код (N1). Это следует из рассмотрения аналогового сигна-

ла как квантованного с разрешающей способностью

m |

= Smax −Smin = |

S |

=100, |

|

s |

S |

S |

δs |

|

|

S — шаг |

|||

где: S =Smax −Smin — диапазон изменения аналогового сигнала; |

||||

квантования сигнала; δs — погрешность, соответствующая величине |

S . |

|||

Из изложенного в [1] следует, что аналоговый сигнал в этом случае является кодированным с относительно высоким основанием, равным его разрешающей способности, которая соответствует основанию унитарного кода. В этом случае

S p N p=ms .

В соответствии с изложенным, более строго будет говорить не о кодировании аналоговых сигналов, а об их перекодировании.

Что касается физических параметров, то любой из них, то есть одни и те же, могут быть использованы как в аналоговой, так и в цифровой форме представления информации.

Различие их использования состоит в том, что при аналоговой форме представления информации параметры аналоговой величины изменяются пропорционально изменению математической величины, в соответствии с масштабным соотношением

ma = xmax −xmin . Smax −Smin

При цифровой форме представления информации имеет место ступенчатое (“да” — “нет”) изменение параметров физических величин, соответствующих признакам кодовых разрядов. Взаимосвязь между математической величиной x и пропорциональным значением кода N в этом случае определяется масштабным соотношением

m |

ц |

= |

xmax |

−xmin |

. |

Nmax |

|

||||

|

|

−Nmin |

|||

Масштабные выражения для ma и |

mц определяют, соответственно, аналого- |

||||

вый и цифровой принципы моделирования.

При аналоговом принципе моделирования непрерывному изменению моделируемой математической величины x соответствует пропорциональное изменение параметра моделирующей физической величины S .

43