Методические указания

.pdfM = |

1 |

= |

|

1 |

. |

|

m |

|

|||

|

P( X ) |

|

|

||

|

∏ p(x )n p(xi ) |

|

|||

|

|

|

i =1 |

i |

|

|

|

|

|

|

|

Тогда количество информации, содержащееся в одном сообщении, будет:

m |

m |

I1(X ) =logM =−log∏ p(xi )np(xi ) =−∑log p(xi )n p(xi ) = |

|

i=1 |

i=1 |

m

=−n∑ p(xi )log p(xi ) [дв.ед.].

i=1

Количество информации, приходящееся на один элемент сообщения, называют удельной информативностью или энтропией:

H ( X ) = |

I1( X ) = − ∑ |

p(x ) log p(x ). |

(2.1) |

||

|

|

m |

|

|

|

1 |

|

|

i |

i |

|

n |

i =1 |

|

|||

|

|

|

|

||

Энтропия характеризует степень или меру неопределенности источника сообщений с заданным алфавитом. Чем больше энтропия, тем больше информации несет в себе сообщение источника, тем большая неопределенность снимается при получении сообщения.

Выражение (2.1) представляет собой классическую формулу Шеннона для определения энтропии сообщения с неравновероятным и независимым распределением символов. Эта формула получена в развитие формулы Хартли, предложенной для определения количества информации в сообщении с равновероятным и независимым распределением символов.

Приведенная формула К. Шеннона переходит в формулу Хартли при равных вероятностях символов, образующих сообщение, то есть при

|

1 |

|

|

m |

1 |

|

1 |

|

1 |

|

p(xi ) = |

|

: |

I0 |

(X ) =−n ∑ |

|

log |

|

=−n log |

|

=n log m [бит]. |

|

|

|

|

|||||||

m |

|

m |

m |

|||||||

|

|

|

i=1 m |

|

|

|

||||

Соотношение энтропии и количества информации.

Если энтропия является мерой неопределенности случайного состояния некоторой системы, то количество информации характеризует меру уменьшения или снятия неопределенности состояния этой системы. ЭнтропияH(X ), выра-

жающая среднюю неопределенность состояния системы, является априорной характеристикой и может быть вычислена до эксперимента, если известна статистика состояний. Количество же информации I(X ) определяется апостери-

орно, т.е. в результате эксперимента. Численное совпадение H(X ) и I(X )

22

возможно лишь в том случае, если эксперимент полностью снимает априорную неопределенность.

Энтропию H(X ) можно рассматривать и как некоторую простейшую число-

вую характеристику случайной величины x и ее законов распределения. Выражение (2.1) раскрывает смысл энтропии как статистического параметра случайной величины, о чем уже было сказано. Если пренебречь математическими строгостями, то выражение (2.1) может быть получено, исходя из того, что энтропия представляет собой среднее количество информации, приходящееся на один отсчет.

Как было ранее показано, в случае равновероятного и независимого распределения символов x (или уровней сигналов S ) энтропия имеет следующее выражение:

H0 (X ) =logm =−log p(S) [отсчетдв.ед. ], где S x .

При неравновероятном и независимом распределении символов, в соответствии

с определением энтропии, необходимо определить среднее значение величи-

ны−log p(S) .

Если в общем случае математическое ожидание определяется как

m'

MO = ∑ p(a j ) a j ,

j =0

то в рассматриваемом случае:

m

H(S) =− ∑ p(S j ) log p(S j ) ,

j =0

где p(S j )соответствует величине p(аj ), а −log p(S j ) — величине аj .

Выражение (2.1) может быть получено также в результате следующих упрощенных рассуждений:

|

1 |

m |

|

|

H0(S) =log |

=−log p(S j ) 1= −log p(S j ) ∑ |

p(S j ) = |

||

p(S j ) |

||||

|

j =1 |

|

m

= − ∑ p(S j ) log p(S j ),

j =1

23

m

где ∑ p(S j )=1, причем множитель −log p(S j ) внесен под знак суммы на j =1

основании того, что все p(S j ) одинаковы. Приведенное при этом выражение

совпадает с выражением (2.1), полученным в результате более строгого доказа-

тельства, вследствие чего может быть использовано для определения величины

H1(S) .

2.5. Определение количества информации в сообщении, состоящем из неравновероятных и зависимых символов. (Случай 3).

В реальных условиях символы (отсчеты), образующие сообщения, взаимосвязаны, что необходимо учесть в выражении для энтропии. Величина энтропии H2 (S) с учетом взаимосвязи между двумя символами может быть выражена

по аналогии с выражением (2.1.) и представлена в виде:

H |

2 |

(S) =−1 |

∑∑ p(S j ,S p ) log p(S j ,S p ) [дв.ед. |

] |

(2.2) |

|

|

2 j p |

отсчет |

|

|

||

при |

|

|

|

|||

∑∑ p(S j ,Sp ) =1. |

|

|

|

|||

|

|

|

|

|

||

|

|

j |

p |

|

|

|

В случае учета взаимосвязи между любимы тремя символами энтропия будет иметь вид:

H (S) =−1 |

∑∑ ∑ p(S |

j |

,S |

p |

,S |

) log p(S |

j |

,S |

p |

,S |

) |

(2.3) |

|

3 |

3 j p q |

|

|

q |

|

|

q |

|

|||||

при |

|

|

|

|

|

|

|

|

|

|

|

||

∑∑ ∑ p(S j ,Sp ,Sq )=1. |

|

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

|||||||

|

j |

p q |

|

|

|

|

|

|

|

|

|

|

|

В общем случае, при учете взаимосвязи между r – символами, получим:

H (S) =−1 |

∑∑K∑ p(S |

j |

,S |

p |

,K,S )log p(S |

j |

,S |

p |

,K,S ) |

(2.4) |

|

r |

r |

j p l |

|

l |

|

l |

|

||||

|

|

|

|

|

|

|

|

|

|

||

при

24

∑∑K∑ p(S j ,Sp ,K,Sl)=1.

j p l

По мере учета взаимосвязи между символами степень неопределенности уменьшается, в связи с чем имеет место соотношение:

H0(S) > H1(S) > H2 (S) >KHr (S). |

(2.5) |

2.6. Относительная энтропия и избыточность сообщений (сигна-

лов).

Приведенное соотношение (2.5) является следствием того, что при нарушении равновероятностного закона распределения символов, образующих сообщения, либо при учете статистической взаимосвязи между символами неопределенность сообщений (сигналов) падает, а следовательно, уменьшается и энтропия. Идеальные сообщения, имеющие максимальную энтропию, являются оптимальными в том смысле, что в них на один символ (элемент, уровень сигнала) приходится наибольшее количество информации.

В реальных сообщениях символы всегда коррелированы между собой, вследствие чего количество информации, приходящееся на один символ (энтропия), будет меньше, чем для идеальных сообщений. Соотношение реальных и оптимальных сообщений может быть выражено посредством коэффициента сжатия

(относительной энтропии) μ(S)или коэффициента избыточности

ϕ(S): |

Hr (S) |

n0 |

|

|

||

μ(S)= H |

0 |

(S) |

= n |

, |

(2.6) |

|

|

|

|

r |

|

|

|

где n0 — число символов оптимального сообщения, а nr |

— реального. Равен- |

|||||

ство (2.6) показывает, какую часть энтропия реальных сообщений составляет от энтропии оптимальных сообщений, а также какую часть длина оптимальных сообщений составляет от длины реальных сообщений.

Равенство (2.6) указывает на то, что одно и то же количество информации I(S)может содержаться в сообщении, состоящем из nr символов с энтропией

Hr (S) или из n0 символов с энтропией H0 (S)т.е.

I(S) =nr Hr (S) =n0 H0 (S)

и так как |

|

Hr (S) < H0 (S) , |

то nr > n0 . |

Коэффициент избыточности может быть представлен в виде:

25

ϕ(S)=1− |

Hr |

(S) |

= |

H |

0 (S)−Hr (S) |

, |

|

|||

H0 |

|

|

|

|

H0(S) |

|

||||

|

(S) |

|

|

(2.7) |

||||||

ϕ(S)=1− |

n0 |

|

|

nr −n0 |

|

|

|

|||

= |

|

|

|

|

||||||

|

|

|

|

|

||||||

|

nr |

|

|

nr |

|

|

|

|

||

|

|

|

|

|

|

|

||||

Коэффициент избыточности показывает, какая часть реального сообщения, передаваемого или оптимального, могла бы не передаваться, если учесть вероятностные характеристики сообщения на приемном конце. Одновременно с этим этот коэффициент показывает, какая часть символов реального сообщения является излишней.

Из выражения (2.7) следует:

а) уменьшить избыточность можно за счет увеличения энтропии сообщений, что связано с приближением к равновероятностному закону распределения символов; б) увеличение избыточности приводит к увеличению времени передачи инфор-

мации, так как nr > n0 ;

в) наличие избыточных символов при одном и том же количестве информации, содержащемся в сообщении, повышает верность передачи сообщений.

Таким образом, основными параметрами теории информации являются: 1. Энтропия для случаев:

H 0(S) =−log p(S) =logm [элементбит |

], |

∑ p(S)=1. |

|

|

|

|||||||||||

H1(S) =− |

m |

|

|

|

|

∑p(Si )=1. |

|

|

|

|

|

|||||

∑ p(Si )log p(Si ) , |

|

|

|

|

|

|||||||||||

i=1 |

|

|

|

|

i |

|

|

|

|

|

|

|

|

|

|

|

H (S) = − |

1 ∑∑ p(S |

j |

,S |

p |

) log p(S |

j |

,S |

p |

) , ∑∑ p(S |

j |

,S |

p |

) =1. |

- - |

||

2 |

2 j p |

|

|

|

|

|

j p |

|

|

|

||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

H (S) =−1 |

∑∑K∑ p(S |

j |

,S |

p |

,K,S )log p(S |

j |

,S |

p |

,K,S |

) , |

|

r |

r |

j p l |

|

l |

|

l |

|

||||

|

|

|

|

|

|

|

|

|

|

||

∑∑K∑ p(S j ,Sp ,K,Sl)=1.

j p l

H0(S) > H1(S) > H2 (S) >KHr (S).

26

2. Относительная энтропия и избыточность:

μ(S)= Hr (S) ; ϕ(S)=1−μ(S).

H0 (S)

3. Пропускная способность и скорость передачи информации:

C(S) = |

I(S)max |

|

[бит |

]; |

|||||

Tmin |

|||||||||

|

с |

||||||||

|

|

|

|

|

|||||

R(S) = |

I(S) |

[бит |

]; |

R(S) ≤C(S) . |

|||||

|

|||||||||

|

|

|

с |

||||||

|

|

T |

|

|

|

||||

2.7. Энтропия и ее основные свойства.

Энтропия — мера неопределенности случайной величины с конечным числом исходов, определяемая как среднее количество информацииI(S), приходящееся на один символ сообщения (элемент сигналаS ).

При равновероятном и независимом распределении символов (элементов сигнала) выражается как

H0 (S) = I(nS) [символдв.ед. ],

а при неравновероятном и независимом распределении символов

|

m |

[дв.ед. |

], |

||

H |

(S) =− ∑ p(Si )log p(Si ) |

||||

|

|

||||

1 |

|

|

символ |

|

|

i=1

где m — число символов сообщения (элементов сигнала); p(Si ) — вероятность исхода величины Si .

Энтропия, как численная величина, — величина вещественная, ограниченная и неотрицательная. Для подтверждения этого воспользуемся выражением (2.1):

H(X ) =− m p(x )log p(x ),

∑ i i i=1

которое характеризует математическое ожидание частных состояний системы. а) Энтропия — величина вещественная, поскольку принимает значение, равное нулю только в случае детерминированного состояния системы.

27

Пусть вероятность одного из состояний системы p(x) =1, тогда вероятности всех других состояний p(x j ) =0.

В этом случае, согласно (2.1.):

H(X ) = p(xi )log p(xi ) − ∑ p(x j )log p(x j )

j=1 j≠i

Первое слагаемое в правой части равно нулю, так как 1 log1=0. Второе слагаемое правой части при p(x j ) →0 также обращается в нуль. Действительно

|

[ |

|

|

|

|

|

] |

|

|

log p |

−1(x j ) |

|||||||

|

|

j |

|

j |

|

|

|

|

|

|

|

|

|

|

||||

lim |

−p(x |

|

)log p(x |

|

) |

= |

|

lim |

|

|

|

p−1(x j ) |

. |

|||||

p(x j )→0 |

|

|

|

|

|

|

|

p(x j )→0 |

|

|||||||||

Введя подстановку p−1(x |

|

|

|

|

|

|

|

|

|

|

||||||||

j |

) =α и раскрывая неопределенность по правилу |

|||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Лопиталя, получим: |

|

|

|

|

|

|

|

log e |

|

|

||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

|

|

|

1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

α |

|

|

|

||||

|

|

|

|

lim logα |

= lim |

|

|

|

=0. |

|

||||||||

|

|

|

|

|

|

|

1 |

|

|

|

||||||||

|

|

|

|

α→0[ |

|

|

|

]α |

α→0 |

|

|

|

|

|

|

|||

Так как при |

p(x j ) =0 каждое из слагаемых равно нулю, то, следовательно, и |

|||||||||||||||||

сумма всех слагаемых также равна нулю.

б) Энтропия — величина ограниченная , поскольку имеет предельное значение максимума каждое из слагаемых − p(xi )log p(xi ).

Действительно, беря производную от этого выражения и приравнивая ее к нулю, получаем:

|

d |

|

|

−p(x ) log p(x ) =loge −log p(x ) =−log p(x ) e =0,откуда |

|||||

dp(x ) |

|||||||||

[ |

i |

i ] |

i |

i |

|||||

|

|

i |

|

|

|

|

|

|

|

p(xi ) e =1 и p(xi ) =1e =0,37 , вследствие чего значение p(xi ), при котором слагаемые имеют максимум, будет

p(xi )log p−1(xi ) =1e loge =0,531.

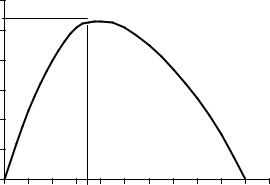

График изменения слагаемых приведен на рис.2.1.

28

0,531 |

0.6 |

|

0.5 |

||

|

||

-p(x)logp(x) |

0.4 |

|

0.3 |

||

0.2 |

||

|

||

|

0.1 |

|

|

0 |

|

|

1/e |

|

|

p(x) |

|

Рис.2.1. График изменения слагаемых энтропии |

||

в) Энтропия — величина неотрицательная, поскольку логарифмы чисел выра-

жения (2.1) отрицательны.

Энтропия как статистический параметр.

Пусть число символов в сообщении m =2 |

( x0 |

и x1). Используя выражение |

|||||

(2.1), можно записать: |

|

|

|

|

|

|

|

1 |

|

|

|

|

|

|

|

H1(X ) =− ∑ p(xi )log p(xi ) =−p(x0 )log p(x0 ) − p(x1)log p(x1).Так как |

|||||||

i=0 |

|

|

|

|

|

|

|

p(x0 ) + p(x1) =1 и p(x1) =1− p(x0 ), |

|

|

|||||

то |

0 |

0 |

[ |

0 ] |

[ |

0 ] |

|

1 |

|||||||

H |

(X ) =−p(x )log p(x ) − |

1−p(x ) log1−p(x ) . |

|||||

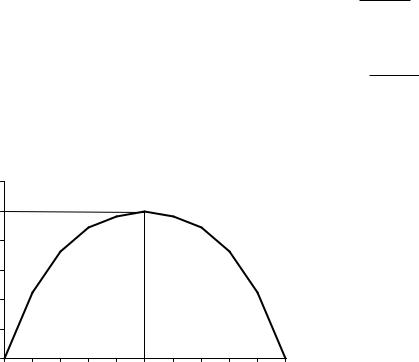

Из полученного выражения можно сделать следующие выводы:

1). Величина энтропии H1(X ) имеет максимальное значение при равновероят-

ном законе распределения символов, то есть, в рассматриваемом случае и при

p(x0 ) = p(x1) =0,5

и численно

H1(X )max =−0,5log0,5−0,5log0,5 =1.

При этом степень неопределенности появления любого из символов x0 или x1достигает максимального значения.

29

2). Величина энтропии H1(X ) = H(X )min =0, если исходы символов известны заранее, то есть, если известно, что p(x0 ) =0 и p(x1) =1, то

H1(X ) =−0log0 −1log1=0.

В этом случае неопределенность в сообщении, то есть неопределенность в выборе символов отсутствует, вследствие чего энтропия сообщения равна нулю. 3). Задавая различные значения p(x0 ) и p(x1) , можно определить характер

изменения H1(X ) , например, при p(x0 ) =0,25 и p(x1) =0,75, получим

H1(X ) =−0,25log0,25−0,75log0,75 0,8 [символдв.ед. ]. При p(x0 ) =0,01и p(x1) =0,99 найдем

H1(X ) =−0,01log0,01−0,99log0,99 0,08 [символдв.ед. ].

График изменения энтропии для рассмотренного случая приведен на рис.2.2.

Это справедливо и для случая, когда m >2. |

|

|

1.2 |

|

1 |

|

0.8 |

H(x) |

0.6 |

|

|

|

0.4 |

|

0.2 |

|

0 |

|

p(x) |

Рис.2.2. Характер изменения энтропии при m=2. |

|

4). В общем случае энтропия H1(X ) , как статистический параметр, характери-

зует степень неопределенности некоторой системы с m различными состояниями при максимальном значении энтропии:

H(X )max |

m |

1 |

|

1 |

=log m . |

|

=− ∑ |

|

log |

|

|||

m |

m |

|||||

|

i=1 |

|

|

Совместная энтропия статистически независимых источников.

30

Пусть имеются два статистически независимых источника X и Y, причем мно-

жество состояний xi |

принадлежит источнику X, а yi — источнику Y. То есть |

||||||||||||

|

|

|

|

|

|

|

m |

|

y j |

|

n |

|

|

|

|

xi X = ∑ xi |

и |

Y = ∑ y j , |

|

||||||||

|

|

|

|

|

|

|

i=0 |

|

|

|

|

j=0 |

|

|

m |

|

|

|

|

|

n |

|

|

|

|

|

|

Причем |

∑ p(xi )=1 |

и |

|

∑ p(y j )=1 |

|

|

|

|

|||||

|

i=0 |

|

|

|

|

|

j=0 |

|

|

|

|

|

|

Если источники X и Y статистически не связаны между собою, то |

|||||||||||||

|

|

p(xi , y j ) = p(xi ) p(y j ) |

(2.8) |

||||||||||

Тогда, используя выражения (2.1) и (2.8) можно записать: |

|

||||||||||||

H(X ,Y) =−∑∑ p(x , y |

j |

)log p(x , y |

j |

) = |

|

||||||||

|

i |

j |

|

|

i |

|

i |

|

|

|

|

||

|

|

)[log p(x )+log p(y |

|

)]= |

|

||||||||

=−∑∑ p(x ) p(y |

j |

j |

|

||||||||||

i j |

i |

|

|

|

|

i |

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

=−∑ p(xi )log p(xi ) ∑ p(y j ) −∑ p(y j )log p(y j ) ∑ p(xi ) = |

|||||||||||||

i |

|

|

|

|

j |

|

|

j |

|

|

|

i |

|

=−∑ p(xi )log p(xi )−∑ p(y j )log p(y j ) = H(X ) +H(Y) |

(2.9) |

||||||||||||

i |

|

|

|

|

j |

|

|

|

|

|

|

|

|

Откуда следует, что совместная энтропия статистически независимых источников равна сумме энтропий этих источников. Этот вывод распространяется и на большее число статистически независимых источников.

Условная энтропия статистически зависимых источников.

Для оценки количества информации, создаваемого статистически зависимыми источниками, может быть использована так называемая условная энтропия.

Пусть имеются два статистически зависимых источника сообщений X и Y, каждый из которых характеризуется условиями, изложенными выше.

Если источники X и Y коррелированы, то это означает, что между сигналами этих источников xi и y j существует взаимосвязь, при которой любому значе-

нию, например xk (рис.2.3), могут соответствовать с различной степенью веро-

ятности различные значения сигналов источника Y, т.е.

p(y1 / x1);K; p(y j / xi );K; p(ym / xn ).

31