Методические указания

.pdf

Взаимосвязь между интегралом Фурье и рядом Фурье для рассмотренной теоремы в частотном представлении состоит в том, что

функция f ()t может быть представлена либо в виде интеграла Фурье (8.11), либо в виде ряда Фурье (8.17).

Выражение в виде интеграла Фурье определяет функцию f ()t для любых значений t . Выражение в виде ряда Фурье определяет функцию f ()t только в интервале от T1 до T2 через значения ее спектральной функции в точках отсчета на оси частот, отстоящих друг от

1

друга на расстоянии T2 −T1 .

Сопоставим результаты дискретизации непрерывной функции во временном и частотном представлении соответственно:

f (t)=

f (t)=

∞

∑

k=−∞

∞

∑

k=−∞

f(k t)sinω(c (t −k )t).

ωc t −k t

|

1 |

|

2π k |

|

j |

2π k t |

|

||

|

T2 |

−T1 |

|

||||||

|

|

|

|

. |

|||||

T |

−T |

S T |

−T |

e |

|

|

|

||

2 |

1 |

|

2 |

1 |

|

|

|

|

|

Во временном представлении элементом разложения является единичный импульс, из которого взят отрезок, ограниченный по частоте, а в частотном — элементом разложения является синусоида, из которой взят ограниченный отрезок во времени.

Во временном представлении суммирование производится по элементам, равноотстоящим во времени, а в частотном — суммирование производится по элементам, равноотстоящим по частоте. Таким образом, во временном представлении элементы ограничены по частоте, а суммирование по времени.

В частотном же представлении элементы ограничены во времени, а суммирование по частоте.

Функция с ограниченным спектром F и временем T определяется 2 FT числами, независимо от того, будут ли эти числа определены как мгновенные значения функции, отсчитанные через t , или как спектральные коэффициенты разложения в ряд Фурье, отстоя-

1

щие друг от друга на расстоянии T2 −T1 (Гц).

Пример 8.1. Пусть на вход канала передачи информации поступает сообщение Y .

127

Определить количество информации, содержащееся в сообщении, при недостоверном приеме из-за воздействия помех.

Пояснения.

а) При отсутствии помех, при приеме сообщения Y , неопределенность полностью снимается и количество получаемой информации

I(X ,Y )равно энтропии источника сообщений, то есть:

I(X ,Y )= H(X ).

При достоверном приеме имеется однозначное соответствие между принятыми и переданными символами, т.е.

x |

i |

|

= |

1 |

при |

i= j; |

p |

y j |

0 |

|

|

||

|

|

|

при |

i≠ j. |

б) При наличии помех при приеме сообщения Y неопределенность полностью не снимается и количество получаемой информации

I(X ,Y )будет равно, в соответствии с выражением разности между

энтропией источника H(X )и энтропией помех H (Y X , т.е. |

||||||||||||||||

( |

|

) |

|

( |

|

) |

|

( X ) |

( |

|

) |

|

|

|

( |

Y ) |

I |

X ,Y |

|

= H |

|

X |

|

−H Y |

= H |

X |

|

−H |

X . |

||||

Так как |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

H (X )=−∑m p(xi )log p(xi ) |

|

|

|

|

|

|

|

|||||||||

и |

|

|

i =1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

H (Y X )=− |

m |

m |

|

|

y |

|

|

|

|

|||||||

∑ ∑ p(xi , y j |

)log p |

|

j |

x |

, |

|

||||||||||

|

|

|

i =1 |

j =1 |

|

|

|

|

|

|

i |

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

|||||

учитывая известные соотношения для вероятности совместного появления двух зависимых событий

|

i |

, y |

j |

|

( |

i ) |

y j |

|

( |

y |

j ) |

x |

|

|

|

|

|

|

|

|

|

||||||||

p x |

|

= p x |

p |

|

= p |

p |

i |

, |

||||||

|

|

|

|

|

|

|

|

xi |

|

|

|

|

|

y j |

окончательно запишем:

128

I(X ,Y )=−∑m p(xi )log p(xi )+

i =1

|

∑ ∑ |

|

j |

xi |

y |

|

xi |

y |

|

( ) |

Y |

||

|

p(y |

)p |

|

|

|

( |

X ) |

||||||

+ |

m |

m |

|

|

log p |

|

|

= H X −H |

|

. |

|||

|

|

|

|

|

j |

|

|||||||

|

i =1 |

j =1 |

|

|

|

|

j |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

Пример 8.2. Пусть имеется дискретный источник X с алфавитом из m символов, вероятности которых равны, т.е.

p(x1 )= p(x2 )=K= p(xi )=K= p(xm )= m1 .

Примем, что действие помех столь велико, что любой из принимаемых символов может соответствовать любому передаваемому. Определить количество информации при приеме.

Пояснения. Обозначим вероятность правильного приема через p , а вероятность ошибочного приема через q .

Тогда

y |

|

|

p |

|

при i= j; |

|

p |

j |

|

= |

q |

|

|

|

|

|

|

|

при i≠ j, |

|

|

|

xi |

|

|

|

|

|

|

|

m−1 |

|

||

так как под действием помех возможен переход любого символа xi

передаваемого сообщения X в любой из m−1 символов yj при-

нимаемого сообщения Y . В соответствии с известным выражением найдем условную вероятность того, что при передаче символа xi

был принят символ yj |

: |

|

|

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

y |

j |

|

|

x |

|

|

|

|

p(x ) p |

|

|

||||

|

|

|

|

i |

|

|

|

xi |

|

||

p |

i |

|

= |

|

|

|

|

|

|

|

. |

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

p(y j ) |

|

|

|

||

|

|

y j |

|

|

|

|

|

|

|

||

Так как p(xi )= p(y j ), то |

|

|

|

|

|

|

|||||

p xi |

|

|

p |

|

при |

|

i= j; |

||||

|

= |

|

1 |

|

|

|

|

|

|||

|

|

|

|

|

|

при i≠ j. |

|||||

|

|

y j |

|

|

|

|

|||||

|

|

|

|

m−1 |

|

|

|

|

|||

129

Подставляя это выражение в соотношение для I(X ,Y )получим:

I=logm + plog p +qlog mq−1.

Вчастном случае для бинарных сообщений m =2 и p +q =1. То-

гда

I =log2 + plog p +(1− p)log(1− p).

При p =0,5 и использовании двоичных логарифмов I =0 , т.е. неопределенность приема сообщения Y по отношению к передаваемому сообщению X не изменяется.

8.5. Информационный критерий оценки помехоустойчивости передачи информации ( β – критерий).

Примем, что в качестве канала передачи информации могут быть коммутирующее устройство (КУ), аналого-цифровой (АЦП) и циф- ро-аналоговый (ЦАП) преобразователи сигналов, запоминающее устройство (ЗУ), арифметическое устройство (АУ) и т.п. Независимо от этого в соответствии с информационным критерием помехоустойчивость «канала» оценивается по соответствию выходных данных входным без учета характера и причин возникновения помех между точками ввода и вывода информации. При этом действие помех и полезных сигналов оценивается по количеству информации, содержащемуся в них и выраженному посредством энтропии.

Потеря информации в канале в этом случае может быть выражена как

I(X ,Y )k = H(X )−H (X Y ),

где H(X )– энтропия полезных сигналов; H (X Y – энтропия по-

мех.

Нормируя приведенное выше выражение, помехоустойчивость канала можно выразить посредством коэффициента информационной надежности в виде:

β =1− |

H (X Y ). |

(8.20) |

|

H(X ) |

|

В случае равновероятного распределения энтропия входных (полезных) сигналов определяется как:

130

H0 |

(X )=logm =log100 |

=log100 |

|

дв.ед. |

|

|

|

, (8.21) |

|||

|

|||||

|

X |

δx |

|

отсчет |

|

где m — число различимых состояний входного сигнала, вероят-

ность появления каждого из которых: p(xi )= m1 ; δx – погреш-

ность сигнала, выраженная в процентах и соответствующая шагу квантования сигнала X .

В случае неравновероятного и независимого распределения состояний входных сигналов их энтропия будет:

H1(X )=−∑m p(xi )log p(xi )

i =1

при

m p(x )=1

∑ i .

i =1

Условная энтропия помех, действующих в канале, имеет следующее выражение:

|

|

|

|

|

|

|

|

m |

m |

|

y |

|

|

|

|

|

|

|

|

|

H (Y X )=−∑ ∑ p(xi , y j )log p |

j |

x |

, |

(8.22) |

||||||||

|

|

|

|

|

|

|

|

i =1 |

j =1 |

|

|

|

|

i |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

где |

|

|

|

|

|

|

|

|

|

y j |

|

|

|

|

|

|

|

|

|

|

( |

i |

, y |

j ) |

( |

i ) |

|

|

|

(8.23) |

|||

|

|

|

|

|

|

|

|

|

||||||||

|

|

|

|

p x |

|

= p x p |

; |

|

|

|

||||||

|

|

|

|

|

|

|

|

|

|

|

xi |

|

|

|

|

|

p(xi , y j )– вероятность совместного появления сигнала xi |

|

на входе |

||||||||||||||

и соответствующего сигнала yj |

на выходе канала; |

|

|

|

|

|

||||||||||

y |

j |

|

|

|

|

|

|

|

|

|

|

|

|

при ус- |

||

p |

|

– вероятность появления на выходе сигнала y |

j |

|||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

|

|

xi |

|

|

|

|

|

|

|

|

|

|

|

|

||

ловии, что на вход подан соответствующий сигнал xi . |

|

|

||||||||||||||

Из |

выражения |

8.22 следует, что при отсутствии |

помех, |

|

т.е. при |

|||||||||||

( |

i |

, y |

j ) |

=1 и |

|

y j |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

p x |

|

p |

|

=1 энтропия помех |

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

|

xi |

|

|

|

|

|

|

|

|

H (Y X )=0.

131

При наличии помех, действие которых столь велико, что корреляция между входом и выходом отсутствует, любому входному сигналу xi

может соответствовать любой выходной сигнал yj . В этом случае

значения сигналов xi |

и yj |

|

представляют собой вероятности незави- |

|||||||||

симых событий, для которых |

i ) |

|

( |

|

j ) |

|

||||||

|

|

|

i |

j |

|

( |

|

|

|

|||

|

|

p x , y |

|

|

= p x |

p |

|

y |

. |

|

||

Сопоставляя |

это |

выражение |

с |

равенством 8.22, |

получим |

|||||||

( i ) |

y j |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

p x |

= p |

. Учитывая указанные выше соотношения при |

||||||||||

|

|

xi |

|

|

|

|

|

|

|

H (Y X )= H(X ), |

|

|

рассмотрении равенства 8.22, получим |

т.е. при |

|||||||||||

отсутствии корреляции между входом и выходом энтропии помех равна энтропии полезных сигналов.

Таким образом, пределы изменения коэффициента информационной надежности β в зависимости от интенсивности помех можно выразить следующим образом:

1 ≥ β |

≥ |

0 ; |

|

|

( |

X ) |

( ) |

0 ≤ H Y |

|

|

|

|

|

||

|

≤ H X . |

||

Если в результате проверки канала на помехоустойчивость коэффициента β окажется меньше заданного, то потребуется исследовать

как характер помех, так и причины их возникновения. При этом в первую очередь необходимо проверить соотношение полезных сигналов и помех.

Ниже рассматривается методика практического использования информационного критерия при обработке результатов наблюдения. Пример 8.3. Пусть при испытании на помехоустойчивость АЦП число различимых уровней входного (кодируемого) сигнала m =10, причем все сигналы равновероятны. Оценить информационную надежность АЦП.

Решение.

1.На основании опытных данных, полученных в результате многократного кодирования каждого из уровней входного сигнала, про-

изводится расчет вероятностей |

y |

j |

|

p |

для каждого из уров- |

||

|

|

|

|

|

|

|

xi |

132

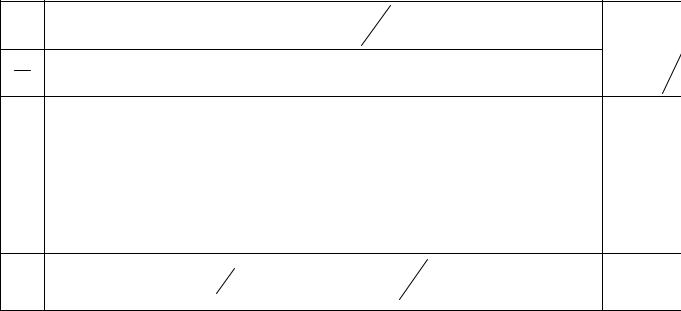

ней. Допустим, что такие условные вероятности определены и представлены в табл.8.1.

2.Производится расчет вероятностей совместного появления сигналов xi на входе и кодовых эквивалентов yj на выходе в соот-

ветствии с выражением (2.3), для которых p(xi )= m1 =0,1. Ре-

зультаты расчета представлены в табл.8.2.

3.На основании данных, приведенных в табл.8.2 и 8.3 определяется энтропия помех в соответствии с выражением (2.5). Результаты расчета представлены в табл.8.3.

4.Определяется энтропия кодированных сигналов в соответствии с выражением: H0(X )=log10 =3,32.

5.Рассчитывается коэффициент информационной надежности в соответствии с выражением

β =1−03,604,32 =0,82 (82%).

При большом числе разрядов АЦП число различимых уровней входных сигналов велико и при определении информационной надежности АЦП нет необходимости кодировать каждый из них.

Так, при числе разрядов n =10 число различимых уровней с учетом нулевого m =210 =1024. В этом случае для оценки информационной надежности АЦП выбираются k контрольных точек, для которых и определяются условные вероятности. При этом полагается, что значения сигналов примыкающих областей имеют те же условные вероятности, что и в контрольных точках.

Таблица 8.1

133

|

|

|

|

|

|

|

|

( |

|

xi ) |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

p |

y j |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

y j |

|

1 |

2 |

3 |

4 |

5 |

|

|

6 |

|

7 |

8 |

9 |

10 |

|

y |

|

)=1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

∑ p( |

j x |

|

|

|

xi |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

i |

|

|

1 |

|

0,9 |

0,1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1 |

|

|

|

2 |

|

|

0,9 |

0,1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

1 |

|

|

|

3 |

|

|

|

0,9 |

0,1 |

|

|

|

|

|

|

|

|

|

|

|

|

1 |

|

|

|

4 |

|

|

|

0,1 |

0,8 |

0,1 |

|

|

|

|

|

|

|

|

|

|

1 |

|

|

||

5 |

|

|

|

|

0,1 |

0,8 |

|

0,1 |

|

|

|

|

|

|

|

1 |

|

|

|||

6 |

|

|

|

|

|

0,1 |

|

0,8 |

|

0,1 |

|

|

|

|

|

1 |

|

|

|||

7 |

|

|

|

|

|

|

|

|

0,1 |

|

0,9 |

|

|

|

|

|

1 |

|

|

||

8 |

|

|

|

|

|

|

|

|

|

|

|

0,1 |

0,9 |

|

|

|

|

1 |

|

|

|

9 |

|

|

|

|

|

|

|

|

|

|

|

|

0,1 |

0,9 |

|

|

|

1 |

|

|

|

10 |

|

|

|

|

|

|

|

|

|

|

|

|

|

0,1 |

0,9 |

|

|

1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Таблица 8.2 |

|

||||

|

|

|

|

|

|

( i |

j ) |

|

( |

i ) |

y j |

|

|

|

|

p(xi )= |

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||

|

|

|

|

|

|

|

( |

xi |

|

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

p x y |

=p |

x |

p |

|

|

|

|

|

|

|

|

|

|

||

|

y j |

|

1 |

2 |

3 |

4 |

5 |

|

|

6 |

|

7 |

8 |

9 |

10 |

|

=∑ p(xi, y j ) |

|

|||

|

xi |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1 |

|

0,09 |

0,01 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

0,1 |

|

|

|

2 |

|

|

0,09 |

0,01 |

|

|

|

|

|

|

|

|

|

|

|

|

|

0,1 |

|

|

|

3 |

|

|

|

0,09 |

0,01 |

|

|

|

|

|

|

|

|

|

|

|

|

0,1 |

|

|

|

4 |

|

|

|

0,01 |

0,08 |

0,01 |

|

|

|

|

|

|

|

|

|

|

0,1 |

|

|

||

5 |

|

|

|

|

0,01 |

0,08 |

|

0,01 |

|

|

|

|

|

|

|

0,1 |

|

|

|||

6 |

|

|

|

|

|

0,01 |

|

0,08 |

|

0,01 |

|

|

|

|

|

0,1 |

|

|

|||

7 |

|

|

|

|

|

|

|

|

0,01 |

|

0,09 |

|

|

|

|

|

0,1 |

|

|

||

8 |

|

|

|

|

|

|

|

|

|

|

|

0,01 |

0,09 |

|

|

|

|

0,1 |

|

|

|

9 |

|

|

|

|

|

|

|

|

|

|

|

|

0,01 |

0,09 |

|

|

|

0,1 |

|

|

|

10 |

|

|

|

|

|

|

|

|

|

|

|

|

|

0,01 |

0,09 |

|

|

0,1 |

|

|

|

134

|

|

|

|

|

|

|

|

|

|

|

Таблица 8.3 |

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

y |

j |

xi ) |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

− p(xi y j )log p( |

|

|

|

|

∑ p x y |

|

|

||||||

y j |

|

|

|

|

|

|

|

|

|

|

j |

i |

j |

||||||

1 |

2 |

3 |

|

4 |

|

5 |

6 |

|

7 |

|

|

8 |

9 |

10 |

y |

j x |

|||

xi |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

log p( |

|

||

1 |

0,0137 |

0,0332 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

0,0469 |

||

2 |

|

0,0137 |

0,0332 |

|

|

|

|

|

|

|

|

|

|

|

|

|

0,0469 |

||

3 |

|

|

0,0137 |

0,0332 |

|

|

|

|

|

|

|

|

|

|

0,0469 |

||||

4 |

|

|

0,0332 |

0,0256 |

0,0332 |

|

|

|

|

|

|

|

|

0,0920 |

|||||

5 |

|

|

|

0,0332 |

0,0256 |

0,0332 |

|

|

|

|

|

|

0,0920 |

||||||

6 |

|

|

|

|

|

|

0,0332 |

0,0256 |

0,0332 |

|

|

|

|

0,0920 |

|||||

7 |

|

|

|

|

|

|

|

|

0,0332 |

0,0137 |

|

|

|

|

0,0469 |

||||

8 |

|

|

|

|

|

|

|

|

|

|

0,0332 |

|

0,0137 |

|

|

0,0469 |

|||

9 |

|

|

|

|

|

|

|

|

|

|

|

|

|

0,0332 |

0,0137 |

|

0,0469 |

||

10 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

0,0332 |

0,0137 |

0,0469 |

||

|

|

|

Y |

|

|

|

|

|

|

y j |

|

|

|

|

|

0,6043 |

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

= |

|

|

|

|

|

||

|

|

|

H ( |

|

X |

)= −∑ ∑ p(xi y j )log p |

|

|

|

|

|

|

|

||||||

|

|

|

|

|

|

i |

j |

|

|

|

xi |

|

|

|

|

|

|

||

135

9.Обработка информации.

9.1.Исходные положения.

Обработка информации — реализация соответствующих алгоритмов обработки измерительной и вычислительной информации при требуемых показателях точности, быстродействия и достоверности. Техническими средствами обработки информации являются СВТ (аналоговые, цифровые и гибридные).

Основными видами обработки информации являются:

•вычислительная обработка, т.е. выполнение математических операций над входными величинами в соответствии с заданным алгоритмом;

•статистическая обработка, т.е. определение таких показателей как дисперсия, математическое ожидание, функция корреляции, энтропия и т.п.;

•выделение полезной информации, т.е. обеспечение требуемой достоверности протекания информационных процессов;

•адаптация, т.е. сжатие информации с целью повышения скорости обработки информации без потери точности и достоверности.

Любой из рассмотренных ранее информационных процессов сопровождается воздействием различного рода помех, снижающих достоверность результата. В связи с этим, прежде всего, рассмотрим специфику помех и некоторые способы выделения полезной информации.

Выделение информации можно определить как процесс, обеспечивающий формирование, передачу, преобразование, хранение, распределение и переработку информации в ВУ с заданной информационной надежностью (помехоустойчивостью).

Проблема выделения полезной информации на фоне помех возникает в аналоговых, цифровых и в цифро-аналоговых ВУ. Для каждого из этих ВУ процесс выделения информации имеет свою специфику. Современные автоматизированные системы управления (АСУ) производственными процессами и объектами немыслимы без использования электронных цифровых вычислительных машин (ЦВМ) и цифро-аналоговых вычислительных устройств (ЦАВУ).

Особенно возросла роль ЦВМ с связи с созданием отраслевых АСУ (например, АСУ железнодорожного транспорта, АСУ воздушного транспорта, сельского хозяйства и т.п.), в которых может быть использовано до нескольких ЦВМ, разнесенных на значительное расстояние.

136