- •Обобщенная структура системы связи. 3. Характеристики систем связи.

- •Помехи в системах связи. Характеристики помех.

- •Информация. Понятие информации. Меры информации.

- •5. Мера Хартли

- •Вероятностный подход к измерению информации.

- •8. Статистическая мера количества информации.

- •Типичные сообщения, их свойства.

- •10. Семантический подход к оценке информации.

- •Энтропия дискретных сообщений.

- •Свойства энтропии.

- •Энтропия непрерывных сообщений.

- •14. Распределения с максимальной энтропией.

- •Непрерывные и дискретные сообщения. Общность и различие.

- •Характеристики случайных процессов.

- •18. Понятие стационарности случайного процесса (ссп).

- •Свойство эргодичности ссп.

- •20. Свойства корреляционной функции стационарного случайного процесса

- •23. Эффективная ширина спектра случайного процесса 21. Интервал корреляции.

- •Дискретизация по времени. Факторы, влияющие на выбор интервала дискретизации.

- •25. Теорема котельникова

- •26. Корреляционный критерий

- •Критерий наибольшего допустимого отклонения.

- •Оценка погрешности восстановления сигнала по дискретным отсчетам.

- •Функция отсчетов. Ее свойства.

- •Энтропия статистически зависимых сообщений.

- •31. Квантование по уровню

- •32. Тепловой, дробовый и фликкер шумы

- •Количество информации при наличии помех. 34. Как проявляется действие помех при передаче непрерывных и дискретных сообщений.

- •Скорость передачи информации.

- •Согласование источников сообщений с каналом связи.

- •Цели и задачи кодирования.

- •Оптимальное кодирование.

- •45. Критерий оптимальности кода.

- •Код Шеннона-Фано. Код Хаффмена.

- •Кодирование блоков сообщений.

-

Количество информации при наличии помех. 34. Как проявляется действие помех при передаче непрерывных и дискретных сообщений.

Количество информации при наличии помех для дискретных сообщений

Если передаваемое количество информации равно Н (X), а принятое Н (Y), то условная энтропия Н (XIY) представляет собой то количество информации, которое надо добавить к H (У), чтобы получить энтропию объединения X и Y, т. е. условная энтропия Н (X/Y) есть то количество информации которое обеспечивает полное знание передаваемых сообщений Х, если извест но полученное количествр информации Н (Y). В связи с этим Н (X\Y) можно назвать потерей информации, обусловленной действием помех, передаваемого сообщения. Таким образом, количество информации, которое содержится в принятой совокупности сообщений Y относительно переданной X, представляет собой разность между энтропией источника и потерями: I(Y,X)=H(X)-H(X/Y).

При большом уровне помех сообщения X и Y становятся статистически независимыми, а условная энтропия Н (X/Y) приближается к безусловной. В этом случае (Y,X) = H(X) — H(X/Y)=0 (I-119)

и сообщения Y не несут никакой информации об X.

Рассмотрим другие выражения для / (Y, X). Как следует из (1-27): Н (X) + Н (YIX) = Н (Y) + Н (X/Y), откуда находим

Н(Х) — Н (X/Y) = Н (Y) — Н (Y/X) = / (К, X) = / (X, Y). (I-120)

Полученный результат свидетельствует о том, что количество информации в сообщениях Y относительно X равно количеству информации сообщениях X относительно Y. Величины / (Y, X) и / (X, Y) называют полной взаимной информацией.

Если передаваемые сообщения и помехи полностью статистически независимы, то условная энтропия Н (YIX) является добавочной энтропией, которую дает знание сообщений Y. Она обусловлена только помехами и поэтому H(Y/X) = H(N), (I-121)

где Н (N) — энтропия помех.

Таким образом I(Y,X) = H(Y)-H(N), (I-122)

т. е. полученная информация равна разности между энтропией полуденного сообщения и энтропией помех. Взаимную информацию можно определить, исключив из (1-120) условную энтропию, используя (1-27) Н (XIY) = Н (X, Y) — Н (Y), после чего (1-119) преобразуется к виду: I(Y,X)=H(X) + H(Y)-H(X,Y).

(I-123)

Подстановка в (1-123) выражений (1-25) и (1-26) позволит получить выражения для

Смысл полученных выражений заключается в том, что они определяют степень уменьшения неопределенности относительно сообщений Х при получении сообщений У,т. е. после приема У наше знание об источнике X возрастает и круг возможных предположений относительно состояний источника X сужается.

Когда уровень помех невелик, сообщения X и Y связаны жесткой статистической зависимостью

![]()

условная энтропия Н (X/Y) равна нулю и потери информации отсутствуют, т. е. / (Y, X) = Н (X).

В случае непрерывных сообщений количество информации в принятом сообщении Y относительно переданного X можно определить как разность безусловной энтропии Н (X) и условной энтропии Н (X/Y). Условная энтропия, как и ранее, определит потери информации вследствие ослабления статистической связи между X и Y. С помощью метода, использованного при выводе (1-40), можно получить выражение для/ (Y, X), сходное с (1-124):

![]()

где р (х, у) - функция совместной плотности вероятности.

В том случае, когда сообщения X и Y статистически независимы р (х, у) = р (х) р (у), (1-127) обращается в нуль, т. е. количество взаимной информации в таких сообщениях будет равно нулю. Такое положение наблюдается при больших уровнях помех. Если сообщения X подвержены действию помех .N, причем X и N статистически независимы, потери информации определятся только действием помех (1-122), т. е. I(Y,X) = H(Y)-H(N).

Непрерывные сообщения

Для определения количества информации при непрерывных сообщениях воспользуемся в качестве исходного выражением (4.23), определяющим количество информации при дискретных сообщениях. В этом выражении начальная и остаточная энтропии сообщений соответственно

(4.26)

(4.26)

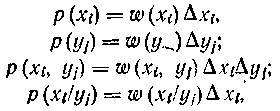

Для перехода к непрерывным случайным величинам выразим вероятности через функции распределения плотности вероятности

где Δхі и Δуі — элементарные участки, на которые разбиты шкалы уровней случайных величин х и у, ω(xі), ω (yj), ω (xі, yj), ω (xі/yj) — значения функций распределения при аргументах X = хі, Y — yj.

Тогда, произведя в (4.26) соответствующие замены, получим

Осуществим предельный переход при Δxі -> 0 и Δyj -> 0. Предел выражения для начальной энтропии Н (X) при Δxі → 0

![]()

Определим предел для остаточной энтропии

Таким образом, после осуществления предельных переходов получаем выражение для количества информации при непрерывных сообщениях

[4.27)

[4.27)

Следовательно, и при непрерывных сообщениях количество передаваемой информации определяется разностью начальной и остаточной энтропии сообщения.

Если

учесть, что

то выражение (4.27) можно представить в ином виде:

![]()

В отличие от дифференциальной энтропии количество информации не зависит от масштаба непрерывных сообщений, если масштабы X и У одинаковы.