- •Обобщенная структура системы связи. 3. Характеристики систем связи.

- •Помехи в системах связи. Характеристики помех.

- •Информация. Понятие информации. Меры информации.

- •5. Мера Хартли

- •Вероятностный подход к измерению информации.

- •8. Статистическая мера количества информации.

- •Типичные сообщения, их свойства.

- •10. Семантический подход к оценке информации.

- •Энтропия дискретных сообщений.

- •Свойства энтропии.

- •Энтропия непрерывных сообщений.

- •14. Распределения с максимальной энтропией.

- •Непрерывные и дискретные сообщения. Общность и различие.

- •Характеристики случайных процессов.

- •18. Понятие стационарности случайного процесса (ссп).

- •Свойство эргодичности ссп.

- •20. Свойства корреляционной функции стационарного случайного процесса

- •23. Эффективная ширина спектра случайного процесса 21. Интервал корреляции.

- •Дискретизация по времени. Факторы, влияющие на выбор интервала дискретизации.

- •25. Теорема котельникова

- •26. Корреляционный критерий

- •Критерий наибольшего допустимого отклонения.

- •Оценка погрешности восстановления сигнала по дискретным отсчетам.

- •Функция отсчетов. Ее свойства.

- •Энтропия статистически зависимых сообщений.

- •31. Квантование по уровню

- •32. Тепловой, дробовый и фликкер шумы

- •Количество информации при наличии помех. 34. Как проявляется действие помех при передаче непрерывных и дискретных сообщений.

- •Скорость передачи информации.

- •Согласование источников сообщений с каналом связи.

- •Цели и задачи кодирования.

- •Оптимальное кодирование.

- •45. Критерий оптимальности кода.

- •Код Шеннона-Фано. Код Хаффмена.

- •Кодирование блоков сообщений.

-

Оценка погрешности восстановления сигнала по дискретным отсчетам.

Представим полезный сигнал в виде х(t) = Вf(t),

где f (t) — известная функция времени; В — параметр сигнала.

Задача состоит в том, чтобы по принятой выборке Y определить, каково значение параметра В в полезном сигнале X.

В отличие от случаев обнаружения и различия сигналов здесь имеет место бесконечное множество возможных значений параметра В и, соответственно, бесконечное множество гипотез. Методы, рассматриваемые в случае двухальтернативных и многоальтернативных ситуаций, применимы и для задачи восстановления сигнала.

Произведем оценку параметра В методом максимума правдоподобия. Если отсчет принятого сигнала производится в дискретные моменты времени, то функция правдоподобия для параметра В будет оавна

(8.56)

(8.56)

Задача состоит в том, чтобы найти такое значение параметра В для которого функция правдоподобия максимальна. Максимуму функции правдоподобия соответствует минимальное значение показателя степени в выражении (8.56)

Из

условия минимума![]() имеем

имеем

![]()

откуда получаем оценочное значение параметра

Осуществив переход к непрерывному примеру, получим

где

![]() —

удельная энергия сигнала (энергия

сигнала при амплитуде В

= 1).

—

удельная энергия сигнала (энергия

сигнала при амплитуде В

= 1).

Для оценки точности восстановления сигнала используем критерий среднеквадратического отклонения. С этой целью в (8.58) принимаемый сигнал выразим в виде суммы у (t) = Bf (t) + ξ (t). Тогда

![]()

Погрешность восстановления

![]()

Дисперсия погрешности

Среднее от произведения ξ (t1)ξ (t2) представляет корреляционную функцию помехи

m1{ξ (t1)ξ (t2)} = Kξ (t) = G0δ(τ),

где g0 — спектральная плотность помехи; δ(τ) — дельта-функция;

τ= t2-t1

Тогда

Следовательно, среднеквадратическое значение погрешности восстановления

![]()

-

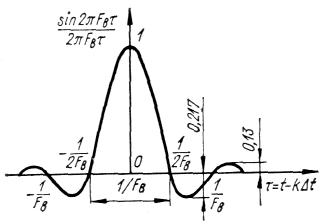

Функция отсчетов. Ее свойства.

Ряд Котельникова имеет вид:

![]() (1-72)

(1-72)

Полученное

выражение представляет собой разложение

в ряд непрерывной функции х (t).

Величины х (kΔt)

представляют собой значения непрерывной

функции в точках отсчета. Множитель

вида

![]() (1-73)

(1-73)

является

функцией времени и называется функцией

отсчетов (рис. 7). Функция отсчетов

принимает максимальное значение, равное

единице, в моменты времени t

= kΔt

и обращается в нуль в моменты времени

t

= (k

±τ)

Δt,

где m

= 1, 2, 3, .... Следует отметить, что функции

отсчетов ортогональны на бесконечно

большом интервале времени. Функция

отсчетов представляет собой реакцию

идеального фильтра нижних частот на

единичную импульсную функцию.

-

Энтропия статистически зависимых сообщений.

При определении энтропии и количества передаваемой информации предполагалось, что элементы сообщений статистически независимы. Однако в реальных условиях независимость элементов сообщений — явление довольно редкое. Например, при передаче русского текста вероятности появления отдельных букв зависят от того, какие буквы им предшествовали. Например, если передана буква «п», вероятность того, что "следующей буквой может быть «а» гораздо больше, чем вероятность появления буквы «р». После буквы «ъ» никогда не ожидается появление буквы «н» и т. п. Такая зависимость между элементами образовалась исторически в процессе длительного формирования современного русского языка.

Очевидно, что при определении энтропии и информации в сообщениях, элементы которых коррелированы, нельзя ограничиваться, как это мы делали до сих пор, только безусловными вероятностями элементов сообщений, необходимо учитывать и условные вероятности появления элементов.

Будем полагать, что передается конечное число сообщений х1, х2, х3, ... , хg, xn, хi, хj, ... , хп-1, хп. Коррелятивные связи между элементами сообщений могут распространяться на различные группы элементов. Если элементы сообщений независимы, то условная вероятность передачи элемента Xj будет равна безусловной

р (xj/x1, xn, хg, ..., х2, х1) = р (хj).

Если имеется коррелятивная связь только между двумя соседними элементами, то вероятность передачи любого элемента сообщения будет зависеть лишь от того, каков был предшествующий символ, т. е. условная вероятность передачи элемента хj будет равна p(Xj/Xi). В этом случае элементы сообщений составляют простую односвязную цепь Маркова.

Если коррелятивные связи охватывают три элемента сообщений то последние представляют двухсвязную цепь Маркова и услов ная вероятность передачи элемента хj будет равна р (xj/XiXn).

Большинство сообщений в реальных условиях представляю собой эргодическую последовательность, у которой коррелятивньн связи распространяются на конечное число элементов. При доста точной длине такой последовательности с достаточной точности могут быть определены вероятности и условные вероятности появ ления отдельных сообщений. Язык является типичным примере» такой последовательности. В любой книге на данном языке (кром узкоспециальных) частота повторения отдельных букв и их ра; личных сочетаний будет постоянной, независимой от содержани книги.

Пусть сообщения составляют простую, т. е. односвязную, цеп Маркова. В этом случае энтропия элемента хj будет определятьс условной вероятностью р (Xj/xі).

Для данного фиксированного хj энтропия сообщений буде определяться частной условной энтропией

![]()

Произведя усреднение по всем хi, получим выражение для средней энтропии сообщения

В случае наличия коррелятивных связей между тремя элементами энтропия сообщений будет равна

Если коррелятивными связями охвачено большее число элементов, то энтропия определится аналогично.

При наличии коррелятивных связей между элементами энтропия сообщений, а следовательно, и количество передаваемой информации уменьшаются, причем это уменьшение будет тем интенсивнее, чем сильнее коррелятивные связи и чем большее число элементов будет охвачено этими связями.