01 КАСЮК С. Т. ПЕРВИЧНЫЙ, КЛАСТЕРНЫЙ, РЕГРЕССИОННЫЙ И ДИСКРИМИНАНТНЫЙ АНАЛИЗ ДАННЫХ СПОРТИВНОЙ МЕДИЦИНЫ НА КОМПЬЮТЕРЕ

.pdf

дений и степень различия групп. Из таблицы видно, что центры групп расположены в трехмерном пространстве последовательно, в соответствии с названием группы. Расстояния между группами последовательно возрастают [3].

В таблице p-values (р-уровень значимости) (рисунок 4.10 в) можно проанализироватье статистическую значимость такого показателя, как расстояния Махоланобиса. Для всех значений расстояний p-levels ниже критического 0,05 [3].

Закроем окно с таблицами.

9 В окне Discriminant Function Analysis Results (Результаты анализа дис-

криминантных функций) на вкладке Advanced (Дополнительно) (рисунок 4.9)

нажмем кнопку Summary: Variables in the model (Переменные в модели). На экран появится таблица (рисунок 4.11), содержащая наиболее информативные переменные с соответствующими статистическими показателями. Из таблицы следует, что четыре переменных – Ferr, Ht, Hg, LBM – наиболее информативны (выделены красным цветом).

Рисунок 4.11 – Таблицы с результатами дискриминантного анализа – переменные в модели

В первом столбце этой таблицы (рисунок 4.11) приведены значения коэффициента лямбда Λ-Уилкса (Wilks's Lambda) для всей модели, являющиеся результатом исключения соответствующей переменной. Чем больше это значение, тем более желательна эта переменная в процедуре дискриминации, то есть переменные желательны в следующем порядке: Ferr, Ht, Hg, LBM, RCC.

Во втором столбце этой таблицы (рисунок 4.11) находятся значения частной Λ-Уилкса (Partial Wilks's), которая равна отношению Λ-Уилкса (Wilks's Lambda) после добавления переменной к Λ-Уилкса (Wilks's Lambda) до добавления этой переменной). Частная Λ-Уилкса (Partial Wilks's) характеризует единичный вклад соответствующей переменной в разделительную силу модели. Чем меньше это значение, тем больший вклад этой переменной в общую дискриминацию [3]. Переменные по силе дискриминации расположены в следующем порядке: Ferr, Ht,

Hg, LBM, RCC.

121

В третьем столбце этой таблицы (рисунок 4.11) находится значение F- исключить (F-remove) – значения критерия Фишера с соответствующими уровнями значимости. Чем меньше F-исключить и больше р-уровень, тем менее желательны переменные в модели. Те из них, у которых р > 0,05 можно исключить из модели [3]. Это переменная RCC.

Закроем окно анализа.

10 Оценим информативность переменных, не включенных в модель. В окне

Discriminant Function Analysis Results (Результаты анализа дискриминантных функций) на вкладке Advanced (Дополнительно) (рисунок 4.9) нажмем кнопку

Variables not in the model (Переменные вне модели). Появится таблица анализа

(рисунок 4.12), в которой для переменных, не включенных в модель, уровень значимости будет гораздо больше 0,05. В нашем примере это следующие перемен-

ные: WCC, Hc, BMI, SSF, %Bfat, Wt.

Рисунок 4.12 – Таблицы с результатами дискриминантного анализа – переменные вне модели

11 В окне Discriminant Function Analysis Results (Результаты анализа дискриминантных функций) переходим на вкладку Classification (Классифи-

кация) (рисунок 4.13) и нажимаем кнопку Classification functions (Функции классификации).

122

Рисунок 4.13 – Результаты анализа дискриминантных функций – вкладка Classification (Классификация)

Появится таблица Classification Functions (Функции классификации) (ри-

сунок 4.14), в которой каждому виду спорта соответствует набор коэффициентов для линейных классификационных функций [3].

Рисунок 4.14 – Таблица функций классификации

По данным этой таблицы можно рассчитать линейные классификационные функции (ЛФК) по следующим формулам:

BBall = –461,297 + 0,083·Ferr + 5,075·Ht + 13,440·Hg – 2,577·LBM – 8,962·RCC; Row = –452,542 + 0,111·Ferr + 4,733·Ht + 16,069·Hg – 2,161·LBM – 10,684·RCC; Tennis = –425,460 + 0,189·Ferr + 4,552·Ht + 13,365·Hg – 2,222·LBM – 2,198·RCC.

123

Подставив в каждое уравнение значения результатов измерений концентрации ферритина в плазме, роста тела, гемоглобина, мышечной массы и количества красных кровяных телец конкретной спортсменки, можно рассчитать линейные классификационные функции ЛКФ, после чего можно отнести женщину к конкретному виду спорта по наибольшему значению ЛКФ [3].

Закроем таблицу.

12 В окне Discriminant Function Analysis Results (Результаты анализа дискриминантных функций) на вкладке Classification (Классификация) (рису-

нок 4.13) нажимаем кнопку Classification matrix (Матрица классификации). В

результате на экран будет выведена таблица (рисунок 4.15), содержащая информацию о чувствительности решающих правил дискриминации.

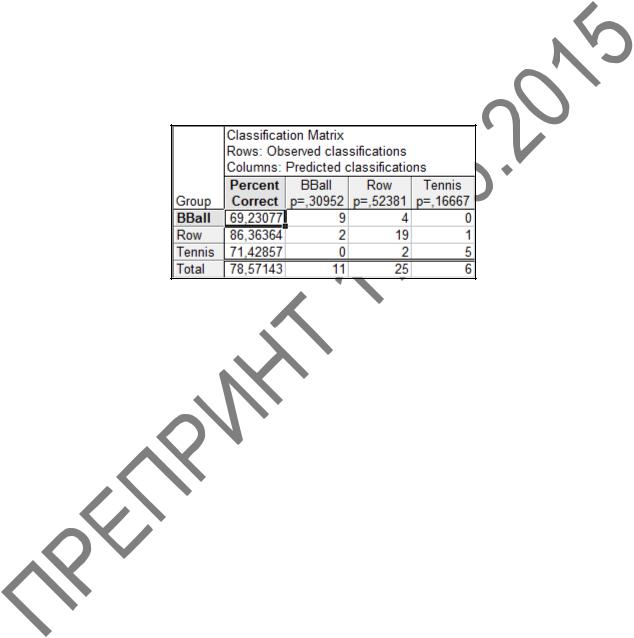

Рисунок 4.15 – Матрица класификации

Строки матрицы – действительные классы (виды спорта) спортсменок, а столбцы – предсказанные классы спортсменок. Процент правильной классификации объектов служит дополнительной мерой различий между группами, и еѐ можно считать наиболее подходящей мерой дискриминации [3].

Величина процентного содержания пригодна для суждения о правильном предсказании только тогда, когда распределение объектов по группам производилось случайно. Например, для двух групп при случайной классификации можно правильно предсказать 50%, а для четырех групп эта величина составит 25%. Поэму если для двух групп имеем Total (Всего) 60% правильнее предсказания, то нужно считать эту величину слишком малой, тогда как для четырех групп эта величина говорит о хорошей разделительной способности [3].

Из таблицы видно, что точность диагностики по решающим правилам (общий процент правильной классификации) составляет 78,6%. К группе BBall (баскетбол) отнесены 9 объектов из 4, процент правильной классификации составляет 69,23%. К группе Row (гребля) правильно отнесены 19 объектов, что составляет 86,36% правильной классификации. К группе Tennis (Теннис) правильно отнесены 5 объекта, что составляет 71,4% правильной классификации. Данные свидетельствуют о достаточно хорошей разделительной способности данной модели. Недостаточная точность диагностики групп объясняется перекрытием результатов изме-

124

рений концентрации ферритина в плазме, роста тела, гемоглобина, мышечной массы и количества красных кровяных телец.

Закроем таблицу.

13 В окне Discriminant Function Analysis Results (Результаты анализа дискриминантных функций) на вкладке Advanced (Дополнительно) (рисунок

4.9) нажимаем кнопку Perform canonical analysis (Проведение канонического анализа). Затем в появившемся окне Canonical Analysis (Канонический анализ)

(рисунок 4.16) на вкладке Advanced (Дополнительно) нажимаем кнопку

Summary: Chi square tests of successive roots (Критерии хи-квадрат последова-

тельных корней).

Рисунок 4.16 – Окно Canonical Analysis

(Канонический анализ)

В результате на экране появится таблица (рисунок 4.17), показывающая вклад КЛДФ в дисперсию признаков. Для оценки реальной полезности канонической дискриминантной функции используют коэффициент канонической корреляции R (Canonical R), Λ статистику Уилкса (Wilk's Lambda), статистику хиквадрат (Chi-Sqr.), уровень значимости (p-value). Значения дискриминантной функции должны как можно отчетливей разделять обе группы. Мерой удачности этого разделения служит корреляционный коэффициент между рассчитанными значениями дискриминантной функции и показателем принадлежности к группе, квадрат которого показывает, какая доля вариации зависимой переменной объясняется моделью (аналог R2 в регрессионном анализе) [3].

125

Рисунок 4.17 – Таблица критерия Хи-квадрат последовательных корней

(Chi-Square Tests with Successive Roots Removed)

Первая КЛДФ Root Removed (Корни исключенные) описывает наибольшую часть дисперсии симптомов заболевания. Вторая КЛДФ описывает наибольшую часть из оставшихся признаков. В таблице эти значения канонической корре-

ляции равны 0,7525 и 0,6666.

Прежде чем интерпретировать дискриминантную функцию, следует убедиться в еѐ статистической значимости. Для этого проверяют нулевую гипотезу о равенстве центроидов во всех группах (чтобы дискриминантная функция была статистически значимой, эта гипотеза должна быть отвергнута). Эта гипотеза проверяется с помощью коэффициента лямбда Λ-Уилкса (Wilks's Lambda). Этот коэффициент принимает значения от 0 до 1, и чем ближе он к нулю тем лучше прошла дискриминация. Таким образом, при помощи Λ-Уилкса проверяют, значимо ли в обеих группах отличаются друг от друга средние значения дискриминантной функции [3].

Для оценки значимости различия также используются собственные значения дискриминантной функции, выводимые под именем Eigenvalue (Собственное значение) (рисунок 4.17). Оно соответствует отношению суммы квадратов разброса между группами к сумме квадратов разброса внутри групп. Большое собственное значение указывает на высокое качество функции. Первая КЛДФ имеет наибольшее собственное значение. Мощность вклада функции оценивают по критерию Xи-квадрат. В рассматриваемом примере значение р < 0,05 указывает на статистически значимую мощность [3].

Вывод: для решения задач спортивной медицины следует применять две канонические КЛДФ (с уровнем значимости р < 0,05).

Закроем окно анализа.

14 В окне Canonical Analysis (Канонический анализ) (рисунок 4.16) на вкладке Advanced (Дополнительно) нажимаем кнопку Coefficients for canonical variables (Коэффициенты для канонических переменных). На экране появится две таблицы коэффициентов для канонических переменных: Raw Coefficients

(Исходные коэффициенты) (рис 4.18 а) и Standardized Coefficients (Стандартизованные коэффициенты) (рис 4.18 б).

126

а) |

б) |

Рисунок 4.18 – Таблицы коэффициентов для канонических переменных

Для анализа используем первую таблицу Raw Coefficients (Исходные коэффициенты) (рис 4.18 а). Для решения задачи дискриминантного анализа в нашем примере следует применять первые две канонические КЛДФ (Root 1 и Root 2), с суммарным (кумулятивным) вкладом в дисперсию результатов измерений показателей спортсменок 62,008% и 100%, что следует из приведенной таблицы. Функция 1 наиболее «важна», так как ответственна за 62,008% объясненной дисперсии. Функция 2 ответственна за 37,992% (100% – 62,008% = 37,992%) объ-

ясненной дисперсии. Константа (Constant) – свободный член в каждой КЛДФ [3]. Рассчитанные коэффициенты необходимо подставить в две канонические

КЛДФ:

D1 = 11,58854 + 0,03184·Ferr – 0,15080·Ht – 0,10716·Hg + 0,09658·LBM + 2,14712·RCC;

D2 = 2,36606 + 0,00233·Ferr – 0,10570·Ht – 1,53270·Hg – 0,17842·LBM + 2,18169·RCC.

Подставив в каждое уравнение значения результатов измерений показателей конкретной спортсменки, можно рассчитать КЛДФ.

Женщину-спортсменку, для которой по еѐ результатам обследования определены Dl и D2 (Root1 и Root2), следует отнести к группе по минимальному расстоянию до соответствующего центроида.

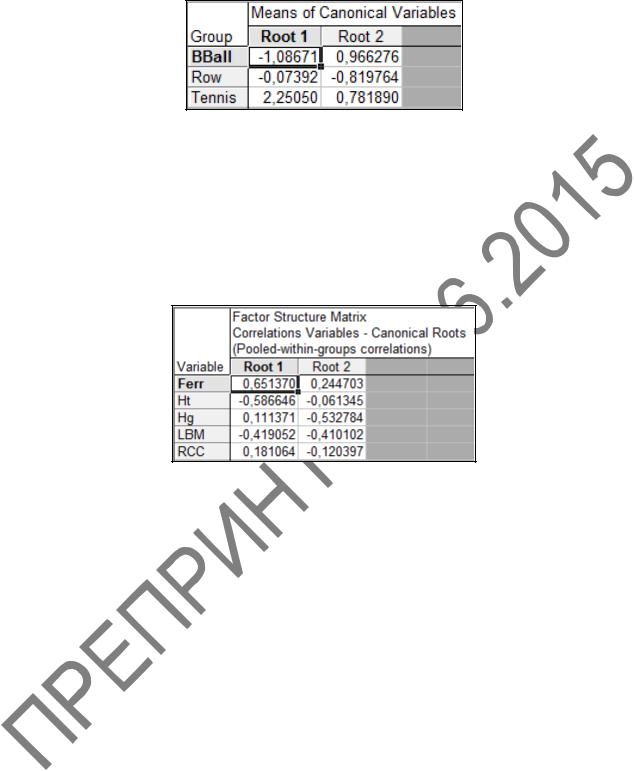

15 Определилим координаты центроидов для трех групп. В окне Canonical

Analysis (Канонический анализ) на вкладке Advanced (Дополнительно) (рису-

нок 4.16) нажимаем кнопку Means of canonical variable (Средние канонических переменных). На экране появится таблица средних канонических переменных

(Means of canonical variable) (рисунок 4.19).

127

Рисунок 4.19 – Таблица средних канонических переменных (Means of canonical variable)

16 В окне Canonical Analysis (Канонический анализ) на вкладке Advanced

(Дополнительно) (рисунок 4.15) нажимаем кнопку Factor structure (Факторная структура). В результате на экране появится матрица факторной структуры

(Factor Structure Matrix) (рисунок 4.20).

Рисунок 4.20 – Матрица факторной структуры (Factor Structure Matrix)

Матрица факторной структуры позволяет определить, какие переменные «маркируют» или определяют отдельную дискриминантную функцию. Коэффициенты факторной структуры являются корреляциями между переменными в модели и дискриминирующей функцией. Можно рассматривать эти корреляции как факторные нагрузки переменных на каждую дискриминантную функцию. Обычно структурные коэффициенты используют для содержательной интерпретации дискриминантных функций, в отличие от коэффициентов дискриминантных функций, которые обозначают вклад каждой переменной в функции [3].

В данном случае у переменные Hg и RCC слабо коррелируют с функцией Root1, а переменные Ferr, Ht, RCC слабо коррелируют с функцией Root2.

Закроем таблицу.

17 В окне Canonical Analysis (Канонический анализ) на кладке Canonical scores (Канонические значения) (рисунок 4.21) нажмем кнопку Scatterplot of canonical scores (Диаграмма рассеяния для канонических значений). На экране появится график положения объектов трѐх групп (BBoll, Row и Tennis) в координатах первой и второй канонических КЛДФ (рисунок 4.22).

128

Рисунок 4.21 – Окно Canonical Analysis (Канонический анализ) |

|||||||||||

|

|

вкладка Canonical scores (Канонические значения) |

|

||||||||

|

|

|

|

|

Root 1 vs. Root 2 |

|

|

|

|

||

|

5 |

|

|

|

|

|

|

|

|

|

|

|

4 |

|

|

|

|

|

|

|

|

|

|

|

3 |

|

|

|

|

|

|

|

|

|

|

|

2 |

|

|

|

|

|

|

|

|

|

|

2 |

1 |

|

|

|

|

|

|

|

|

|

|

Root |

|

|

|

|

|

|

|

|

|

|

|

0 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

-1 |

|

|

|

|

|

|

|

|

|

|

|

-2 |

|

|

|

|

|

|

|

|

|

|

|

-3 |

|

|

|

|

|

|

|

|

|

|

|

-4 |

|

|

|

|

|

|

|

|

|

BBall |

|

-4 |

-3 |

-2 |

-1 |

0 |

1 |

2 |

3 |

4 |

5 |

Row |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Root 1 |

|

|

|

|

Tennis |

|

|

Рисунок 4.22 – График положения объектов трѐх групп |

|

|||||||||

|

|

в координатах первой и второй канонических КЛДФ |

|

||||||||

129

Классы BBoll и Tennis дискриминированы между собой достаточно отчетливо, а вот класс Row перекрывается с классами BBoll и Tennis.

Закроем график и окно канонического анализа.

18 Возвращаемся в окно Discriminant Function Analysis Results (Результа-

ты анализа дискриминантных функций), выбираем закладку Classification

(Классификация) (рисунок 4.13) и нажимаем кнопку Squared Mahalanobis distance (Квадрат расстояния Махаланобиса). На экране появится таблица с квадратами расстояний Махаланобиса от наблюдений до центров групп (рису-

нок 4.23).

Рисунок 4.23 – Таблица Squared Mahalanobis Distances

(Квадраты расстояния Махаланобиса)

Наблюдение относится к той группе, до которой расстояние Махаланобиса минимально. Например, наблюдение 1 относится к классу BBoll, поскольку квадрат расстояния Махаланобиса минимален и равен 7,793.

При использовании данного решающего правила неправильно классифицированные наблюдения отмечены знаком *. Это наблюдения 9, 11, 12, 13, 16, 17.

130