- •Содержание.

- •1. Оптимизация режимов энергосистем 6

- •2. Автоматизированные системы управления (асу). 53

- •Введение

- •1. Оптимизация режимов энергосистем

- •1.1. Параметры режима эс

- •1.2. Формулировка задачи оптимизации

- •1.3. Особенности задачи нелинейного программирования

- •1.4. Методы безусловной оптимизации

- •1.4.1. Метод покоординатного спуска

- •1.4.2. Градиентный метод

- •1.4.3. Метод случайного поиска

- •1.4.4. Метод деформированного многогранника

- •1.5. Оптимизация с учетом ограничений в форме равенств

- •1.5.1. Метод прямой оптимизации

- •1.5.2. Метод приведенного градиента

- •1.5.3. Метод неопределенных множителей Лагранжа

- •1.6. Оптимизация с учетом ограничений в форме неравенств

- •1.7. Условия оптимального распределения нагрузки между параллельно работающими блоками

- •1.8. Характеристики основного оборудования тэс

- •1.9. Характеристики блоков

- •1.10. Маневренные свойства блока

- •1.11. Методы распределения нагрузки между блоками на кэс

- •1.11.1. Графический метод.

- •1.11.2. Распределение с помощью эвм.

- •1.12. Влияние погрешностей в определении на пережог топлива

- •1.13. Условие оптимального распределения в системе с тэс

- •1.14. Условия распределения мощности и энергии с учетом рынка перетоков

- •1.15. Определение удельных приростов потерь

- •1.16. Мероприятия по снижению потерь в сети

- •1.17. Распределение нагрузки в системе с гэс

- •1.18. Определение характеристик гэс

- •1.19. Распределение нагрузки в системе с гэс

- •1.19.1. Применение динамического программирования для выбора графика сработки водохранилища для гэс

- •1.20. Оптимизация реактивной мощности в системе

- •1.21. Комплексная оптимизация режима

- •1.22. Выбор состава включенного в работу оборудования.

- •1.23. Применение эвм для оптимизации

- •1.24. Оптимизация надежности

- •1.24.1. Выбор оптимального аварийного резерва

- •1.24.2. Определение дискретных рядов аварийного выхода и снижения нагрузки

- •1.25. Оптимизация качества электроэнергии.

- •1.26. Интегральный критерий качества.

- •1.27. Определение оптимального напряжения для осветительной нагрузки.

- •2. Автоматизированные системы управления (асу).

- •2.1. Энергосистема как объект управления.

- •2.2. Подсистемы асу тп.

- •2.3. Подсистемы технического обеспечения.

- •2.3.1. Датчики электрических параметров.

- •2.3.2. Счетчики.

- •2.3.3. Устройства преобразования информации.

- •2.3.4. Средства связи в асу и телемеханика.

- •2.3.5. Регистраторы событий.

- •2.3.6. Автоматизированные системы контроля и учета электроэнергии (аскуэ).

- •2.3.7. Средства отображения информации.

- •2.3.8. Информационное обеспечение.

- •2.4. Подсистемы программного обеспечения асу.

- •Иоасу “Энергия”

- •2.5. Асу тп тэс.

- •2.6. Асу пэс

- •2.7. Асу тп подстанций.

- •2.8. Контроль за работой пэ энергосистемы.

1.3. Особенности задачи нелинейного программирования

По сравнению с линейными задачи нелинейного программирования имеют ряд особенностей:

Допустимая область может быть не выпуклой (рис.1.2);

Рис. 1.2.

Решение может лежать как внутри допустимой области, так и на границе;

Целевая функция может иметь несколько экстремумов, один из них является глобальным, остальные – локальными (рис. 1.3)

Рис. 1.3.

Все это осложняет решение, поэтому, в отличие от линейного программирования, здесь существует множество методов решения подобных задач.

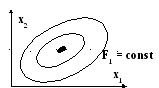

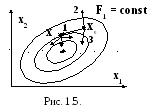

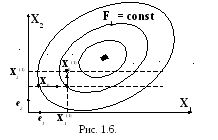

Ниже будут рассмотрены основные методы нелинейного программирования. Для иллюстрации их будет использована F(Х) при n=2 и представляемая на графике в виде линий F = const (рис.1.4).

Рис. 1.4.

1.4. Методы безусловной оптимизации

Пусть задана целевая функция F(Х)min без ограничений, где Х={x1,…,xn}.

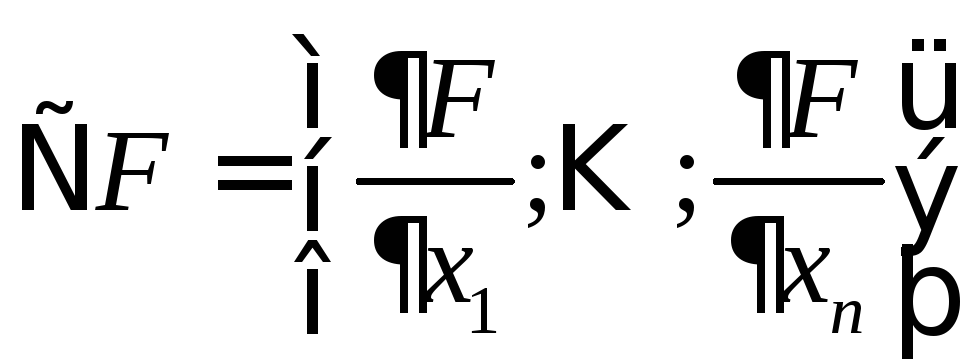

Если F(x) задана аналитически, то условие экстремума

гдеi=

1,…,n.

гдеi=

1,…,n.

Как известно,

условие минимума:

Далее будем рассматривать численные методы решения, которые удобны для реализации на ЭВМ. На сегодняшний день большинство таких методов относятся к методам возможных направлений (рис.1.5).

Р асчет

начинается с исходного приближенияx0.

В точке x0

рассматривается несколько направлений

асчет

начинается с исходного приближенияx0.

В точке x0

рассматривается несколько направлений

![]() .

Направления, ведущие к снижению F

(здесь 1 и 3) называют возможными

направлениями (ВН).

.

Направления, ведущие к снижению F

(здесь 1 и 3) называют возможными

направлениями (ВН).

По любому из этих

возможных направлений осуществляется

переход в следующую точку:

![]() ,

гдеt

– шаг.

,

гдеt

– шаг.

Получаем общее

уравнение:

![]() ,

,

где k – номер итерации (шага).

Величина шага t определяет сходимость процесса:

если t0, то сходимость медленная, но надежная;

если t – большой, то сходимость быстрая, но процесс может расходиться.

Наилучшая сходимость

обеспечивается выбором tОПТ

по критерию F(Х)min

на выбранном направлении

![]() .

Оптимальный шаг можно выбрать, еслиF(x)

представить по возможности как

.

Оптимальный шаг можно выбрать, еслиF(x)

представить по возможности как

![]() и по условию минимума

и по условию минимума

найти оптимальный

шаг

найти оптимальный

шаг

![]() .

.

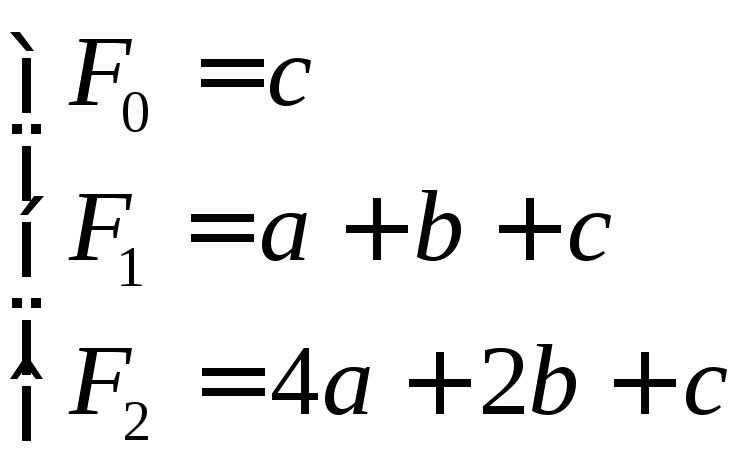

Чаще f(t) аппроксимируют кривой второго порядка:

![]()

Для определения параметров a,b и c считают f в трех точках:

- при t = 0, когда x = x0 (F(x0) = F0);

- при t

= 1, ![]() (F(x1)

= F1);

(F(x1)

= F1);

- при t

= 2, ![]() (F(x2)

= F2).

(F(x2)

= F2).

После этого составляют систему уравнений,

из решения которой находят a,b и c.

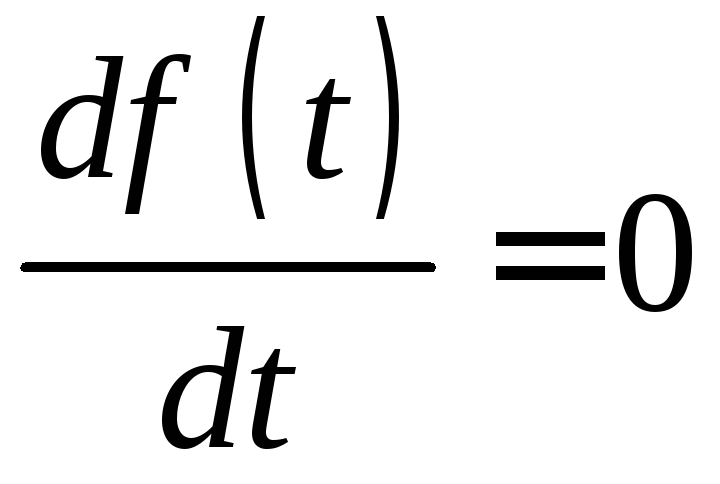

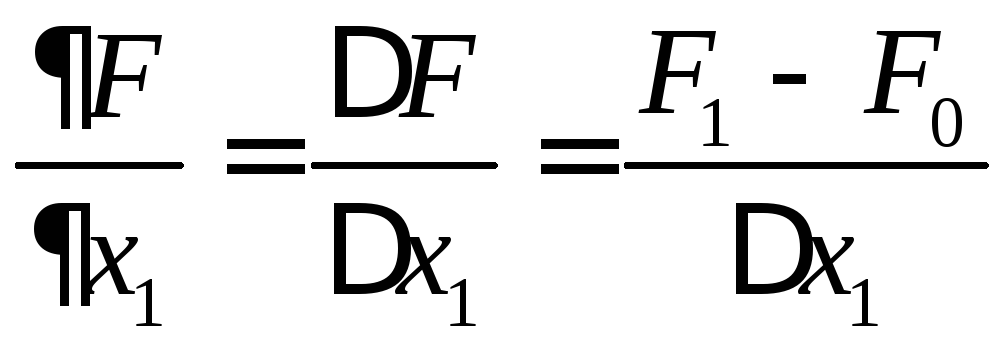

Из условия минимума функции

![]()

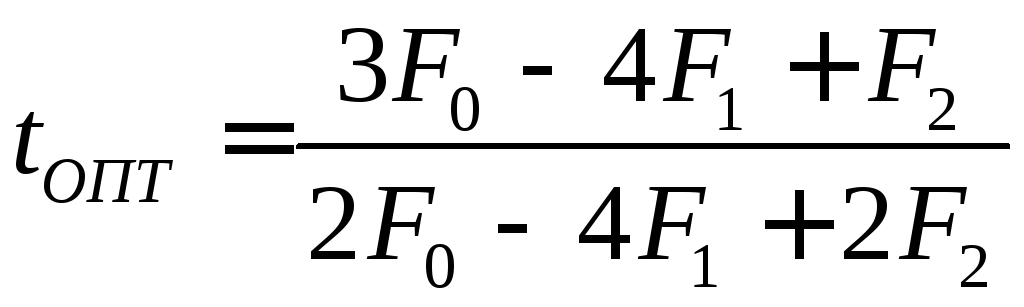

определяют оптимальный шаг

![]() ,

,

Методы, в которых определяется tОПТ, называются методами скорейшего поиска. Эти методы широко используются при решении задач.

В зависимости от выбора возможных направлений различают несколько методов.

1.4.1. Метод покоординатного спуска

Здесь возможные направления определяются по ортам ei (единичным векторам по осям координат). Каждая переменная xi последовательно (рис.1.6) оптимизируется, начиная с x1.

Оптимизация может проводиться различными методами, применимыми только для функций одной переменной.

После нахождения

![]() оптимизацию проводят по второй переменной

(x2)

и т.д.

оптимизацию проводят по второй переменной

(x2)

и т.д.

Аналогично проводятся последующие циклы и весь процесс.

Достоинства метода: простота. Недостатки: плохая сходимость для функций типа “овраг”.

1.4.2. Градиентный метод

Возможное направление выбирают противоположным градиенту:

Основное уравнение:

![]() .

.

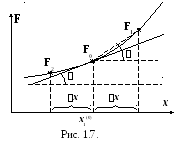

С оставляющие

градиента

оставляющие

градиента![]() находятся через конечные приращения

(рис.1.7):

находятся через конечные приращения

(рис.1.7):

.

.

Так как tg tg, то этот метод имеет погрешность в определении градиента, которая зависит от величины приращения аргумента.

Для снижения погрешности используют метод центрированных приращений.

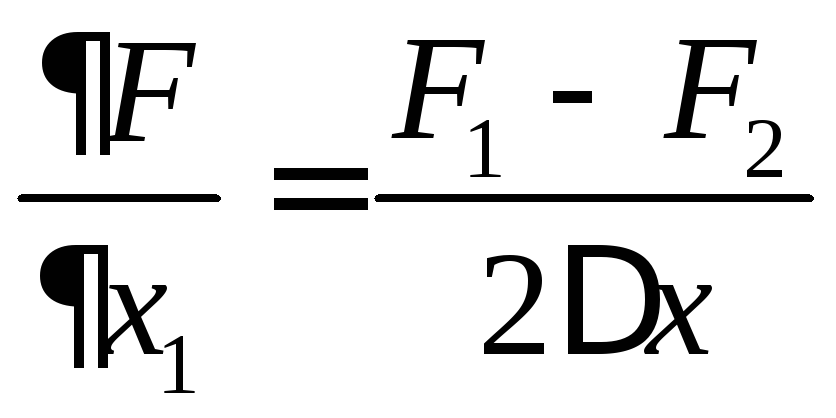

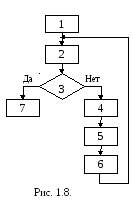

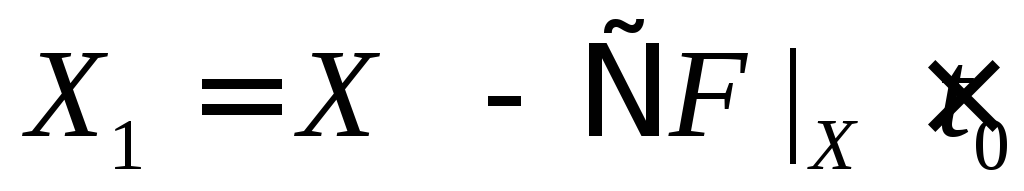

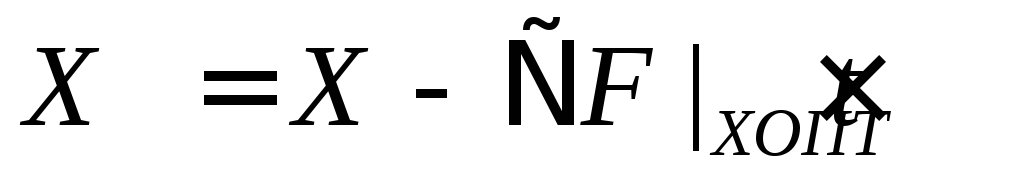

Градиентный метод часто сочетается с выбором оптимального шага. Для выбора используется пробный шаг t0, в конце которого определяются координаты Х1 и составляющие градиента. По значениям градиента в точках Х и Х1 определяется шаг близкий к оптимальному. Алгоритм метода приведена рис.1.8.:

Исходное приближение Х = Х(0);

Определение градиента F |X;

Сравнение |F| < eps;

t0 и определение

;

;Определение tОПТ;

Определение

;

;

Выход.

Метод широко используется в программах оптимизации режимов.