- •Понятие, история развития теории нейронных сетей.

- •2. Основные свойства мозга, которые моделируются.

- •3. Основные области применения нейронных сетей.

- •4. Составляющие модели нейронной сети.

- •5. Понятие нейрона

- •6. Виды искусственных нейронов

- •7. Виды и назначение функции активации

- •8. Виды архитектуры нейронной сети.

- •9. Основные модели динамических нейронных сетей.

- •10. Парадигмы обучения нейронных сетей.

- •11. Параметры оптимизации системы, обучаемой по примерам.

- •12. Правила обучения.

- •13. Алгоритм обучения персептрона Розенблата.

- •14. Оценки качества нейронной сети.

- •15. Алгоритм обратного распространения ошибки

- •16. Способы обеспечения и ускорения сходимости

- •17. Сеть встречного распространения

- •18. Модель зрительного восприятия.

- •19. Виды сегментации изображения.

- •20. Виды преобразований изображения между классами

- •21. Особенности зрительного восприятия человека.

- •22. Методы пороговой обработки изображений.

- •23. Методы выделения контуров на изображении.

- •24. Метод уточнения контура

- •25. Методы распознавания изображений.

- •26. Основные проблемы теории искусственного интеллекта

- •27. Направления исследований в области систем искусственного интеллекта.

- •28. Данные и знания. Способ определения понятий.

- •29. Особенности знаний

- •30. Семантические сети.

- •31. Типы объектов и виды отношений в семантической сети.

- •32. Фреймовая модель.

- •33. Сравнительная харак-ка систем предста-ия знаний на основе сетевых моделей.

- •34. Продукционная система.

- •35. Логическая модель представления знаний.

- •36. Сравнительная характеристика систем представления знаний на основе продукций и логической модели.

- •37. Метод резолюций.

- •38. Виды неопределенности в задачах принятия решений

- •39. Понятие лингвистической переменной и основные операции теории нечетких множеств.

- •40. Характеристики речевых сигналов

- •41. Методы обработки речевого сигнала

- •42. Распознавание речевых сигналов.

- •Вопросы

- •Понятие, история развития теории нейронных сетей.

- •Основные области применения нейронных сетей.

13. Алгоритм обучения персептрона Розенблата.

Однослойная сеть. Обучение с учителем.

-

Всем весам связей присваиваются некоторые случайные малые значения, чтобы сеть вышла из состояния равновесия и чтобы сеть не вошла в состояние насыщения.

-

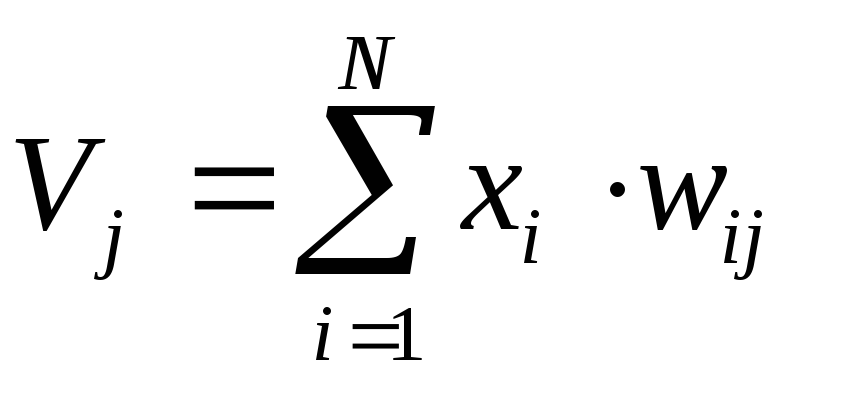

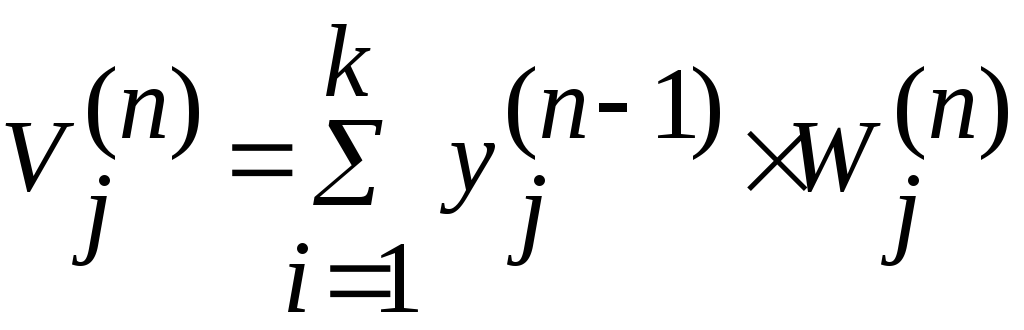

на входы подается вектор X примера и вычисляется потенциал входного нейрона:

,

где N

- количество компонент вектора.

,

где N

- количество компонент вектора. -

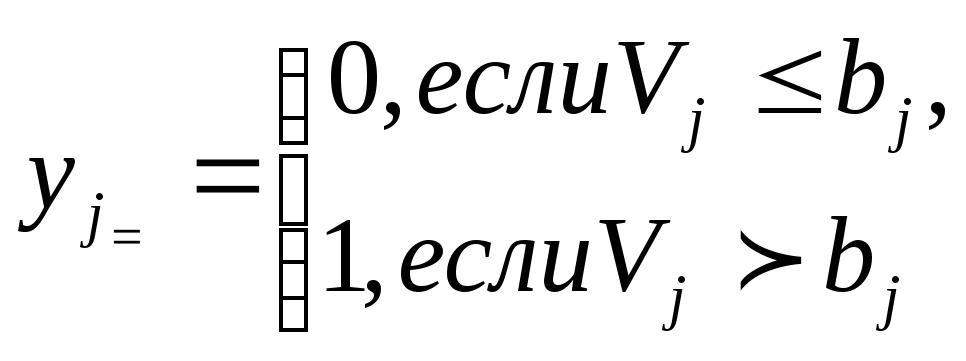

Вычисленные значения выхода каждого нейрона обрабатываются с помощью пороговой функции активации.

-

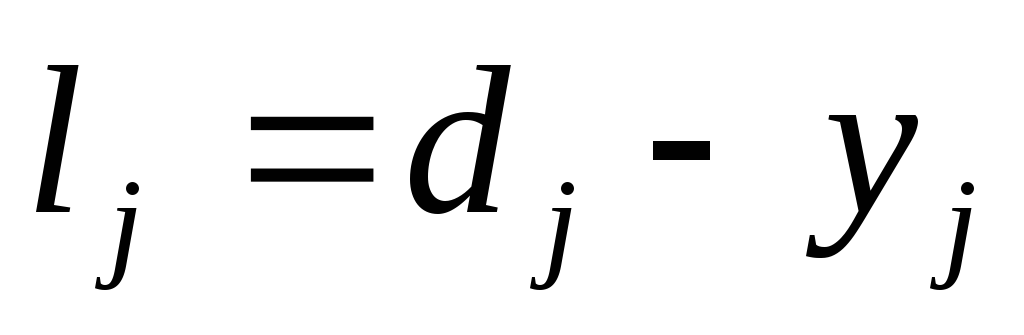

Для каждого нейрона вычисляется ошибка

-

Модифицируются веса связей (0 не модифицируется)

![]() ,

где

- коэффициент обучения (0<<1)

определяет добавку веса, которая

произойдет на определенном шаге. Если

общая ошибка сети больше заданной, то

шаги 2-5 повторяются.

,

где

- коэффициент обучения (0<<1)

определяет добавку веса, которая

произойдет на определенном шаге. Если

общая ошибка сети больше заданной, то

шаги 2-5 повторяются.

Недостатками алгоритма являются:

-

для сложных задач требуемое распределение связей может быть не найдено. При этом переходят к многослойной модели (вводят промежуточные слои).

-

Для многослойной сети трудно сформировать желаемое значение нейронов скрытых слоев. Поэтому при обучении многослойной сети переходят к оценке качества нейронной сети.

14. Оценки качества нейронной сети.

Целефая функция (Задача обучения) – это отыскание глобального минимума функции ошибки. Достижение глобального минимума называется сходимостью процесса обучения. Удачный выбор критерия ошибки приводит к получению более гладкой поверхности функции ошибки и упрощает обучение.

Критерии ошибки:

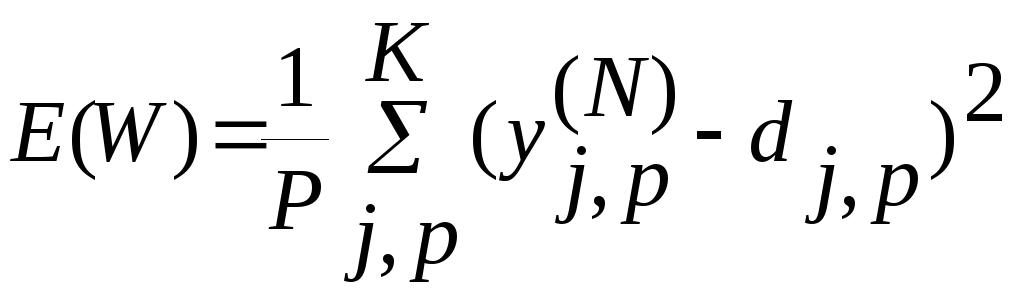

1. Среднеквадратичная ошибка вычисляется по множеству обучающих примеров

где

K

– количество примеров обучающей выборки,

d

– желаемый выход для к-го примера; y

– вычисленное значение выхода для к-го

примера.

где

K

– количество примеров обучающей выборки,

d

– желаемый выход для к-го примера; y

– вычисленное значение выхода для к-го

примера.

2. Модифицированная ошибка

![]() где

- уровень надежности сети.

где

- уровень надежности сети.

Для различных способов интерпретации выходных сигналов может принимать значения: 0 ≤1 – знаковая интерпретация. состояние нейронов определяет номер класса;

1 ≤2 – соревновательное правило или победитель забирает все.

0

≤

![]() - порядковая интерпретация, в данном

случае класс интерпретируется по формуле

N!

(факториал). N

– количество выходных нейронов.

- порядковая интерпретация, в данном

случае класс интерпретируется по формуле

N!

(факториал). N

– количество выходных нейронов.

15. Алгоритм обратного распространения ошибки

Данный алгоритм используется для полно связной сети. Суть алгоритма в распространении сигнала ошибки от входов сети последовательно через каждый скрытый слой на входе.Wij – связь, соединяющая i-ый нейрон предыдущего слоя с j-ым нейроном последующего слоя.

Ошибка

распространяется от выхода в сети к

входам, т.е. направлении обратном

функционированию сети в обычном режиме.

Для минимизации ошибки используется

функция отвеса

yj,p - реальное состояние нейрона выходного слоя N при подаче на входы сети примера P

d – желаемый выход нейрона для данного входного примера p.

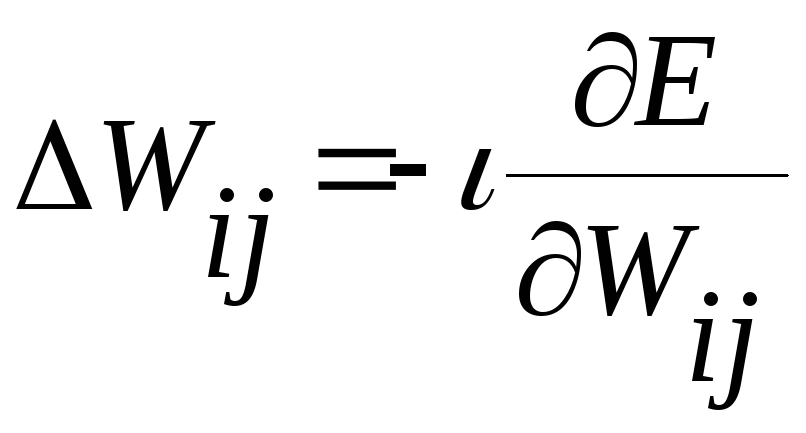

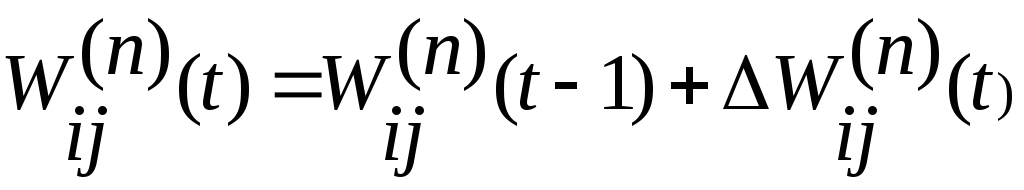

В процессе обучения выполняется минимизация ошибки E(W) методом градиентного спуска. Настройка весов осуществляется по правилу

(0<<1) (1)

(0<<1) (1)

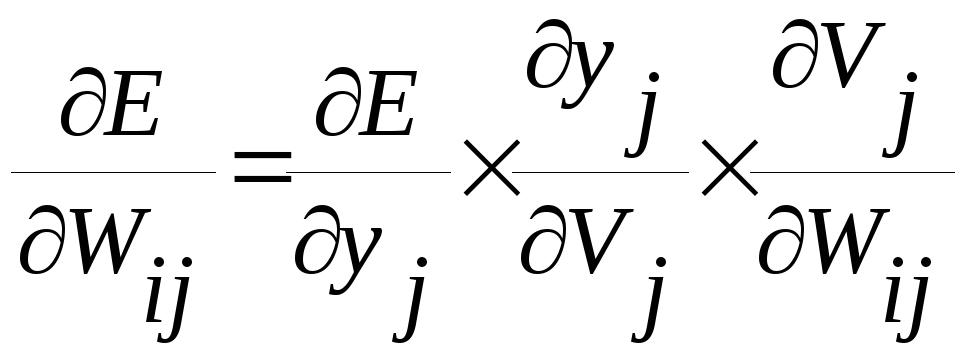

Определяют общую производную функцию:

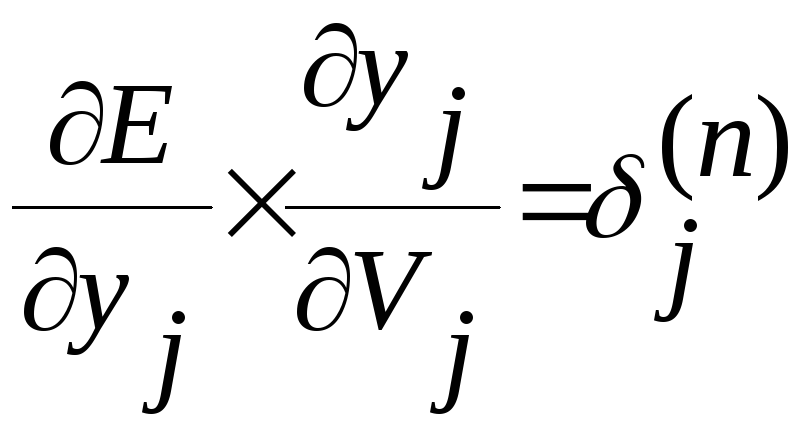

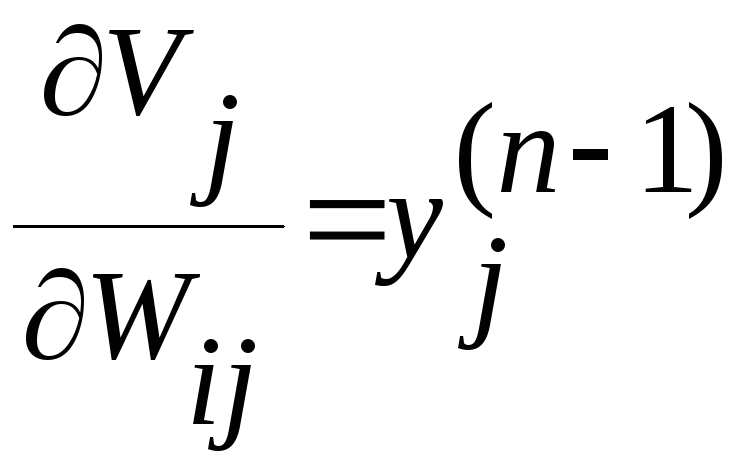

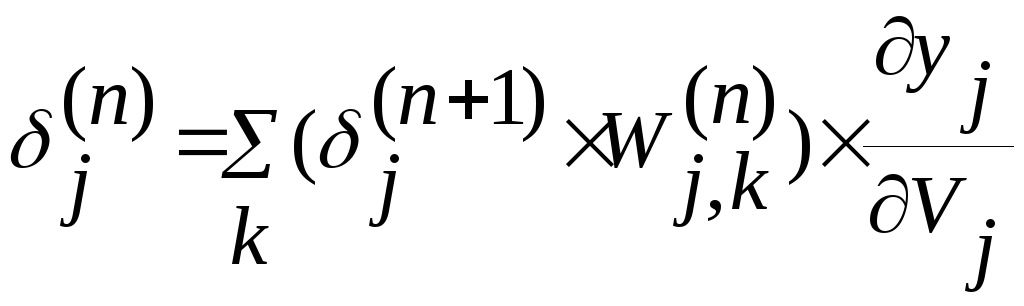

Для

расчета величины

![]() вводится рекурсивная формула для расчета

вводится рекурсивная формула для расчета

![]() через

через

![]()

k

– количество нейронов слоя (n+1)

k

– количество нейронов слоя (n+1)

Для

выходного слоя можно вычислить

![]()

Теперь перепишем формулу (1) в раскрытом виде

![]()

Алгоритм состоит из следующих шагов:

1) на входы подается один из возможных примеров из множества P и рассчитываются потенциалы для всех слоев в режиме обычного функционирования сети

у каждого нейрона для получения выходного сигнала используется сигмоидальная функция активации.

2)

по формуле (4) вычисляется

![]() для

выходного слоя.

для

выходного слоя.

-

по формуле (3) вычисляется ошибка на предыдущем слое через последующий и по формуле (5) величина коррекции веса. Ошибки вычисляются для слов от N-1 до 1, т.е. n=N-1,…..,1

-

корректируются все веса связей в нейронной сети

-

если общая ошибка E(W) больше заданной, то возвращаемся на шаг 1.