- •6.3. Синхронна мережа Гопфілда

- •6.4. Неперервна мережа Гопфілда

- •6.5. Асоціативна мережа вsв

- •7. Синергетичний комп’ютер

- •8. Мережа хеммінга

- •9. Динамічні рекурсивні шнм

- •9.1. Структура дрм

- •9.2. Неперервні дрм

- •9.3. Дискретна дрм

- •9.3.2. Частково-рекурсивні мережі

- •9.3.3. Локально-рекурсивні мережі прямого поширення

- •9.4. Навчання дрм

- •9.4.1. Алгоритм зворотного поширення помилки

- •9.4.2. Адаптивний алгоритм навчання

- •10. Мережа векторного квантування

- •10.1. Структура мережі векторного квантування

- •10.2. Неконтрольоване навчання мережі вк

- •10.3. Контрольоване навчання мережі вк

- •10.3.1. Lvq1

- •10.3.2. Lvq2.1

9.4.2. Адаптивний алгоритм навчання

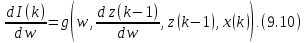

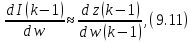

Даний алгоритм запропоновано і досліджено Р. Уільямсом і Д. Ціпсером [95] та використовує обчислення градієнта в момент часу к на основі часток похідних станів нейронів, обчислених у момент часу (k - 1), тобто

У цьому випадку обсяг необхідної пам’яті істотно зменшується й залежить тільки від кількості нейронів у мережі й кількості настроюваних параметрів. Хоча й тут необхідно брати до уваги всі попередні стани мережі, у цьому алгоритмі відбувається облік інформації лише про один останній такт, тобто складові в z(k-1) і х(k) мають розмірності n х 1 й N х 1 відповідно.

Під час використання даного алгоритму в реальному часі припускають, що

що й враховується в потактовій корекції ваг.

Контрольні запитання

У чому відмінність ДРМ від мережі Гопфілда?

Які існують різновиди ДРМ? У чому відмінність мережі Елмана від мережі Джордана?

Яким чином здійснюється навчання ДРМ?

10. Мережа векторного квантування

Багато завдань розпізнавання мовних сигналів, зображень тощо пов’язані з необхідністю зберігання, обробки й передачі великих масивів даних, що вимагає значних обчислювальних ресурсів і витрат часу. Якщо масиви даних різняться незначною мірою, то істотної економії як обчислювальних засобів, так і необхідного для розв’язання задачі часу можна досягти, використовуючи стиснення даних або спеціальні методи їхнього кодування. При цьому дані можуть бути, наприклад, згруповані в деякі класи, яким привласнюється свій код або індекс. Образи можна також розбити на деякі кластери, визначивши для кожного з них свого типового представника (опорного представника, центра кластера). Досить добре розроблені методи стиснення даних вимагають для своєї реалізації наявності статистичної інформації (щільності розподілу) про досліджувані процеси; застосування ефективних методів кодування можливе, якщо відома частота появи образів. В умовах, коли така інформація відсутня, найбільш ефективними є ШНМ векторного квантування (vector quantion, VQ), розроблені й досліджені Т. Когоненом [8-14].

10.1. Структура мережі векторного квантування

Під

векторним квантуванням (ВК) розуміють

процес перетворення деякого вектора х

з множини А є

у

векторw

з множини В

є

у

векторw

з множини В

є

,

деМ

< N.

Інакше кажучи, множина векторів х

розмірності N

х 1 розбивається

на кінцеве число класів М, М

< N,

кожному з яких привласнюється

свій код (призначається опорний

представник)

,

деМ

< N.

Інакше кажучи, множина векторів х

розмірності N

х 1 розбивається

на кінцеве число класів М, М

< N,

кожному з яких привласнюється

свій код (призначається опорний

представник)

.Множина

всіх

.Множина

всіх утворитькодову

множину

(кодову

книгу)

класифікатора.

утворитькодову

множину

(кодову

книгу)

класифікатора.

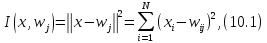

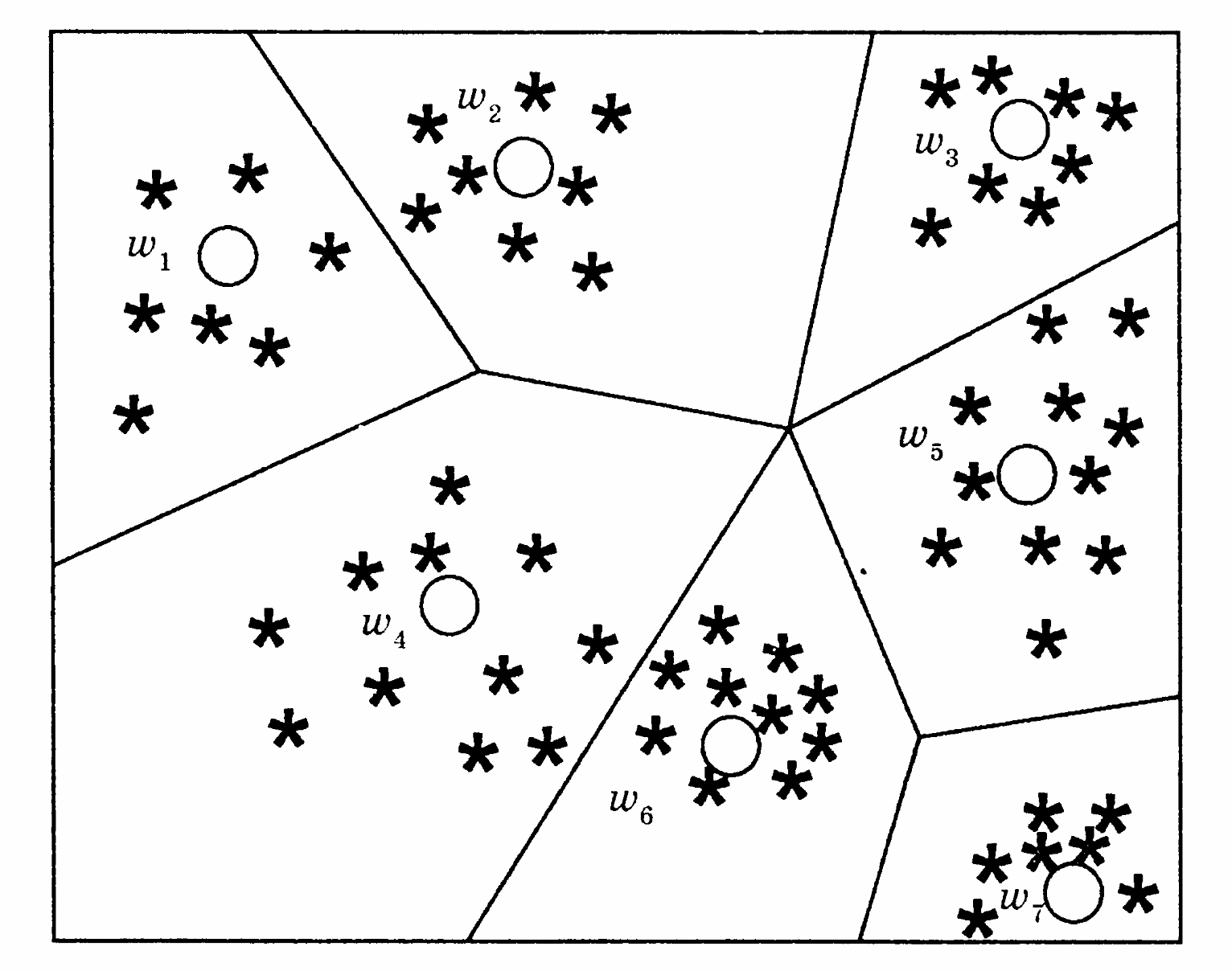

Векторне квантування здійснюється за допомогою методу «найближчого сусіда», причому під «найближчим» розуміється вектор, що задовольняє різним вимогам. Якщо як такий вибирається вектор, що знаходиться від даного на мінімальній евклідовій відстані, тобто на відстані, що мінімізує вартісний функціонал

маємо

класифікатор, що називається у літературі

Voronoi-класи-

фікатор.

Приклад такої класифікації, розбивання

всієї множини вхідних векторів на 7

класів (М = 7), наведено на рис. 10.1. Тут

зірочками позначені вхідні

вектори, а кільцями — відповідні опорні

представники

При

поданні вхідного образу, що підлягає

розпізнаванню,

видається

представник

видається

представник

того

класу, до якого відноситься

того

класу, до якого відноситься Межі

між класами утворять медіатриси між

опорними представниками.

Межі

між класами утворять медіатриси між

опорними представниками.

Рис. 10.1. Розбивання множини вхідних образів на класи

У

мережі ВК реалізовано принцип «переможець

отримує все»

(winner

takes

all),

коли за право подання будь-якого вхідного

образу (вектора) змагаються всі

нейрони вихідного шару. Нейрон, ваговий

вектор якого

найближчий до вхідного образу, є

переможцем.

найближчий до вхідного образу, є

переможцем.

Конкуруючі нейрони Когонена мають як власні зворотні зв’язки, так і латеральні, причому перші служать для посилення власного сигналу нейрона, а другі — для придушення впливу сигналів, що надходять від інших нейронів.

Кожен

нейрон вхідного шару з’єднаний з усіма

нейронами шару векторного квантування

(VQ-шару). Сила зв’язку визначається

відповідною вагою.

Нарис.

10.2

—

вектор ваг j-го нейрона Когонена.

—

вектор ваг j-го нейрона Когонена.

Рис. 10.2. Мережа векторного квантування

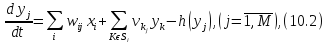

Динаміка мережі описується такими диференціальними рівняннями:

де

— вхідні сигнали

— вхідні сигнали ;

; —

вага зв’язку міжі-м

та j-м нейронами;

—

вага зв’язку міжі-м

та j-м нейронами;

—

вага зв’язку міжі-м

й j-м

нейронами;

—

вага зв’язку міжі-м

й j-м

нейронами;

— множина нейронів, пов’язаних з

j-м нейроном;

— множина нейронів, пов’язаних з

j-м нейроном; — нелінійний член, що враховує ефекти

насичення й зміщення.

— нелінійний член, що враховує ефекти

насичення й зміщення.

У

рівнянні (10.2) вагові коефіцієнти

є тими, що настроюються, ваги ж

зворотних зв’язків

є тими, що настроюються, ваги ж

зворотних зв’язків задаються й у процесі роботи мережі

не змінюються.

задаються й у процесі роботи мережі

не змінюються.