- •6.3. Синхронна мережа Гопфілда

- •6.4. Неперервна мережа Гопфілда

- •6.5. Асоціативна мережа вsв

- •7. Синергетичний комп’ютер

- •8. Мережа хеммінга

- •9. Динамічні рекурсивні шнм

- •9.1. Структура дрм

- •9.2. Неперервні дрм

- •9.3. Дискретна дрм

- •9.3.2. Частково-рекурсивні мережі

- •9.3.3. Локально-рекурсивні мережі прямого поширення

- •9.4. Навчання дрм

- •9.4.1. Алгоритм зворотного поширення помилки

- •9.4.2. Адаптивний алгоритм навчання

- •10. Мережа векторного квантування

- •10.1. Структура мережі векторного квантування

- •10.2. Неконтрольоване навчання мережі вк

- •10.3. Контрольоване навчання мережі вк

- •10.3.1. Lvq1

- •10.3.2. Lvq2.1

9.3.3. Локально-рекурсивні мережі прямого поширення

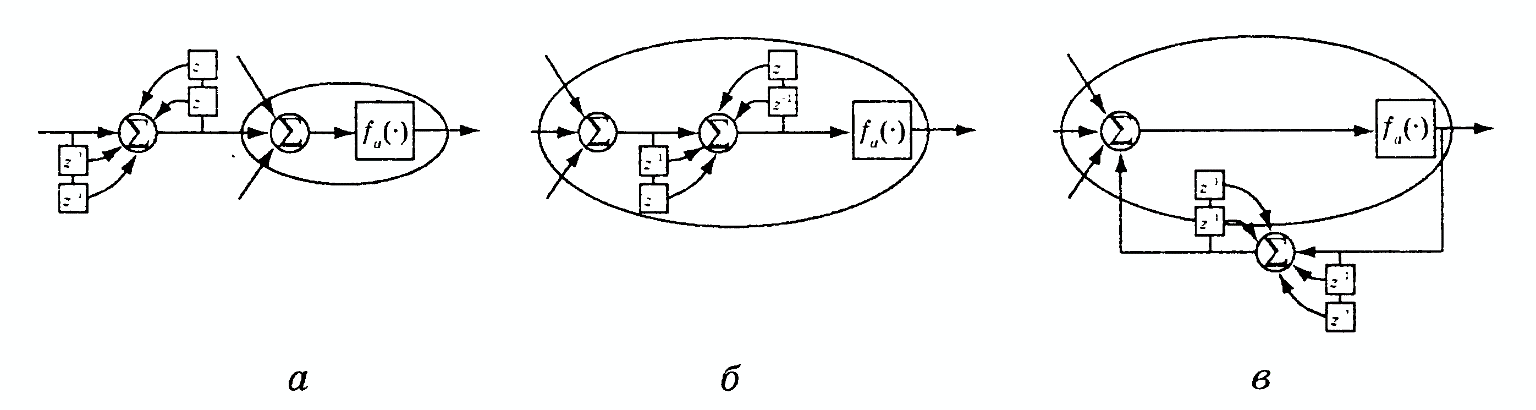

Мережі даного типу не використовують ні зворотний зв’язок між нейронами сусідніх шарів, ні латеральні зв’язки між нейронами одного шару. Рекурсивність у них завжди обмежується одним нейроном. Отримувані при цьому структури є лінійними, а зворотні зв’язки, що вводяться, інтерпретуються як фільтррі з кінцевою (КІХ) або нескінченною (НІХ) імпульсною характеристикою. Як показано на рис. 9.6, існує три різних способи отримування локальної рекурсивності або, інакше кажучи, локального введення в мережу динаміки:

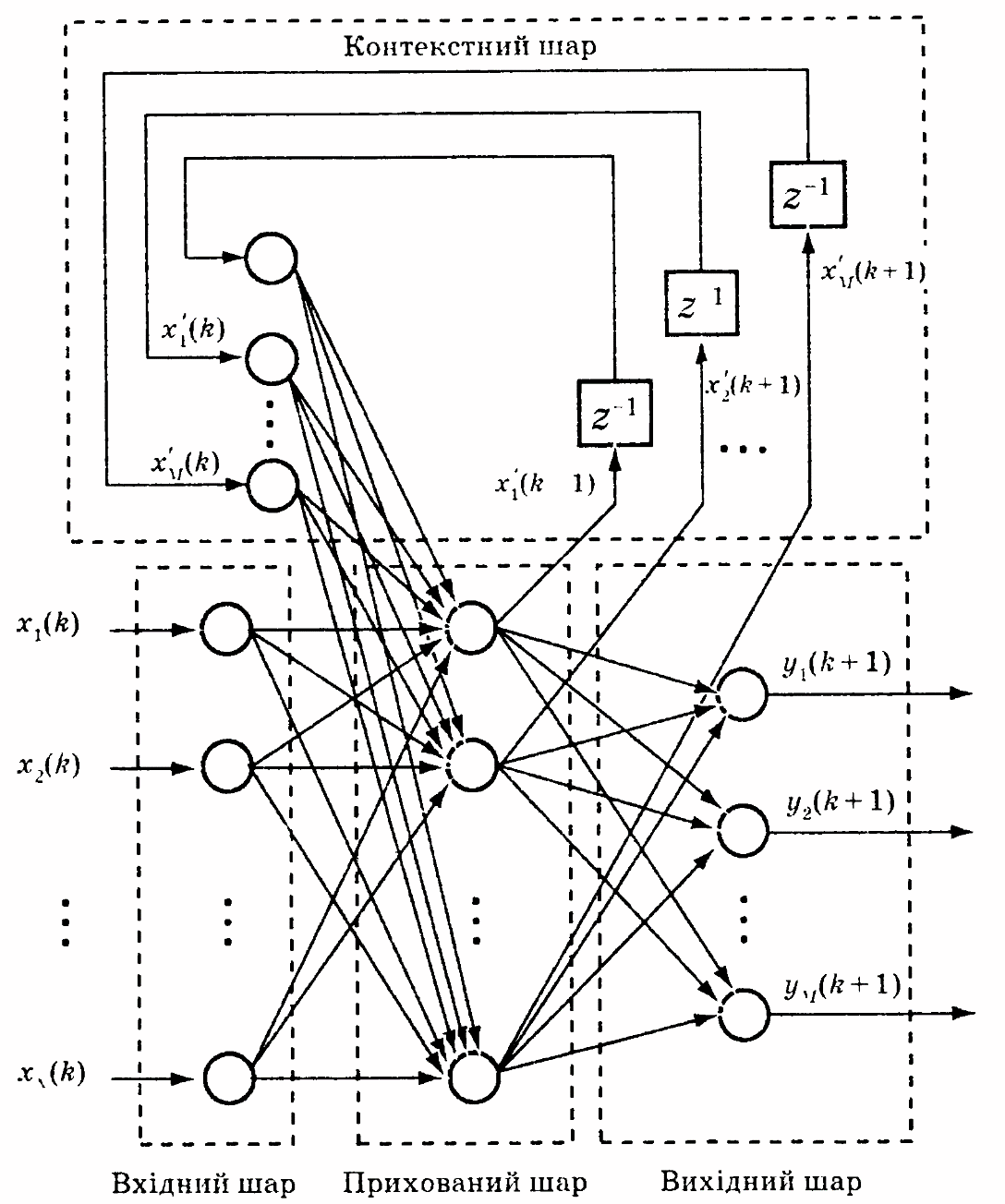

Рис. 9.4 Мережа Елмана

Рис. 9.5. Ієрархічна часткова-рекурсивна мережа

динаміка синапсів, що використовує локальні зворотні зв’язки нейронів (рис. 9.6, а);

«активаційна» динаміка, що є окремим випадком динаміки синапсів і дозволяє у випадку однакових передавальних функцій усіх синапсів одного нейрона істотно спростити структуру мережі; у цьому випадку фільтри, використовувані в синапсах, можуть бути замінені одним фільтром, який має ті ж нулі й полюси та стоїть після операції підсумовування [94] (рис. 9.6, б);

динаміка зворотного зв’язку, реалізована шляхом введення лінійного зворотного зв’язку з виходу нейрона на його вхід (рис. 9.6, в).

Рис. 9.6. Типи локальної рекурсивності

Хоча основою локально-рекурсивних мереж є звичайно багатошаровий персептрон, ці мережі можуть бути також реалізовані й на основі радіально-базисних мереж (див. розділ 15).

9.4. Навчання дрм

Оскільки ДРМ описуються нелінійними рівняннями, для настроювання параметрів цих мереж використовують методи нелінійної оптимізації, серед яких найчастіше застосовують градієнтні методи. Наявність у ДРМ зворотних зв’язків призводить до того, що значення градієнта залежить від попередніх станів мережі. У зв’язку з цим розрізнюють два підходи до розв’язання задачі навчання мережі: застосування алгоритму зворотного поширення помилки й застосування адаптивних алгоритмів, в основі яких лежать рекурентні процедури. Обидва ці підходи використовують градієнтні схеми мінімізації, тобто є звичайними градієнтними методами першого порядку (хоча можуть бути використані й методи більш високих порядків), що відрізняються кількістю використовуваної та збереженої в пам’яті інформації.

9.4.1. Алгоритм зворотного поширення помилки

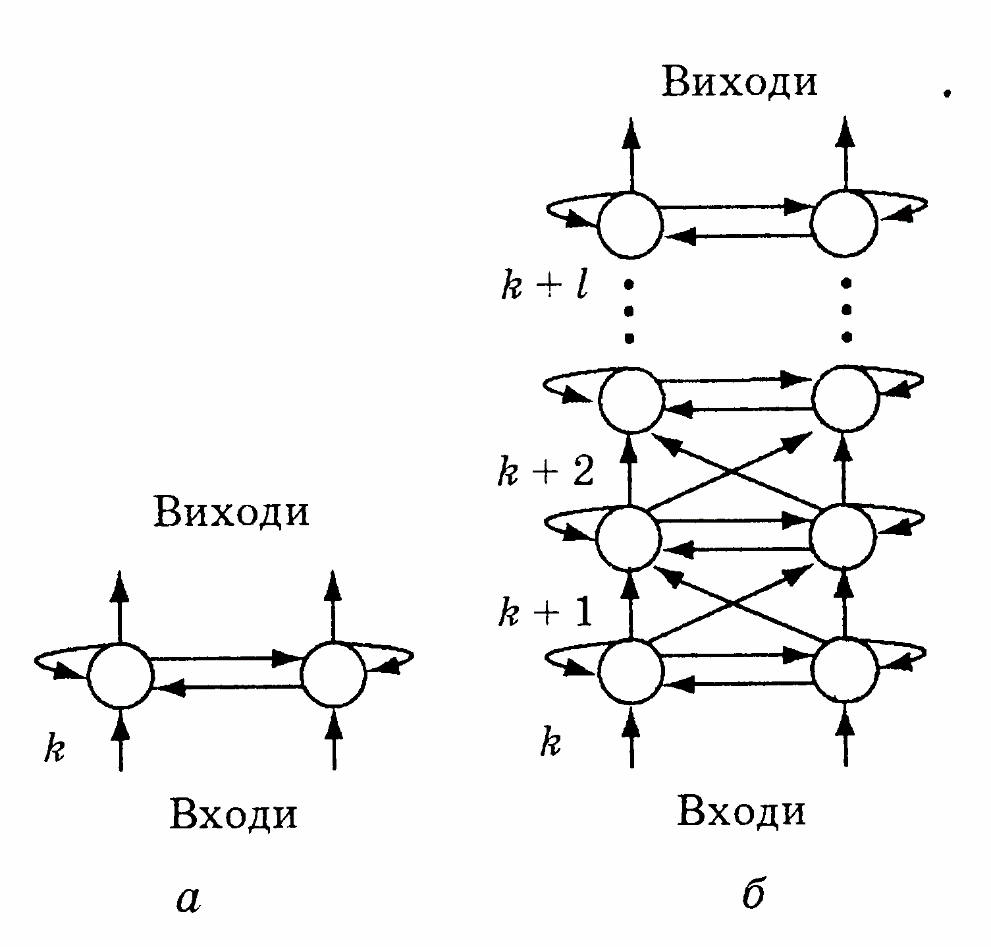

Цей алгоритм запропоновано Д. Румельхартом, Г.Гінтоном і Р. Уільямсом у роботі [19] і використовує подання ДРМ у вигляді багатошарової мережі прямого поширення (БМПП), у якої на кожному такті роботи відбувається збільшення шарів на одиницю. Кожен шар БМПП складається з тієї ж кількості нейронів, що мають ті ж зв’язки, що й вихідна ДРМ. На рис. 9.7, б наведено багатошарову мережу прямого поширення, що розвивається, еквівалентну повнозв’язній ДРМ, яка містить два нейрони (рис. 9.7, а).

Рис. 9.7. Проста повнозв’язна ДРМ (а), еквівалентна БМПП (б), що розвивається в часі

Перший шар такої мережі відповідає стану ДРМ у момент часу k=1.

Очевидно, для навчання мережі може бути застосований алгоритм зворотного поширення помилки, що використовує в будь- який момент часу k (k = 1, 2, ...) обчислення градієнта

де

— шукані параметри мережі;Z(k)

— матриця станів мережі розмірності

n

х k

(n

— кількість станів мережі, k

— кількість попередніх тактів); Х(k)

— матриця вхідних сигналів N

х k

(N — кількість входів).

— шукані параметри мережі;Z(k)

— матриця станів мережі розмірності

n

х k

(n

— кількість станів мережі, k

— кількість попередніх тактів); Х(k)

— матриця вхідних сигналів N

х k

(N — кількість входів).

З (9.9) видно, що для реалізації алгоритму настроювання ваг ю необхідне запам’ятовування великого обсягу інформації, що зростає зі збільшенням кількості тактів навчання k. У зв’язку з цим частіше застосовують модифікації алгоритму зворотного поширення, що полягають у розповсюдженні вихідної помилки не на всі шари, починаючи з вихідного, а на обмежену їх кількість.