- •1. Основные определения.

- •2. Этапы обращения информации.

- •3. Понятие сигнала и его модели.

- •4. Формы представления детерминированных сигналов.

- •5. Представление сигнала в виде взвешенной суммы базисных функций. Понятие дискретного спектра сигнала и спектральной плотности.

- •6. Ортогональное представление сигналов.

- •7. Временная форма представления сигнала.

- •8. Частотная форма представления сигнала.

- •9. Спектры периодических сигналов.

- •10. Распределение энергии в спектре периодичного сигнала.

- •11. Спектры непериодических сигналов.

- •12. Распределение энергии в спектре непериодического сигнала. Равенство Парсеваля.

- •13. Соотношение между длительностью импульсов и шириной их спектра.

- •14. Спектральная плотность мощности детерминированного сигнала.

- •15. Функция автокорреляции детерминированного сигнала.

- •16. Случайный процесс как модель сигнала. Понятие ансамбля и пространства состояний. Виды случайных процессов.

- •17. Вероятностные характеристики случайного процесса.

- •18. Стационарные и эргодические случайные процессы.

- •19. Спектральное представление случайных сигналов.

- •20. Частотное представление стационарных случайных сигналов. Дискретные спектры.

- •21. Частотное представление стационарных случайных сигналов. Непрерывные спектры.

- •22. Основные свойства спектральной плотности.

- •23. Дискретизация непрерывных величин.

- •24. Квантование по времени. Теорема Котельникова.

- •25. Понятие модуляции.

- •26. Амплитудная модуляция.

- •27. Частотная модуляция.

- •28. Фазовая модуляция.

- •29. Модуляция импульсного тока.

- •30. Кодоимпульсные сигналы.

- •31. Многократная модуляция.

- •32. Количество информации в дискретных сообщениях. Энтропия дискретного источника.

- •33. Свойства энтропии.

- •34. Условия энтропии и ее свойства.

- •35. Передача информации от дискретного источника. Частное количество информации.

- •37. Частная условная энтропия. Условная энтропия источника. Апостериорная энтропия источника.

- •38. Количество информации в переданном сообщении дискретным источником.

- •39. Энтропия квантовой величины.

- •40. Количество информации в непрерывном сообщении. Априорная (безусловная) и апостериорная (условная) дифференциальные энтропии. Симметричность выражения количества информации.

- •43. Количество и скорость передачи информации при нормальном распределении сигнала и помехе (погрешности).

- •42. Количество информации, передаваемое за определенное время. Скорость передачи информации.

- •41. Количество передаваемой информации с учетом наличия аддитивной помехи.

- •44. Количество и скорость передачи информации при равномерном распределении сигнала и нормальном распределении помехи (погрешности).

- •45. Дифференциальная энтропия равномерно распределенной погрешности. Энтропийная погрешность.

- •46. Код, кодирование, кодовые сигналы.

- •47. Системы счисления.

- •48. Числовые коды.

- •49. Коды, не обнаруживающие возможных искажений.

- •50. Коды, обнаруживающие ошибки.

- •51. Информационная способность кода и избыточность.

- •52. Коды с коррекцией искажений.

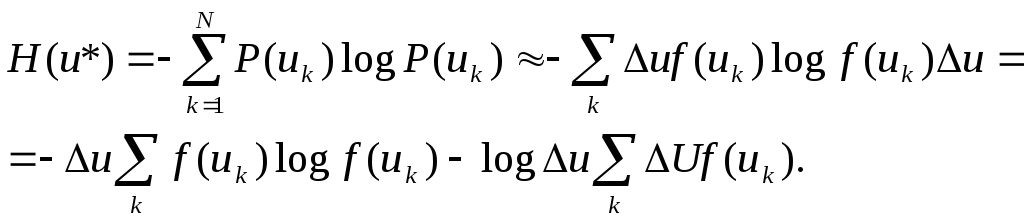

39. Энтропия квантовой величины.

Энтропия квантовой величины u*

По условию нормирования

![]()

тогда

![]()

40. Количество информации в непрерывном сообщении. Априорная (безусловная) и апостериорная (условная) дифференциальные энтропии. Симметричность выражения количества информации.

При

![]() второе

слагаемое стремится к бесконечности.

Таким образом, предельный переход не

позволяет ввести понятие энтропии

переданного сообщения. Однако при

определении количества информации для

случая, когда сигнал искажен шумами

(помехами), нужно из безусловной энтропии

H(U)

вычесть среднюю условную HW(Z).

В этом случае при квантовании “u”

и “”

с одинаковым шагом

второе

слагаемое стремится к бесконечности.

Таким образом, предельный переход не

позволяет ввести понятие энтропии

переданного сообщения. Однако при

определении количества информации для

случая, когда сигнал искажен шумами

(помехами), нужно из безусловной энтропии

H(U)

вычесть среднюю условную HW(Z).

В этом случае при квантовании “u”

и “”

с одинаковым шагом

![]() получается, что энтропия соответствующих

квантовых величин H(u*)

HW*(U*)

имеют одинаковые составляющие -

получается, что энтропия соответствующих

квантовых величин H(u*)

HW*(U*)

имеют одинаковые составляющие -

![]() ,

которые при вычитании взаимно

компенсируются. Предельный переход при

,

которые при вычитании взаимно

компенсируются. Предельный переход при

![]() дает

дает

![]()

Величину

![]() (36)

(36)

называют априорной (безусловной) дифференциальной энтропией непрерывной величины U.

Величину

![]() (37)

(37)

называют апостериорной (условной) дифференциальной энтропией.

Соответственно количество информации есть разность априорной и апостериорной дифференциальной энтропии

![]() (38)

(38)

Аналогично можно получить выражение

![]() . (39)

. (39)

Заметим, что величина дифференциальной энтропии зависит от того, в каких единицах выражена величина переменной. Разность энтропий от этого не зависит, если только величины одинаковы.

Докажем симметричность этого критерия, т.е. что в величине содержится столько же информации о величине “u”, сколько в величине “u” – о величине . Как и в предыдущем случае, возьмем за основу соотношения, полученные для объектов с дискретными состояниями. Преобразуем формулу (29) для частного количества информации I(ui):

![]()

Подставляя полученное выражение в (34) получим:

![]()

Далее найденную

формулу применим к непрерывным величинам

“u”

и “”,

подвергнув их квантованию с шагом

![]() ,

и совершив затем предельный переход

при

,

и совершив затем предельный переход

при

![]() .

.

Тогда получим

![]() (40)

(40)

Во многих случаях принимаемую (воспроизводимую) величину можно представить как сумму передаваемой (измеряемой) величины “u” и некоторой помех “S”:

![]() (41)

(41)

причем помеха часто

не зависит от “u”.

В этом случае условная дифференциальная

энтропия

![]() равна безусловной энтропии помехи

равна безусловной энтропии помехи

![]() .

Покажем это. По аналогии с (37)

.

Покажем это. По аналогии с (37)

![]() (42)

(42)

Рассмотрим выражение

в квадратных скобках под интегралом в

правой части формулы (42). Заменим

переменную

в соответствии с (41). При этом

![]() .

Будем иметь в виду, что данный интеграл

вычисляется для фиксированного значения

“u”:

.

Будем иметь в виду, что данный интеграл

вычисляется для фиксированного значения

“u”:

![]()

Если значение “u”

фиксировано, то условная вероятность

обращается в безусловную, т.е.

![]() .

.

![]()

Тогда

![]()

но интеграл в правой

части последнего выражения равен

единице:

![]() .

Поэтому

.

Поэтому

![]() (43)

(43)

Формула (39) с учетом (43) имеет вид

![]() (44)

(44)

Предполагаем, что при вычислении обеих энтропий – принимаемого сигнала и помехи – величины и S выражаются в одинаковых единицах.

43. Количество и скорость передачи информации при нормальном распределении сигнала и помехе (погрешности).

Если измеряемая величина “u” и помеха S имеют нормальные распределения, то их сумма также имеет нормальное распределение. Дифференциальная энтропия нормально распределенной величины “u”, вычисленная по формуле (36)

Максимальной

дифференциальной энтропией обладает

равномерное распределение вероятностей.

Если значения случайной величины U

лежат в пределах[,

].![]()

где D(u) – дисперсия величины “u”.

Соответственно

![]()

![]()

Подставляя эти величины в (44), получаем

![]() (45)

(45)

Как известно, дисперсия сигнала пропорциональна его средней мощности, которую обозначим Pu, а среднюю мощность помехи PS. Тогда

![]() (46)

(46)

Отметим еще раз, что эта формула справедлива для случая, когда помеха является аддитивной и не зависит от сигнала, а законы их распределения – нормальные.

До сих пор не учитывалось, что “u” есть функция времени, а рассматривалась передача отдельных сообщений о значениях некоторой непрерывной величины “u”. При этом величина I(UW) трактовалась как среднее количество информации, содержащееся в одном принятом значении . Подразумевалось, что усреднение проводится по ансамблю всех возможных значений “u” и с учетом законов распределения каждой из них отдельно и обеих вместе.

Теперь перейдем к рассмотрению передачи случайной функции времени (случайного процесса) u(t) по каналу, в котором действует случайный шум S(t).

Пусть частотный

спектр процесса u(t)

ограничен частотой Fmax,

а ширина полосы частот канала связи не

меньше Fmax.

Согласно теореме Котельникова, указанный

процесс u(t)

полностью определяется последовательностью

ординат взятых с интервалом

![]() .

Ординаты, отстающие одна от другой на

величину Т,

статистически взаимно независимы.

Поэтому общее количество информации,

содержащееся в принятом сообщении,

равно сумме количеств информации,

содержащихся в этих отдельных ординатах.

В сообщении длительностью Тс

содержится 2ТСFmax

таких ординат. Среднее количество

информации в принятом сообщении

длительностью ТС

равно

.

Ординаты, отстающие одна от другой на

величину Т,

статистически взаимно независимы.

Поэтому общее количество информации,

содержащееся в принятом сообщении,

равно сумме количеств информации,

содержащихся в этих отдельных ординатах.

В сообщении длительностью Тс

содержится 2ТСFmax

таких ординат. Среднее количество

информации в принятом сообщении

длительностью ТС

равно

![]()