- •Лекция №1. Теория информации.

- •1.2 Основные понятия комбинаторики.

- •1.3 Случайные модели в теории информации.

- •1.4 Основные понятия теории информации

- •Этапы обращения информации:

- •Практическое занятие

- •Лекция №2. Меры информации

- •1.Энтропия всегда неотрицательна.

- •3.Энтропия сообщения максимальна, если события равновероятны.

- •4.Энтропия аддитивна.

- •Аксиомы Хинчена

- •Аксиомы Фадеева

- •2.4 Понятие совместной энтропии.

- •Лекция №3 .Источники информации и их энтропия.

- •Лекция №4 оптимальное и эффективное кодирование

- •4.3.3. Арифметическое кодирование.

- •Лекция № 5 помехоустойчивое кодирование

- •5.1 Классификация помехоустойчивых кодов.

- •5.2 Параметры (характеристики) помехоустойчивых кодов и их границы. Корректирующие свойства кодов.

- •0 Запрещенные кодовые комбинации00

- •5.3.Линейные (систематические) коды.

- •5.3.1.Механизмы кодирования и синдромного декодирования.

- •100 → Ошибка в b1,

- •5.3.2. Матричное представление линейных (систематических) кодов.

Лекция №2. Меры информации

Классификация мер информации.

В зависимости от направлений исследований теории информации различают её меры, а именно:

Структурные

Синтаксические

Семантические

Прагматические

Прагматическая мера информации определяет полезность или ценность этой информации для достижения пользователем своих целей. Например, емкость памяти, производительность ПК и т.п.

Семантическая мера основывается на понятии содержания информации. Единицей измерения этой меры является тезаурус ( совокупность сведений, которыми располагает пользователь или система).

Структурная мера информации определяется подходом к оценке особенности структуры сообщений. Среди структурных мер различают: геометрическую, комбинаторную, аддитивно-логарифмическую. Геометрической мерой определяется потенциальное (максимально возможное) количество информации в заданной структуре сообщения. Это количество называют информационной емкостью исследуемой части ИС. Информационным элементом в геометрической мере является квант как неделимая часть информации, т.е. информационную емкость можно представить числом, показывающим, какое количество квантов содержится в полном массиве информации.

X

T

N-массив

информации; ![]() ;

;

![]() ,

,

![]() ,

,

![]()

![]()

Комбинаторной мере используют различные комбинаторные конфигурации, заданных множеств элементов в случае, если требуется оценить возможности передачи информации с помощью таких комбинаторных комбинаций.

Количество информации в комбинаторной мере вычисляется как количество комбинаций элементов. Образование комбинаций в структуре комбинационных элементов есть одна из форм кодирования информации. С помощью комбинаторных мер оценке подвергается комбинаторное свойство потенциального структурного разнообразия комплексов. Комбинирование элементов в информационных комплексах базируется на основных понятиях комбинаторики.

В отличие от геометрической меры комбинаторная - это не просто подсчет квантов, а определение количества возможных (осуществимых) комбинаторных элементов.

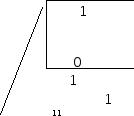

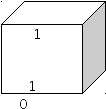

В прикладной теории информации для представления структуры информационного комплекса используется следующее понятие:

Ч

исловое

гнездо

исловое

гнездо

h

-глубина кода (основание системы

счисления)

h

-глубина кода (основание системы

счисления)

l- длина кода

(размерность кода или кодового слова)

1.Глубина (или основа кода) h- это количество различных элементов или знаков, содержащихся в алфавите кодирования, т.е. объем алфавита одного разряда кодового слова. Полный алфавит занимает одно числовое гнездо.

2. Длина кода l- это число гнезд, т.е. количество повторений алфавита, необходимых и достаточных для представления чисел нужной размерности.

h= 2; 8; 10; 16; …

l= 16; 32; 64; ….

В общем случае информационная емкость определяется числом размещений из h по l:

![]()

Мера информации по Хартли:

![]()

Для практического удобства использования комбинаторной меры Хартли ввел аддитивно- логарифмическую меру информации, позволяющую вычислить количество информации в двоичных единицах. Единица измерения этого количества информации - бит.

Один разряд двоичного кода может нести информацию равную 1-му биту или 1 бит – это количество информации, заключенное в одном событии, которое может произойти, а может и не произойти. Аддитивность меры Хартли заключается в том, что она позволяет производить суммирование количество информации отдельных элементов информационного комплекса (как по разрядам, так и по числу гнезд).

Если

принять, что log2h=I1,то

Ix=l![]() Ix

Ix

Синтаксическая (статистическая) мера определяется, как правило, вероятностными характеристиками элементами сообщения. Направление статистической теории информации дает оценки информационной системы в конкретных проявлениях. В качестве меры информации используют понятие энтропии.

Энтропия- мера неопределенности , учитывающая вероятность появления некоторого события, а ,следовательно, информативность этого события. Частые ожидаемые события несут мало информации, а редкие события, наоборот, обладают высоким информационным содержанием. Следовательно, количество информации или вероятность события находятся в обратно пропорциональной зависимости.

Энтропия вероятностной схемы. Основные свойства энтропии.

Аксиомы Хинчена и Фадеева.

Простейший дискретный источник сообщений можно представить вероятностной схемой событий.

X

=![]() ,

причем

,

причем![]() ,

,

,

,![]() .

.

Для заданной схемы справедливыми будут считаться аксиомы:

Информация одиночного события

, происходящего с вероятностью pi

имеет положительное значение:

, происходящего с вероятностью pi

имеет положительное значение:

![]()

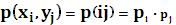

Имеет место для случая объединенной вероятностной схемы, например для X и Y, тогда совместная информация двух независимых событий xi и yj, которые обладают совместной плотностью вероятности

,

будет иметь вид:

,

будет иметь вид:

![]()

Информация I(pi) - это есть непрерывная функция от вероятности.

Аксиомы 1 и 2 подтверждают как бы то, что информация нескольких событий не может взаимно уничтожиться.

Аксиома 3 говорит о том, что при изменении вероятности события количество информации в нем неминуемо изменится.

Из этих аксиом следует, что информация является логарифмической функцией от вероятности.

![]()

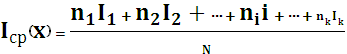

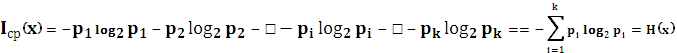

Вернемся к простейшему дискретному источнику, заданному вероятностной схемой, для которого найдем среднее значение информации виде:

,

,

где ni- частота появления i-го события в заданном множестве X;

k- количество разных событий;

Ii- количество информации i-го события

Но

если ![]() ,

тогда получим:

,

тогда получим:

Энтропия события:

Свойства энтропии: