cl-Ast-informatikaУЧЕБНОЕ ПОСОБИЕ

.pdf

синоним computer science (наука о компьютерной технике). Оба термина употребляются в эквивалентном смысле. Термин "информатика" используется не только для отображения достижений компьютерной техники, но и связывается с процессами передачи и обработки информации.

В1983 г. на сессии годичного собрания Академии наук СССР было принято решение об организации нового отделения информатики, вычислительной техники и автоматизации. Информатика трактовалась как "комплексная научная и инженерная дисциплина, изучающая все аспекты разработки, проектирования, создания, оценки, функционирования основанных на ЭВМ систем переработки информации, их применения

ивоздействия на различные области социальной практики".

Всамом общем смысле под информатикой понимают фундаментальную естественную науку, изучающую процессы передачи, накопления и обработки информации.

Известно определение информатики, данное Международным конгрессом в Японии в 1978 г.: «Понятие информатики охватывает области, связанные с разработкой, созданием, использованием и материально-техническим обслуживанием систем обработки информации, включая машины, оборудование, математическое обеспечение, организационные аспекты, а также комплекс промышленного, коммерческого, административного, социального и политического воздействия».

Ядро информатики определяют три связанные между собой части: алгоритмические (Brainware), программные (Software) и технические средства (Hardware).

Hardware — это устройства, имеющиеся в компьютере.

Software — это совокупность всех программ, используемых на компьютере. Brainware — это то, что должен знать и уметь делать пользователь, чтобы

правильно решать задачи.

Информатика как отрасль народного хозяйства включает:

•производство технических средств;

•производство программных продуктов;

•разработку технологий переработки информации.

Информатика как фундаментальная наука включает:

•методологию создания информационного обеспечения;

•теорию информационных систем.

Информатика как прикладная дисциплина включает:

•изучение закономерностей в информационных процессах;

•создание информационных моделей коммуникаций;

•разработку информационных систем и технологий.

Информатика — это область человеческой деятельности, связанная с процессами преобразования информации с помощью компьютеров и их взаимодействием со средой применения.

Главная функция информатики — разработка методов и средств преобразования информации и их использование в организации технологического процесса переработки информации.

Задачи информатики:

•исследование информационных процессов любой природы;

•разработка информационной техники; создание новейшей технологии переработки информации на базе полученной в результате исследования информационных процессов;

•решение научных и инженерных проблем создания, внедрения и эффективного использования компьютерной техники и технологии во всех сферах общественной жизни.

10

Таким образом, информатика является комплексной естественнонаучной дисциплиной. Это динамичная область знаний, постоянно развивающаяся и пополняющаяся новыми направлениями. Она предоставляет методы и средства исследования другим областям.

1.5 ИНФОРМАЦИЯ: СВОЙСТВА, КАЧЕСТВО

Причина стремительного развития информатики состоит в том, что научная информация, свойства и закономерности ее распространения приобретают в современном мире исключительно важное значение. В условиях научно-технической революции информация является одним из национальных ресурсов, которые определяют социальноэкономическое развитие страны. Эффективное использование информации, умение грамотно ее обрабатывать, искать, отбирать, анализировать выходят на первый план.

В современных условиях, когда объем необходимых для человека знаний резко и быстро возрастает важно развить умение самостоятельно пополнять свои знания, ориентироваться в потоке информации. С одной стороны, чем больше информации, тем увереннее чувствует себя человек, тем больше его возможности и тем выше степень комфорта. А с другой стороны информация подвергает серьезному испытанию организм человека, все больше «переключая» его с физической деятельности на умственную, информационного характера, что требует большого напряжения. Информационные перегрузки не менее страшны для организма, чем перегрузки физические.

Знание — сила, а информация — источник этой силы. Всем, что имеет человек сейчас, он обязан своему умению воспринимать и обрабатывать информацию. Вся история становления и развития человека сопровождалась совершенствованием этого умения и ростом объема информации, накопленной обществом.

По данным ЮНЕСКО, в начале XIX в. во всем мире выходило около 100 периодических научных изданий. К 1850г. количество периодических изданий увеличилось до 1000, к 1900г. превысило 10000, а теперь, по оценке некоторых специалистов, оно приближается к 100 000.

Более половины накопленной человечеством информации приходится на долю отчетов, докладов, меморандумов и т.д. Огромные объемы информации хранятся на магнитных лентах, микрофильмах, формулярах и т.д.

Основную опасность таят в себе не потоки информации сами по себе, а их соотношение с возможностями человека по их обработке. Прогресс человечества немыслим без возрастания объемов информации, однако рост ее становится помехой прогрессу, что проявляется в информационном кризисе. Быстро увеличивающиеся потоки информации все труднее обрабатывать, в результате обычным явлением стало дублирование разработок.

Необходимы не просто знания, но и знания о знании, и информация об информации. Множество научных дисциплин изучают различные аспекты понятия информации, все, что так или иначе связано с этим понятием.

Увеличение количества информации связано с повышением сложности системы, с ее прогрессивным развитием.

По данным некоторых исследований, при переходе от атомного уровня к молекулярному количество информации увеличивается в 103 раза. Количество информации, относящейся к организму человека, примерно в 1011 раз больше информации, содержащейся в одноклеточном организме.

Термин информация происходит от латинского informatio, что означает разъяснение, осведомление, изложение. Информация есть отражение реального мира с помощью сведений (сообщений).

Информация — это сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают имеющуюся о них степень неопределенности, неполноты знаний.

11

Сообщение — это реальная форма представления информации в виде речи, текста, изображения, цифровых данных, графиков, таблиц и т. п.

Наряду с информацией в информатике часто употребляется понятие данные. Данные могут рассматриваться как признаки или записанные наблюдения, которые по каким-то причинам не используются, а только хранятся. Если появляется возможность использовать эти данные для уменьшения неопределенности о чем-либо, то они превращаются в информацию. Таким образом, информацией являются используемые данные.

Как объект преобразования и использования, информация обладает тремя основными свойствами:

1.Синтаксис определяет способ представления информации на носителе (например, параметры шрифта документа, формат бумаги).

2.Семантика определяет смысл информации и может рассматриваться как соглашение о правилах ее интерпретации (например, дорожные знаки).

3.Прагматика определяет влияние информации на поведение потребителя (например, успешная сдача экзамена по вождению автомобиля после изучения правил дорожного движения).

1.5.1 Потребительские показатели качества информации

Репрезентативность связана с правильностью отбора информации в целях адекватного отражения свойств объекта. Нарушение репрезентативности информации приводит нередко к существенным ее погрешностям.

Содержательность отражает семантическую емкость информации. Это отношение количества семантической информации в сообщении к объему обрабатываемых данных С=IC /VD

Коэффициент информативности — это отношение количества синтаксической информации (по Шеннону) к объему данных Y=I/ VD.

Достаточность (полнота) информации означает, что она содержит минимальный, но достаточный для принятия правильного решения набор показателей.

Понятие полноты информации связано с ее смысловым содержанием (семантикой) и прагматикой. Как неполная так и избыточная информация снижают эффективность принимаемых пользователем решений.

Доступность информации обеспечивается выполнением соответствующих процедур ее получения и преобразования.

Актуальность информации определяется степенью ценности информации в момент ее использования. Зависит от динамики изменения ее характеристик и от интервала времени, прошедшего с момента возникновения данной информации.

Своевременность информации означает ее поступление не позже заранее назначенного момента времени, который согласован со временем решения поставленной задачи.

Точность информации определяется степенью близости получаемой информации к реальному состоянию объекта, процесса, явления и т. п.

Достоверность определяется свойством информации отражать реально существующие объекты с необходимой точностью.

Устойчивость отражает способность информации реагировать на изменения исходных данных без нарушения необходимой точности.

1.6 ИНФОРМАЦИЯ: КОЛИЧЕСТВО, МЕРА

Для потребителя информации очень важной характеристикой является ее адекватность. Адекватность информации — это уровень соответствия создаваемого с помощью полученной информации образа реальному объекту, процессу, явлению.

В реальной жизни всегда присутствует некоторая степень неопределенности. Л. Бриллюэн охарактеризовал информацию как отрицательную энтропию. Так как

12

энтропия является мерой неупорядоченности, то информация может быть определена как мера упорядоченности материальных систем.

Пусть потребитель имеет предварительные сведения о системе α до получения информации. Н (β) — мера его неосведомленности о системе (или мера неопределенности состояния системы). Iβ(α) — дополнительная информация после получения сообщения β, уменьшившая неопределенность состояния системы Нβ(α).

Количество информации о системе, полученной в сообщении β:

Iβ(α) = Н(α) - Нβ(α)

Другими словами, количество информации измеряется изменением неопределенности состояния системы. Энтропия системы Н(α) может рассматриваться как мера недостающей информации.

От степени адекватности информации реальному состоянию объекта или процесса зависит правильность принятия решений человеком. Для измерения информации вводятся параметры: I — количество информации, VD — объем данных.

Синтаксическая адекватность отражает формально-структурные характеристики информации и не затрагивает ее смыслового содержания. Учитываются тип носителя, способ представления информации, скорость передачи и обработки, надежность и точность преобразования информационных кодов. Информацию, рассматриваемую только с синтаксических позиций, обычно называют данными.

Семантическая (смысловая) адекватность определяет степень соответствия образа объекта и самого объекта; предполагает учет смыслового содержания информации. Эта форма служит для выявления смысла, содержания информации и ее обобщения. Количество информации IC=CVD, где C — коэффициент содержательности.

Прагматическая (потребительская) адекватность отражает отношение информации и ее потребителя. Учитывается ценность, полезность использования информации при выработке потребителем решения для достижения своей цели.

Так как информация может пониматься и интерпретироваться в различных предметных областях по-разному, то различаются и способы определения ее количества.

Количество информации — числовая величина, характеризующая информацию по разнообразию, сложности, упорядоченности, определенности и т.п.

Если рассматривается некоторая система, которая может принимать одно из n возможных состояний, то актуальной задачей является задача оценки этого выбора, исхода. Такой оценкой может стать мера информации (события).

Мера — непрерывная действительная неотрицательная функция, определенная на множестве событий. Меры могут быть статические и динамические, в зависимости от того, какую информацию они позволяют оценивать: статическую (оценка сообщения без учета ресурсов и формы получения) или динамическую (оценка затрат ресурсов для получения информации).

1.6.1 Мера Р. Хартли

Пусть имеется N состояний системы S. Если каждое состояние системы закодировать кодами длины d, то эту длину необходимо выбрать так, чтобы число всех различных комбинаций было больше или равно N. Наименьшее число, при котором это возможно, называется мерой разнообразия множества состояний системы и задается формулой H=klogаN, где k — коэффициент пропорциональности, а — основание системы меры. Если N — число возможных равновероятных исходов, то величина klnN представляет собой меру нашего незнания о системе.

Система |

Формула Хартли |

Единица измерения |

Экспоненциальная |

k=1, H=lnN |

Нат |

Двоичная |

k=1/ln2, H=log2N |

Бит |

Десятичная |

k=1/ln10, H=lgN |

Дит |

13

Пример 1. Чтобы узнать положение точки в системе из 4-х клеток необходимо задать два вопроса ("Левая или правая клетка?"). В итоге, узнав положение точки, мы увеличиваем суммарную информацию о системе на 2 бита (I=log24).

Пример 2. Имеются 200 монет. Известно, что одна из них — фальшивая и более легкая по весу. За сколько взвешиваний можно выявить ее? Предположим, что на весы кладется равное количество монет. Тогда получим 3 независимые возможности: а) левая чашка ниже; б) правая чашка ниже; в) чашки уравновешены. Таким образом, каждое взвешивание дает количество информации I=log23. Следовательно, для определения фальшивой монеты нужно сделать не менее k взвешиваний, где наименьшее k

удовлетворяет условию log23k log2200. Отсюда, k

log2200. Отсюда, k 5.

5.

Формула Хартли не работает в случае различных состояний системы.

1.6.2. Мера К. Шеннона

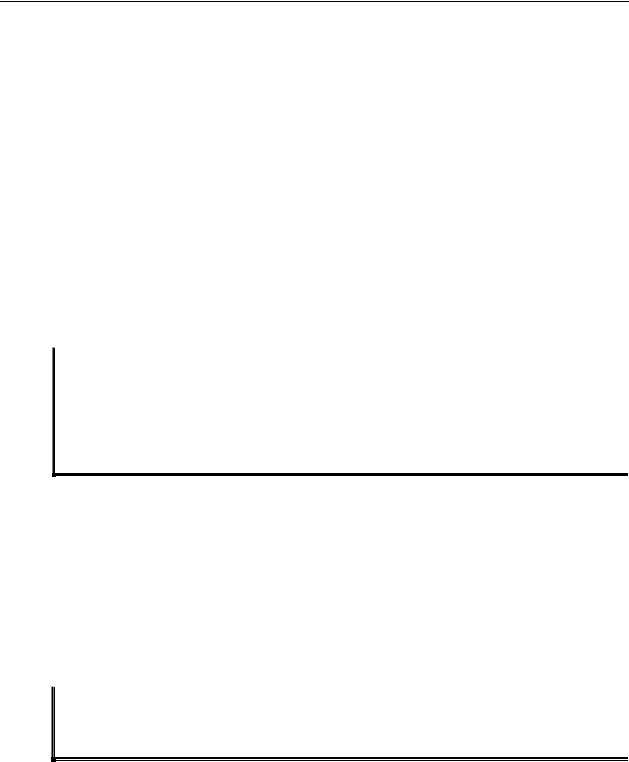

Формула Шеннона дает оценку информации независимо от ее смысла:

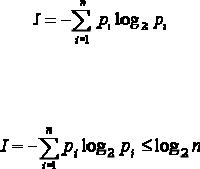

где n — число состояний системы; рi — вероятность (относительная частота) перехода системы в i-е состояние (сумма всех pi равна 1). Для равновероятных состояний рi=1/n, I=log2n.

В общем случае выполняется неравенство

Сообщение о наступлении события с меньшей вероятностью несет в себе больше информации, чем сообщение о наступлении события с большей вероятностью. Сообщение о наступлении достоверно наступающего события несет в себе нулевую информацию.

Пример 1. Определить, сколько бит информации несет произвольное двузначное десятичное число со всеми значащими цифрами (каждая из возможных цифр может появиться на данном месте, в данном разряде с одинаковой вероятностью). Так как таких чисел может быть всего 90 (10-99), то количество информации будет I=log290 (приблизительно I=6,5). Так как в двузначных числах первая значащая цифра может принимать 9 значений (1-9), а вторая — 10 значений (0-9), то I=log290=log29+log210. Итак, сообщение в одну десятичную единицу несет в себе в 3,32 (значение log210) больше информации, чем в одну двоичную единицу (чем log22=1). Вторая цифра в двузначном десятичном числе несет в себе больше информации, чем первая.

Количество информации I можно понимать как среднеарифметическое величин fi=-nlog2pi.Тогда fi можно интерпретировать как информационное содержание символа алфавита с индексом i и величиной pi вероятности появления этого символа в сообщении, передающем информацию.

Пример 2. Определить количество информации в сообщении из 4-х букв "a", 2-х букв "б", 1-й буквы "и", 6-ти букв "р". Число N различных сообщений длиной 13 букв будет равно величине: N=13!/(4!×2!×1!×6!)=180180. Количество информации I в одном сообщении будет равно величине: I=log2(N)=log2180180≈18 (бит).

Нулевой энтропии соответствует максимальная информация. Основное соотношение между энтропией и информацией определяется как I+S(log2e)/k=const.

При переходе от состояния S1 с информацией I1 к состоянию S2 с информацией I2 возможны варианты уничтожения информации (S1 < S2, I1 >I2), сохранения информации

(S1 = S2, I1 = I2), рождения новой информации (S1 > S2, I1 < I2).

Формула Шеннона учитывает различность, но не различает состояния, то есть, не может оценивать состояния сложных систем. Теория Шеннона разработана как теория передачи данных по каналам связи, а мера Шеннона — как мера количества данных и не отражает семантического смысла.

14

1.6.3. Термодинамическая мера

Информационно-термодинамический подход связывает величину энтропии системы с недостатком информации о внутренней структуре. Число состояний определяет степень неполноты сведений о системе.

Пусть дана термодинамическая система (процесс) S, а Н0, Н1 — термодинамические энтропии системы S в начальном (равновесном) и конечном состояниях термодинамического процесса. Тогда термодинамическая мера информации (негэнтропия) определяется формулой: Н(Н0,Н1)=Н0 - Н1. Уменьшение Н(Н0,Н1) говорит о приближении термодинамической системы S к состоянию статического равновесия, а увеличение — об удалении.

Пусть до начала процесса можно дать p1 равновероятных ответов на вопрос о состоянии термодинамической системы, а после окончания процесса — p2 ответов. Изменение информации определяется выражением ∆I=k ln(p1 / p2)=k (ln p1 - ln p2 ).

Если p1>p2 (∆I>0), то сведения о системе стали более определенными. Если p1<p2 (∆I<0) — менее определенными.

Пример. Имеется термодинамическая система — газ в объеме V , который расширяется до объема 2V. Каковы координаты молекулы m газа в новом объеме? До расширения объема координаты были известны p1=1 (lnp1=0). Число ответов было пропорционально lnV. После расширения мы знаем эту координату по изменившейся информации о состоянии системы как ∆I = -k ln(2V /V) = -k ln 2 (нат).

Величина ∆I может быть интерпретирована как количество информации, необходимой для перехода от одного уровня организации системы к другому (при ∆I>0

— более высокому, а при ∆I>0 — более низкому уровню организации).

1.6.4. Энергоинформационная (квантово-механическая) мера

Энергия и информация являются фундаментальными характеристиками систем реального мира, связывающие их по вещественным, пространственным, временным характеристикам. Пусть А — именованное множество "энергетического происхождения", а В — именованное множество "информационного происхождения". Определим

энергоинформационную меру как f: A B.

B.

Пример. Процесс деления клеток сопровождается излучением квантов энергии с частотами приблизительно до N=1.5×1015 Гц. С помощью этого спектра можно закодировать до 1015 различных биохимических реакций. Количество информации на один квант энергии: I=log21015≈50 бит.

1.7 КЛАССИФИКАЦИЯ ИНФОРМАЦИИ

1. По месту возникновения

•входная;

•выходная.

Одна и та же информация может являться входной для одного объекта, а для другого — выходной. По отношению к объекту управления информация может быть определена как внутренняя и внешняя.

2. По полноте

•избыточная;

•достаточная;

•недостаточная.

3. По стадии использования

•первичная — это информация, которая возникает непосредственно в процессе деятельности объекта и регистрируется на начальной стадии;

•вторичная — это информация, которая получается в результате обработки первичной информации и может быть промежуточной и результирующей;

•промежуточная информация используется в качестве исходных данных для последующих расчетов;

15

• результирующая информация получается в процессе обработки первичной и промежуточной информации.

4. По способу отображения

• текстовая — это совокупность алфавитных, цифровых и специальных символов, с помощью которых представляется информация на физическом носителе;

• графическая — это различного рода графики, диаграммы, схемы, рисунки;

• звуковая.

5. По стабильности

•переменная — отражает физические количественные и качественные характеристики (например, количество производственной продукции за смену, количество исправных станков и т. п.);

•постоянная (условно-постоянная) — это неизменная и многократно используемая в течение длительного периода времени информация; может быть справочной, нормативной, плановой.

6. По функциям управления (экономическая информация)

•плановая — информация о параметрах объекта управления на будущий

период;

•нормативно-справочная — различные нормативные и справочные данные; обновление происходит достаточно редко;

•учетная — это информация, которая характеризует деятельность фирмы за прошлый период времени;

•оперативная (текущая) информация — это информация, используемая в оперативном управлении и характеризующая производственные процессы в текущий период времени.

7. По отношению к управлению системой

•управляющая;

•советующая;

•преобразующая.

8. По характеру использования

•статистическая;

•коммерческая;

•научная;

•учебная;

•методическая.

1.8 ИНФОРМАЦИОННЫЙ ПРОЦЕСС

Под информационными процессами понимаются любые действия, выполняемые над информацией. При работе с информацией всегда имеется ее источник и потребитель. Информационные коммуникации — это пути и процессы, обеспечивающие передачу сообщений от источника информации к ее потребителю. В общем представлении информационный процесс включает:

•хранение данных (объем информации, надежность, время доступа);

•передачу данных (скорость, пропускная способность, защита от шума);

•обработку данных (математические вычисления, логические рассуждения, поиск, кодирование).

Информационный поиск — это процесс отыскания в каком-то множестве документов тех, которые соответствуют указанной в информационном запросе теме или содержат необходимые потребителю факты, сведения.

Информационный поиск осуществляется при помощи информационно-поисковых систем (ИПС), для применения которых необходима систематизация и классификация документов. Классифицировать документы можно по отрасли науки, виду документа,

16

автору или по другому признаку. Одной из самых распространенных классификаций в настоящее время является универсальная десятичная классификация (УДК).

Все знания, накопленные человечеством, разбиты в УДК на 10 классов:

0.Общий отдел;

1.Философия;

2.Религия;

3.Общественные науки;

4.Свободный отдел;

5.Математика. Естественные науки;

6.Прикладные знания. Медицина. Техника;

7.Спорт. Фотография. Зрелища;

8.Языкознание. Филология. Художественная литература. Литературоведение;

9.Краеведение. География. Биография. История.

Каждый из этих 10 классов делится на 10 подклассов, затем еще на десять и т.д., образуя иерархию. Иерархия — это такое отношение, при котором один класс является подклассом другого, более широкого.

Для обозначения классов и подклассов в УДК применены арабские цифры. Эта классификация применяется более чем в 50 странах. Наряду с УДК, в нашей стране широко используются библиотечно-библиографическая классификация (ББК), международная классификация изобретений (МКИ), классификаторы промышленной продукции и т.д.

Информационный процесс может проходить только в системе, в которой присутствует человек, например, процессы познания, обучения, управления. Основой информационных процессов является информационное взаимодействие — это взаимодействие между людьми посредством передачи данных, в результате которого происходят изменения в ощущениях, мнениях, представлениях, знаниях.

1.9 ИНФОРМАЦИОННЫЕ СИСТЕМЫ

Система — это совокупность элементов, находящихся в отношениях и связях между собой и образующих определенную целостность. Система создается для описания каких-то процессов. Если процесс информационный, то система обязательно должна включать людей, например, система образования, система экономики, правовая система.

Информационная система — это взаимосвязанная совокупность средств, методов и персонала, используемых для хранения, обработки и выдачи информации в интересах достижения поставленной цели. Это система, направленная на получение новых знаний людьми – участниками этой системы.

Основные свойства информационных систем

•сбор, хранение, обработка информации;

•ориентация на конечного пользователя-непрофессионала в области вычислительной техники.

Одна из задач информатики — показать, что в информационных системах источником данных является человек. Другая задача — научить человека мыслить системно во взаимосвязи событий и явлений. Эти вопросы касаются информационной культуры человека.

Основные правила организации информации для управления системой

заключаются в выяснении:

•формы и структуры входной информации;

•средств, форм передачи и источников информации;

•формы и структуры выходной информации;

•надежности информации и организации контроля достоверности;

•форм использования информации для принятия решений.

17

Основные типы подсистем информационных систем

•информационное обеспечение (данные);

•интеллектуальное обеспечение (информация, знания);

•техническое обеспечение (аппаратура);

•технологическое обеспечение (технологии);

•коммуникативное обеспечение (интерфейс);

•анализ и проектирование;

•оценка адекватности и качества;

•управление персоналом.

2 ЛОГИЧЕСКИЕ ОСНОВЫ ЭВМ

Алгебра логики (булева алгебра) занимается исчислением высказываний и применяется для описания работы дискретных устройств, к которым относятся и ЭВМ.

Утверждение — основная единица, неделимая с точки зрения отражения смысла информации.

Высказывание — повествовательное утверждение, про которое можно однозначно сказать, истинно оно или ложно.

Предикат — высказывательная форма с логическими переменными, имеющая смысл при любых допустимых значениях этих переменных.

Пример. «Теплое лето» — утверждение; «Москва — столица РФ» — высказывание; «х > 100» — предикат.

Базовые логические операции булевой алгебры (по убыванию приоритета): НЕ — логическое отрицание; И — логическое умножение (конъюнкция);

ИЛИ — логическое сложение (дизъюнкция).

Основные законы (аксиомы) булевой алгебры

1.¬(¬X) = Х

2.X Y = Y Х; X Y = Y Х

3.(X Y) Z = X (Y Z) = X Y Z (X Y) Z = X (Y Z) = X Y Z

4.X X = X; X X = X

5.X (X Y) = Х; X (X Y) = Х

6.X (Y Z) = (X Y) (X Z) X (Y Z) = (X Y) (X Z)

7.¬(X Y) = ¬X¬Y ¬(X Y) = ¬X¬Y

8.X (Y¬Y) = Х X (Y¬Y) = Х

9.¬0 = 1; ¬1 = 0; ¬Х Х = 1; ¬Х Х = 0

Двойное отрицание Коммутативность

Ассоциативность

Идемпотентность

Поглощение

Дистрибутивность

Моргана (перенесение бинарной операции на операнды)

Нейтральность

Существование единицы

Из аксиом можно вывести ряд полезных соотношений:

Х 1 = Х |

Х 0 = 0 |

Х 0 = Х |

Х 1 = 1 |

18

Рассмотрим сложение по mod 2 (неравнозначность)

1 X = ¬X 0 X = X X ¬X = 1 X X X ……. X = X — при нечетном числе членов, 0 — при четном. Таблица истинности для неравнозначности

Переменные |

|

Mod 2 |

|

Х |

|

Y |

X Y |

0 |

|

0 |

0 |

0 |

|

1 |

1 |

1 |

|

0 |

1 |

1 |

|

1 |

0 |

Булева функция n переменных полностью определяется таблицей из 2n строк. Таблица всех значений некоторой логической функции называется таблицей истинности этой функции.

Базовые операции булевой алгебры

Переменные |

|

Логические операции |

|||

Х |

|

Y |

X Y |

Х Y |

¬Х |

0 |

|

0 |

0 |

0 |

1 |

0 |

|

1 |

0 |

1 |

1 |

1 |

|

0 |

0 |

1 |

0 |

1 |

|

1 |

1 |

1 |

0 |

Кроме базовых операций существуют небазовые, но достаточно важные операции:

1.Импликация (X→Y) ≡ (¬X Y)

2.Эквивалентность (X↔Y) ≡ (X Y¬X¬Y)

Логические функции позволяют эффективно решать информационно-логические задачи, доказывать утверждения. Логические функции эквивалентны, если совпадают их таблицы истинности. Всегда истинные формулы называют тавтологиями. В информационно-логической задаче необходимо установить информационные или логические связи и сделать причинно-следственные логические выводы.

Пример.

Иванов, Петров и Сидоров утверждают, что видели виновника ДТП. Иванов говорит, что это были белые «Жигули», Петров — что черная «Волга», Сидоров — что «Москвич», но не белый. Как определить истинный цвет и марку автомобиля?

Составим простые высказывания: X = «машина — белая»

Y= «машина — жигули»

Z= «машина — черная»

U= «машина — волга»

V= «машина — москвич» На основе высказываний запишем логические выражения для каждого очевидца

Иванов: |

X Y |

Петров: |

Z U |

Сидоров: |

¬X V |

|

Пусть в каждом из этих логических выражений одна из переменных принимает |

||||

значение «истина». Тогда будут истинны и дизъюнкции вида: |

|

|

|||

|

X Y = 1 |

|

Z U = 1 |

|

¬X V = 1 |

По определению конъюнкции получим следующее выражение

(X Y) (Z U) (¬X V) = 1 (*)

19