из электронной библиотеки / 520820910343900.pdf

.pdf

Понятие информация является одним из фундаментальных в современной науке вообще и базовым для изучаемой информатики. Информацию наряду с веществом и энергией рассматривают в качестве важнейшей сущности мира, в котором мы живем. Однако, если задаться целью формально определить понятие «информация», то сделать это будет чрезвычайно сложно. Аналогичными «неопределяемыми» понятиями, например, в математике является «точка» или «прямая». Так, можно сделать некоторые утверждения, связанные с этими математическими понятиями, но сами они не могут быть определены с помощью более элементарных понятий.

В простейшем бытовом понимании с термином «информация» обычно ассоциируются некоторые сведения, данные, знания и т.п. Информация передается в виде сообщений, определяющих форму и представление передаваемой информации. Примерами сообщений являются музыкальное произведение; телепередача; команды регулировщика на перекрестке; текст, распечатанный на принтере; данные, полученные в результате работы составленной вами программы и т.д. При этом предполагается, что имеются «источник информации» и «получатель информации».

Сообщение от источника к получателю передается посредством какой-нибудь среды, являющейся в таком случае «каналом связи». Так, при передаче речевого сообщения в качестве такого канала связи можно рассматривать воздух, в котором распространяются звуковые волны, а в случае передачи письменного сообщения (например, текста, распечатанного на принтере) каналом сообщения можно считать лист бумаги, на котором напечатан текст.

Источник посылает передаваемое сообщение, которое кодируется в передаваемый сигнал. Этот сигнал посылается по каналу связи. В результате в приемнике появляется принимаемый сигнал, который декодируется и становится принимаемым сообщением.

Канал связи

Источник  Приемник

Приемник

Прием-передача информации между автоматическими устройствами выполняется с использованием технических средств связи. Ретрансляционная вышка передает информацию, которую воспринимает блок приема радиоприемника. Видеомагнитофон передает информацию с видеокассеты на экран телевизора. При обмене информацией нужны источник информации и приемник информации. Передаваемая от источника информация достигает приемника с помощью последовательности сигналов, которые могут быть письменными, звуковыми, электрическими, электромагнитными и т.д.

Устройства хранения информации: аудиокассета, видеокассета, кинолента, лист бумаги, картина и др. – называются носителями информации. Носитель информации может быть разной природы: механический, магнитный, электрический, оптический. Носители информации различаются по форме представления информации, по принципу считывания, по типам материала. Информация на носителях запоминается в виде сигналов или знаков.

Обработка информации означает преобразование информации из одного вида в другой, осуществляемое по строгим формальным правилам. Автоматизированная обработка информации выполняется по принципу «черного ящика» – процесс, в котором пользователю важна и необходима лишь входная и выходная информация, но правила, по которым происходит преобразование, его не интересуют и не принимаются во внимание. Кроме этого, автоматизированная обработка не подразумевает осмысления потребителем информации на этапе ее обработки.

41

Анализ опубликованных работ по информатике показывает, что общепринятой трактовки крайне дискуссионного понятия информация на сегодняшний день пока не существует и, скорее всего, еще долго не будет существовать в силу сложности и многообразия проявлений этого феномена природы.

Под информацией в быту (житейский аспект) понимают сведения, которые интересны, необходимы и доступны для понимания потребителю. Устранение хотя бы одного из этих атрибутов сразу лишает их в глазах потребителя информативности. Например, "развлекательное" чтение на досуге справочника движения поездов дальнего следования или прослушивание лекции на незнакомом иностранном языке.

Под информацией в технике (технический аспект) понимают любой сигнал, прошедший по каналу связи.

Под информацией в теории информации понимают сведения, которые, снимают полностью или уменьшают существующую неопределенность. Иначе говоря, информация

– это устраненная неопределенность.

Под информацией в кибернетике понимают сведения, которые могут быть использованы для ориентирования и принятия правильного управленческого решения в целях сохранения, совершенствования и развития системы.

Под информацией в семантике понимают сведения, обладающие новизной. При изучении информатики наиболее всеобъемлющим «определением»

информации следует считать ее общенаучную трактовку:

Под информацией понимается способность объектов, процессов и явлений живой

инеживой природы порождать многообразие различных состояний, которые посредством отражения передаются от одного объекта к другому и запечатлеваются в том или ином виде в его структуре.

Современная наука утверждает, что мы живем в окружении трех основных полей: энергетическое поле, которое включает в себя все известные виды энергии (механическую, тепловую, электрическую, атомную и др.), гравитационное поле, а также информационное поле, к пониманию о существовании которого пришли совсем недавно. То, как воздействуют на человека первые два поля, нам хорошо известно из повседневной жизни. Информационное же поле воздействует на человека через свои информационные потоки, к числу которых можно отнести следующие основные потоки:

вербальный поток (письменные и устные слова); сенсорный поток, воспринимаемый органами чувств (зрение, слух, вкус, обоняние

иосязание);

структурный поток, компонентами которого являются вещества, находящиеся в различных фазовых состояниях (твердые, жидкие и газообразные тела, а также плазма).

Сбор, хранение, обработка и передача информации присущи живой и неживой природе, человеку, обществу, техническим устройствам. В системах различной природы такие действия с информацией в своей основе одинаковы и называются

информационными процессами.

Информация может существовать и участвовать в информационных процессах в самых разнообразных формах, например в виде:

текстов, чисел; рисунков, чертежей, фотографий;

световых и звуковых сигналов или радиоволн; электрических и нервных импульсов; магнитных и оптических записей; жестов, мимики; запахов и вкусовых ощущений; химических соединений.

42

В информационных процессах для каждого вида информации обязательно используются соответствующий носитель и подходящая система кодирования информации. Так, например, текстовая информация кодируется с помощью букв национальных алфавитов, числовая информация – с помощью арабских или римских цифр, голосовая информация – с помощью фонетических звуков, музыкальная информация – с помощью нотной записи и т.д. Любая система кодирования преследует своей целью не скрытие информации (в отличие от систем шифрования информации), а наоборот – предоставление ее потребителю в наиболее удобном для потребления виде.

С понятием информации тесно связаны следующие понятия: Сигнал – это любой процесс, несущий информацию.

Сообщение – это информация, представленная в определенной форме и предназначенная для передачи.

Данные – это информация, представленная в формализованном виде и предназначенная для обработки техническими средствами, например ЭВМ.

Носитель информации – среда для записи и хранения информации. Носителем информации может быть любой материальный предмет (бумага, камень, стена, поверхность дискеты), волны различной природы (акустическая – звук, электромагнитная

– свет, радиоволна, гравитационная – давление, притяжение), особые состояния вещества (концентрация молекул в жидком растворе, температура и давление газа, расположение молекул в кристалле процессора и др.).

Способ передачи информации – сигнал.

Информационный сигнал – физический процесс, имеющий для человека или технического устройства информационное значение. Он может быть непрерывным (аналоговым) или дискретным.

Аналоговый сигнал – сигнал, непрерывно изменяющийся по амплитуде и во времени.

Сигнал называется дискретным, если он может принимать лишь конечное число значений в определенный период времени.

Вреальной жизни мы чаще всего воспринимаем непрерывные сигналы. Даже речь человека по сути представляет собой непрерывный сигнал. В этом легко убедиться, если вспомнить, что речь на незнакомом языке воспринимается слитно, в ней трудно выделить отдельные слова. Но легче обрабатывать дискретные сигналы. Благодаря сложившейся с детства привычке, мы выделяем в сигналах, непрерывно поступающих к нам из внешнего мира, отдельные элементы: лица и облака, слова и музыкальные фразы.

Важно: аналоговые сигналы всегда могут быть представлены в дискретном виде, например, в виде последовательности чисел. Процесс представления какой-либо величины в виде последовательного ряда ее отдельных (дискретных) значений называют дискретизацией.

Вычислительная техника может работать как с аналоговыми, так и с дискретными (цифровыми) сигналами. Соответственно, существуют аналоговые вычислительные машины (АВМ) и цифровые вычислительные машины (ЦВМ), причем последние получили значительно большее распространение.

Всуществующих на сегодняшний день разнообразных технических устройствах и системах прием, обработка и передача информации осуществляется с помощью сигналов. Сигналы отражают физические характеристики изучаемых объектов и процессов.

43

Посредством сигналов информация может передаваться как на очень короткие расстояния, например, от одного узла устройства к другому, так и на очень большие, расположенные в разных точках Земного шара. Кроме этого, информация в виде сигнала может различным образом перерабатываться, сохраняться, уничтожаться и т. п.

На сегодняшний день различают несколько видов сигналов. Это, например, звуковые сигналы, которые можно услышать при работе милицейской сирены. Или световые сигналы, передающие информацию от пульта дистанционного управления к телевизору. Но наибольшее распространение в современных технических устройствах получили электрические сигналы. Это связано с тем, что для них в настоящее время созданы наилучшие технические средства обработки, хранения и передачи.

Остановимся подробнее на электрическом сигнале. При передаче информации посредством электрического сигнала значение информации, заключенной в этом сигнале, выражается в параметрах электрического тока - в силе тока и напряжении. При этом информации, переносимая таким сигналом, может быть самой разнообразной.

Существующие в технических устройствах сигналы делятся на непрерывные (или аналоговые) и дискретные.

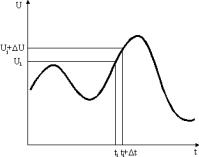

Непрерывность сигнала означает возможность его изменения на любую малую величину в любой заданный малый промежуток времени (рис.1).

Рис. 1. Непрерывный сигнал

Аналоговое сохранение информации является также довольно распространенным явлением. Это, например запись звукового сигнала на магнитофонную ленту.

До семидесятых годов ХХ века технические устройства работали только с аналоговыми сигналами. Аналоговыми являлись и способы их обработки. Это означало, что обработка сигнала проводилась на непрерывном интервале времени (иными словами -

вкаждый малый промежуток времени).

Споявлением в семидесятых годах ХХ века микропроцессора - основного элемента ЭВМ, а также микросхем с высокой степенью интеграции, стали получать распространение дискретные и цифровые сигналы, а вместе с ними и соответствующие способы их обработки.

Говоря о непрерывности сигнала, мы рассматривали непрерывный промежуток времени, на котором может изменяться сигнал.

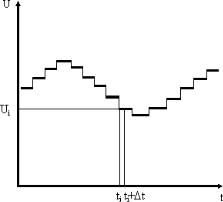

Дискретность же сигнала означает возможность его измерения только на конечном отрезке, в строго определенные моменты времени. А следовательно, и сам сигнал представляет собой уже не непрерывную функцию, а последовательностью дискретных значений (рис. 2).

44

Рис. 2. Дискретный сигнал

Как видно из рис.2 дискретные значения функции, полученные в дискретные моменты времени, имеют лишь только приближенные числовые значения. В зависимости от решаемой задачи, эти значения могут быть зафиксированы только в данных временных точках, а могут сохранять свое значение в промежутке от данной до следующей точки измерения.

В случае, когда наличие приближенных значений не удовлетворяет поставленной задаче, производят округление имеющихся значений с заданной степенью точности.

Дискретный сигнал, значения которого выражены определенными конечными числами, называется цифровым.

Бурное развитие вычислительной техники, средств телекоммуникации непосредственно связано с обработкой именно цифровых сигналов, поскольку цифровая связь имеет множество преимуществ по сравнению с аналоговой. Когда в процессе передачи на сигнал накладывается шум, то восстановить истинный сигнал становится очень трудно. В случае цифрового сигнала ситуация изменяется. Так как цифровой сигнал, и особенно двоичный сигнал, имеет конечное число состояний, то восстановление истинных значений переданного сигнала осуществляется гораздо легче, без потери информации и искажений за счет переходных помех, групповых задержек и других посторонних влияний, которые неизбежны при аналоговой передаче сигналов.

Проблемы передачи аналоговых сигналов возрастают при увеличении длины линии, так как уровень шума возрастает пропорционально длине линии.

Качество цифровой передачи не зависит от длины линии, так как существует возможность восстанавливать сигнал. При каждой регенерации сигнала исчезает влияние переходных помех, неравномерности группового времени замедления (дисперсии) и т.д., в результате мы можем утверждать, что качество передачи речевых сигналов одинаково как в начале так и в конце линии.

Широкое применение цифрового способа хранения информации находит запись различного рода информации на аудио- и видео- компакт-дисках (CD-ROM).

С цифровой передачей данных мы сталкиваемся при обмене информацией между компьютерами с помощью модема или при работе с факсимильными средствами связи.

Несмотря на то, что цифровая обработка информации приобретает в настоящее время все большее распространение, отказаться от аналоговой невозможно. Еще остается достаточно много систем и устройств, в которых информация может передаваться только в виде аналогового сигнала. В связи с этим решаются различные вопросы, ищутся способы преобразования аналогового сигнала в цифровой и наоборот.

Очевидно, при преобразовании исходного аналогового сигнала в цифровой, появляется определенная погрешность. Это, конечно, является недостатком. Но, увеличивая число дискретов по оси времени и функции сигнала, можно достичь

45

уменьшение погрешности. Использование современных высокоскоростных технических средств обработки и хранения цифровых сигналов позволяет значительно упростить и удешевить процесс преобразования аналогового сигнала в цифровой. А также устранить недостатки, присущие аналоговой передаче сигнала, например, влияние шумов, и получить ряд важных преимуществ.

Таким образом, мы рассмотрели существующие виды информации. Зрительная и звуковая, посредством которой общаются люди, а также информация в виде сигналов, непосредственно связаны между собой. Преобразования информации из одного вида в другой показывают насколько важен и непрерывен процесс обмена информацией. Применение технических устройств делает этот процесс неотъемлемой частью жизни человеческого общества.

Свойства информации

Получая какую-либо информацию, человек ее пытается осмыслить и оценить. Что в ней нового? Насколько она ему важна? Правдива ли она? Может возникнуть множество вопросов относительно полученной информации. Как же правильно ее оценить?

Оказывается, любая информация должна обладать рядом свойств. Только определив, насколько ваша информация отвечает присущим ей свойствам, можно ее оценить.

Сначала рассмотрим свойство, которое гласит: любая полученная информация должна быть достоверной. Достоверность означает истинное, объективное отражение действительности. Информация в человеческом обществе передается и получается людьми или с их помощью. Как известно, каждый человек воспринимает окружающую действительность субъективно, имея свой собственный, отличный от других взгляд и мнение. Поэтому передаваемая или получаемая человеком информация не может быть абсолютно объективна. Она лишь может быть максимально приближена к объективной. Смысл рассматриваемого свойства достоверности и заключается в том, чтобы определить насколько данная информация соответствует истинному положению дел. В противном случае недостоверная информация повлечет за собой неправильное понимание и, как следствие, принятие неправильных решений.

С этим свойством информации каждый из нас сталкивается каждый день. Из огромного потока получаемой нами информации следует определить, какая достоверна, а какая нет. В качестве примера можно привести ежедневный интерес людей к прогнозу погоды. Существуют различные источники получения информации о предстоящей погоде. Это могут быть собственные наблюдения, а также сводки погоды, составленные метеослужбами различных ведомств, городов, а также гидрометеорологическими службами целых регионов. Каждая из этих служб имеет свои средства наблюдения и составления прогнозов, каждая из них учитывает какие-то показатели больше, какие-то меньше. У всех различная точность предсказания погоды. Поэтому человек, получая прогноз погоды, интересуется, из какого источника он получен и является ли достоверным.

Рассмотрим на примере прогноза погоды и другие свойства. Получая сводку погоды, в одних случаях нас интересует температура и влажность воздуха, в других - осадки и направление ветра, в третьих, возможно, нам потребуется полная картина предстоящей погоды. Если информация содержит все интересующие нас данные, и их достаточно для понимания и принятия решений, тогда говорят, что информация полна. Неполная информация может повлечь ошибки или привести к сдерживанию каких-то решений.

Также важно, чтобы получаемая информация соответствовала бы данной ситуации. Например, можно получить полную сводку погоды из достоверного источника. Но она

46

окажется ненужной, если будет содержать сведения недельной давности. Иными словами, информация должна быть актуальной.

Теперь давайте представим, что имеем достоверную, полную и актуальную информацию о погоде на предстоящую неделю. Но эта информация записана (или произнесена) в терминах и обозначениях синоптиков, непонятных большинству людей. В этом случае она окажется бесполезной. Отсюда следует вывод, что информация должна быть выражена в таком виде, который был бы понятен получателю данной информации. В этом заключается следующее свойство информации - ясность.

Получая новую информацию, мы смотрим, нужна ли она для решения данной проблемы. Одна и та же информация может быть очень важной для одного человека и быть абсолютно бесполезной для другого. Так, информация о погоде в городе N представляет большой интерес для жителей этого города и совсем не нужна жителям города М. От того, какие задачи можно решить с помощью данной информации, зависит ее ценность.

Таким образом, мы определили следующие свойства информации: достоверность, полноту, актуальность, ясность и ценность.

Виды информации:

–по способу восприятия: визуальная, аудиальная, тактильная, вкусовая, обонятельная;

–по общественному значению:

–личная – это знания, опыт, интуиция, умения, эмоции, наследственная память конкретного человека;

–специальная, значимая для определенной группы людей: научная, производственная, техническая, управленческая;

–общественная, значимая для большинства членов общества: общественнополитическая, научно-популярная (научно осмысленный опыт всего человечества, исторические, культурные и национальные традиции и др.), обыденная (которой мы обмениваемся в процессе повседневного общения), эстетическая (изобразительное искусство, скульптура, музыка, театр и др.).

–по сфере применения информации (экономическая, географическая, социологическая и пр.);

–по характеру источников информации (первичная, вторичная, обобщающая и пр.); Существует выделение видов информации и по другим основаниям, но в информатике наиболее важным является разделение информации по форме представления, а именно:

–текстовая,

–числовая,

–графическая,

–звуковая и их всевозможные комбинации.

Единицы количества информации: вероятностный и объемный подходы Каждый предмет или явление человек пытается охарактеризовать, для сравнения с

подобными, его величиной. Не всегда это можно просто и однозначно сделать. Даже величины физических предметов можно оценивать по-разному: по объему, весу, массе, количеству составляющих его элементов, стоимости. Чем явление более сложно и многопланово и чем больше характеристик у этого явления, тем труднее подобрать для него удовлетворяющее всех, кто занимается этим явлением, определение его величины. Так и количество информации можно мерить по-разному: в количествах книг, страниц, знаков, метрах кинопленки, тоннах архивных материалов, килобайтах оперативной памяти ЭВМ, а также оценивать по эмоциональному восприятию человека, по полученной пользе от обладания информацией, по необходимым затратам на обработку,

47

систематизацию информации и т.д. Попробуйте оценить, где больше информации: в формуле Энштейна E=mc2, лежащей в основе физики водородной бомбы, в картине Айвазовского “Девятый вал” или в ежедневной телевизионной передаче “Новости”.

Видимо, проще всего оценить количество информации по тому, сколько необходимо места для ее хранения, выбрав какой-нибудь единый способ представления и хранения информации.

Определить понятие «количество информации» довольно сложно. В решении этой проблемы существуют два основных подхода. Исторически они возникли почти одновременно. В конце 40-х годов XX века один из основоположников кибернетики американский математик Клод Шеннон развил вероятностный подход к измерению количества информации, а работы по созданию ЭВМ привели к «объемному» подходу.

Вероятностный подход Введем в рассмотрение численную величину, измеряющую неопределенность —

энтропию (обозначим ее H). Величины N и H связаны между собой некоторой

функциональной зависимостью: |

|

H = f(N), |

(1.1) |

а сама функция f является возрастающей, неотрицательной и определенной (в рассматриваемом нами примере) для N = 1, 2, … 6.

Следующим важным моментом является определение вида функции f в формуле (1.1). Если варьировать число граней N и число бросаний кости (обозначим эту величину через M), то общее число исходов (векторов длины M, состоящих из знаков 1, 2, …, N) будет равно N в степени М:

X = NМ . |

(1.3) |

Так, в случае двух бросаний кости с шестью гранями имеем: X = 62 = 36. Фактически каждый исход X есть некоторая пара (X1, X2), где X1 и X2 — соответственно исходы первого и второго бросаний (общее число таких пар — X).

H = log2 N. — формула Хартли.

Важным при введение какой-либо величины является вопрос о том, что принимать за единицу ее измерения. Очевидно, H будет равно единице при N = 2. Иначе говоря, в качестве единицы принимается количество информации, связанное с проведением опыта, состоящего в получении одного из двух равновероятных исходов (примером такого опыта может служить бросание монеты при котором возможны два исхода: “орел”, “решка”). Такая единица количества информации называется “бит”.

Объемный подход В двоичной системе счисления знаки 0 и 1 будем называть битами (от английского

выражения Binary digiTs — двоичные цифры). Отметим, что создатели компьютеров отдают предпочтение именно двоичной системе счисления потому, что в техническом устройстве наиболее просто реализовать два противоположных физических состояния:

некоторый физический элемент, имеющий два различных состояния: намагниченность в двух противоположных направлениях, прибор, пропускающий или нет электрический ток, конденсатор, заряженный или незаряженный и т.п. В компьютере бит является наименьшей возможной единицей информации. Объем информации, записанной двоичными знаками в памяти компьютера или на внешнем носителе информации, подсчитывается просто по количеству требуемых для такой записи двоичных символов. При этом, в частности, невозможно нецелое число битов (в отличие от вероятностного подхода).

Для удобства использования введены и более крупные, чем бит, единицы количества информации. Так, двоичное слово из восьми знаков содержит один байт

48

информации. 1024 байта образуют килобайт (Кбайт), 1024 килобайта — мегабайт (Мбайт), а 1024 мегабайта — гигабайт (Гбайт).

Между вероятностным и объемным количеством информации соотношение неоднозначное. Далеко не всякий текст, записанный двоичными символами, допускает измерение объема информации в кибернетическом смысле, но заведомо допускает его в объемном. Далее, если некоторое сообщение допускают измеримость количества информации в обоих смыслах, то это количество не обязательно совпадает, при этом кибернетическое количество информации не может быть больше объемного.

При всем многообразии подходов к определению понятия информации, с позиций измерения информации нас интересуют два из них: определение К. Шеннона, применяемое в математической теории информации, и определение А. Н. Колмогорова, применяемое в отраслях информатики, связанных с использованием компьютеров

(computer science).

В содержательном подходе возможна качественная оценка информации: новая, срочная, важная и т.д. Согласно Шеннону, информативность сообщения характеризуется содержащейся в нем полезной информацией - той частью сообщения, которая снимает полностью или уменьшает неопределенность какой-либо ситуации. Неопределенность некоторого события - это количество возможных исходов данного события. Так, например, неопределенность погоды на завтра обычно заключается в диапазоне температуры воздуха и возможности выпадения осадков.

Содержательный подход часто называют субъективным, так как разные люди (субъекты) информацию об одном и том же предмете оценивают по-разному. Но если число исходов не зависит от суждений людей (случай бросания кубика или монеты), то информация о наступлении одного из возможных исходов является объективной.

Алфавитный подход основан на том, что всякое сообщение можно закодировать с помощью конечной последовательности символов некоторого алфавита. С позиций computer science носителями информации являются любые последовательности символов, которые хранятся, передаются и обрабатываются с помощью компьютера. Согласно Колмогорову, информативность последовательности символов не зависит от содержания сообщения, а определяется минимально необходимым количеством символов для ее кодирования. Алфавитный подход является объективным, т.е. он не зависит от субъекта, воспринимающего сообщение. Смысл сообщения учитывается на этапе выбора алфавита кодирования либо не учитывается вообще. На первый взгляд определения Шеннона и Колмогорова кажутся разными, тем не менее, они хорошо согласуются при выборе единиц измерения.

Единицы измерения информации

Решая различные задачи, человек вынужден использовать информацию об окружающем нас мире. И чем более полно и подробно человеком изучены те или иные явления, тем подчас проще найти ответ на поставленный вопрос. Так, например, знание законов физики позволяет создавать сложные приборы, а для того, чтобы перевести текст на иностранный язык, нужно знать грамматические правила и помнить много слов.

Часто приходится слышать, что сообщение или несет мало информации или, наоборот, содержит исчерпывающую информацию. При этом разные люди, получившие одно и то же сообщение (например, прочитав статью в газете), по-разному оценивают количество информации, содержащейся в нем. Это происходит оттого, что знания людей об этих событиях (явлениях) до получения сообщения были различными. Поэтому те, кто знал об этом мало, сочтут, что получили много информации, те же, кто знал больше, чем написано в статье, скажут, что информации не получили вовсе. Количество информации в

49

сообщении, таким образом, зависит от того, насколько ново это сообщение для получателя.

Однако иногда возникает ситуация, когда людям сообщают много новых для них сведений (например, на лекции), а информации при этом они практически не получают (в этом нетрудно убедиться во время опроса или контрольной работы). Происходит это оттого, что сама тема в данный момент слушателям не представляется интересной.

Итак, количество информации зависит от новизны сведений об интересном для получателя информации явлении. Иными словами, неопределенность (т.е. неполнота знания) по интересующему нас вопросу с получением информации уменьшается. Если в результате получения сообщения будет достигнута полная ясность в данном вопросе (т.е. неопределенность исчезнет), говорят, что была получена исчерпывающая информация. Это означает, что необходимости в получении дополнительной информации на эту тему нет. Напротив, если после получения сообщения неопределенность осталась прежней (сообщаемые сведения или уже были известны, или не относятся к делу), значит, информации получено не было (нулевая информация).

Если подбросить монету и проследить, какой стороной она упадет, то мы получим определенную информацию. Обе стороны монеты "равноправны", поэтому одинаково вероятно, что выпадет как одна, так и другая сторона. В таких случаях говорят, что событие несет информацию в 1 бит. Если положить в мешок два шарика разного цвета, то, вытащив вслепую один шар, мы также получим информацию о цвете шара в 1 бит. Единица измерения информации называется бит (bit) - сокращение от английских слов binary digit, что означает двоичная цифра.

В компьютерной технике бит соответствует физическому состоянию носителя информации: намагничено - не намагничено, есть отверстие - нет отверстия. При этом одно состояние принято обозначать цифрой 0, а другое - цифрой 1. Выбор одного из двух возможных вариантов позволяет также различать логические истину и ложь. Последовательностью битов можно закодировать текст, изображение, звук или какуюлибо другую информацию. Такой метод представления информации называется двоичным кодированием (binary encoding).

Винформатике часто используется величина, называемая байтом (byte) и равная 8 битам. И если бит позволяет выбрать один вариант из двух возможных, то байт, соответственно, 1 из 256 (28). В большинстве современных ЭВМ при кодировании каждому символу соответствует своя последовательность из восьми нулей и единиц, т. е. байт. Соответствие байтов и символов задается с помощью таблицы, в которой для каждого кода указывается свой символ. Так, например, в широко распространенной кодировке Koi8-R буква "М" имеет код 11101101, буква "И" - код 11101001, а пробел - код

00100000.

Наряду с байтами для измерения количества информации используются более крупные единицы:

1 Кбайт (один килобайт) = 210 байт = 1024 байта; 1 Мбайт (один мегабайт) = 210 Кбайт = 1024 Кбайта;

1 Гбайт (один гигабайт) = 210 Мбайт = 1024 Мбайта.

Впоследнее время в связи с увеличением объёмов обрабатываемой информации входят в употребление такие производные единицы, как:

1 Терабайт (Тб) = 1024 Гбайта = 240 байта, 1 Петабайт (Пб) = 1024 Тбайта = 250 байта.

Рассмотрим, как можно подсчитать количество информации в сообщении, используя содержательный подход.

50