- •Теоретичні з викладками

- •3. Спільна ентропія двох джерел (а та b) дискретних залежних повідомлень та надати її аналіз.

- •4. Взаємна інформація двох джерел (а та b) дискретних залежних повідомлень. Основні властивості.

- •Схемні з викладками

- •2 Навести структурну або функціональну схему кодера та декодера ікм. Пояснити принцип роботи.

- •Задачі з викладками

- •Привести інформаційні характеристики джерел неперервних повідомлень.

- •Вивести формулу епсилон-ентропії джерела неперервних повідомлень, якщо густина ймовірності джерела має гауссів розподіл та надати її аналіз.4

- •13.Пропускна здатність каналу з абгш. Надати її аналіз.

- •Пропускна здатність каналу дск. Надати її аналіз.

- •Пояснити принцип дії цифрових систем з передбаченням.

- •Теоретичні

- •16. Пояснити принцип кодування за методом дікм.

- •17. Як визначається інтервал дискретизації або частота дискретизації при кодуванні аналогових сигналів методом дікм?

- •18. Від чого залежить довжина коду при дікм?

- •19. Як визначається швидкість цифрового сигналу при кодуванні за методом дікм?

- •15. Обчислити пропускну здатність гауссового каналу із заданою смугою пропускання Fк, яким передається сигнал із потужністю Рs при спектральній густині потужності шуму в ньому n0.

- •Теоретичні з викладками

- •Задачі з викладками

Теорія:

Ентропії джерела дискретних незалежних і залежних повідомлень та надати її аналіз.

Ентропія джерела H(A), це – середня кількість інформації в одному повідомленні. Для М незалежних повідомлень обчислюється як математичне сподівання

,

де P(ak)-імовірність

появи повідомлення, також у формулі

логарифм можемо замінити на власну

інформацію:

I(ak)

= – log 2

P(ak)

,

де P(ak)-імовірність

появи повідомлення, також у формулі

логарифм можемо замінити на власну

інформацію:

I(ak)

= – log 2

P(ak)

Ентропія, як і інформація, завжди додатна й досягає максимального значення

Hmax (А) = log2 M.

Ентропія джерела залежних повідомлень. Користуючись поняттям умовної ентропії(Умовна ентропія – середня кількість інформації, яку переносить одне повідомлення джерела при залежних повідомленнях), можна отримати вираз для обчислення ентропії Нп(X) джерела з пам’яттю, яке має алфавіт X. Якщо глибина пам’яті такого джерела дорівнює h, а потужність алфавіту M, то можна вважати, що перед генерацією чергового символу джерело знаходиться в одному з Q=Mh станів, де під станом розуміємо одну з можливих послідовностей попередніх символів довжиною h на його виході.

Для залежних

повідомлень обчислюється як (умовна

ентропія H

(X/s)

при умові,

що джерело перебуває в s-му

стані)

де p(xi/s) – умовна ймовірність появи символу xi, якщо джерело перебуває в s-му стані

Умовна ентропія двох джерел (А та B) дискретних залежних повідомлень та надати її аналіз.

Умовна ентропія – середня кількість інформації, яку переносить одне повідомлення джерела при залежних повідомленнях. Умовна ентропія двох джерел повідомлень A i B чи B і A, визначається:

Н (A/B) = M (і(аk/bk))

Н (B/A) = M (і(bk/ak)) [дв.од./пов. (біт/пов.)]

Де спільна кількість інформації в повідомленнях аk та bk об’єднаного ансамблю AB двох джерел повідомлень A та B – і(аk, bk) чи і(bk, ak), визначається:

і(аk, bk) = – log 2 P(аk, bk)

і(bk. ak) = – log 2 P(bk. ak) [дв.од.]

Умовна ентропія H (X/s) при умові, що джерело перебуває в s-му стані

де p(xi/s) – умовна ймовірність появи символу xi, якщо джерело перебуває в s-му стані.

Схема:

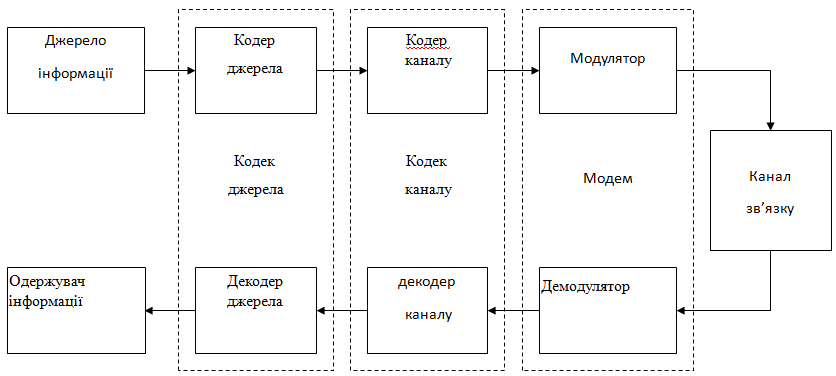

Навести структурну схему систем електрозв’язку для передачі дискретних повідомлень (пояснити призначення основних блоків).

Джерело інформації формує повідомлення(до них віднос. дискретних символів (дані, телеграфні повідомлення) чи неперервні повідомлення (мовлення, телебачення, результати телевимірювань тощо)), що підлягають передаванню каналом зв’язку. Реальні повідомлення містять надлишковість, і для їхнього передавання в цифровому вигляді необхідне істотне збільшення пропускної здатності каналу. Для усунення значної частини надлишковості й узгодження джерела інформації з цифровою системою передавання використовується кодер джерела. Кодер разом з декодером утворюють кодек джерела. Неперервний канал зв'язку містить у собі лінію зв'язку, передавач і приймач сигналів. У залежності від типу лінії зв'язку (волоконно-оптичний кабель чи кабель з мідними жилами, простір між передавальною і приймальною антенами при використанні радіозв'язку і т. д.) структура приймально-передавальних пристроїв змінюється. Відмінність прийнятого сигналу від переданого зумовлена дією завад і спотворень у каналі зв’язку. У модуляторі формуються сигнали-переносники, форми яких повинні задовольняти вимогам до завадостійкості, смуги займаних частот, швидкості передавання та стійкості до спотворень у лінії зв'язку. Джерело й одержувач повідомлень оперують, як правило, з двійковими символами, тоді як часто в каналах використовують недвійкові (багатопозіційні) ансамблі сигналів. У цьому разі узгодження первинного сигналу з каналом зв’язку є також функцією модема, до складу якого входить як модулятор, так і демодулятор.

Задачі

Джерело видає три дискретні повідомлення a1, a2 та a3 з імовірностями – Р(а1) = 0,25 та Р(а2) = 0,12. Тривалості видачі повідомлень 10 мс, 15 мс та 20 мс відповідно. Обчислити кількість інформації в кожному повідомленні, ентропію, продуктивність і надмірність джерела

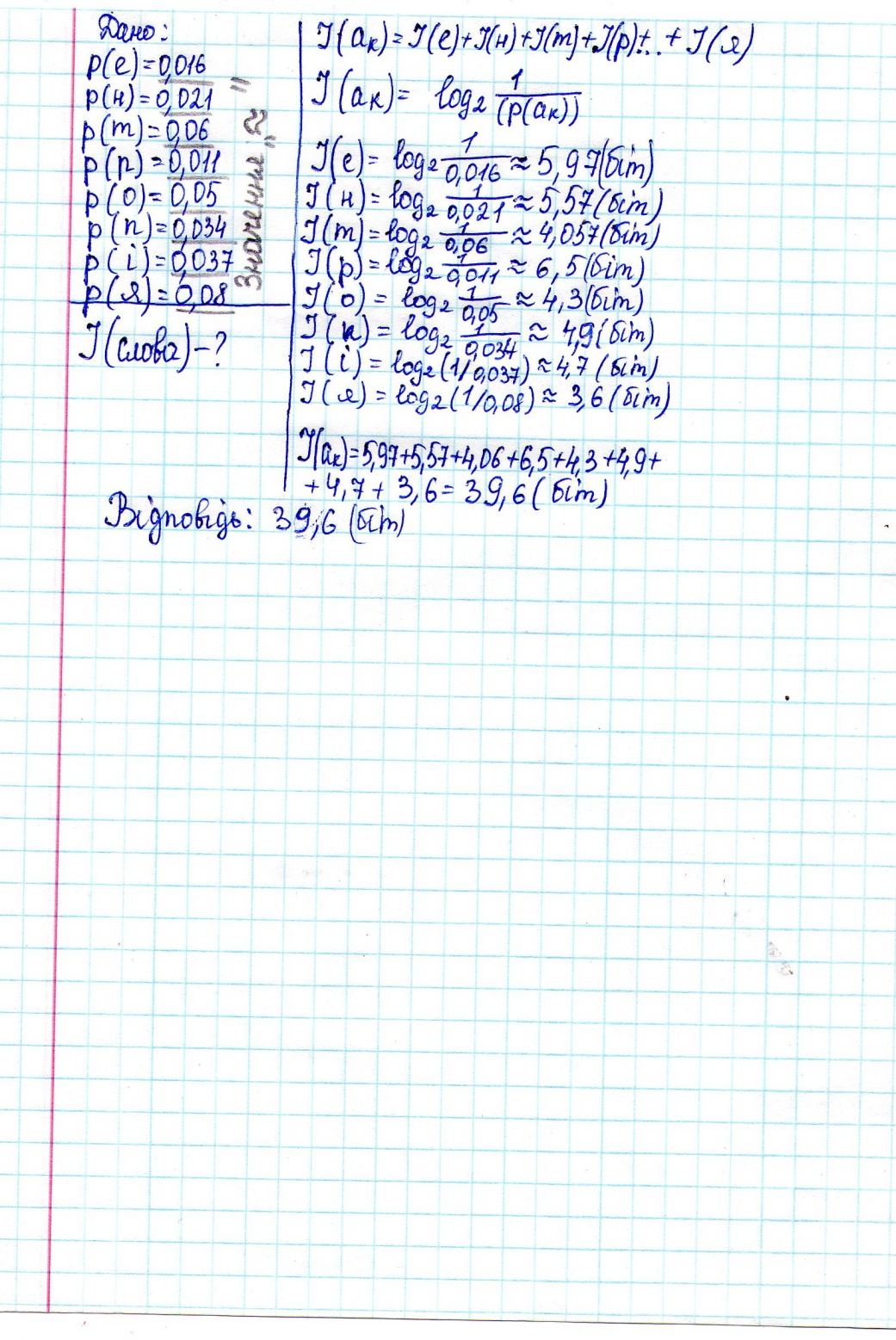

Знайти кількість інформації в слові ентропія. Імовірності літер українського змістовного тексту надані в табл. ___.

Теоретичні з викладками

3. Спільна ентропія двох джерел (а та b) дискретних залежних повідомлень та надати її аналіз.

Середня кількість інформації об’єднаного ансамблю AB двох джерел повідомлень A та B характеризується умовною, спільною та взаємною ентропіями.

Спільна ентропія – середня кількість інформації, яку переносять повідомлення джерел A та B з врахуванням статистичної залежності між ними.

Спільна ентропія об’єднаного ансамблю AB двох джерел повідомлень A та B, визначається:

Нсп (AB) = Н(A) + Нум (B/A) = Н(B) + Нум (A/B) [дв.од./пов. (біт/пов.)]

4. Взаємна інформація двох джерел (а та b) дискретних залежних повідомлень. Основні властивості.

Взаємна ентропія об’єднаного ансамблю AB двох джерел повідомлень показує середню кількість інформації, яку можна отримати про джерело А, спостерігаючи джерело В.

Взаємна ентропія об’єднаного ансамблю AB двох джерел повідомлень A та B, визначається:

Нвз (A, B) = Н(A) – Нум (A/B) = Н(B) – Нум (B/A) [дв.од./пов. (біт/пов.)]

Продуктивність об’єднаного ансамблю AB двох джерел повідомлень A та B, визначається:

Rдж (A,B) = Нсп (A,B) /Тср [дв.од./с (біт/с)]

Швидкість передачі інформації між двома джерелами повідомлень A та B, визначається:

R (A→B) = Нвз (A, B) /Тср [дв.од./с (біт/с)]

Схемні з викладками

2 Навести структурну або функціональну схему кодера та декодера ікм. Пояснити принцип роботи.

Особливістю цих методів є те, що кожний відлік представляється цифровим сигналом незалежно від інших відліків. Схема, що відображає передавання відліків при ІКМ, наведена на рис. 2.

Основний параметр квантувача – число рівнів квантування L. При рівномірному квантуванні діапазон значень b від –bmax до bmax розбивається на L – 1 інтервалів величиною

b = 2bmax /(L – 1), (2)

яка

називається кроком квантування. На рис.

3 показана розбивка при L = 8. Дискретні

значення bi відповідають

серединам інтервалів. Індекс і

приймає значення 0, 1,

2, ,

0,5L – 1. Дискретні

значення визначаються bi = ib.

При квантуванні кожен відлік b(kTд)

округляється до найближчого дискретного

значення bi, а на вихід

квантувача надходить ціле число i(kTд).

Представлення відліку b(kTд)

дискретним значенням bi

вносить похибку

яка

називається кроком квантування. На рис.

3 показана розбивка при L = 8. Дискретні

значення bi відповідають

серединам інтервалів. Індекс і

приймає значення 0, 1,

2, ,

0,5L – 1. Дискретні

значення визначаються bi = ib.

При квантуванні кожен відлік b(kTд)

округляється до найближчого дискретного

значення bi, а на вихід

квантувача надходить ціле число i(kTд).

Представлення відліку b(kTд)

дискретним значенням bi

вносить похибку

кв(kTд) = i(kTд)b – b(kTд), (3)

яка називається шумом квантування.

У кодері, що входить до складу кодера ІКМ (рис. 2), числа i(kTд) представляються заданим двійковим кодом. Довжина коду

n = log2L. (4)

Цифровий сигнал на виході кодера bц(t) має швидкість

R = nfд. (5)

Декодер з цифрового сигналу bц(t)

формує числа i(kTд), за якими

відновлюються квантовані відліки:

.

З формули (3) видно, що відліки відновлюються

з похибками кв(kTд).

Середній квадрат похибки квантування

(середня потужність шуму квантування)

визначається кроком квантування

.

З формули (3) видно, що відліки відновлюються

з похибками кв(kTд).

Середній квадрат похибки квантування

(середня потужність шуму квантування)

визначається кроком квантування

,

,

а відношення сигнал/шум квантування

,

(6)

,

(6)

де KА – коефіцієнт амплітуди аналогового сигналу.

Широко використовуються методи ІКМ з нерівномірним квантуванням: в області великих значень b кроки квантування більші і навпаки. Це еквівалентно нелінійному перетворенню відліків з наступним рівномірним квантуванням. За рахунок такого перетворення зменшується KА і зростає кв при незмінному числі L – формула (6), або, зберігаючи значення кв, можна зменшити число L, довжину коду n і швидкість цифрового сигналу R – формули (4) і (5).