- •Глава 1. Понятие модели. Чем замечательны модели математические

- •1.1. Что будем называть моделью и моделированием

- •1.2. Наука, научное знание, систематизации научных моделей

- •1.3. Обман чувств и интуиция. Спасение математикой

- •1.4. Сколько моделей может быть у одного объекта

- •1.6. Структурная схема процесса математического моделирования

- •1.7. Выводы из исторической практики моделирования. Показательная судьба моделей механики

- •Глава 2. Два подхода к моделированию и прогноз (вероятностный и динамический)

- •2.1. Основные понятия и особенности динамического моделирования

- •2.1.1. Определение динамической системы

- •2 .1.3. Фазовое пространство. Консервативные и диссипативные системы. Аттракторы, мультистабильность, бассейны притяжения

- •2.1.5. Пространство параметров. Бифуркации. Комбинированные пространства, бифуркационные диаграммы

- •2.2.4. Случайность как непредсказуемость

- •Глава 3. Динамические модели эволюции

- •3.1.1. Оператор, отображение, уравнение, оператор эволюции

- •3.1.2. Функции, непрерывное и дискретное время

- •3.1.4. Потоки и каскады, сечение и отображение Пуанкаре

- •3.5.2. Популярный класс модельных уравнений – осцилляторы

- •3.7.3. Дифференциальные уравнения с запаздыванием

- •4 .4. Процессы авторегрессии – скользящего среднего

- •4.5. Стохастические дифференциальные уравнения и белый шум

3.7.3. Дифференциальные уравнения с запаздыванием

Системы

с запаздывающей обратной связью являются

генераторами колебаний, включая

хаотические.

![]() .

.

учитывают возможность существования

нескольких причин запаздывания с разными

характерными масштабами. Eравнение

Маккея–Гласса, описывающее процесс

выработки красных кровяных клеток в

живых организмах:

учитывают возможность существования

нескольких причин запаздывания с разными

характерными масштабами. Eравнение

Маккея–Гласса, описывающее процесс

выработки красных кровяных клеток в

живых организмах:

![]() .

Уравнение генератора с запаздывающей

обр. связью, популярного в радиофизике:

.

Уравнение генератора с запаздывающей

обр. связью, популярного в радиофизике:![]() .

Эти ДС являются бесконечномерными, т.к.

при задании начальных условий необходимо

указать распределение динамической

переменной на временном отрезке [0,

.

Эти ДС являются бесконечномерными, т.к.

при задании начальных условий необходимо

указать распределение динамической

переменной на временном отрезке [0, ].

Эти системы демонстрируют большое

кол-во режимов (аттракторов в ФП,

мультистабильность, хаос и прочие).

].

Эти системы демонстрируют большое

кол-во режимов (аттракторов в ФП,

мультистабильность, хаос и прочие).

3 .7.4.

Дифференциальные уравнения в частных

производных –

классический аппарат для моделирования

колебательных систем. Наиболее известные

модели – уравнения Максвелла, Шредингера,

ур-е типа реакция-диффузия и т.д.

.7.4.

Дифференциальные уравнения в частных

производных –

классический аппарат для моделирования

колебательных систем. Наиболее известные

модели – уравнения Максвелла, Шредингера,

ур-е типа реакция-диффузия и т.д.

– ур-е простой волны, где

– ур-е простой волны, где

–

распространения возмущения,

–

распространения возмущения,

- пространственная координата.

- пространственная координата.

– уравнение Кортевега – де Вриза

(описывает волны солитонного типа –

локализованные возмущения, распространяющиеся

с постоянной скоростью без изменения

формы).

– уравнение Кортевега – де Вриза

(описывает волны солитонного типа –

локализованные возмущения, распространяющиеся

с постоянной скоростью без изменения

формы).

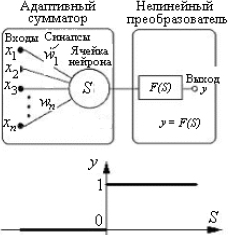

3.8.

Искусственные нейронные сети

– вид мат. моделей, которые строятся по

принципу организации и функционирования

их биологических прототипов – сетей

нервных клеток (нейронов) мозга.

Используется идея о том, что нейроны

можно моделировать довольно простыми

автоматами (искусственными нейронами),

а вся сложность мозга, гибкость его

функционирования и другие важнейшие

качества определяются связями между

нейронами. Искусственный

нейрон состоит из

адаптивного сумматора и нелинейного

преобразователя. На его входы подается

вектор входных значений переменной

{xn}.

Каждому входу xi

соответствует свой

вес wi.

Сумматор осуществляет взвешенное

(адаптивное, подстраивающееся с помощью

весов) суммирование входов

,

а нелинейный преобразователь формирует

сигнал на выходе нейрона

,

а нелинейный преобразователь формирует

сигнал на выходе нейрона

.

Выбор функции активации F

нейрона определяется:

1) спецификой задачи, 2) удобством

реализации на ЭВМ, 3) алгоритмом обучения.

.

Выбор функции активации F

нейрона определяется:

1) спецификой задачи, 2) удобством

реализации на ЭВМ, 3) алгоритмом обучения.

В полносвязных нейронных сетях каждый нейрон передает свой выходной сигнал остальным нейронам, в том числе и самому себе. Выходными сигналами сети могут быть все или некоторые выходные сигналы нейронов после нескольких тактов функционирования сети. В многослойных нейронных сетях нейроны объединяются в слои. Слой содержит совокупность нейронов с едиными входными сигналами. Число нейронов в слое может быть любым и не зависит от количества нейронов в других слоях. Состав: входной слой, скрытые слои, выходной слой. В зависимости от того, передают ли последующие слои свои сигналы на предыдущие слои, различают сети прямого распространения и сети с обратными связями. Свойства ИНС: 1. Обучаемость. Выбрав одну из архитектур НС и свойства нейронов, а также проведя алгоритм обучения, можно «обучить» сеть решению задачи, которая ей по силам. Нет гарантий, что это удастся сделать всегда, но во многих случаях обучение бывает успешным. 2. Способность к обобщению. После обучения сеть становится нечувствительной к малым изменениям входных сигналов (шуму) и дает правильный результат на выходе. 3. Способность к абстрагированию. Если предъявить сети несколько искаженных вариантов входного образа, то сеть сама может создать на выходе идеальный образ, с которым она никогда не встречалась. Решаемые задачи: распознавание образов (зрительных, слуховых), реализация ассоциативной памяти, кластеризация (разбиение изучаемой совокупности объектов на группы схожих между собой), аппроксимация функций, предсказание временных рядов, управление, принятие решений, диагностика. Обучение с учителем. При этом для построения решения используется обучающая выборка – пары известных входных-выходных значений. Обучение без учителя. Имеется набор входных векторов. Обучить сеть означает подобрать ее параметры так, чтобы она некоторым «оптимальным» образом классифицировала входные векторы.

4![]() .2.

Базовые модели случайных процессов

СП можно задать, определив явно

конечномерные законы распределения

вероятностей. Так вводятся базовые

модели теории случайных процессов.

1) Нормальный

(гауссовский)

случайный процесс – для него все

конечномерные законы распределения

являются нормальными. n-мерный

закон распределения имеет вид ..,

.2.

Базовые модели случайных процессов

СП можно задать, определив явно

конечномерные законы распределения

вероятностей. Так вводятся базовые

модели теории случайных процессов.

1) Нормальный

(гауссовский)

случайный процесс – для него все

конечномерные законы распределения

являются нормальными. n-мерный

закон распределения имеет вид .., ![]() где

m(t) – мат. ожидание, K – АКФ, T –

транспонирование, |Vn|

- определтель матрицы Vn.

где

m(t) – мат. ожидание, K – АКФ, T –

транспонирование, |Vn|

- определтель матрицы Vn.

2) Процесс с независимыми приращениями; 3) Белый шум; 4) Дискретный БШ – независимые одинаково распределенные СВ; 5) Марковский процесс; 6) Цепь Маркова; 7) Винеровский процесс.