- •1. Особенности языка

- •2.1. Синтаксис языка.

- •2.2. Типы вопросов.

- •2.3. Рекурсия. Декларативная и процедурная семантики.

- •2.4. Встроенные предикаты

- •2.5. Списки

- •3. Основы Турбо-Пролога

- •3.1. Интерфейс пользователя

- •3.2. Структура программ на Турбо-Прологе

- •3.3. Первые примеры

- •Экспертные системы

- •1. Определение и основные требования.

- •Общая структура эс.

- •Правила типа «если - то».

- •Продукционные системы.

- •Продукции

- •Рабочая память.

- •Механизм вывода (интерпретатор правил).

- •Машина вывода.

- •Различные стратегии поиска вывода.

- •Перцептро́н

Перцептро́н

(неверно: персептрон, англ. perсeptron от лат. perсeptio — восприятие)

Перцептрон – это математическая и компьютерная модель восприятия информации мозгом (кибернетическая модель мозга), предложенная Фрэнком Розенблаттом в 1957 году и реализованная в виде электронной машины «Марк-1» в 1960 году. Перцептрон стал одной из первых моделей нейросетей, а «Марк-1» — первым в мире нейрокомпьютером. Несмотря на свою простоту, перцептрон способен обучаться и решать довольно сложные задачи.

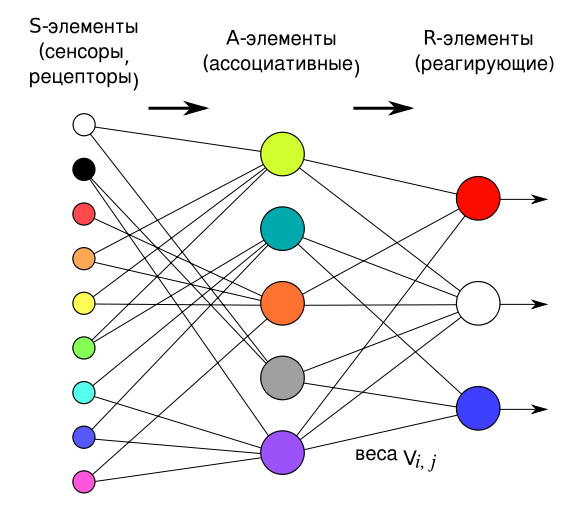

Перцептрон состоит из трёх типов элементов: поступающие от сенсоров сигналы передаются ассоциативным элементам, а затем реагирующим элементам. Таким образом, перцептрон позволят создать набор «ассоциаций» между входными стимулами и необходимой реакцией на выходе. В биологическом плане это соответствует преобразованию, например, зрительной информации в физиологический ответ от двигательных нейронов. Согласно современной терминологии, перцептроны могут быть классифицированы как искусственные нейронные сети:

-

с одним скрытым слоем;

-

с пороговой передаточной функцией;

-

с прямым распространением сигнала.

На фоне «романтизма» нейронных сетей, в 1969 году вышла книга М. Минского и С. Паперта, которая показала принципиальные ограничения перцептронов. Это привело к смещению интереса исследователей искусственного интеллекта в противоположную от нейросетей область — символьных вычислений. Кроме того, из-за сложности математического анализа перцептронов, а также отсутствия общепринятой терминологии, возникли различные неточности и заблуждения. Впоследствии интерес к нейросетям, и в частности, работам Розенблатта, возобновился.

В 1943 году в своей статье «Логическое исчисление идей, относящихся к нервной активности» У. Мак-Каллок и У. Питтс предложили понятие искусственной нейронной сети. В частности, ими была предложена модель искусственного нейрона. Д. Хебб в работе «Организация поведения» 1949 года описал основные принципы обучения нейронов.

Эти идеи несколько лет спустя развил американский нейрофизиолог Фрэнк Розенблатт. Он предложил схему устройства, моделирующего процесс человеческого восприятия, и назвал его перцептроном. Перцептрон передавал сигналы от фотоэлементов, представляющих собой сенсорное поле, в блоки электромеханических ячеек памяти. Эти ячейки соединялись между собой случайным образом в соответствии с принципами коннективизма. В 1957 году в Корнелльской Лаборатории Аэронавтики успешно были завершено моделирование работы перцептрона на компьютере IBM 704, а два года спустя, 23 июня 1960 года в Корнелльском университете, был продемонстрирован первый нейрокомпьютер — «Марк-1», который был способен распознавать некоторые из букв английского алфавита.

Чтобы «научить» перцептрон классифицировать образы, был разработан специальный итерационный метод обучения проб и ошибок, напоминающий процесс обучения человека. Кроме того, при распознании той или иной буквы перцептрон мог выделять характерные особенности буквы, статистически чаще встречающиеся, чем малозначимые отличия в индивидуальных случаях. Тем самым перцептрон был способен обобщать буквы, написанные различным образом (почерком), в один обобщённый образ. Однако возможности перцептрона были ограниченными: машина не могла надежно распознавать частично закрытые буквы, а также буквы иного размера, расположенные со сдвигом или поворотом, нежели те, которые использовались на этапе ее обучения.

Отчёт по первым результатам появился ещё в 1958 году — тогда Розенблаттом была опубликована статья «Перцептрон: Вероятная модель хранения и организации информации в головном мозге». Но подробнее свои теории и предположения относительно процессов восприятия и перцептронов он описывает 1962 году, в книге «Принципы нейродинамики: Перцептроны и теория механизмов мозга». В книге он рассматривает не только уже готовые модели перцептрона с одним скрытым слоем, но и многослойных перцептронов с перекрёстными (третья глава) и обратными (четвёртая глава) связями. В книге также вводится ряд важных идей и теорем, например, доказывается теорема сходимости перцептрона.

Марвин Минский и Сеймур Паперт опубликовали в 1969 г. книгу «Перцептроны», где математически показали, что перцептроны, подобные розенблаттовским, принципиально не в состоянии выполнять многие из тех функций, которые приписывал перцептронам Розенблатт. Эта книга существенно повлияла на пути развития науки об искусственном интеллекте, так как переместила научный интерес и субсидии правительственных организаций США на другое направление исследований — символьный подход в ИИ.

В 80-х годах интерес к кибернетике возродился, так как сторонники символьного подхода в ИИ так и не смогли подобраться к решению вопросов о «Понимании» и «Значении», из-за чего машинный перевод и техническое распознавание образов до сих пор обладает неустранимыми недостатками. Сам Минский публично выразил сожаление, что его выступление нанесло урон концепции перцептронов, хотя книга лишь показывала недостатки отдельно взятого устройства и некоторых его вариаций. Но в основном ИИ стал синонимом символьного подхода, который выражался в составлении все более сложных программ для компьютеров, моделирующих сложную деятельность человеческого мозга.

ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ПЕРЦЕПТРОНОВ

Серьезное ознакомление с теорией перцептронов требует знания базовых определений и теорем, совокупность которых и представляет собой базовую основу для всех последующих видов искусственных нейронных сетей. Но как минимум необходимо, понимание хотя бы с точки зрения теории сигналов, являющиеся оригинальным, то есть описаное автором перцептрона Ф. Розенблаттом.

Описание на основе сигналов

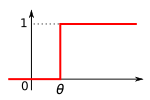

Пороговая функция, реализуемая простыми S- и A-элементами.

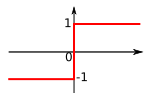

Пороговая функция, реализуемая простым R-элементом.

Для начала определим составные элементы перцептрона, которые являются частными случаями искусственного нейрона с пороговой передаточной функцией.

-

Простым S-элементом (сенсорным) является чувствительный элемент, который от воздействия какого-либо из видов энергии (например, света, звука, давления, тепла и т. п.) вырабатывает сигнал. Если входной сигнал превышает некоторый порог θ, на выходе элемента получаем +1, в противном случае — 0.

-

Простым A-элементом (ассоциативным) называется логический решающий элемент, который даёт выходной сигнал +1, когда алгебраическая сумма его входных сигналов равна или превышает некоторую пороговую величину θ (говорят, что элемент активный), в противном случае выход равен нулю.

-

Простым R-элементом (реагирующим, т. е. действующим) называется элемент, который выдаёт сигнал +1, если сумма его входных сигналов является строго положительной, и сигнал −1, если сумма его входных сигналов является строго отрицательной. Если сумма входных сигналов равна нулю, выход считается либо равным нулю, либо неопределённым.

Если на выходе любого элемента мы получаем 1, то говорят, что элемент активен или возбуждён.

Все рассмотренные элементы называются простыми, так как они реализуют скачкообразные функции. Розенблатт утверждал также, что для решения более сложных задач могут потребоваться другие виды функций, например, линейная.

В результате Розенблатт ввёл следующие определения:

-

Перцептрон представляет собой сеть, состоящую из S-, A-, R-элементов, с переменной матрицей взаимодействия V (элементы которой ui — весовые коэффициенты), определяемой последовательностью прошлых состояний активности сети.

ОПИСАНИЕ ЭЛЕМЕНТАРНОГО ПЕРЦЕПТРОНА

Поступление сигналов с сенсорного поля в решающие блоки элементарного перцептрона в его физическом воплощении.

Элементарный перцептрон состоит из элементов 3-х типов: S-элементов, A-элементов и одного R-элемента. S-элементы это — слой рецепторов. Эти рецепторы соединены с A-элементами с помощью возбуждающих связей. Каждый рецептор может находиться в одном из двух состояний — покоя или возбуждения. A-элементы представляют собой сумматоры с порогом (то есть формальные нейроны). Это означает, что A-элемент возбуждается, если алгебраическая сумма возбуждений, приходящих к нему от рецепторов, превышает определённую величину — его порог. Сигналы от возбудившихся A-элементов передаются в сумматор R, причём сигнал от i-го ассоциативного элемента передаётся с коэффициентом vi.

А- или R-элементы (которые является пороговыми) подсчитывают некоторую линейную форму (как правило, сумму весовых коэффициентов) от своих входов и сравнивает её с заданным значением — порогом. Если у А-элемента n входов, то в нем должны быть заданы n весов v1,v2,...,vn и порог θ. Перцептрон выдаёт 1, если линейная форма от входов с коэффициентами vi превышает θ, иначе −1.

![]()

![]()

Логическая схема элементарного перцептрона. Веса S—A связяй могут либо 1, либо 0. Веса A—R связей V могут быть любыми.

Система связей между рецепторами S- и A-элементами, так же как и пороги A-элементов выбираются некоторым случайным, но фиксированным образом, а обучение состоит лишь в изменении коэффициентов vi. Считаем, что мы хотим научить перцептрон разделять два класса объектов, и потребуем, чтобы при предъявлении объектов первого класса выход перцептрона был положителен, а при предъявлении объектов второго класса — отрицательным. Начальные коэффициенты vi полагаем равными нулю. Далее предъявляем обучающую выборку: объекты (например, круги либо квадраты) с указанием класса, к которым они принадлежат. Показываем перцептрону объект первого класса. При этом некоторые A-элементы возбудятся. Коэффициенты vi, соответствующие этим возбуждённым элементам, увеличиваем на 1. Затем предъявляем объект второго класса и коэффициенты vi тех A-элементов, которые возбудятся при этом показе, уменьшаем на 1. Этот процесс продолжим для всей обучающей выборки. В результате обучения сформируются значения весов связей vi.

После обучения перцептрон готов работать в режиме распознавания или обобщения. В этом режиме перцептрону предъявляются «не знакомые» перцептрону объекты, и перцептрон должен установить, к какому классу они принадлежат. Работа перцептрона состоит в следующем: при предъявлении объекта возбудившиеся A-элементы передают сигнал R-элементу, равный сумме соответствующих коэффициентов vi. Если эта сумма положительна, то принимается решение, что данный объект принадлежит к первому классу, а если она отрицательна — то второму.

ЛИТЕРАТУРА К КУРСУ «БАЗЫ ЗНАНИЙ И ЭКСПЕРТНЫЕ СИСТЕМЫ»

1. Джарратано Д., Райли Г. "Экспертные системы. :Принципы разработки и программирование. М.: «Вильямс», 2007.

2. Логический подход к искусственному интеллекту: от классической логики к логическому программированию. / Тейз А., Грибомон П. и др. — М.: Мир, 1990.

3. Логический подход к искусственному интеллекту: от модальной логики к логике баз данных. / Тейз А., Грибомон П. и др. — М.: Мир, 1998.

4. Джексон П. Введение в экспертные системы. М., СПб, Киев: «Вильямс», 2001.

5. Гаврилова Т.А., Хорошевский В.Ф. Базы знаний интеллектуальных систем. — СПб: Питер, 2000.

6. Ин Ц,. Соломон Д., Использование Турбо-Пролога. М., Мир, 1993.

7. Хайкин, С. Нейронные сети: Полный курс 2-е изд. — М.: «Вильямс», 2006.