- •6.3. Синхронна мережа Гопфілда

- •6.4. Неперервна мережа Гопфілда

- •6.5. Асоціативна мережа вsв

- •7. Синергетичний комп’ютер

- •8. Мережа хеммінга

- •9. Динамічні рекурсивні шнм

- •9.1. Структура дрм

- •9.2. Неперервні дрм

- •9.3. Дискретна дрм

- •9.3.2. Частково-рекурсивні мережі

- •9.3.3. Локально-рекурсивні мережі прямого поширення

- •9.4. Навчання дрм

- •9.4.1. Алгоритм зворотного поширення помилки

- •9.4.2. Адаптивний алгоритм навчання

- •10. Мережа векторного квантування

- •10.1. Структура мережі векторного квантування

- •10.2. Неконтрольоване навчання мережі вк

- •10.3. Контрольоване навчання мережі вк

- •10.3.1. Lvq1

- •10.3.2. Lvq2.1

9.3. Дискретна дрм

Рівняння, що описує динаміку дискретної ДРМ, здобувається із (9.1) шляхом переходу до кінцевих різниць, а елементи вагової матриці є розв’язком системи рівнянь

При

поведінка неперервної й дискретної ДРМ

ідентична. У загальному ж випадку

поведінка обох мереж навіть при однакових

значеннях елементів вагової матриці

різна (наприклад, якщо одна досягає

стійкого стану, то інша може осцилювати).

поведінка неперервної й дискретної ДРМ

ідентична. У загальному ж випадку

поведінка обох мереж навіть при однакових

значеннях елементів вагової матриці

різна (наприклад, якщо одна досягає

стійкого стану, то інша може осцилювати).

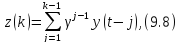

Від опису (9.4) можна перейти до опису в просторі станів виду

де z(і) — стан мережі в момент часу і.

Розглянемо деякі різновиди дискретних ДРМ.

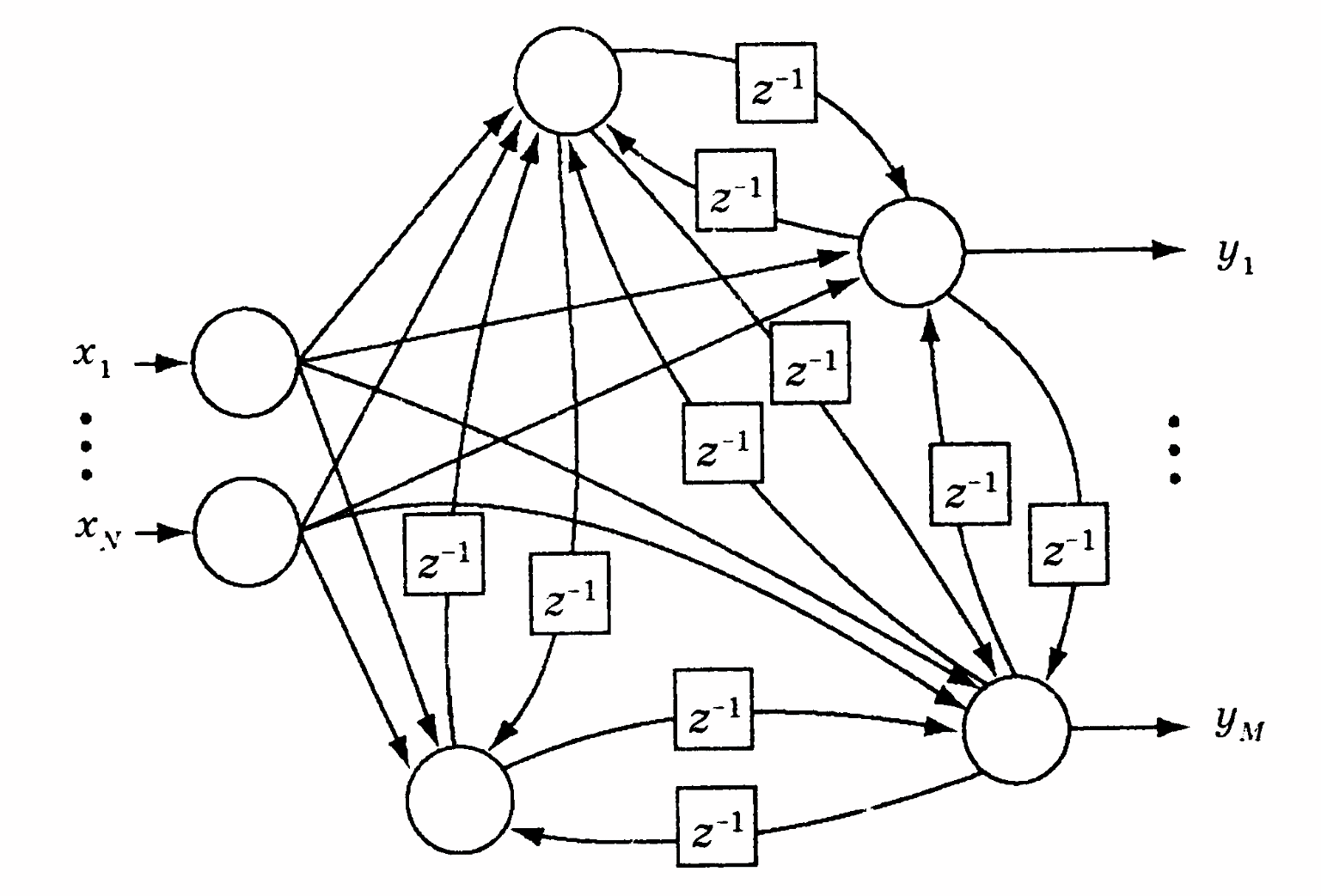

9.3.1. Повнозв’язні ДРМСтруктуру повнозв’язної ДРМ наведено на рис. 9.2. ДРМ даного типу вивчалися в роботах [19, 89-91].

Рис. 9.2. Повнозв’язна ДРМ

Подана архітектура була спочатку запропонована для розв’язання задач, пов’язаних з аналізом й обробкою послідовностей, але згодом була використана також для ідентифікації нелінійних динамічних об’єктів. Однак цій мережі властивий серйозний недолік — повільна збіжність (істотна тривалість процесу навчання) і проблеми стійкості, які при цьому виникають [38].

9.3.2. Частково-рекурсивні мережі

Рекурсивні мережі дуже зручні для розв’язання задач розпізнавання, класифікації образів і прогнозування часових рядів. Іноді замість одиничних образів на вхід мережі подається одночасно послідовність ю часткових образів у вигляді деякого вікна, що зміщується при надходженні кожного нового образу назад. Хоча таке ковзне вікно може бути реалізоване за допомогою ШНМ прямого поширення, більш ефективним є розв’язання таких задач за допомогою частково-рекурсивних мереж. Дані мережі займають проміжну позицію між «чистими» мережами прямого поширення й «чистими» рекурсивними мережами.

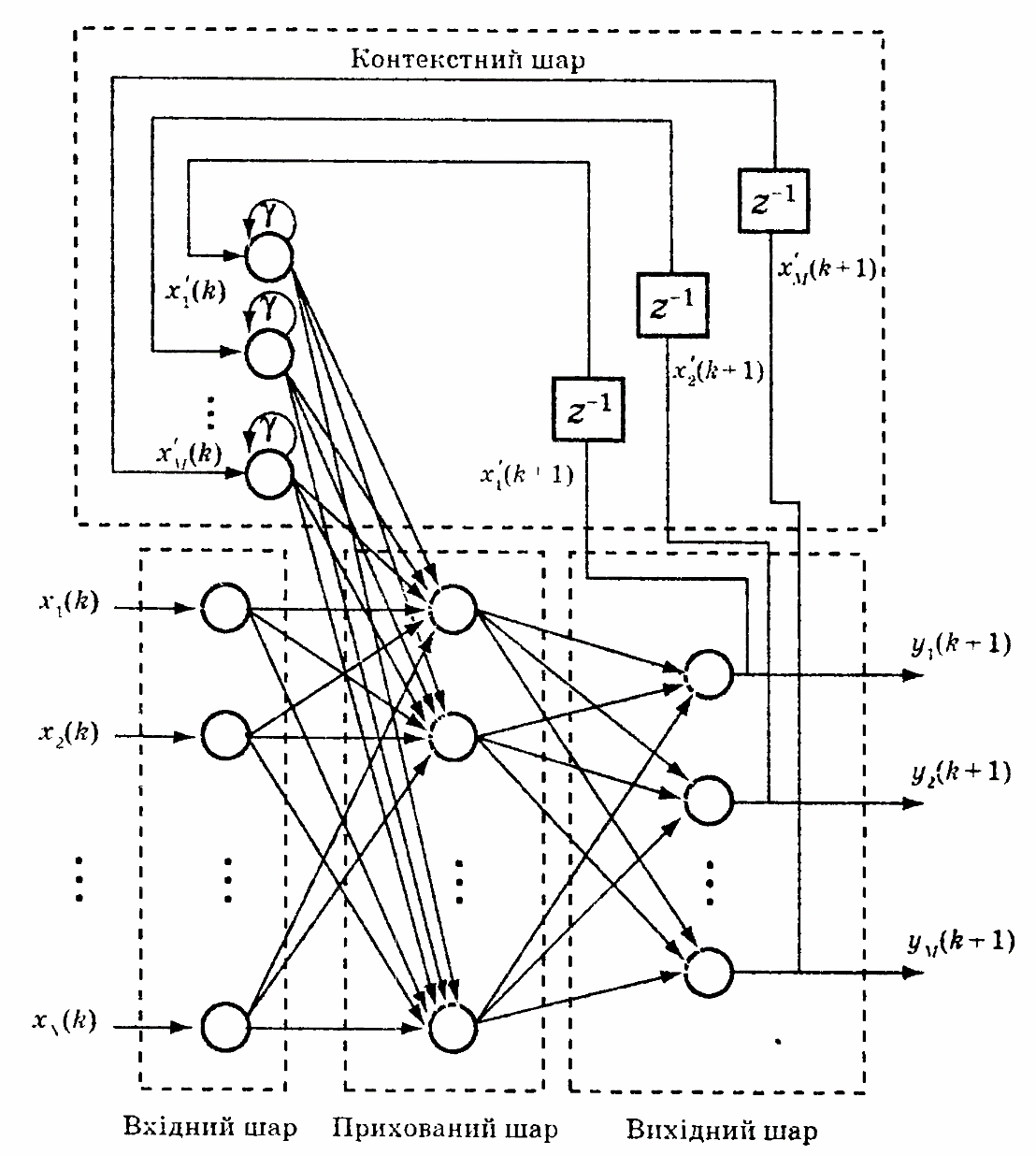

На відміну від повнозв’язних ДРМ, частково-рекурсивні мережі представляють багатошаровий персептрон, доповнений так званим контекстним шаром, нейрони якого реалізують пам’ять мережі.

Запропонована М. Джорданом мережа є ШНМ прямого поширення, доповненою шаром контекстних нейронів (рис. 9.3), кількість яких збігається з кількістю виходів ШНМ [92].

Рис. 9.3. Мережа Джордана

Вхідні

сигнали мережі разом із сигналами

контекстного шару надходять на входи

нейронів прихованого шару, вихідні

сигнали яких передаються на вихідний

шар. Виходи нейронів цього шару є виходами

ШНМ. Крім того, вихідні сигнали у вигляді

сигналів зворотного зв’язку передаються

з вагами

на контекстний шар. Нейрони контекстного

шару мають власні зворотні зв’язки з

вагою

на контекстний шар. Нейрони контекстного

шару мають власні зворотні зв’язки з

вагою ,

що звичайно не змінюється.

,

що звичайно не змінюється.

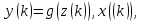

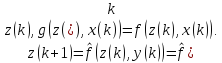

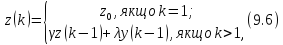

Вихідний сигнал мережі в кожен момент часу залежить від значення вхідного сигналу й стану, накопиченого в контекстному шарі. Тому мережа описується рівнянням і (9.5)

де z(к) — стан у момент часу k;g, f — функції, що визначають відповідно вихід і стан мережі на наступному такті (у теорії цифрових автоматів їх називають функціями виходів і переходів відповідно).

Те, що стан z(k + 1) залежить від z(k) і х(к), видно з топології мережі

Послідовна

зміна станів нейронів при деякому

початковому стані

описується формулою

описується формулою

тобто

де

є

(0,1]

— ваговий параметр зворотного зв’язку

(звичайно

є

(0,1]

— ваговий параметр зворотного зв’язку

(звичайно

=

1).

=

1).

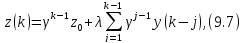

Якщо

= 0 и

= 0 и = 1, то

= 1, то

тобто стан є експоненційно зваженою сумою всіх вихідних сигналів, що були до цього часу.

При

малих значеннях

вплив

попередніх станів малий, а при

вплив

попередніх станів малий, а при

1 великий. При

1 великий. При

= 1 всі стани мають однакову вагу

(використання параметра

= 1 всі стани мають однакову вагу

(використання параметра <

1, з одного боку, зменшує вплив образів,

що раніше надійшли на поточний, а з

іншого — дозволяє врахувати цей вплив).

Зазвичай приймають

<

1, з одного боку, зменшує вплив образів,

що раніше надійшли на поточний, а з

іншого — дозволяє врахувати цей вплив).

Зазвичай приймають

0,5.

0,5.

У

процесі навчання мережі ваги

не

змінюються. Хоча принципово зміна

не

змінюються. Хоча принципово зміна можлива,

проте, як свідчать дослідження, це лише

призводить до затягування процесу

навчання без істотного поліпшення

роботи ШНМ. Однак питання вибору

можлива,

проте, як свідчать дослідження, це лише

призводить до затягування процесу

навчання без істотного поліпшення

роботи ШНМ. Однак питання вибору

,

малі

значення якого дозволяють краще реагувати

на образ, що знову надійшов, а більші

— забезпечувати накопичення всіх

образів, що надійшли раніше, залишається

відкритим.

,

малі

значення якого дозволяють краще реагувати

на образ, що знову надійшов, а більші

— забезпечувати накопичення всіх

образів, що надійшли раніше, залишається

відкритим.

Мережа Джордана здатна асоціювати різні вхідні образи з різними вихідними послідовностями.

Мережа Дж. Елмана [93] є модифікацією мережі Джордана, у якій сигнали зворотних зв’язків надходять не з вихідного шару, а з виходів нейронів прихованого шару, тому кількість нейронів контекстного й прихованого шарів збігається. Крім того, тут немає власних зворотних зв’язків нейронів контекстного шару. Дані нейрони виконують роль функції активації. Надходження на вхід мережі першого образу активує нейрони всіх шарів: прихованого, вихідного й контекстного. Оскільки нейрони контекстного шару відіграють роль, аналогічну активаційній функції, вони перейдуть у новий стан, що відповідає стану нейронів прихованого шару, тобто копіюють (запам’ятовують) інформацію. З виходів нейронів прихованого шару сигнал передається на входи нейронів вихідного шару, які й формують вихідний сигнал мережі. При надходженні наступного образу стан нейронів контекстного шару відповідає попередньому образу.

Основним завданням нейронів прихованого шару є генерація бажаного вихідного сигналу на підставі порівняння образу, що знову надійшов, і образу, що запам’ятався в контекстному шарі.

Найпростіша мережа Елмана складається з одного прихованого й одного контекстного шару нейронів (рис. 9.4).

Для розв’язання складніших задач використовують ієрархічну частково-рекурсивну мережу, у якій кожен прихований шар має свій контекстний (рис. 9.5).

Можливості

мережі різко зростають внаслідок

можливості вибору різних значень

.

.

Якщо відкинути сигнали зворотних зв’язків, що надходять на контекстний шар, то вийде чиста мережа прямого поширення, у якої контекстний шар є додатковим вхідним. Тому розширеий вхідний вектор складається із безпосередньо вхідного вектора х і вектора станів нейронів контекстного шару z, що визначається на кожному такті функцією переходів.