- •6.3. Синхронна мережа Гопфілда

- •6.4. Неперервна мережа Гопфілда

- •6.5. Асоціативна мережа вsв

- •7. Синергетичний комп’ютер

- •8. Мережа хеммінга

- •9. Динамічні рекурсивні шнм

- •9.1. Структура дрм

- •9.2. Неперервні дрм

- •9.3. Дискретна дрм

- •9.3.2. Частково-рекурсивні мережі

- •9.3.3. Локально-рекурсивні мережі прямого поширення

- •9.4. Навчання дрм

- •9.4.1. Алгоритм зворотного поширення помилки

- •9.4.2. Адаптивний алгоритм навчання

- •10. Мережа векторного квантування

- •10.1. Структура мережі векторного квантування

- •10.2. Неконтрольоване навчання мережі вк

- •10.3. Контрольоване навчання мережі вк

- •10.3.1. Lvq1

- •10.3.2. Lvq2.1

7. Синергетичний комп’ютер

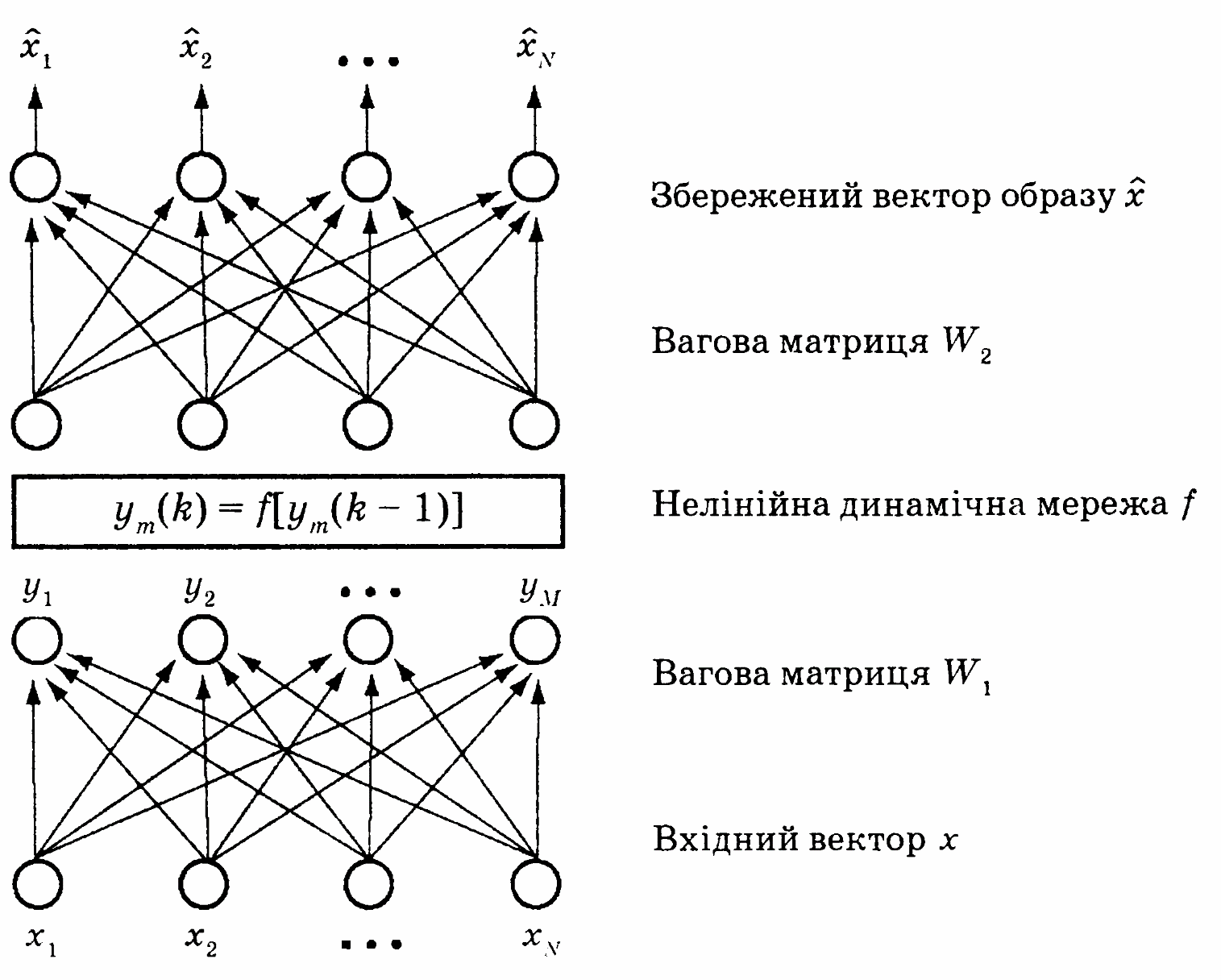

Дана мережа запропонована засновником синергетики Х.Хаке- ном [87, 88] як ШНМ, функціонування якої може бути пояснене із синергетичної точки зору. Ця мережа має багато спільного з мережею Гопфілда й більш того, може розглядатися як один з її варіантів, що працює з аналоговими сигналами. Цей комп’ютер відноситься до асоціаторів, а збережені в ньому образи можуть бути інтерпретовані як локальні енергетичні мінімуми. Відмінність його від мережі Гопфілда полягає в тому, що його нейрони не містять нелінійностей, оскільки нелінійне перетворення здійснюється спеціальним модулем. Принцип побудови «синергетичного комп’ютера» наведено на рис. 7.1.

Рис. 7.1. Синергетичний комп’ютер

ШНМ

складається із вхідного шару, на який

надходить зашум- лений або спотворений

N-вимірний

образ, що відповідає одному з М

збережених

.

Вхідний вектор х

перетвориться нейронним шаром з ваговою

матрицею

.

Вхідний вектор х

перетвориться нейронним шаром з ваговою

матрицею

Вихідним сигналом шару єМ-вимірний

вектор у,

кількість компонент якого збігається

із кількістю збережених образів. Цей

вектор у

подається на модуль, описуваний системою

нелінійних диференціальних рівнянь,

що після деякої кількості ітерацій

обчислює нові значення компонент

Вихідним сигналом шару єМ-вимірний

вектор у,

кількість компонент якого збігається

із кількістю збережених образів. Цей

вектор у

подається на модуль, описуваний системою

нелінійних диференціальних рівнянь,

що після деякої кількості ітерацій

обчислює нові значення компонент

векторау.

Вектор у

зі знову обчисленими компонентами

подається на наступний шар через

матрицю

векторау.

Вектор у

зі знову обчисленими компонентами

подається на наступний шар через

матрицю

Вихідним сигналом останнього шару

Вихідним сигналом останнього шару є

N-вимірний вектор, що відповідає образу

є

N-вимірний вектор, що відповідає образу .

Отже,

асоціативний виклик накопиченого образу

здійснюється подачею на вхід вектора

х.

.

Отже,

асоціативний виклик накопиченого образу

здійснюється подачею на вхід вектора

х.

Вибір

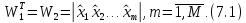

значень елементів матриць

й

й дуже простий — вони визначаються

безпосередньо векторами збережених

образів за формулою

дуже простий — вони визначаються

безпосередньо векторами збережених

образів за формулою

Щоб простіше було зрозуміти роботу мережі, розглянемо окремі етапи обчислення вихідного образу.

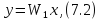

Вихідний сигнал першого шару визначається як

тобто

є скалярним добутком векторів

іх,

що тим більше, чим ближче розташовані

ці вектори. Таким

чином,

компоненти вихідного сигналу у

характеризують міру подібності

накопиченого образу

іх,

що тим більше, чим ближче розташовані

ці вектори. Таким

чином,

компоненти вихідного сигналу у

характеризують міру подібності

накопиченого образу

пропонованому х,

і якщо пропонований образ х

буде найближчим до збереженого

пропонованому х,

і якщо пропонований образ х

буде найближчим до збереженого

,

компонентаm*

вихідного сигналу

,

компонентаm*

вихідного сигналу

матиме

найбільше значення. Компоненти

матиме

найбільше значення. Компоненти

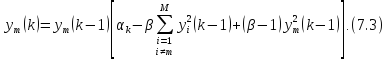

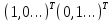

є

початковими значеннями компонентів

вектора y,

що

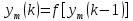

обчислюють за такою рекурсивною формулою:

є

початковими значеннями компонентів

вектора y,

що

обчислюють за такою рекурсивною формулою:

Це рівняння можна розглядати як рівняння руху тіла в потенціальному полі, на яке діє сила, що задається похідною потенціальної функції по координатах тіла.

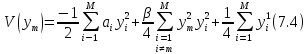

Вибираючи відповідну потенційну функцію у вигляді

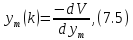

й обчислюючи рівняння руху як

можна

отримати (7.3). Рівняння (7.5) відповідає

градієнтному методу пошуку локального

мінімуму. Можна показати, що найбільший

компонент

збігається

до одиниці, а інші — до нуля. Таким чином,

завдання (7.3) полягає у тому, щоб збільшити

значення найбільшого компонента й

зменшити значення всіх інших. Після

рекурсивних обчислень відповідно до

(7.3) тільки один компонент вихідного

вектора дорівнюватиме одиниці, а інші

— нулю. Цей вектор передається з ваговою

матрицею

збігається

до одиниці, а інші — до нуля. Таким чином,

завдання (7.3) полягає у тому, щоб збільшити

значення найбільшого компонента й

зменшити значення всіх інших. Після

рекурсивних обчислень відповідно до

(7.3) тільки один компонент вихідного

вектора дорівнюватиме одиниці, а інші

— нулю. Цей вектор передається з ваговою

матрицею на інший шар (вихідний)

на інший шар (вихідний)

Оскільки

компоненти матриці

обрані відповідно до (7.1), то при надходженні

на цей шар сигналуу,

всі компоненти якого, крім однієї,

обрані відповідно до (7.1), то при надходженні

на цей шар сигналуу,

всі компоненти якого, крім однієї,

ї,

рівної одиниці, дорівнюють нулю,

відповідний вихідний векторі

ї,

рівної одиниці, дорівнюють нулю,

відповідний вихідний векторі точно

відповідатиме

точно

відповідатиме -му

образу

-му

образу ,

що навчає.

,

що навчає.

Якщо

образи

,

що навчають, ортонормовані в М-вимірному

просторі, то подання вхідного вектора

х

й обчислення у

за формулою (7.2) є не що інше, як

обчислення проекції х

на М

базисних векторів. А рекурсивне обчислення

(7.3) і збіжність до 1 означає, що застосування

(7.3) повертає х

до того базисного вектора, проекція

на який у нього найбільша. Після

рекурсивних обчислень вектор у

ідентичний цьому базисному вектору. У

зв’язку з тим, що сигнал у

містить тільки одну одиницю, а всі інші

компоненти нульові, дана система завжди

зводить вхідний вектор х

до однієї з базисних функцій. Оскільки

система (7.3) випливає з потенційної

функції (7.4), то базисні вектори

,

що навчають, ортонормовані в М-вимірному

просторі, то подання вхідного вектора

х

й обчислення у

за формулою (7.2) є не що інше, як

обчислення проекції х

на М

базисних векторів. А рекурсивне обчислення

(7.3) і збіжність до 1 означає, що застосування

(7.3) повертає х

до того базисного вектора, проекція

на який у нього найбільша. Після

рекурсивних обчислень вектор у

ідентичний цьому базисному вектору. У

зв’язку з тим, що сигнал у

містить тільки одну одиницю, а всі інші

компоненти нульові, дана система завжди

зводить вхідний вектор х

до однієї з базисних функцій. Оскільки

система (7.3) випливає з потенційної

функції (7.4), то базисні вектори

тощо є мінімумами потенціальній

функції. А у зв’язку з тим, що базисні

вектори шляхом координатної

трансформації з’являються у вигляді

навчальних образів

тощо є мінімумами потенціальній

функції. А у зв’язку з тим, що базисні

вектори шляхом координатної

трансформації з’являються у вигляді

навчальних образів ,

це означає, що дані образи є мінімумами

потенційної функції (7.4). Отже, як й у

мережі Гопфілда, для образів

«синергетичного комп’ютера», що

навчають, можна задати енергетичну

(потенційну) функцію, мінімуми якої

відповідають цим образам. Пропонований

мережі вхідний образ х

збігається до того мінімуму, в області

притягання (околі) якого він перебуває.

,

це означає, що дані образи є мінімумами

потенційної функції (7.4). Отже, як й у

мережі Гопфілда, для образів

«синергетичного комп’ютера», що

навчають, можна задати енергетичну

(потенційну) функцію, мінімуми якої

відповідають цим образам. Пропонований

мережі вхідний образ х

збігається до того мінімуму, в області

притягання (околі) якого він перебуває.

На

завершення слід зазначити, що «синергетичним

комп’ютером» ця мережа була названа

тому, що основним принципом синергетики

є встановлення (аналіз) стаціонарних

станів динамічної системи, що залежать

від початкових умов й областей притягання

стаціонарних точок системи. Тому система

рівнянь

на

рис. 7.1 описує синергетический модуль

ШНМ. Перетворений першим шаром за

допомогою вагової матриці

на

рис. 7.1 описує синергетический модуль

ШНМ. Перетворений першим шаром за

допомогою вагової матриці

вхідний

сигналх

подається в системі координат, базисні

вектори якої є мінімумами синергетичної

системи, що характеризується потенційною

функцією (7.4) й описується співвідношеннями

(7.3) і (7.4). Рекурсивне обчислення (7.3)

дозволяє досягти локального мінімуму,

тобто базисного вектора, в області

притягання якого перебуває

трансформований вхідний вектор х.

Другий шар мережі за допомогою матриці

вхідний

сигналх

подається в системі координат, базисні

вектори якої є мінімумами синергетичної

системи, що характеризується потенційною

функцією (7.4) й описується співвідношеннями

(7.3) і (7.4). Рекурсивне обчислення (7.3)

дозволяє досягти локального мінімуму,

тобто базисного вектора, в області

притягання якого перебуває

трансформований вхідний вектор х.

Другий шар мережі за допомогою матриці

здійснює зворотну трансформацію

базисного вектора в область образів,

що навчають, і викликає асоціативно

вектор образів

здійснює зворотну трансформацію

базисного вектора в область образів,

що навчають, і викликає асоціативно

вектор образів ,

що відповідає мінімуму потенційної

функції.

,

що відповідає мінімуму потенційної

функції.

Слід зазначити, що кількість збережених образів М не може бути більше розмірності образу N.

На

відміну від мережі Гопфілда, «синергетичний

комп’ютер» не має нестійких станів

(spurious

states).

Це

пояснюється тим, що його динамічний

модуль завжди збігається до одного з

базисних векторів. А оскільки завжди

в процесі навчання тільки один компонент

у

дорівнюватиме одиниці, а всі інші нулю,

то й завжди забезпечується виклик

одного з образів

шляхом обчислення

шляхом обчислення

Контрольні запитання

Якою є структура синергетичного комп’ютера?

Як відбувається навчання синергетичного комп’ютера?

У чому відмінність синергетичного комп’ютера від мережі Гопфілда?