- •Принципы системного подхода

- •Принятие решений в условиях неопределенности

- •Критерий Гурвица

- •Теория многомерной полезности

- •1. Составные части системного анализа, основные определения.

- •4. Экспертные методы выбора решений.

- •2. Основные понятия исследования операций

- •3. Критерий Лапласа

- •Мера Шеннона, как обобщение меры Хартли для неравновероятных событий.

- •1 Задача принятия оптимальных решений

- •2 Задача линейного программирования

- •3 Задача нелинейного программирования

- •4 Задача стохастического программирования

- •Принятие решений в условиях риска

- •Критерий предельного уровня.

- •Критерий наиболее вероятного исхода.

- •Методология принятия решений в условиях риска и неопределенности. Матрица решений

- •Критерий Сэвиджа

- •Основные определения теории нечетких множеств

- •Метод анализа иерархий

2. Основные понятия исследования операций

Операцией называется всякое мероприятие (система действий), объединенное единым замыслом и направленное к достижению какой-то цели.

Цель исследования операций - предварительное количественное обоснование оптимальных решений.

Всякий определенный выбор зависящих от нас параметров называется решением. Оптимальным называются решения, по тем или другим признакам предпочтительные перед другими.

Параметры, совокупность которых образует решение, называются элементами решения.

Множеством допустимых решений называются заданные условия, которые фиксированы и не могут быть нарушены.

Показатель эффективности - количественная мера, позволяющая сравнивать разные решения по эффективности.

Все решения принимаются всегда на основе информации, которой располагает лицо принимающее решение (ЛПР).

Каждая задача в своей постановке должна отражать структуру и динамику знаний ЛПР о множестве допустимых решений и о показателе эффективности.

Задача называется статической, если принятие решения происходит в наперед известном и не изменяющемся информационном состоянии. Если информационное состояние в ходе принятия решения сменяют друг друга, то задача называется динамической.

Информационные состояния ЛПР могут по-разному характеризовать его физическое состояние:

-

Если информационное состояние состоит из единственного физического состояния, то задача называется определенной.

-

Если информационное состояние содержит несколько физических состояний и ЛПР кроме их множества знает еще и вероятности каждого из этих физических состояний, то задача называется стохастической (частично неопределенной).

Если информационное состояние содержит несколько физических состояний, но ЛПР кроме их множества ничего не знает о вероятности каждого из этих физических состояний, то задача называется неопределенной.

3. Критерий Лапласа

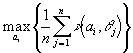

Этот критерий опирается на известный принцип недостаточного обоснования. Поскольку вероятности состояний q 1, q 2, ... ,q n не известны, необходимая информация для вывода, что эти вероятности различны, отсутствует. В противном случае можно было бы определить эти вероятности и ситуацию уже не следовало рассматривать как принятие решения в условиях неопределенности. Так как принцип недостаточного обоснования утверждает противоположное, то состояния q 1, q 2, ...,q n имеют равные вероятности. Если согласиться с приведенными доводами, то исходную задачу можно рассматривать как задачу принятия решений в условиях риска, когда выбирается действие ai , дающее ожидаемый выигрыш.

Другими словами, находится действие ai* , соответствующее

(1)

(1)

![]() -

вероятность реализации состояния q j (

j=1,2, ... ,n),

-

вероятность реализации состояния q j (

j=1,2, ... ,n),

Пример. Одно из предприятий должно определить уровень предложения услуг так, чтобы удовлетворить потребности клиентов в течение предстоящих праздников. Точное число клиентов не известно, но ожидается, что оно может принять одно из четырех значений: 200, 250, 300 или 350 клиентов. Для каждого из этих возможных значений существует наилучший уровень предложения (с точки зрения возможных затрат). Отклонения от этих уровней приводят к дополнительным затратам либо из-за превышения предложения над спросом, либо из-за неполного удовлетворения спроса.

В таблице приведены потери в тысячах долларов.

Клиенты

Таблица 2 - Уровень предложения

|

|

q 1 |

q 2 |

q 3 |

q 4 |

|

a1 |

5 |

10 |

18 |

25 |

|

a2 |

8 |

7 |

8 |

23 |

|

a3 |

21 |

18 |

12 |

21 |

|

a4 |

30 |

22 |

19 |

15 |

Принцип Лапласа предполагает, что q 1, q 2, q 3, q 4 равновероятны.

Следовательно, P{q =q j } =1/4, j= 1, 2, 3, 4, и ожидаемые потери при различных действиях a1, a2, a3, a4 составляют

E{a1}= (1/4)(5+10+18+25)=14,5

E{a2}= (1/4)(8+7+8+23)=11,5

E{a3}= (1/4)(21+18+12+21)=18,0

E{a4}= (1/4)(30+22+19+15)=21,5

Таким образом, наилучшим уровнем предложения в соответствии с критерием Лапласа будет a2.

4 Принятие решений, как снятие неопределенности (информационный подход)

Процесс получения информации можно рассматривать как уменьшение неопределенности в результате приема сигнала, а количество информации, как количественную меру степени снятия неопределенности.

Но в результате выбора некоторого подмножества альтернатив из множества, т.е. в результате принятия решения, происходит тоже самое (уменьшение неопределенности).

Это значит, что каждый выбор, каждое решение порождает определенное количество информации, а значит может быть описано в терминах теории информации.

Простейшее понятие об информации (подход Хартли).

Будем считать, что если существует множество элементов и осуществляется выбор одного из них, то этим самым сообщается или генерируется определенное количество информации. Эта информация состоит в том, что если до выбора не было известно, какой элемент будет выбран, то после выбора это становится известным.

Найдем вид функции, связывающей количество информации, получаемой при выборе некоторого элемента из множества, с количеством элементов в этом множестве, т.е. с его мощностью.

Если множество элементов, из которых осуществляется выбор, состоит из одного-единственного элемента, то ясно, что его выбор предопределен, т.е. никакой неопределенности выбора нет. Таким образом, если мы узнаем, что выбран этот единственный элемент, то, очевидно, при этом мы не получаем никакой новой информации, т.е. получаем нулевое количество информации.

Если множество состоит из двух элементов, то неопределенность выбора минимальна. В этом случае минимально и количество информации, которое мы получаем, узнав, что совершен выбор одного из элементов. Минимальное количество информации получается при выборе одного из двух равновероятных вариантов. Это количество информации принято за единицу измерения и называется "бит".

Чем больше элементов в множестве, тем больше неопределенность выбора, тем больше информации мы получаем, узнав о том, какой выбран элемент.

Рассмотрим множество, состоящее из чисел в двоичной системе счисления длиной i двоичных разрядов. При этом каждый из разрядов может принимать значения только 0 и 1 (таблица 3).

Таблица 3 – К эвристическому выводу формулы количества информации по Хартли

|

Кол-во двоичных разрядов (i) |

Кол-во состояний N, которое можно пронумеровать i-разрядными двоичными числами |

Основание системы счисления |

||

|

10 |

16 |

2 |

||

|

1 |

2 |

0 1 |

0 1 |

0 1 |

|

2 |

4 |

0 1 2 3 |

0 1 2 3 |

00 01 10 11 |

|

3 |

8 |

0 1 2 3 4 5 6 7 |

0 1 2 3 4 5 6 7 |

000 001 010 011 100 101 110 111 |

|

4 |

16 |

0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 |

0 1 2 3 4 5 6 7 8 9 A B C D E F |

0000 0001 0010 0011 0100 0101 0110 0111 1000 1001 1010 1011 1100 1101 1110 1111 |

|

*** |

*** |

|

|

|

|

i |

N=2i |

|

|

|

Из таблицы 32 очевидно, что количество этих чисел (элементов) в множестве равно:

|

|

|

Рассмотрим процесс выбора чисел из рассмотренного множества. До выбора вероятность выбрать любое число одинакова. Существует объективная неопределенность в вопросе о том, какое число будет выбрано. Эта неопределенность тем больше, чем больше N – количество чисел в множестве, а чисел тем больше – чем больше разрядность i этих чисел.

Примем, что выбор одного числа дает нам следующее количество информации:

|

|

|

Таким образом, количество информации, содержащейся в двоичном числе, равно количеству двоичных разрядов в этом числе. Это количество информации i мы получаем, когда случайным равновероятным образом выпадает одно из двоичных чисел, записанных i разрядами, или из некоторого множества выбирается объект произвольной природы, пронумерованный этим числом (предполагается, что остальные объекты этого множества пронумерованы остальными числами и этим они и отличаются).

Это выражение и представляет собой формулу Хартли для количества информации. Отметим, что оно полностью совпадает с выражением для энтропии (по Эшби), которая рассматривалась им как количественная мера степени неопределенности состояния системы.

Сам Хартли, возможно, пришел к своей мере на основе эвристических соображений, подобных только что изложенным, но в настоящее время строго доказано, что логарифмическая мера для количества информации однозначно следует из этих двух постулированных им условий.

Таким образом, информация по своей сущности теснейшим и органичным образом связана с выбором и принятием решений.

Отсюда следует простейшее на первый взгляд заключение: "Для принятия решений нужна информация, без информации принятие решений невозможно, значение информации для принятия решений является определяющим, процесс принятия решений генерирует информацию".