- •Воронежский институт высоких технологий

- •Содержание

- •Введение

- •1. Понятие информации и подходы к ее количественной оценке

- •1.1 Понятие и виды информации

- •Виды информации

- •1.2 Структурная мера информации

- •1.3 Статистическая мера информации

- •Выражение (1.4) можно записать также в виде

- •1.4 Семантическая мера информации

- •1.5 Преобразование информации

- •1.6 Формы представления информации

- •1.7 Передача информации

- •Передача информации по каналу без помех

- •Передача информации по каналу с помехами

- •Таким образом, скорость передачи по каналу связи с помехами

- •1.8 Общая характеристика фаз преобразования информации

- •Контрольные вопросы

- •2. Алгоритмические основы информатики

- •2.1 Свойства алгоритмов

- •2.2 Виды алгоритмов и их реализация

- •2.3 Методы представления алгоритмов

- •Структурная (блок-) схема алгоритма

- •2.4 Порядок разработки иерархической схемы реализации алгоритмов

- •2.5 Нормальный алгоритм Маркова

- •2.6 Языки программирования

- •2.7 Жизненный цикл программного обеспечения

- •Контрольные вопросы

- •3. Математические основы информатики

- •3.1 Понятие дискретного автомата

- •Логический автомат

- •Автомат с конечной памятью

- •3.2 Машина Тьюринга

- •3.3 Кодирование информации

- •Основные понятия теории кодирования

- •Методы эффективного кодирования информации

- •Кодирование по методу четности-нечетности

- •Коды Хэмминга

- •3.4 Системы счисления

- •Смешанные системы счисления

- •Перевод чисел из одной системы счисления в другую

- •Положим

- •Тогда x1будет правильной дробью и к этому числу можно применить ту же самую процедуру для определения следующего коэффициентаq-2и т.Д.

- •3.5 Представление данных в компьютере Представление целых чисел без знака и со знаком

- •Индикаторы переноса и переполнения

- •Представление символьной информации в эвм

- •Форматы данных

- •Контрольные вопросы

- •4. Прикладная информатика

- •4.1 Информационные категории

- •4.2 Автоматизация деятельности на основе алгоритмизации

- •4.3 Методы автоматизации бизнес-процессов

- •4.4 Базовые понятия и технологии управления данными

- •4.5 Базовые сведения о компьютерной графике и геометрии

- •Способ хранения изображения

- •Фундаментальные недостаткивекторной графики

- •4.6 Введение в информационную безопасность

- •Электронная цифровая подпись: алгоритмы, открытый и секретный ключи, сертификаты

- •Контрольные вопросы

- •5. Программно-аппаратные средства реализации информационных процессов

- •5.1 Операционные системы

- •Классификация ос

- •5.2 Файловые системы

- •Имена файлов

- •Типы файлов

- •Физическая организация и адрес файла

- •Права доступа к файлу

- •Кэширование диска

- •Общая модель файловой системы

- •Отображаемые в память файлы

- •Современные архитектуры файловых систем

- •5.3 Принципы организации эвм

- •Функционирование эвм с шинной организацией

- •Функционирование эвм с канальной организацией

- •5.4 Сетевые технологии обработки данных

- •Понятие локальной вычислительной сети

- •Базовая модель osi (Open System Interconnection)

- •Архитектура лвс

- •Топологии вычислительной сети

- •Сетевые устройства и средства коммуникаций

- •Виды используемых кабелей и сетевого оборудования

- •Типы построения сетей по методам передачи информации

- •5.5 Сеть internet

- •Контрольные вопросы

- •Заключение

- •Список использованных источников

- •Приложение

- •Память эвм

Методы эффективного кодирования информации

Информационную избыточность можно ввести разными путями. Рассмотрим один из путей эффективного кодирования.

В ряде случаев буквы сообщений преобразуются в последовательности двоичных символов. Учитывая статистические свойства источника сообщения, можно минимизировать среднее число двоичных символов, требующихся для выражения одной буквы сообщения, что при отсутствии шума позволит уменьшить время передачи.

Такое эффективное кодирование базируется на основной теореме Шеннона для каналов без шума, в которой доказано, что сообщения, составленные из букв некоторого алфавита, можно закодировать так, что среднее число двоичных символов на букву будет сколь угодно близко к энтропии источника этих сообщений, но не меньше этой величины.

Теорема не указывает конкретного способа кодирования, но из нее следует, что при выборе каждого символа кодовой комбинации необходимо стараться, чтобы он нес максимальную информацию. Следовательно, каждый символ должен принимать значения 0 и 1 по возможности с равными вероятностями и каждый выбор должен быть независим от значений предыдущих символов.

При отсутствии статистической взаимосвязи между буквами конструктивные методы построения эффективных кодов были даны впервые К.Шенноном и Н. Фано. Их методики существенно не различаются, поэтому соответствующий код получил название кода Шеннона-Фано.

Код строится следующим образом: буквы алфавита сообщений выписываются в таблицу в порядке убывания вероятностей. Затем они разделяются на две группы так, чтобы суммы вероятностей в каждой из групп были по возможности одинаковы. Всем буквам верхней половины в качестве первого символа приписывается 1, а всем нижним - 0. Каждая из полученных групп, в свою очередь, разбивается на две подгруппы с одинаковыми суммарными вероятностями и т. д. Процесс повторяется до тех пор, пока в каждой подгруппе останется по одной букве.

Рассмотрим алфавит из восьми букв (табл. 3.4). Ясно, что при обычном (не учитывающем статистических характеристик) кодировании для представления каждой буквы требуется три символа.

Таблица 3.4 – Кодирование по методике Шеннона-Фано

|

Буквы |

Вероятности |

Кодовые комбинации |

|

z1 |

0,22 |

11 |

|

z2 |

0,20 |

101 |

|

z3 |

0,16 |

100 |

|

z4 |

0,16 |

01 |

|

z5 |

0,10 |

001 |

|

z6 |

0,10 |

0001 |

|

z7 |

0,04 |

00001 |

|

z8 |

0,02 |

00000 |

Вычислим энтропию набора букв:

(z)

= - p(zi)log

p(zi)

2,76

p(zi)log

p(zi)

2,76

и среднее число символов на букву

lcp

= - p(zi)

n(zi)

2,84,

p(zi)

n(zi)

2,84,

где n(zi) - число символов в кодовой комбинации, соответствующей букве zi.

Значения zi и lcp не очень различаются по величине.

Рассмотренная методика Шеннона-Фано не всегда приводит к однозначному построению кода. Ведь при разбиении на подгруппы можно сделать большей по вероятности как верхнюю, так и нижнюю подгруппу.

Множество вероятностей в предыдущей таблице можно было разбить иначе (табл. 3.5).

Таблица 3.5 – Кодирование по методике Шеннона-Фано (продолжение)

|

Буквы |

Вероятности |

Кодовые комбинации |

|

z1 |

0,22 |

11 |

|

z2 |

0,20 |

10 |

|

z3 |

0,16 |

011 |

|

z4 |

0,16 |

010 |

|

z5 |

0,10 |

001 |

|

z6 |

0,10 |

0001 |

|

z7 |

0,04 |

00001 |

|

z8 |

0,02 |

00000 |

При этом среднее число символов на букву оказывается равным 2,80. Таким образом, построенный код может оказаться не самым лучшим. При построении эффективных кодов с основанием q > 2 неопределенность становится еще больше.

От указанного недостатка свободна методика Д. Хаффмена. Она гарантирует однозначное построение кода с наименьшим для данного распределения вероятностей средним числом символов на букву.

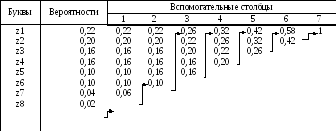

Таблица 3.6 – Кодирование по методике Хаффмена

Для двоичного кода методика сводится к следующему. Буквы алфавита сообщений выписываются в основной столбец в порядке убывания вероятностей. Две последние буквы объединяются в одну вспомогательную букву, которой приписывается суммарная вероятность. Вероятности букв, не участвовавших в объединении, и полученная суммарная вероятность снова располагаются в порядке убывания вероятностей в дополнительном столбце, а две последние объединяются. Процесс продолжается до тех пор, пока не получим единственную вспомогательную букву с вероятностью, равной единице.

Для составления кодовой комбинации, соответствующей данному сообщению, необходимо проследить путь перехода сообщений по строкам и столбцам таблицы. Для наглядности строится кодовое дерево. Из точки, соответствующей вероятности 1, направляются две ветви, причем ветви с большей вероятностью присваивается символ 1, а с меньшей - 0. Такое последовательное ветвление продолжаем до тех пор, пока не дойдем до каждой буквы (рис. 3.9).

Рисунок 3.9 – Кодовое дерево

Теперь, двигаясь по кодовому дереву сверху вниз, можно записать для каждой буквы соответствующую ей кодовую комбинацию:

Таблица 3.7 – Кодирование по методике Хаффмена

|

z1 |

z2 |

z3 |

z4 |

z5 |

z6 |

z7 |

z8 |

|

01 |

00 |

111 |

110 |

100 |

1011 |

10101 |

10100 |