- •1. Введение

- •2. Информатика

- •Предмет и основные понятия информатики

- •Понятие информации и её свойства

- •Классификация информации

- •1) По способам восприятия

- •3) По предназначению

- •Свойства информации

- •Объективность

- •Достоверность

- •Полнота

- •Понятие количества информации

- •Тема 1. Информация и информационные процессы

- •1.1. Информация. Информационные объекты различных видов

- •1.2. Виды и свойства информации

- •1.3. Основные информационные процессы. Хранение, передача и обработка информации

- •Информационная энтропия

- •Формальные определения

- •Определение по Шеннону

- •Определение с помощью собственной информации

- •Свойства

- •Математические свойства

- •Эффективность

- •Вариации и обобщения

- •Условная энтропия

- •Взаимная энтропия

- •История

- •Алгоритм Шеннона — Фано

- •Основные сведения

- •Основные этапы

- •Алгоритм вычисления кодов Шеннона — Фано

- •Пример кодового дерева

- •Информация

- •История понятия

- •Классификация информации

- •Значение термина в различных областях знания Философия

- •В информатике

- •Системология

- •В физике

- •В математике

- •В теории управления

- •В кибернетике

- •Информация в материальном мире

- •Информация в живой природе

- •Информация в человеческом обществе

- •Хранение информации

- •Передача информации

- •Обработка информации

- •Информация в науке

- •Теория информации

- •Теория алгоритмов

- •Теория автоматов

- •Семиотика

- •Дезинформация

- •1. Введение

- •Способы кодирования информации.

- •Теорема Шеннона — Хартли

- •Утверждение теоремы

- •История развития

- •Критерий Найквиста

- •Формула Хартли Теоремы Шеннона для канала с шумами

- •Теорема Шеннона — Хартли

- •Значение теоремы Пропускная способность канала и формула Хартли

- •1. Передача информации. Информационные каналы

- •2. Характеристики информационного канала

- •3. Абстрактный алфавит

- •4. Кодирование и декодирование

- •5. Понятие о теоремах Шеннона

- •6. Международные системы байтового кодирования

- •7. Кодирование информации

- •7.1. Двоичное кодирование текстовой информации

- •7.2. Кодирование графической информации

- •7.2.1. Кодирование растровых изображений

- •7.2.2. Кодирование векторных изображений.

- •7.3. Двоичное кодирование звука

- •Алгоритм

- •История термина

- •Определения алгоритма Неформальное определение

- •Формальное определение

- •Машина Тьюринга

- •Рекурсивные функции

- •Нормальный алгоритм Маркова

- •Стохастические алгоритмы

- •Другие формализации

- •Формальные свойства алгоритмов

- •Виды алгоритмов

- •Нумерация алгоритмов

- •Алгоритмически неразрешимые задачи

- •Анализ алгоритмов Доказательства корректности

- •Время работы

- •Наличие исходных данных и некоторого результата

- •Представление алгоритмов

- •Эффективность алгоритмов

- •1.1. Sadt-модели

- •1.2. Модель отвечает на вопросы

- •1.3. Модель имеет единственный субъект

- •1.4. У модели может быть только одна точка зрения

- •1.5. Модели как взаимосвязанные наборы диаграмм

- •1.6. Резюме

- •Классификация моделей

- •1) Классификация моделей по области использования:

- •2) Классификация моделей по фактору времени:

- •1.3.1. Основные признаки систем

- •Система

- •Различные определения

- •Свойства систем Связанные с целями и функциями

- •Связанные со структурой

- •Связанные с ресурсами и особенностями взаимодействия со средой

- •Классификации систем Ранги систем

- •Термодинамическая классификация

- •Другие классификации

- •Закон необходимости разнообразия (закон Эшби)

Определение с помощью собственной информации

Также можно определить энтропию случайной величины, введя предварительно понятия распределения случайной величины X, имеющей конечное число значений:[2]

![]()

![]()

и собственной информации:

I(X) = − log PX(X).

Тогда энтропия определяется как:

![]()

От основания логарифма зависит единица измерения информации и энтропии: бит, трит, нат или хартли.

Свойства

Энтропия

является количеством, определённым в

контексте вероятностной модели для

источника

данных. Например, кидание монеты имеет

энтропию − 2(0,5log 20,5) = 1 бит

на одно кидание (при условии его

независимости). У источника, который

генерирует строку, состоящую только из

букв «А», энтропия равна нулю:

![]() .

Так, например, опытным путём можно

установить, что энтропия английского

текста равна 1,5 бит на символ, что конечно

будет варьироваться для разных текстов.

Степень энтропии источника данных

означает среднее число битов на элемент

данных, требуемых для её зашифровки без

потери информации, при оптимальном

кодировании.

.

Так, например, опытным путём можно

установить, что энтропия английского

текста равна 1,5 бит на символ, что конечно

будет варьироваться для разных текстов.

Степень энтропии источника данных

означает среднее число битов на элемент

данных, требуемых для её зашифровки без

потери информации, при оптимальном

кодировании.

-

Некоторые биты данных могут не нести информации. Например, структуры данных часто хранят избыточную информацию, или имеют идентичные секции независимо от информации в структуре данных.

-

Количество энтропии не всегда выражается целым числом бит.

Математические свойства

-

Неотрицательность:

.

. -

Ограниченность:

,

что вытекает из неравенства

Йенсена для вогнутой функции f(gi)

= log 2gi и

,

что вытекает из неравенства

Йенсена для вогнутой функции f(gi)

= log 2gi и

.

Если все n элементов из X

равновероятны, H(X) = log 2n.

.

Если все n элементов из X

равновероятны, H(X) = log 2n. -

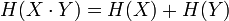

Если

независимы,

то

независимы,

то

.

. -

Энтропия — выпуклая вверх функция распределения вероятностей элементов.

-

Если

имеют

одинаковое распределение вероятностей

элементов, то H(X) = H(Y).

имеют

одинаковое распределение вероятностей

элементов, то H(X) = H(Y).

Эффективность

Алфавит может иметь вероятностное распределение далекое от равномерного. Если исходный алфавит содержит n символов, тогда его можно сравнить с «оптимизированным алфавитом», вероятностное распределение которого равномерное. Соотношение энтропии исходного и оптимизированного алфавита — это эффективность исходного алфавита, которая может быть выражена в процентах. Эффективность исходного алфавита с n символами может быть также определена как его n-арная энтропия.

Энтропия ограничивает максимально возможное сжатие без потерь (или почти без потерь), которое может быть реализовано при использовании теоретически — типичного набора или, на практике, — кодирования Хаффмана, кодирования Лемпеля — Зива — Велча или арифметического кодирования.

Вариации и обобщения

b-арная энтропия

В

общем случае b-арная энтропия

(где b равно 2, 3, …) источника

![]() с

исходным

алфавитом

с

исходным

алфавитом

![]() и

дискретным

распределением вероятности

и

дискретным

распределением вероятности

![]() где

pi является вероятностью

ai (pi = p(ai)),

определяется формулой:

где

pi является вероятностью

ai (pi = p(ai)),

определяется формулой:

Условная энтропия

Если следование символов алфавита не независимо (например, во французском языке после буквы «q» почти всегда следует «u», а после слова «передовик» в советских газетах обычно следовало слово «производства» или «труда»), количество информации, которую несёт последовательность таких символов (а, следовательно, и энтропия), очевидно, меньше. Для учёта таких фактов используется условная энтропия.

Условной энтропией первого порядка (аналогично для Марковской модели первого порядка) называется энтропия для алфавита, где известны вероятности появления одной буквы после другой (то есть, вероятности двухбуквенных сочетаний):

![]()

где i — это состояние, зависящее от предшествующего символа, и pi(j) — это вероятность j при условии, что i был предыдущим символом.

Например,

для русского языка без буквы «ё»

![]() [3].

[3].

Через

частную и общую условные энтропии

полностью описываются информационные

потери при передаче

данных в канале с помехами. Для этого

применяются так называемые канальные

матрицы. Для описания потерь со стороны

источника (то есть известен посланный

сигнал) рассматривают условную

вероятность

![]() получения

приёмником символа bj при

условии, что был отправлен символ ai.

При этом канальная матрица имеет

следующий вид:

получения

приёмником символа bj при

условии, что был отправлен символ ai.

При этом канальная матрица имеет

следующий вид:

|

|

b1 |

b2 |

… |

bj |

… |

bm |

|

a1 |

|

|

… |

|

… |

|

|

a2 |

|

|

… |

|

… |

|

|

… |

… |

… |

… |

… |

… |

… |

|

ai |

|

|

… |

|

… |

|

|

… |

… |

… |

… |

… |

… |

… |

|

am |

|

|

… |

|

… |

|

Очевидно, вероятности, расположенные по диагонали, описывают вероятность правильного приёма, а сумма всех элементов столбца даёт вероятность появления соответствующего символа на стороне приёмника — p(bj). Потери, приходящиеся на передаваемый сигнал ai, описываются через частную условную энтропию:

Для вычисления потерь при передаче всех сигналов используется общая условная энтропия:

![]()

![]() означает

энтропию со стороны источника, аналогично

рассматривается

означает

энтропию со стороны источника, аналогично

рассматривается

![]() —

энтропия со стороны приёмника: вместо

—

энтропия со стороны приёмника: вместо

![]() всюду

указывается

всюду

указывается

![]() (суммируя

элементы строки можно получить p(ai),

а элементы диагонали означают вероятность

того, что был отправлен именно тот

символ, который получен, то есть

вероятность правильной передачи).

(суммируя

элементы строки можно получить p(ai),

а элементы диагонали означают вероятность

того, что был отправлен именно тот

символ, который получен, то есть

вероятность правильной передачи).