- •2.Категория управления.

- •5.Единицы измерения информации.

- •7.Процесс дискретизации (пд), частота дискретизации.

- •8.Теорема Найквиста.

- •11.Информационная энтропия.

- •13.Радиотехническая модель передачи информации.

- •14.Источник информации или сообщения.

- •17.Радиотехническая модель передачи информации. Назначение декодера канала.

- •20.Канал связи (информационный канал).

- •23.Основные виды шифрования.

- •26.Рассмотрите методы оптимального кодироваия (сжатия информации). Опишите алгоритм метода Шенона-Фано.

- •29.Рассмотрите подстановочные или словарно-ориентированные методы сжатия информации.

1.Основоположники кибернетики. Кибернетика - это наука об общих законах получения, хранения, передачи и переработки информации. Ее основной предмет исследования - это так называемые кибернетические системы, рассматриваемые абстрактно, вне зависимости от их материальной природы. Родоначальниками кибернетики (датой ее рождения считается 1948 год, год соответствующей публикации) считаются американские ученые Норберт Винер (Wiener, он - прежде всего) и Клод Шеннон (Shannon, он же основоположник теории информации). Название «кибернетика» происходит от греческого «кюбернетес», что первоначально означало «рулевой», «кормчий», но впоследствии стало обозначать и «правитель над людьми». Так, древнегреческий философ Платон в своих сочинениях в одних случаях называет кибернетикой искусство управления кораблем или колесницей, а в других — искусство править людьми. Примечательно, что римлянами слово «кюбернетес» было преобразовано в «губернатор». Известный французский ученый-физик А. М. Ампер (1775-1836 гг.) в своей работе «Опыт о философии наук, или Аналитическое изложение естественной классификации всех человеческих знаний», первая часть которой вышла в 1834 г., назвал кибернетикой науку о текущем управлении государством (народом), которая помогает правительству решать встающие перед ним конкретные задачи с учетом разнообразных обстоятельств в свете общей задачи принести стране мир и процветание. Однако вскоре термин «кибернетика» был забыт и, как отмечалось ранее, возрожден в 1948 г. Винером в качестве названия науки об управлении техническими, биологическими и социальными системами.

2.Категория управления.

— наука о принципах и методах управленияразличнымисистемами,процессами и объектами. Суть теории управления состоит в построении математической модели на основе системного анализа объекта управления (ОУ) и синтезе алгоритма управления(АУ) для получения желаемых характеристик протекания процесса или целей управления. Сущность принципа управления заключается в том, что движение и действие больших масс или передача и преобразование больших количеств энергии направляется и контролируется при помощи небольших количеств энергии, несущих информацию. Этот принцип управления лежит в основе организации и действия любых управляемых систем: автоматических устройств, живых организмов и т.п. Подобно тому, как введение понятия энергии позволило рассматривать все явления природы с единой точки зрения и отбросило целый ряд ложных теорий.

3.Понятие информации. Термин И происходит от лат слова informatio, что означает «сведения, разъяснения, изложение». В пост употребление этот термин вошёл в сер 20го века. Ввёл его амер учёный Клод Шеннон, разработавший основы теории И. И по Шеннону — это сообщение, передаваемое в виде кодовых посылок по канану связи, а ценность сообщения измеряется не его смыслом, а неожиданностью и необычностью сигнала. В это слово вкладывается различный смысл в технике, науке и в житейских ситуациях. В обиходе И наз-ют любые данные или сведения, к-ые кого-либо интересуют, н-р сообщение о каких-либо событиях, о чьей-либо деятельности и т. п. «Информировать» в этом смысле означает «сообщить нечто, неизвестное раньше». И — сведения об объектах и явлениях окр среды, их параметрах, св-вах и состоянии, к-ые воспринимают ИС (живые организмы, управляющие машины и др.) в процессе жизнедеятельности и работы. Применительно к комп обработке данных под И понимают нек-ую послед-cть символических обознач (букв, цифр, закодированных графических образов и звуков и т. п.), несущую смысловую нагрузку и представленную в понятном компу виде. Каждый новый символ в такой последовательности символов увеличивает информационный объем сообщения. И может сущ-вать в виде:

текстов, рисунков, чертежей, фотографий;

световых или звуковых сигналов;

радиоволн;

электрических и нервных импульсов;

магнитных записей;

жестов и мимики;

запахов и вкусовых ощущений;

хромосом, посредством которых передаются по наследству признаки и свойства организмов, и т. д.

Предметы, процессы, явления материального или нематериального св-ва, рассматриваемые с точки зрения их информационных свойств, наз-ся информационными объектами. Свойства И:

достоверность (инф. отражает истинное положение дел)

полнота (инф. достаточ для пониман и принятия решений)

точность (опред. степенью инф. близости к реальному состоянию объекта, процесса, явления и т. п.)

ценность (зависит от того, наскоко инф. важна для решения задачи, а также от того, насколько в дальнейшем инф. найдет применение в каких-либо видах деятельности человека)

своевременность

понятность

доступность

краткость и т. д.

Информация может быть двух видов: дискретная информация и непрерывная(аналоговая). Дискретная информация характеризуется последовательными точными значениями некоторой величины, а непрерывная - непрерывным процессом изменения некоторой величины. Непрерывную информацию может, например, выдавать датчик атмосферного давления или датчик скорости автомашины. Дискретную информацию можно получить от любого цифрового индикатора: электронных часов, счетчика магнитофона и т.п. Дискретная информация удобнее для обработки человеком, но непрерывная информация часто встречается в практической работе.

4.Определение

Шеннона. Клод

Элвуд Шеннон (Shannon) (1916 – 2001) – американский

инженер и математик. Человек, к-ого

наз-ют отцом современных теорий инф-ции

и связи. В своих работах 1948-49 гг он

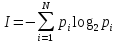

определил кол-во инф-ции через энтропию

- величину, известную в термодинамике

и статистической физике как мера

разупорядоченности системы, а за ед

инф-ции принял то, что впоследствии

окрестили "битом", то есть выбор

одного из двух равновероятных вариантов.

Шеннонвывел

это определение энтропии из след

предположений:1)мера

должна быть непрерывной; т. е. изменение

значения величины вероятности на малую

величину должно вызывать малое

результирующее изменение энтропии; 2)в

случае, когда все варианты (буквы в

приведенном примере) равновероятны,

увеличение кол -ва вариантов (букв)

должно всегда увеличивать полную

энтропию; 3)должна

быть возможность сделать выбор (в нашем

примере букв) в два шага, в к-ых энтропия

конечного результата должна будет

являться суммой энтропий промежуточных

результатов. Шеннон показал, что любое

определение энтропии, удовлетворяющее

этим предположениям, должно быть в

форме: