- •Балтийский Федеральный Университет имени и.Канта

- •Расчетно-графическая работа №1

- •1.2 Статистический подход к измерению информации

- •Расчетно-графическая работа №2 Тема: «Разработка формальной грамматики Хомского».

- •1.1 Формальная грамматика

- •1.2 Пример построения грамматики

- •1.3 Представление грамматики в виде графа

- •1.5 Классификация формальных грамматик

- •Расчетно-графическая работа №3

- •Метод Шеннона-Фано

- •Метод Хаффмана

- •Расчетно-графическая работа №4 Тема: «Системы счисления».

- •Правила перевода целых чисел

- •Правила перевода правильных дробей

- •Правила сложения

- •Правила вычитания

- •Правила умножения

- •Правила деления

- •Расчетно-графическая работа №5 Тема: «Нормальные алгоритмы Маркова и машины Тьюринга».

- •Расчетно-графическая работа №6 Тема: «Расчет числовых характеристик графов».

- •Расчетно-графическая работа №7 Тема: «Нахождение кратчайшего остова неориентированного графа по алгоритму Дейкстра».

- •Расчетно-графическая работа №8 Тема: «Поиск кратчайших путей на неориентированном графе по алгоритму Флойда».

- •Расчетно-графическая работа №9 Тема: «Архивирование файлов алгоритмом Зива-Лемпеля-Велча».

1.2 Статистический подход к измерению информации

В 30-х годах ХХ века американский ученый Клод Шеннон предложил связать количество информации, которое несет в себе некоторое сообщение, с вероятностью получения этого сообщения.

Вероятность p – количественная априорная (т.е. известная до проведения опыта) характеристика одного из исходов (событий) некоторого опыта. Измеряется в пределах от 0 до 1. Если заранее известны все исходы опыта, сумма их вероятностей равна 1, а сами исходы составляют полную группу событий. Если все исходы могут свершиться с одинаковой долей вероятности, они называются равновероятными.

Например, пусть опыт состоит в сдаче студентом экзамена по ТОИ. Очевидно, у этого опыта всего 4 исхода (по количеству возможных оценок, которые студент может получить на экзамене). Тогда эти исходы составляют полную группу событий, т.е. сумма их вероятностей равна 1. Если студент учился хорошо в течение семестра, значения вероятностей всех исходов могут быть такими:

p(5) = 0,5; p(4) = 0,3; p(3) = 0,1; p(2) = 0,1. (1.4)

Здесь запись p(j) означает вероятность исхода, когда получена оценка j (j = {2, 3, 4, 5}).

Если студент учился плохо, можно заранее оценить возможные исходы сдачи экзамена, т.е. задать вероятности исходов, например, следующим образом:

p(5) = 0,1; p(4) = 0,2; p(3) = 0,4; p(2) = 0,3. (1.5)

В![]() обоих случаях выполняется условие:

обоих случаях выполняется условие:

где n – число исходов опыта,

i – номер одного из исходов.

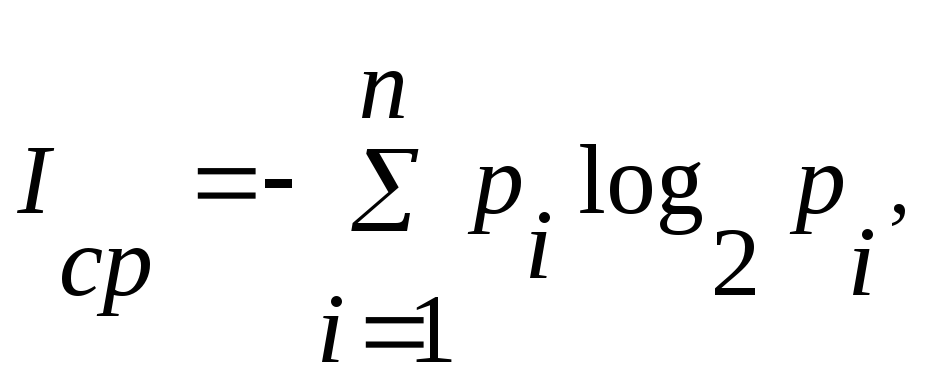

Пусть можно получить n сообщений по результатам некоторого опыта (т.е. у опыта есть n исходов), причем известны вероятности получения каждого сообщения (исхода) - pi. Тогда в соответствии с идеей Шеннона, количество информации I в сообщении i определяется по формуле (1.6):

I = -log2 pi, (1.6)

где pi – вероятность i-го сообщения (исхода).

Соотношение (1.6) позволяет определять также размер двоичного эффективного кода, требуемого для представления того или иного сообщения, имеющего определенную вероятность появления.

П (1.7)

где pi – вероятность i-го сообщения.

На практике часто вместо вероятностей используются частоты исходов. Это возможно, если опыты проводились ранее и существует определенная статистика их исходов.

Усложним задачу.

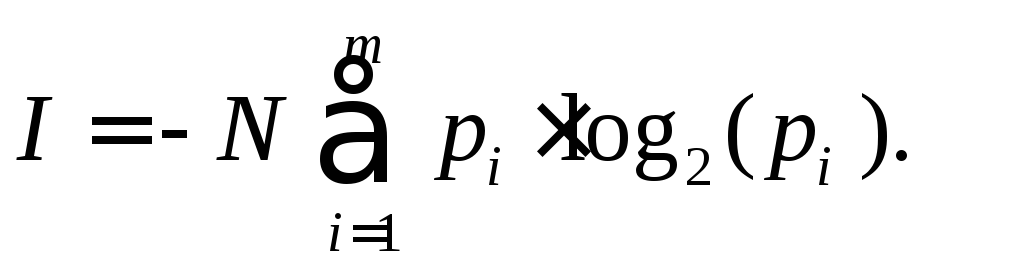

Пусть сообщение – набор длиной N символов русского алфавита. Пусть опыт состоит в появлении той или иной буквы исходного алфавита в сообщении. Вероятности (или частоты) исходов известны: pi – вероятность появления символа i. Тогда полное количество информации, доставленное отрезком из N сигналов, где N =N1+..+Nm при Ni – число вхождений i-ого типа буквы в сообщение, будет рассчитываться по формуле (1.8):

(1.8)

Пусть у опыта два равновероятных исхода, составляющих полную группу событий, т.е. p1 = p2 = 0,5. Тогда имеем в соответствии с (1.7):

I ср = -(0,5*log20,5 + 0,5*log20,5) = 1. (1.9)

Формула (9) есть аналитическое определение бита по Шеннону: это среднее количество информации, которое содержится в двух равновероятных исходах некоторого опыта, составляющих полную группу событий.

Формула, предложенная Хартли, представляет собой частный случай более общей формулы Шеннона. Если имеется N равновероятных исходов некоторого опыта, то от формулы (8) мы приходим к формуле (1.1)

Единица измерения информации при статистическом подходе – бит.

Примеры решения задач

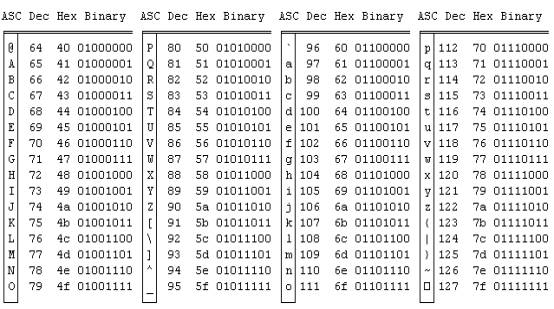

Пример 1 (структурный подход). Рассчитать количество информации, которое содержится в шестнадцатеричном и двоичном представлении ASCII-кода для числа 1.

Пример 2 (структурный подход). Рассчитать количества информации для сообщений «Информатика» и «30-е годы 20-ого века» без учета кавычек.

Пример 3. Какое количество вопросов достаточно задать вашему собеседнику, чтобы наверняка определить месяц, в котором он родился?

Пример 4 (статистический подход). Определить количество информации, содержащейся в сообщении о результате сдачи экзамена для студента из (1.4) и (1.5).

Пример 5 (статистический подход). Определить среднее количество информации, получаемое студентом из (1.4) и (1.5), по всем результатам сдачи экзамена.

Пример 6 (статистический подход). Рассчитать количества информации для сообщений «Информатика» и «30-е годы 20-ого века» без учета кавычек.

|

Буква |

Частота |

Буква |

Частота |

Буква |

Частота |

|

о |

0,090 |

м |

0,026 |

й |

0,010 |

|

е (ё) |

0,072 |

д |

0,025 |

х |

0,009 |

|

а |

0,062 |

п |

0,023 |

ж |

0,007 |

|

и |

0,062 |

у |

0,021 |

ю |

0,006 |

|

т |

0,053 |

я |

0,018 |

ш |

0,006 |

|

н |

0,053 |

ы |

0,016 |

ц |

0,004 |

|

с |

0,045 |

з |

0,016 |

щ |

0,003 |

|

р |

0,040 |

ь,ъ |

0,014 |

э |

0,003 |

|

в |

0,038 |

б |

0,014 |

ф |

0,001 |

|

л |

0,035 |

г |

0,013 |

пробелы и знаки препинания |

0,175 |

|

к |

0,028 |

ч |

0,012 |

|

|

Задание

Для выбранной в соответствии с вариантом задания задачи:

Рассчитать количество информации в сообщении по формуле Хартли.

Рассчитать количество информации в сообщении по формуле Шеннона.

Выполнить сравнительный анализ результатов расчетов.

Сделать выводы.

Содержание отчета

Определение понятия «Количество информации».

Мера Р.Хартли.

Подробный расчет количества информации, содержащейся в сообщении по формуле Хартли.

Мера К.Шеннона.

Подробный расчет количества информации, содержащейся в сообщении по формуле Хартли (привести таблицу вероятностей появления букв русского алфавита в сообщениях)

Анализ результатов и выводы.

Варианты задания

Вариант задания формируется каждым студентом индивидуально следующим образом. От источника к приемнику передается следующее сообщение: «Фамилия Имя Отчество день. месяц. год город-рождения». Каждый студент использует в качестве варианта задания свои фамилию, имя и отчество, далее – день, месяц, год и город рождения. Все семь частей сообщения разделены одним пробелом. Например: «Иванов Семен Петрович 10 11 1992 Москва».

Список литературы

Информатика. Базовый курс. / Под ред. С.В.Симоновича. — Спб., 2000 г.

Информатика. Компьютерная техника. Компьютерные технологии. / Пособие под ред. О.И.Пушкаря.— Издательский центр "Академия", Киев, — 2001 г.

Казиев В.М. Введение в анализ, синтез и моделирование систем. М.: Бином, 2007.

Коцюбинский А.О., Грошев С.В. Современный самоучитель профессиональной работы на компьютере. — Г.: Триумф, 1999 г.