- •Нормирование и метрологические характеристики си.

- •Диапазон измерения. Прямая и обратная сфп. Восстановление сфп на основе мнк.

- •Приведенная и относительная погрешности.

- •Класс точности. Основная, дополнительная погрешности.

- •Чувствительность. Порог чувствительности. Динамические характеристики иу.

- •Режимы работы измерительного устройства.

- •Индивидуальная сфп иу. Погрешность нелинейности. Аналитическое описание эмпирической фп.

- •Симметрирование в условиях сильных вв. Бисимметрия. Принцип Кюри.

- •Обобщенный показатель вв для параметрических преобразователей.

- •Частичное симметрирование и возможности повышения точности.

Приведенная и относительная погрешности.

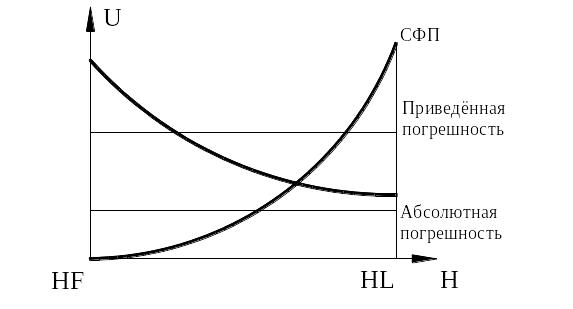

Относительная погрешность СИ – погрешность средства измерений, выраженная отношением абсолютной погрешности СИ к результату измерений или к действительному значению измеренной величины: δ = ∆Х / Хд. Относительная погрешность дает наилучшее из всех видов погрешностей представление об уровне точности измерений, который может быть достигнут при использовании данного средства измерений. Однако она обычно существенно изменяется вдоль шкалы прибора, например, увеличивается с уменьшением значения измеряемой величины. В связи с этим часто используют приведенную погрешность.

Приведенная погрешность СИ – относительная погрешность, выраженная отношением абсолютной погрешности средства измерений к диапазону измерения: D = ∆Х / UD. Относительные и приведенные погрешности обычно выражают либо в процентах, либо в относительных единицах (долях единицы). Приведенные погрешности позволяют сравнивать по точности средства измерений, имеющие разные пределы измерений, если абсолютные погрешности каждого из них не зависят от значения измеряемой величины.

Неподписанная кривая – относительная погрешность. Приведенная и относит. Погрешности – прямые, параллельные оси Н.

Класс точности. Основная, дополнительная погрешности.

Основная погрешность СИ – погрешность средства измерений, применяемого в нормальных условиях, т.е. в условиях, которые определены в НТД не него как нормальные. Нормальные значения влияющих величин указываются в стандартах или технических условиях на средства измерений данного вида в форме номиналов с нормированными отклонениями.

Дополнительная погрешность СИ – составляющая погрешности СИ, возникающая дополнительно к основной погрешности вследствие отклонения какой-либо из влияющих величин от нормального ее значения, оговоренного в ГОСТ или техн. документации. Возникает в рабочих условиях, которые также предписаны документацией.

Класс точности — основная метрологическая характеристика прибора, определяющая допустимые значения основных и дополнительных погрешностей, влияющих на точность измерения.

Для стрелочных приборов принято указывать класс точности, записываемый в виде числа, например, 0,05 или 4,0. Это число дает максимально возможную погрешность прибора, выраженную в процентах от наибольшего значения величины, измеряемой в данном диапазоне работы прибора. Так, для вольтметра, работающего в диапазоне измерений 0 — 30 В, класс точности 1,0 определяет, что указанная погрешность при положении стрелки в любом месте шкалы не превышает 0,3 В.

Обычно цена наименьшего деления шкалы стрелочного прибора согласована с погрешностью самого прибора. Если класс точности используемого прибора неизвестен, за погрешность s прибора всегда принимают половину цены его наименьшего деления.

Обозначения класса точности могут иметь вид заглавных букв латинского алфавита, римских цифр и арабских цифр с добавлением условных знаков. Если класс точности обозначается латинскими буквами, то класс точности определяется пределами абсолютной погрешности. Если класс точности обозначается арабскими цифрами без условных знаков, то класс точности определяется пределами приведённой погрешности и в качестве нормирующего значения используется наибольший по модулю из пределов измерений. Если класс точности обозначается арабскими цифрами с галочкой, то класс точности определяется пределами приведённой погрешности, но в качестве нормирующего значения используется длина шкалы. Если класс точности обозначается римскими цифрами, то класс точности определяется пределами относительной погрешности.