- •Оглавление

- •1 Распределение энергии в спектре периодического и непериодического сигнала; равенство Парсеваля; понятие о практической ширине частотного спектра сигнала

- •2 Принимаемый сигнал – как случайный процесс; виды случайных процессов, законы и числовые характеристики; корреляционные характеристики и свойства процессов; преобразования Винера-Хинчина; белый шум

- •3 Векторное представление сигнала; дискретизация сигнала по времени; теорема отсчетов (Котельникова); дискретизация по уровню, шум квантования; условие ретрансляции; понятие икм и дм сигнала

- •4 Понятие информации; понятие энтропии, избыточности; оценка энтропии дискретного и непрерывного источника; энтропия шумового сигнала

- •6 Прямое и косвенное описание процессов; некоторые модели источников сообщений; модели речевого сообщения; модели стохастического дискретного источника

- •7 Идеальный канал без помех, канал с неопределенной фазой сигнала и аддитивным шумом, канал с межсимвольной интерференцией (мси) и аддитивным шумом

- •8 Модели дискретного канала, модели дискретного канала с память, модель дискретно-непрерывного канала

- •Библиографический список

4 Понятие информации; понятие энтропии, избыточности; оценка энтропии дискретного и непрерывного источника; энтропия шумового сигнала

В теории информации и передачи сигналов под информацией понимают совокупность сведений о каких-либо событиях, процессах, явлениях и т.п., рассматриваемых в аспекте их передачи в пространстве и во времени. Информацию передают в виде сообщений. Сообщением называют информацию, выраженную в определенной форме и предназначенную для передачи от источника к адресату. Примерами сообщений служат тексты телеграмм, речь, музыка, телевизионное изображение, данные на выходе компьютера, команды в системе автоматического управления объектами и т.п. Сообщения передают с помощью сигналов, которые являются носителями информации. Основным видом сигналов являются электрические сигналы. В последнее время всё большее распространение получают оптические сигналы, например, в волоконно-оптических линиях передачи информации.

Энтропия – это количество информации, приходящейся на одно элементарное сообщение источника, вырабатывающего статистически независимые сообщения.

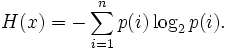

Информационная энтропия для независимых случайных событий x с n возможными состояниями (от 1 до n) рассчитывается по формуле:

Эта

величина также называется средней

энтропией сообщения.

Величина

![]() называется

частной

энтропией,

характеризующей только i-e

состояние.

называется

частной

энтропией,

характеризующей только i-e

состояние.

Таким образом, энтропия события x является суммой с противоположным знаком всех произведений относительных частот появления события i, умноженных на их же двоичные логарифмы (основание 2 выбрано только для удобства работы с информацией, представленной в двоичной форме). Это определение для дискретных случайных событий можно расширить для функции распределения вероятностей.

Энтропия

является количеством, определённым в

контексте вероятностной модели для

источника данных. Например, кидание

монеты имеет энтропию − 2(0,5log20,5)

= 1 бит на одно кидание (при условии его

независимости). У источника, который

генерирует строку, состоящую только из

букв «А», энтропия равна нулю:

![]() .

Так, например, опытным путём можно

установить, что энтропия английского

текста равна 1,5 бит на символ, что конечно

будет варьироваться для разных текстов.

Степень энтропии источника данных

означает среднее число битов на элемент

данных, требуемых для её зашифровки без

потери информации, при оптимальном

кодировании. Некоторые биты данных

могут не нести информации. Например,

структуры данных часто хранят избыточную

информацию, или имеют идентичные секции

независимо от информации в структуре

данных. Количество энтропии не всегда

выражается целым числом бит.

.

Так, например, опытным путём можно

установить, что энтропия английского

текста равна 1,5 бит на символ, что конечно

будет варьироваться для разных текстов.

Степень энтропии источника данных

означает среднее число битов на элемент

данных, требуемых для её зашифровки без

потери информации, при оптимальном

кодировании. Некоторые биты данных

могут не нести информации. Например,

структуры данных часто хранят избыточную

информацию, или имеют идентичные секции

независимо от информации в структуре

данных. Количество энтропии не всегда

выражается целым числом бит.

Математические свойства энтропии:

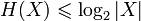

Неотрицательность:

.

.Ограниченность:

.

Равенство, если все элементы из X

равновероятны.

.

Равенство, если все элементы из X

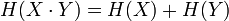

равновероятны.Если

независимы,

то

независимы,

то

.

.Энтропия — выпуклая вверх функция распределения вероятностей элементов.

Если имеют одинаковое распределение вероятностей элементов, то H(X) = H(Y).

Избыточность — термин из теории информации, означающий превышение количества информации, используемой для передачи или хранения сообщения, над его информационной энтропией. Для уменьшения избыточности применяется сжатие данных без потерь, в то же время контрольная сумма применяется для внесения дополнительной избыточности в поток, что позволяет производить исправление ошибок при передаче информации по каналам, вносящим искажения (спутниковая трансляция, беспроводная передача и т. д.).

Информационное содержание одного сообщения в потоке, в наиболее общем случае, определяется как:

![]()

Обозначим как R логарифм числа символов в алфавите сообщений: R = log | M |

Абсолютная избыточность может быть определена как разность этих двух величин:

D = R − r

Соотношение D/R называется относительной избыточностью и дает математическую оценку максимальной степени сжатия, на которую может быть уменьшен размер файла.

Энтропия дискретного источника. Шеннон предположил, что прирост информации равен утраченной неопределённости, и задал требования к её измерению:

мера должна быть непрерывной; то есть изменение значения величины вероятности на малую величину должно вызывать малое результирующее изменение функции;

в случае, когда все варианты (буквы в приведённом примере) равновероятны, увеличение количества вариантов (букв) должно всегда увеличивать значение функции;

должна быть возможность сделать выбор (в нашем примере букв) в два шага, в которых значение функции конечного результата должно являться суммой функций промежуточных результатов.

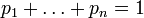

Поэтому функция энтропии H должна удовлетворяет условиям:

определена

и непрерывна для всех

определена

и непрерывна для всех

,

где

,

где

для

всех

для

всех

и

и

.

(Нетрудно видеть, что эта функция зависит

только от распределения вероятностей,

но не от алфавита.)

.

(Нетрудно видеть, что эта функция зависит

только от распределения вероятностей,

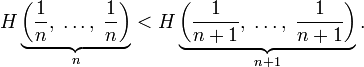

но не от алфавита.)Для целых положительных n, должно выполняться следующее неравенство:

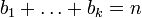

Для целых положительных bi, где

,

должно выполняться равенство:

,

должно выполняться равенство:

![]()

Шеннон

показал, что единственная функция,

удовлетворяющая этим требованиям, имеет

вид:

![]() где K —

константа (и в действительности нужна

только для выбора единиц измерения).

где K —

константа (и в действительности нужна

только для выбора единиц измерения).

Шеннон

определил, что измерение энтропии (![]() ),

применяемое к источнику информации,

может определить требования к минимальной

пропускной способности канала, требуемой

для надёжной передачи информации в виде

закодированных двоичных чисел. Для

вывода формулы Шеннона необходимо

вычислить математическое ожидание

«количества информации», содержащегося

в цифре из источника информации. Мера

энтропии Шеннона выражает неуверенность

реализации случайной переменной. Таким

образом, энтропия является разницей

между информацией, содержащейся в

сообщении, и той частью информации,

которая точно известна (или хорошо

предсказуема) в сообщении. Примером

этого является избыточность языка —

имеются явные статистические закономерности

в появлении букв, пар последовательных

букв, троек и т. д. (см. цепи Маркова).

),

применяемое к источнику информации,

может определить требования к минимальной

пропускной способности канала, требуемой

для надёжной передачи информации в виде

закодированных двоичных чисел. Для

вывода формулы Шеннона необходимо

вычислить математическое ожидание

«количества информации», содержащегося

в цифре из источника информации. Мера

энтропии Шеннона выражает неуверенность

реализации случайной переменной. Таким

образом, энтропия является разницей

между информацией, содержащейся в

сообщении, и той частью информации,

которая точно известна (или хорошо

предсказуема) в сообщении. Примером

этого является избыточность языка —

имеются явные статистические закономерности

в появлении букв, пар последовательных

букв, троек и т. д. (см. цепи Маркова).

Определение энтропии Шеннона связано с понятием термодинамической энтропии. Больцман и Гиббс проделали большую работу по статистической термодинамике, которая способствовала принятию слова «энтропия» в информационную теорию. Существует связь между термодинамической и информационной энтропией. Например, демон Максвелла также противопоставляет термодинамическую энтропию информации, и получение какого-либо количества информации равно потерянной энтропии.

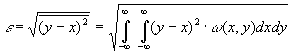

Энтропия непрерывного источника. В одном отсчете любого непрерывного сообщения содержится бесконечное количество собственной информации. И тем не менее, непрерывные сообщения (телефонные разговоры, телепередачи) успешно передаются по каналам связи. Это объясняется тем, что на практике никогда не требуется абсолютно точного воспроизведения переданного сообщения, а для передачи даже с очень высокой, но ограниченной точностью, требуется конечное количество информации, также как и при передаче дискретных сообщений. Данное обстоятельство и положено в основу определения количественной меры собственной информации, источников непрерывных сообщений. В качестве такой меры, принимается минимальное количество информации, необходимое для воспроизведения непрерывного сообщения с заданной точностью. Очевидно, что при таком подходе собственная информация зависит не только от свойств источника сообщений, но и от выбора параметра , характеризующего точность воспроизведения. Возможны различные подходы к определению в зависимости от вида и назначения передаваемой информации. Наиболее часто в информационной технике в качестве используют среднеквадратическое отклонение между принятым у и переданным х сигналами, отражающими непрерывные сообщения, т.е.

|

|

|

где Х и Y – ансамбли сигналов, отражающих исходное и воспроизведенное сообщения. Два варианта сообщения или сигнала, различающиеся не более, чем на заданное значение 0, называются эквивалентными. Взаимная информация I(X,Y) между двумя эквивалентными процессами X(t) и Y(t) может быть определена как I(X,Y)=h(X)-h(X/Y), |

||

где h(X) и h(X/Y) – соответственно дифференциальная и условная дифференциальная энтропии.

Из приведенного выражения видно, что величина I(X,Y) зависит не только от собственного распределения (х) ансамбля Х, но и от условного распределения (x/y), которое определяется способом преобразования процесса X в Y. Для характеристики собственной информации, содержащейся в одном отсчете процесса Х, нужно устранить ее зависимость от способа преобразования сообщения Х в эквивалентное ему сообщение Y. Этого можно добиться, если под количеством собственной информации или - энтропией H(Х) процесса Х понимать минимизированную по всем распределениям (X/Y) величину I(X,Y), при которой сообщения Х и Y еще эквивалентны, т.е.

|

|

|

Таким образом, - энтропия определяет минимальное количество информации, содержащейся в одном отсчете непрерывного сообщения, необходимое для воспроизведения его с заданной верностью.

5 Информационная характеристика сигнала: скорость передачи сигнала; бод, скорость передачи сигнала; пропускная способность дискретного сигнала в канале с помехами; пропускная способность канала с шумовой помехой; теорема Шеннона; согласование канала с сигналом

Канал связи – это совокупность средств, предназначенных для передачи сигналов (сообщений). Существуют различные типы каналов, которые можно классифицировать по различным признакам:

По типу линий связи: проводные; кабельные; оптико-волоконные; линии электропередачи; радиоканалы и т.д.

По характеру сигналов: непрерывные; дискретные; дискретно-непрерывные (сигналы на входе системы дискретные, а на выходе непрерывные, и наоборот).

По помехозащищенности: каналы без помех; с помехами.

Каналы связи характеризуются:

1. Емкость канала определяется как произведение времени использования канала Tк, ширины спектра частот, пропускаемых каналом Fк и динамического диапазона Dк., который характеризует способность канала передавать различные уровни сигналов.Vк = Tк Fк Dк.

Условие согласования сигнала с каналом: Vc Vk; Tc Tk; Fc Fk; Vc Vk; Dc Dk.

2. Скорость передачи информации – среднее количество информации, передаваемое в единицу времени.

3. Пропускная способность канала связи – наибольшая теоретически достижимая скорость передачи информации при условии, что погрешность не превосходит заданной величины.

4. Количество информации и избыточность.

Дискретные системы связи – системы, в которых как реализации сообщения, так и реализации сигнала представляют собой последовательности символов алфавита, содержащего конечное число элементарных символов.

Единицей измерения количества информации является бит, который представляет собой количество информации, получаемое при наблюдении случайной величины, имеющей два равновероятных значения.

При

равномерном распределении

количество информации задается формулой

Хартли:

количество информации задается формулой

Хартли:

.

.

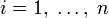

Справедливы следующие соотношения:

1)

2)

3)

если

если

и

и

- независимы.

- независимы.

Избыточность – обеспечивает достоверность передаваемой информации (R = 01).

Одной из задач теории информации является определение зависимости скорости передачи информации и пропускной способности канала связи от параметров канала и

Скорость передачи данных в значительной мере зависит от передающей среды в каналах связи, в качестве которых используются различные типы линий связи:

Проводные:

1. Витая пара (что частично подавляет электромагнитное излучение других источников). Скорость передачи до 1 Мбит/с. Используется в телефонных сетях и для передачи данных.

2. Коаксиальный кабель. Скорость передачи 10–100 Мбит/с – используется в локальных сетях, кабельном телевидении и т.д.

3. Оптико-волоконная. Скорость передачи 1 Гбит/с.

В средах 1–3 затухание в дБ линейно зависит от расстояния, т.е. мощность падает по экспоненте. Поэтому через определенное расстояние нужно ставить ретрансляторы (усилители).

Радиолинии:

1. Радиоканал. Скорость передачи 100–400 Кбит/с. Использует радиочастоты до 1000 МГц. До 30 МГц за счет отражения от ионосферы возможно распространение электромагнитных волн за пределы прямой видимости. Но этот диапазон сильно зашумлен (например, любительской радиосвязью). От 30 до 1000 МГц – ионосфера прозрачна и необходима прямая видимость. Антенны устанавливаются на высоте (иногда устанавливаются регенераторы). Используются в радио и телевидении.

2. Микроволновые линии. Скорости передачи до 1 Гбит/с. Используют радиочастоты выше 1000 МГц. При этом необходима прямая видимость и остронаправленные параболические антенны. Расстояние между регенераторами 10–200 км. Используются для телефонной связи, телевидения и передачи данных.

3. Спутниковая связь. Используются микроволновые частоты, а спутник служит регенератором (причем для многих станций). Характеристики те же, что у микроволновых линий.

Бод (англ. baud) в связи и электронике – единица измерения символьной скорости, количество изменений информационного параметра несущего периодического сигнала в секунду. Названа по имени Эмиля Бодо, изобретателя кода Бодо – кодировки символов для телетайпов.

Зачастую, ошибочно, считают, что бод – это количество бит, переданное в секунду. В действительности же это верно лишь для двоичного кодирования, которое используется не всегда. Например, в современных модемах используется квадратурная амплитудная модуляция (КАМ), и одним изменением уровня сигнала может кодироваться несколько (до 16) бит информации. Например, при символьной скорости 2400 бод скорость передачи может составлять 9600 бит/c благодаря тому, что в каждом временном интервале передаётся 4 бита.

Кроме этого, бодами выражают полную ёмкость канала, включая служебные символы (биты), если они есть. Эффективная же скорость канала выражается другими единицами, например битами в секунду (бит/c, bps).

Дисктретные

системы передачи информации. Условной

энтропией величины

при наблюдении величины

называется

Справедливы соотношения:

Взаимной

информацией величин

и

называется

Справедливы следующие соотношения:

Если

и

независимы,

то

=0.

=0.

При расчетах условной энтропии и взаимной информации удобно пользоваться следующими соотношениями теории вероятностей:

1)

теорема умножения вероятностей

;

;

2)

формула полной вероятности

3)

формула Байеса

Теорема

Шеннона для дискретного канала:

Если поток информации, вырабатываемый

источником, достаточно близок к пропускной

способности канала связи, т.е.

,

где

,

где

–

сколь угодно малая величина, то всегда

можно найти такой способ кодирования,

который обеспечит передачу всех сообщений

источника, причем скорость передачи

информации будет весьма близкой к

пропускной способности канала.

–

сколь угодно малая величина, то всегда

можно найти такой способ кодирования,

который обеспечит передачу всех сообщений

источника, причем скорость передачи

информации будет весьма близкой к

пропускной способности канала.

Непрерывные

системы передачи информации. Пусть

– реализации непрерывного сообщения

на входе какого-либо блока схемы связи,

– реализации непрерывного сообщения

на входе какого-либо блока схемы связи,

– реализация выходного сообщения

(сигнала),

– реализация выходного сообщения

(сигнала),

– одномерная плотность вероятности

ансамбля входных сообщений,

– одномерная плотность вероятности

ансамбля входных сообщений,

– одномерная плотность вероятности

ансамбля выходных сообщений,

– одномерная плотность вероятности

ансамбля выходных сообщений,

– совместная плотность вероятности,

– совместная плотность вероятности,

– условная плотность вероятности

– условная плотность вероятности

при

известном

при

известном

Тогда для количества информации

Тогда для количества информации

справедливы следующие соотношения:

справедливы следующие соотношения:

,

,

Здесь

– взаимная информация между каким-либо

значением

– взаимная информация между каким-либо

значением

входного

и значением

выходного

сообщений,

входного

и значением

выходного

сообщений,

– средние значения условной информации,

– средние значения условной информации,

– полная средняя взаимная информация.

Условная энтропия определяется по

формуле:

– полная средняя взаимная информация.

Условная энтропия определяется по

формуле:

Когда

и

и

статистически связаны между собой, то

статистически связаны между собой, то

При независимых и

Полная средняя взаимная информация определяется формулой:

Теорема Шеннона для непрерывного канала с шумом. Если энтропия источника непрерывных сообщений сколь угодно близка к пропускной способности канала, то существует метод передачи, при котором все сообщения источника будут переданы со сколь угодно высокой верностью воспроизведения.

Дискретный канал связи с помехами

Каналом

без памяти

называется канал, в котором на каждый

передаваемый символ сигнала, помехи

воздействуют, не зависимо от того, какие

сигналы передавались ранее. То есть

помехи не создают дополнительные

коррелятивные связи между символами.

Название «без памяти» означает, что при

очередной передаче канал как бы не

помнит результатов предыдущих передач.

При наличии помехи среднее количество

информации в принятом символе сообщении

–

Y,

относительно переданного – X

равно:

Для символа сообщения XT длительности T, состоящего из n элементарных символов среднее количество информации в принятом символе сообщении – YT относительно переданного – XT равно: I(YT, XT) = H(XT) – H(XT/YT) = H(YT) – H(YT/XT) = n [H(Y) – H (Y/X)

Для определения потерь в дискретном канале связи используется канальная матрица (матрица переходных вероятностей), позволяющая определить условную энтропию характеризующую потерю информации на символ сообщения. Скорость передачи информации по дискретному каналу с помехами равна:

Пропускная способность дискретного канала при наличии помех равна максимально допустимой скорости передачи информации, причем максимум разыскивается по всем распределениям вероятностей p(x) на X и, поскольку, энтропия максимальна для равномерного распределения (для равновероятных символов сообщения), то выражение для пропускной способности имеет вид:

.

.

Как видно из формулы, наличие помех уменьшает пропускную способность канала связи.

Основная теорема Шеннона о кодировании для дискретного канала с помехами: Для дискретного канала с помехами существует такой способ кодирования, который позволяет осуществлять безошибочную передачу информации, если производительность источника ниже пропускной способности

Согласование сигнала с каналом. Канал связи можно характеризовать так же, как и сигнал, тремя параметрами: временем ТК, в течение которого по каналу ведется передача; полосой пропускания канала FK и динамическим диапазоном DK. Под динамическим диапазоном канала понимают отношение допустимой мощности передаваемого сигнала к мощности помехи, неизбежно присутствующей в канале. Типы каналов, по которым передаются сообщения, многочисленны и разнообразны. Широко применяются каналы проводной связи, коротковолновой радиосвязи с использованием отражения от ионосферы, ультракоротковолновой связи ионосферного и тропосферного рассеяния, метеорной связи, космической связи и т. п. Характеристики этих каналов значительно отличаются друг от друга. Обобщенной характеристикой непрерывного канала является его емкость (объем): VK = ТК * FK * DK.

Необходимым условием неискаженной передачи по каналу сигналов с объемом VС должно быть VC<VK. Для согласования сигнала с каналом осуществляют вторичное преобразование первичного сигнала. В простейшем случае сигнал согласуют с каналом по всем трем параметрам, т.е. добиваются выполнения условий: ТС<ТК; FC<FK; DC<DK.

При этих условиях объем сигнала полностью «вписывается» в объем канала. Однако первое неравенство может выполняться и тогда, когда не выполнены одно или два из вторых неравенств. Это означает, что можно производить «обмен» длительности на ширину спектра или ширину спектра на динамический диапазон и т.д. Например, записанный на пленку сигнал можно воспроизводить с пониженной скоростью. При этом диапазон частот исходного сигнала уменьшится во столько раз, во сколько увеличится время передачи. Принятый сигнал также записывается на пленку, а затем воспроизводится с повышенной скоростью для восстановления исходного сигнала. Записанный сигнал можно передавать также и с повышенной скоростью. Широко используется также обмен динамического диапазона на полосу пропускания. Так, использование помехоустойчивых широкополосных видов модуляции позволяет передать сообщение по каналам с увеличенным уровнем помех. Но это требует полосы пропускания канала более широкой, чем спектр сообщения.

,

,