- •Министерство образования и науки Российской Федерации

- •Введение

- •Измерения в экономике

- •Глава 1. Простой корреляционный и регрессионный анализ

- •Коэффициент парной корреляции

- •1.2. Парная (простая) линейная регрессия

- •1.2.1. Метод наименьших квадратов (мнк) и его предпосылки

- •1.2.2. Оценки точности уравнения регрессии и его параметров

- •1.3.2. Проверка остатков регрессии на автокорреляцию (статистика Дарбина – Уотсона)

- •Глава 2. Множественная корреляция и регрессия

- •2.1. Множественный корреляционный анализ

- •2.1.1. Анализ матрицы парных коэффициентов корреляции

- •2.1.2. Частная и множественная корреляция

- •2.2. Множественный регрессионный анализ

- •2.2.1. Метод наименьших квадратов и его предпосылки

- •2.2.2 Свойства мнк-оценок

- •2.2.3. Показатели точности уравнения регрессии и оценок его параметров

- •2.2.4. Мультиколлинеарность

- •2.2.5. Тестирование предпосылок мнк для множественной регрессии Анализ остатков уравнения множественной регрессии на автокорреляцию

- •Тестирование остатков на гомоскедастичность

- •Тестирование ошибки спецификации уравнения регрессии

- •2.2.6. Учёт некоторых нарушений стандартных предположений о модели

- •2.2.7. Обобщённый метод наименьших квадратов

- •2.2.8. Стандартизованное уравнение множественной регрессии

- •2.2.9. Дискретные переменные в регрессионном анализе

- •2.2.10. Дискретные (качественные) зависимые переменные

- •2.2.11. Пошаговый регрессионный анализ

- •Глава 3. Стохастические объясняющие переменные в регрессионном анализе

- •3.1. Инструментальные переменные

- •3.2. Системы одновременных уравнений

- •3.2.1. Оценивание параметров системы одновременных уравнений

- •Библиографический список

- •Оглавление

- •Глава 1. Простой корреляционный и регрессионный анализ……………… 5

- •Глава 2. Множественная корреляция и регрессия………………………… 23

- •Глава 3. Стохастические объясняющие переменные

- •Учебное издание

2.2. Множественный регрессионный анализ

Если в регрессионном анализе рассматривается пара переменных (одна зависимая, одна независимая), то говорят о парной или простой регрессии. Если независимых переменных более одной, то говорят о множественной регрессии.

2.2.1. Метод наименьших квадратов и его предпосылки

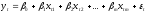

Рассмотрим уравнение линейной множественной регрессии. Уравнение генеральной совокупности или модель регрессии запишем в виде

,

(t

=

,

(t

= ),

(2.1)

),

(2.1)

где

– значения зависимой переменной с

номеромt;

– значения зависимой переменной с

номеромt;

–значения

независимых переменных с номером t;

–значения

независимых переменных с номером t;

–параметры

уравнения регрессии,

–параметры

уравнения регрессии,

– константа или свободный член уравнения

регрессии,

– константа или свободный член уравнения

регрессии, – коэффициенты уравнения регрессии;

– коэффициенты уравнения регрессии;

–значения

случайного члена уравнения регрессии.

–значения

случайного члена уравнения регрессии.

Предполагается,

что εt

независимы и нормально распределены с

нулевым математическим ожиданием и

постоянной дисперсией

,

т. е.

,

т. е.

N(0,

N(0, ).

).

Термины «зависимая» и «независимые» для переменных не совсем удачны и означают лишь, что в этом случае значения зависимой переменной оцениваются на основе известных значений независимых переменных.

Приведём предпосылки спецификации классической регрессионной модели:

эндогенная,

зависимая переменная объясняется m

экзогенными, независимыми переменными;

эндогенная,

зависимая переменная объясняется m

экзогенными, независимыми переменными;

в

общем случае уравнение регрессии

включает константу;

в

общем случае уравнение регрессии

включает константу;

объём

выборки n

должен быть значительно больше числа

объясняющих переменных m

(считается, что каждый регрессор должен

быть обеспечен не менее 6–7 наблюдениями);

объём

выборки n

должен быть значительно больше числа

объясняющих переменных m

(считается, что каждый регрессор должен

быть обеспечен не менее 6–7 наблюдениями);

разность

n–m–1

называется числом степеней свободы

модели; чем она больше, тем надёжнее

результаты оценивания;

разность

n–m–1

называется числом степеней свободы

модели; чем она больше, тем надёжнее

результаты оценивания;

параметры

уравнения регрессии

параметры

уравнения регрессии

должны быть постоянными для всей выборки;

это положение зачастую определяет

выборку.

должны быть постоянными для всей выборки;

это положение зачастую определяет

выборку.

Кроме

предпосылок спецификации модели

необходимо выполнение ещё и предпосылок

метода наименьших квадратов (МНК). Как

известно, оценки параметров модели

линейной регрессии обычно рассчитываются

на основе МНК. Доказано, что эти оценки

будут «хорошими», т.е. несмещёнными,

эффективными и состоятельными, если

будут выполняться следующие предпосылки

относительно поведения остаточного

члена

:

:

математическое

ожидание

математическое

ожидание

равно нулю для всехt,

т.е. M(

равно нулю для всехt,

т.е. M( )

= 0;

)

= 0; t;

t;

дисперсия

дисперсия

постоянна, т.е.D(

постоянна, т.е.D( )

= 0

)

= 0 t,

в этом случае говорят, что в остатках

наблюдается гомоскедастичность; в

противном случае – гетероскедастичность;

t,

в этом случае говорят, что в остатках

наблюдается гомоскедастичность; в

противном случае – гетероскедастичность;

случайные

отклонения

случайные

отклонения

и

и независимы

друг от друга дляt

независимы

друг от друга дляt s,

в этом случае говорят, что в остатках

отсутствует какая-либо автокорреляция;

s,

в этом случае говорят, что в остатках

отсутствует какая-либо автокорреляция;

регрессоры

и остатки должны быть независимыми.

регрессоры

и остатки должны быть независимыми.

Кроме

основных предпосылок, рассматриваются

ещё две дополнительные –

отсутствие между регрессорами сильной

линейной зависимости (совершенной

мультиколлинеарности) и что

N(0,

N(0, En).

Последняя предпосылка не влияет на

качество оценок и необходима для проверки

статистических гипотез и построения

интервальных оценок.

En).

Последняя предпосылка не влияет на

качество оценок и необходима для проверки

статистических гипотез и построения

интервальных оценок.

Одна из задач эконометрики – тестирование выполнимости предпосылок и выработка методов оценивания при их нарушениях.

Оцененное уравнение регрессии будем записывать так:

,

(t

=

,

(t

=

).

(2.2)

).

(2.2)

Здесь

– оценки параметров уравнения регрессии,

а

– оценки параметров уравнения регрессии,

а – выборочная реализация случайного

процесса

– выборочная реализация случайного

процесса .

.

Представим уравнение генеральной совокупности и оценённое уравнение регрессии в матричной форме. Введём следующие обозначения:

Y

=

,X

=

,X

=

,b

=

,b

=

,e

=

,e

=

,

и т. д.

,

и т. д.

Тогда уравнения регрессии (2.1) и (2.2) в матричной форме примут вид

Y

= X +

+

иY

= Xb

+ e.

(2.3)

иY

= Xb

+ e.

(2.3)

МНК-оценки параметров уравнения (2.1) рассчитываются из условия минимизации по b квадратичной формы:

Q(b)

=

e

= (Y

– Xb)T(Y

– Xb)

= YTY

– 2YTXb

– bTXTXb.

e

= (Y

– Xb)T(Y

– Xb)

= YTY

– 2YTXb

– bTXTXb.

Продифференцируем Q(b) по b и приравняем результат к нулю:

=

–2XTY

– 2XTXb

= 0.

=

–2XTY

– 2XTXb

= 0.

Откуда имеем

b

=

.

(2.4)

.

(2.4)

Это и есть МНК-оценка параметров уравнения (2.1).

Кроме

того, известно, что несмещённая оценка

дисперсии случайного члена равна

равна

=

=

=

= =

= ,

,

где

– оценённые по уравнению (2.2) значения

зависимой переменной.

– оценённые по уравнению (2.2) значения

зависимой переменной.