Лекции по ИТ

.pdf

ИНФОРМАЦИЯ

Информация — это совокупность сведений, подлежащих хранению, передаче, обработке и использованию в человеческой деятельности.

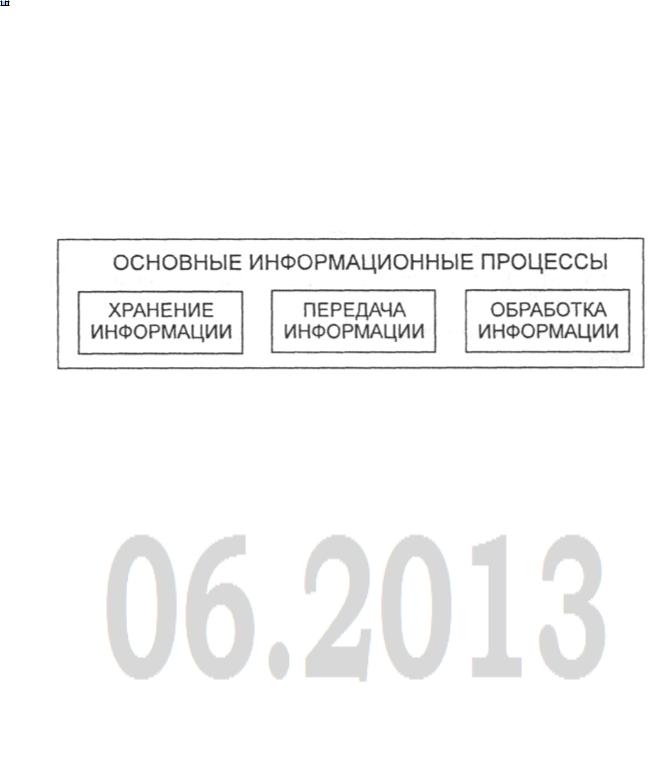

Основные информационные процессы: что обычно делают с информацией? Вопервых, её стремятся сохранить: запомнить или записать. Во-вторых, передают. В третьих, создают новую информацию, выполняя обработку полученной информации. Какой бы информационной деятельностью мы не занимались, вся она сводится к осуществлению трех процессов: хранению, передаче и обработке информации (рис. 1).

Рис. 1. Основные виды информационных процессов Хранение информации: хранить информацию можно либо в собственной памяти, либо

на каких-то внешних носителях. Информация на внешних носителях хранится дольше, надежнее.

Передача информации: распространение информации происходит в процессе ее передачи. Передача может происходить при непосредственном разговоре между людьми, через переписку, с помощью технических средств связи. В передаче информации всегда участвуют две стороны: есть источник и есть приемник информации. Источник передает (отправляет) информацию, а приемник ее получает (воспринимает). Передача информации от источника к приемнику всегда происходит через какой-то канал передачи. В процессе передачи информация может искажаться или теряться, если информационные каналы имеют плохое качество или на линии связи действуют помехи (шумы).

Обработка информации: происходит различными способами. Путём математических вычислений, выполненных над исходными данными можно получить новые. Логические рассуждения, иногда помогают получить необходимые данные из запутанной исходной информации. Процесс обработки информации не всегда связан с получением каких-то новых сведений. Это относится к кодированию. Кодирование — это преобразование представления информации из одной символьной формы в другую, удобную для ее хранения, передачи или обработки. В случае, если кодирование производится в целях засекречивания содержания текста, его называют шифрованием. Еще одной разновидностью обработки информации является ее сортировка (иногда говорят - упорядочение). В информатике организация данных по какому-либо правилу,

связывающему ее в единое целое, называется структурированием. Поиск нужной информации также является процессом обработки.

Для облегчения обработки информации создаются информационные системы (ИС). Большинство существующих ИС являются автоматизированными. Автоматизированными называют ИС, в которых применяют технические средства, в частности ЭВМ. Иногда используется более узкая трактовка понятия ИС как совокупности аппаратнопрограммных средств, задействованных для решения некоторой прикладной задачи.

Количественная оценка информации

В качестве основной характеристики сообщения теория информации принимает величину, называемую количеством информации. Это понятие не зависит от смыслового содержания сообщения, от его эмоционального воздействия, полезности и даже от его отношения к реальной действительности, а связано со степенью его неопределенности.

Например, после сдачи зачета или сдачи экзамена вы мучаетесь неопределенностью, вы не знаете, какую оценку получили. Наконец, преподаватель объявляет результаты, и вы получаете одно из двух информационных сообщений: "зачет" или "незачет", а после экзамена одно из четырех информационных сообщений: "2", "3", "4" или "5".

Информационное сообщение об оценке за зачет приводит к уменьшению неопределенности вашего знания в два раза, так как получено одно из двух возможных информационных сообщений. Информационное сообщение об оценке за экзамен приводит к уменьшению неопределенности вашего знания в четыре раза, так как получено одно из четырех возможных информационных сообщений.

Ясно, что чем более неопределенна первоначальная ситуация (чем большее количество информационных сообщений возможно), тем больше мы получим новой информации при получении информационного сообщения (тем в большее количество раз уменьшится неопределенность знания).

Пусть алфавит источника сообщений состоит из m знаков, каждый из которых может служить элементом сообщения. Количество N возможных сообщений длины n равно числу перестановок с неограниченными повторениями:

N = mn

Если для получателя все N сообщений от источника являются равновероятными, то получение конкретного сообщения равносильно для него случайному выбору одного из N сообщений с вероятностью 1/N.

Ясно, что чем больше N, тем большая степень неопределенности характеризует этот выбор и тем более информативным можно считать сообщение.

Поэтому число N могло бы служить мерой информации. Однако, с позиции теории информации, естественно наделить эту меру свойствами аддитивности, т.е. определить ее

так, чтобы она бала пропорциональна длине сообщения (например, при передаче и оплате сообщения - телеграммы, важно не ее содержание, а общее число знаков).

В качестве меры неопределенности выбора состояния источника с равновероятными состояниями принимают логарифм числа состояний:

I = log N = log mn = n log m.

Эта логарифмическая функция характеризует количество информации:

Указанная мера была предложена американским ученым Р.Хартли в 1928 г.

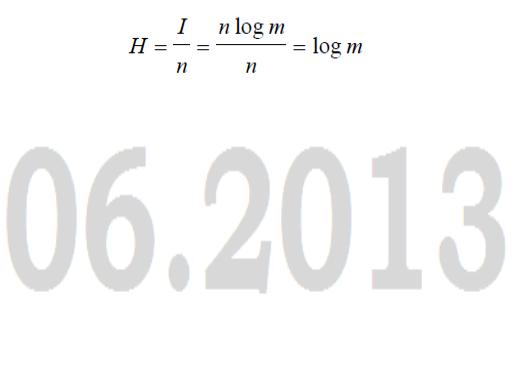

Количество информации, приходящееся на один элемент сообщения (знак, букву), называется энтропией:

В принципе безразлично, какое основание логарифма использовать для определения количества информации и энтропии, т. к. в силу соотношения loga m =loga b logb m переход от одного основания логарифма к другому сводится лишь к изменению единицы измерения.

Так как современная информационная техника базируется на элементах, имеющих два устойчивых состояния, то обычно выбирают основание логарифма равным двум, т.е. энтропию выражают как:

H0 = log2 m.

Тогда единицу количества информации на один элемент сообщения называют двоичной единицей или битом. При этом единица неопределенности (двоичная единица или бит) представляет собой неопределенность выбора из двух равновероятных событий (bit — сокращение от англ. binary digit — двоичная единица)

Так как из log2 m = 1 следует m = 2, то ясно, что 1 бит - это количество информации, которым характеризуется один двоичный элемент при равновероятных состояниях 0 и 1. Двоичное сообщение длины n содержит n бит информации.

Единица количества информации, равная 8 битам, называется байтом.

Если основание логарифма выбрать равным десяти, то энтропия выражается в десятичных единицах на элемент сообщения - дитах, причем 1 дит = log102 бит = 3,32 бит.

Производные единицы измерения количества информации.

Минимальной единицей измерения количества информации является бит, а следующей по величине единицей - байт, причем:

1 байт = 8 битов = 23 битов.

В информатике система образования кратных единиц измерения несколько отличается от принятых в большинстве наук. Традиционные метрические системы единиц, например

Международная система единиц СИ, в качестве множителей кратных единиц используют коэффициент 10n, где n = 3, 6, 9 и т. д., что соответствует десятичным приставкам "Кило" (103), "Мега" (106), "Гига" (109) и т. д.

В компьютере информация кодируется с помощью двоичной знаковой системы, и поэтому в кратных единицах измерения количества информации используется коэффициент 2n

Так, кратные байту единицы измерения количества информации вводятся следующим образом:

1 килобайт (Кбайт) = 210 байт = 1024 байт; 1 мегабайт (Мбайт) = 210 Кбайт = 1024 Кбайт;

1 гигабайт (Гбайт) = 210 Мбайт = 1024 Мбайт.

КОМПЬЮТЕР

История

1642-1945 — Механические компьютеры (нулевое поколение)

В 1642 году Блезом Паскалем, французским ученым была сконструирована счетная машина, которая могла выполнять только операции сложения и вычитания. Она представляла собой механическую конструкцию с шестеренками и ручным приводом. Аналитическая машина Бэбиджа (Первая попытка построить цифровой компьютер). Компьютер Марк 1 содержал около 765 тысяч деталей (электромеханических реле, переключателей и т. п.) достигал в длину почти 17 м (машина занимала в Гарвардском университете площадь в несколько десятков квадратных метров), в высоту — более 2,5 м и весил около 4,5 тонн. Общая протяжённость соединительных проводов составляла почти 800 км. Основные вычислительные модули синхронизировались механически при помощи 15-метрового вала, приводимого в движение электрическим двигателем, мощностью в 4 кВт. Компьютер оперировал 72 числами, состоящими из 23 десятичных разрядов, делая по 3 операции сложения или вычитания в секунду. Умножение выполнялось в течение 6 секунд, деление — 15,3 секунды, на операции вычисления логарифмов и выполнение тригонометрических функций требовалось больше минуты.

1945-1955 — Электронные лампы (первое поколение)

ENIAC (Electronic Numerical Integrator and Computer —электронный цифровой интегратор и калькулятор) - первый электронный компьютер, который состоял из 18 000 электровакуумных ламп и 1500 реле, весил 30 тонн и потреблял 140 киловатт электроэнергии. У машины имелось 20 регистров, причем каждый из них мог содержать 10разрядное десятичное число.

В 1946 году работа над ENIAC была закончена. Правда, тогда она уже была не нужной — по крайней мере, для достижения первоначально поставленных целей. В ENIAC было

установлено 6000 многоканальных переключателей и имелось множество кабелей, протянутых к разъемам.

Фон Нейман вскоре осознал, что создание компьютеров с большим количеством переключателей и кабелей требует длительного времени и очень утомительно и пришёл к мысли, что программа должна быть представлена в памяти компьютера в цифровой форме, вместе с данными. Им также было отмечено, что десятичная арифметика, используемая в машине ENIAC, где каждый разряд представлялся десятью электронными лампами 1 включена и 9 выключены), должна быть заменена параллельной бинарной арифметикой.

Основной проект Фон Неймана был использован в EDSAC, первой машине с программой в памяти, и даже сейчас, более чем полвека спустя, является основой большинства современных цифровых компьютеров. Сам замысел и машина IAS (Immediate Address Storage — память с прямой адресацией) оказали очень большое влияние на дальнейшее развитие компьютерной техники.

Краткое описание проекта Фон Неймана.

Машина фон Неймана состояла из пяти основных частей: памяти, арифметико-логического устройства, устройства управления, устройства ввода, устройства вывода.

Память включала 4096 слов размером по 40 бит. Каждое слово содержало или 2 команды по 20 бит, или целое число со знаком на 40 бит.

8 бит указывали на тип команды, а остальные 12 бит определяли одно из 4096 слов. Арифметический блок и блок управления составляли «мозговой центр» компьютера. В современных машинах эти блоки сочетаются в одной микросхеме, называемой центральным процессором (ЦП).

Внутри арифметико-логического устройства находился особый внутренний регистр на 40 бит, так называемый аккумулятор. Типичная команда добавляла слово из памяти в аккумулятор или сохраняла содержимое аккумулятора в памяти. Эта машина не выполняла арифметические операции с плавающей точкой, поскольку Фон Нейман считал, что любой сведущий математик способен держать плавающую точку в голове.

1955-1965 — Транзисторы (второе поколение)

В 1956 году сотрудниками лаборатории Bell Laboratories Джоном Бардином, Уолтером Браттейном и Уильямом Шокли был изобретен транзистор, за что они получили Нобелевскую премию в области физики. Транзисторы совершили революцию в производстве компьютеров, и к концу 1950-х годов компьютеры на вакуумных лампах уже

безнадежно устарели. В лаборатории МТИ был построен первый компьютер на транзисторах

1965-1980 — Интегральные схемы (третье поколение)

В 1958 году Роберт Нойс создал кремниевую интегральную схему, что дало возможность размещения на одной небольшой микросхеме несколько десятков транзисторов. Компьютеры на интегральных схемах были меньшего размера, работали быстрее и стоили дешевле, чем их предшественники на транзисторах.

1980-н.в. — Сверхбольшие интегральные схемы (четвертое поколение)

В 1980-х годах появление сверхбольших интегральных схем позволило помещать на одну плату сначала десятки тысяч, затем сотни тысяч и, наконец, миллионы транзисторов. Это привело к созданию компьютеров меньшего размера и более быстродействующих. К этому времени цены упали так сильно, что возможность приобретать компьютеры появилась не только у организаций, но и у отдельных людей. Началась эра персональных компьютеров.

Невидимые компьютеры (пятое поколение)

Значительно большее значение придается так называемым «невидимым» компьютерам — тем, что встраиваются в бытовую технику, часы, банковские карточки и огромное количество других устройств. Процессоры этого типа предусматривают широкие функциональные возможности и не менее широкий спектр вариантов применения за весьма умеренную цену.

Устройство

Вычислительная машина (ВМ, Computer) — совокупность технических средств, создающая возможность проведения обработки информации и получение результата в необходимой форме По своему назначению компьютер — универсальное техническое средство для работы

человека с информацией.

Компьютер включает в себя устройства: устройства ввода; устройства запоминания — память;

устройство обработки — процессор; устройства вывода.

В ходе работы компьютера информация через устройства ввода попадает в память; процессор извлекает из памяти обрабатываемую информацию, работает с ней и помещает в нее результаты обработки; полученные результаты через устройства вывода сообщаются

человеку. Чаще всего в качестве устройства ввода используется клавиатура, а устройства вывода — экран дисплея или принтер (устройство печати) (рис.1).

Рис. 1. Информационный обмен в компьютере

Работа компьютера строго подчинена заложенной в него программе.

Память

У компьютера есть два вида памяти: ОЗУ (внутренняя) — оперативная память и ПЗУ (внешняя) — энергонезависимая долговременная память.

Схема устройства компьютера

ОЗУ — это электронное устройство, которое хранит информацию, пока питается электроэнергией. При отключении компьютера от сети информация из оперативной памяти исчезает. Программа во время ее выполнения хранится во внутренней памяти компьютера. Сформулированное правило относится к принципам Неймана. Его называют принципом хранимой программы. Идея состоит в том, что, во-первых, программа вычислений вводится в ЭВМ и хранится в той же памяти, что и исходные числа, а вовторых, команды, составляющие программу, представляются в виде числового кода, по форме ничем не отличаются от чисел и с ними можно производить те же операции, что и с

числами.

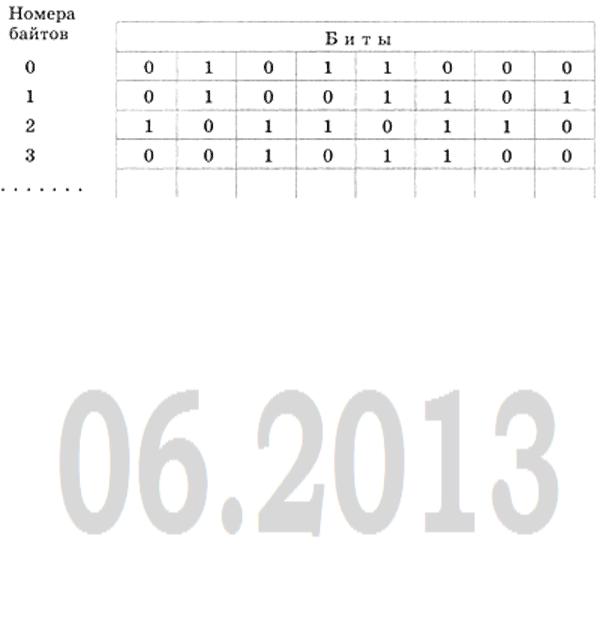

Структуру ОЗУ можно условно изобразить так, как показано на рис. 2.

Рис. 2. Структура внутренней памяти компьютера

Данные и программы в памяти компьютера хранятся в виде двоичного кода.

Битовая структура определяет первое свойство оперативной памяти компьютера — дискретность. Дискретные объекты составлены из отдельных частиц, битов. Второе свойство оперативной памяти компьютера — адресуемость. Восемь расположенных подряд битов памяти образуют байт. Следовательно, в одном байте памяти хранится один байт информации. В оперативной памяти компьютера все байты пронумерованы. Нумерация начинается с нуля. Порядковый номер байта называется его адресом. Принцип адресуемости означает, что запись информации в память, а также чтение ее из памяти производится по адресам.

Память можно представить как многоквартирный дом, в котором каждая квартира — это байт, а номер квартиры — адрес. Для того чтобы почта дошла по назначению, необходимо указать правильный адрес. Именно так, по адресам, обращается процессор к внутренней памяти компьютера.

ПЗУ — это различные магнитные носители (ленты, диски), оптические диски, твердотельные накопители. Сохранение информации на них не требует постоянного электропитания.

Важнейшими устройствами ПЗУ на современных компьютерах являются накопители на магнитных дисках (НМД), или дисководы. На дорожки диска записывается все тот же двоичный код: намагниченный участок — единица, ненамагниченный — нуль. При чтении с диска эта запись превращается в нули и единицы в битах ОЗУ. Чтение/запись на жесткий диск производится быстрее, чем на все другие виды внешних носителей, но все-таки медленнее, чем в оперативную память.

Процессор |

|

|

Центральный процессор (англ. central processing unit, |

CPU, дословно — центральное |

|

обрабатывающее |

устройство) — электронный |

блок либо микросхема — |

исполнитель машинных инструкций (кода программ), главная часть аппаратного обеспечения.

Центральный процессор состоит из:

∙арифметико-логического устройства — выполняющего операции над данными (работа с машинными командами);

∙регистров — сверхбыстрой оперативной памяти очень маленького объема для временного хранения промежуточных результатов при работе с данными;

∙счетчиков команд — регистров с адресами, выполняемых команд;

∙шины данных и шины адресов — для передачи информации и общения с другими устройствами;

∙кэша — очень быстрой памяти малого объема, для временного хранения информации, которая будет запрошена с наибольшей вероятностью. Уменьшает количество обращений к основной памяти, увеличивая тем самым производительность;

∙математического сопроцессора — служит для расширения функциональности и выполнения математических операций над вещественными числами.

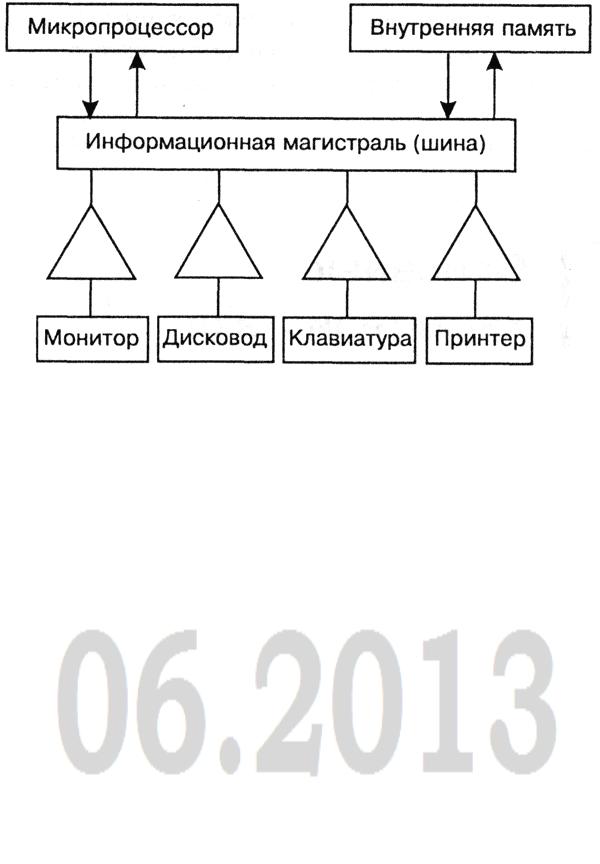

Магистральный принцип взаимодействия устройств ПК Принцип, по которому организована информационная связь между процессором,

оперативной памятью и внешними устройствами, похож на принцип телефонной связи. Процессор через многопроводную линию, которая называется магистралью (другое название - шина), связывается с другими устройствами (рис. 3).

Подобно тому, как каждый абонент телефонной сети имеет свой номер, каждое подключаемое к ПК внешнее устройство также получает номер, который выполняет роль адреса этого устройства. Информация, передаваемая внешнему устройству, сопровождается его адресом и подается на контроллер. В данной аналогии контроллер подобен телефонному аппарату, который преобразует электрический сигнал, идущий по проводам, в звук, когда вы слушаете телефон, и преобразует звук в электрический сигнал, когда вы говорите.

Рис. 3. Структура ПК (треугольниками изображены контроллеры)

Шинами процессора называют линии, по которым происходит связь между процессором и остальными устройствами компьютера Шина данных используется для копирования данных из оперативной памяти в регистры процессора и обратно.

Адресная шина служит процессору для чтения данных из оперативной памяти. По ней процессор сообщает оперативной памяти адрес ячейки, из которой нужно считать данные. Информация по адресной шине передается только в одном направлении - от процессора к памяти.

Шина команд для того чтобы процессор мог обрабатывать данные, ему нужны команды. Он должен знать, что следует сделать с теми байтами, которые хранятся в его регистрах. Эти команды поступают в процессор тоже из оперативной памяти, но не из тех областей, где хранятся массивы данных, а оттуда, где хранятся программы. Команды тоже представлены в виде байтов. Самые простые команды укладываются в один байт, однако есть и такие, для которых нужно два, три и более байтов.

Пропускная способность шины определяется ее разрядностью, то есть числом одновременно передаваемых по ней бит информации, то есть количеством элементарных операций по посылке и принятию информации за единицу времени. Разрядность шины данных и адресной шины на одном компьютере может быть различна. В современных компьютерах наиболее часто используются шины данных с разрядностью 32 и 64 и адресные шины с разрядностью 32. Разрядностью адресной шины определяется величина адресного пространства, то есть максимальное количество доступных процессору ячеек памяти. От разрядности шин зависит следующая характеристика - разрядность процессора.