- •Использование высокопроизводительных Linux-систем в крупномасштабных исследовательских проектах

- •Церн прошел полный цикл

- •Облачный Cloud BioLinux

- •Техасский компьютерный центр передовых исследований

- •Многоядерные процессоры в высокопроизводительных вычислениях

- •Qnap представляет линейку высокопроизводительных систем видеонаблюдения на 32/24 канала стандартной и высокой четкости

- •Высокопроизводительные системы разделения газовых смесей (htgs)

- •Комплект поставки htgs включает:

- •Методики анализа

- •Высокопроизводительные процессоры Intel Haswell-e выйдут раньше, чем ожидалось

- •Что такое вычисления с gpu-ускорением?

- •Как приложения получают ускорение на gpu

- •Сравнение cpu и gpu

- •Как начать работу

- •Самые высокопроизводительные процессоры blackfin® компании analog devices с ускорителем для анализа видеоизображений и малым энергопотреблением

- •Инструменты проектирования для Blackfin adsp-bf60x

- •Ключевые особенности процессоров Blackfin adsp-bf60x

- •Цена и доступность для заказа

- •О компании Analog Devices

- •Процессор

- •Содержание

- •История[править | править исходный текст]

- •Перспективы[править | править исходный текст]

- •Архитектура фон Неймана[править | править исходный текст]

- •Конвейерная архитектура[править | править исходный текст]

- •Суперскалярная архитектура[править | править исходный текст]

- •Cisc-процессоры[править | править исходный текст]

- •Risc-процессоры[править | править исходный текст]

- •Misc-процессоры[править | править исходный текст]

- •Vliw-процессоры[править | править исходный текст]

- •Многоядерные процессоры[править | править исходный текст]

- •Кэширование[править | править исходный текст]

- •Гарвардская архитектура[править | править исходный текст]

- •Параллельная архитектура[править | править исходный текст]

- •Цифровые сигнальные процессоры[править | править исходный текст]

- •Процесс изготовления[править | править исходный текст]

- •Энергопотребление процессоров[править | править исходный текст]

- •Рабочая температура процессора[править | править исходный текст]

- •Тепловыделение процессоров и отвод тепла[править | править исходный текст]

- •Измерение и отображение температуры микропроцессора[править | править исходный текст]

- •Производители[править | править исходный текст]

- •Ссср/Россия[править | править исходный текст]

- •Высокопроизводительные многоядерные процессоры для встраиваемых систем Калачев Александр

- •Введение

- •Процессоры Tile64, Tile64Pro

- •Семейство процессоров Tile-Gx

- •Процессор csx700

- •167-Ядерная вычислительная платформа AsAp-II

- •Сравнительные характеристики процессоров

- •Заключение

- •Литература amd выпускает самый высокопроизводительный процессор в мире для домашних компьютеров - двухъядерный amd Athlon™ 64 fx-60

- •2. Общие принципы организации высокопроизводительных эвм и высокоскоростных вычислений

- •2.1. Повышение быстродействия

- •Области применения высокопроизводительных многоядерных dsp c6000

Цель прогрессивного подхода к хранению данных на основе высокопроизводительных вычислительных систем – повышение производительности и эффективности. Результаты не заставят долго ждать.

Key Points:

Ускоряйтесь!: Неослабевающее быстрое действие повышает производительность и обеспечивает большую окупаемость инвестиций

Бесперебойная работа:Разработаны, чтобы обеспечивать надежность и готовность для непрерывного предоставления данных

От малого к большему: Модульная эффективность системы «в одном корпусе» позволяет снизить расходы на приобретение, обслуживание и эксплуатацию

Высокопроизводительная кластеризация с поддержкой технических приложений предъявляет высокие требования к системам хранения данных. Производительность обычно измеряется в гигабайтах в секунду, а объемы СХД достигают многих петабайтов. Приложения для высокопроизводительных вычислительных систем (HPC), например, для обработки сейсмических данных, моделирования климатических прогнозов, моделирования цифровых изображений, геномных исследований, оборонных нужд и выполнения других операций с большими объемами данных требуют увеличения дисковых массивов и производительности до невероятно высокого уровня, при этом гибкость и эффективность должны сохраняться.

Решение

NetApp® FastStak и DenseStak – эталонные конфигурации, разработанные в соответствии с этими требованиями..

Решение FastStak предназначено для оптимизации производительности СХД путем предоставления самой высокой в отрасли пропускной способности и обеспечения большого числа IOPS.

Решение DenseStak предназначено для оптимизации плотности хранения и максимизации пространства в одной стандартной стойке 40U, с обеспечением высокой производительности.

Вместе эти решения формируют новый подход к системе хранения, который можно корректировать в соответствии с практически любыми требованиями HPC, обеспечивая необходимый для эффективных операций баланс.

Нет необходимости полностью менять конфигурацию, если изменились требования производительности или дискового пространства. Используйте системы HPC для ускорения рабочих процессов и повышения производительности.

Более подробно о о конфигурации решений для хранения HPC. (PDF)

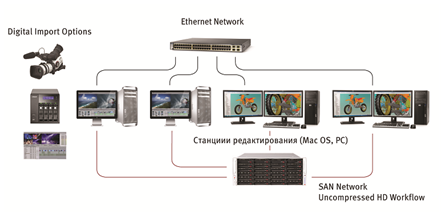

Высокопроизводительные системы хранения данных IntellectDigital серии AVS

С каждым

годом в студиях возрастают требования

к объему данных, к скорости

и удобству доступа и обработки,

к совместимости с существующими

и новыми системами.

С каждым

годом в студиях возрастают требования

к объему данных, к скорости

и удобству доступа и обработки,

к совместимости с существующими

и новыми системами.

Системы хранения данных IntellectDigital семейства AVS производства компании «СВЕТ Компьютерс» для задач обработки медиаконтента — это аппаратно-программный RAID, использующий уникальный многопоточный алгоритм расчета RAID6 и оптимизированный для предоставления максимально высокой производительности при работе с потоковыми данными. Размер кэша ограничен только аппаратной поддержкой платформы, что вносит заметный вклад в скорость работы системы хранения. Инструменты управления доступны через интуитивно понятный web-интерфейс. Встроенная система мониторинга и диагностики позволяет создавать автоматические оповещения об изменении статуса системы, а также проводить детальный анализ и оптимизацию производительности по всему устройству, по пользователям, подключенным к устройству, по RAID-ам построенным на устройстве, по LUN-ам и по целевым портам устройства.

Системы могут поставляться полностью готовыми к эксплуатации и настроенными под индивидуальные требования вашей ИТ-структуры.

Тестирование типичной модели гетерогенного ИТ-парка небольшой студии по созданию и обработке медиаконтента

В рамках проведенного тестирования была использована типичная модель гетерогенного ИТ-парка небольшой компании по созданию и обработке медийного контента, а также организован высокопроизводительный совместный доступ к данным с применением кластерных файловых систем. Реализация данного решения позволяет подключить к томам на хранилище рабочие станции, использующие различные операционные системы (Windows, Linux и Mac).

Модель семейства ID AVS была представлена 24-дисковой системой с возможными интерфейсами подключения Infiniband илиFibreChannel.

Результаты тестирования продемонстрировали высокую производительность параллельного чтения и записи со скоростью до 2.5-3 ГБ/сек при одновременном доступе 3-х рабочих станций под нагрузкой. Тестирование показало, что при выходе одиночного диска системы хранения из строя, производительность не деградирует. Скорость восстановления (реконструкции) массива — менее 4 часов. В представленной системе допустимо подключение до 8 рабочих станций по интерфейсу FC без использования дополнительного коммутатора. Модели ID AVS поддерживают MPIO в режиме балансировки нагрузки для Mac OS, Linux, Windows2003, Windows 2008 и Windows 2008 R2.

Задачи тестирования

Демонстрация высоких показателей производительности системы хранения IntellectDigital на основе ПО AVRORA при работе с типичной нагрузкой для видео-монтажа с применением ПО MetaSAN для предоставления функции разделяемого доступа. Стабильность (неизменность значений скорости чтения и записи) при выходе дисков из строя и при выявлении системой медленно (некорректно) работающего диска. Замер времени восстановления (реконструкции) массива.

Стенд

3 рабочих станции под управлением Windows Server 2008 R2, с установленным ПО MetaSAN версия 4.6.0, подключены напрямую по 2 каналам FibreChannel 8Gb каждая к системе хранения данных ID AVS c 24 дисками SATA.

|

|

Результат |

Суммарная производительность |

|

Параллельное

чтение из одного файла размером

150ГБ с 3 рабочих станций

по 2 каналам

|

1150 МБ/сек 820 МБ/сек 990 МБ/сек |

2.96ГБ/сек |

|

Сохранение

показателей производительности при

выходе из строя 2 дисков

|

При отключении 2 дисков суммарная производительность на чтение и запись осталась прежней (Около 2.6ГБ/сек). |

|

|

Выполнение

реконструкции массива

|

При отсутствии постоянной нагрузки восстановление массива завершилось за 3,6 часа. Время реконструкции массива из 24 дисков — менее 4 часов. |

|

Использование высокопроизводительных Linux-систем в крупномасштабных исследовательских проектах

Оригинал: "HPC Research Projects Find Muscle in Linux Lab Partner " Автор: Carla Schroder Дата публикации: 08 June 2012 Перевод: Н.Ромоданов Дата перевода: июнь 2012 г.

Linux и FOSS являются ключевыми игроками в области науки и исследований, и вместе они широко используются в крупнейших научно-исследовательских проектах в мире. Ниже описаны четыре проекта, в которых рассказано о четырех различных способах использования Linux в крупномасштабных исследованиях.

Церн прошел полный цикл

В начале - был ЦЕРН и там работал Тим Бернерс-Ли (Tim Berners-Lee), который затем изобрел World Wide Web и отдал его миру. У нас уже был Интернет, текст заполонял FidoNets, Nethacks, Usenets и CompuServe. World Wide Web все это приукрасил или сделал более доступным.

Затем появился Линус Торвальдс (Linus Torvalds) и его знаменитое объявление в группе новостей Usenet comp.os.minix от 25 августа 1991 года:

"Привет всем, кто использует minix -

Я делаю (бесплатную) операционную систему (просто хобби, она не будет такой большой и профессиональной, как gnu) для клонов 386 (486) AT".

Крошечному Linux не понадобилось много времени с тем, чтобы стать полезным, а системе Linux, открытому исходному коду и открытым сетевым протоколам — что стать причиной удивительного роста сети интернет. Конечно, эта история более запутана — в ней решающие роли сыграли Ричард Столлман (Richard Stallman), изобретатели языков программирования, UNIX, Тео де Раадт (Theo de Raadt), энтузиасты, поддерживающие дистрибутивы, а также многие другие.

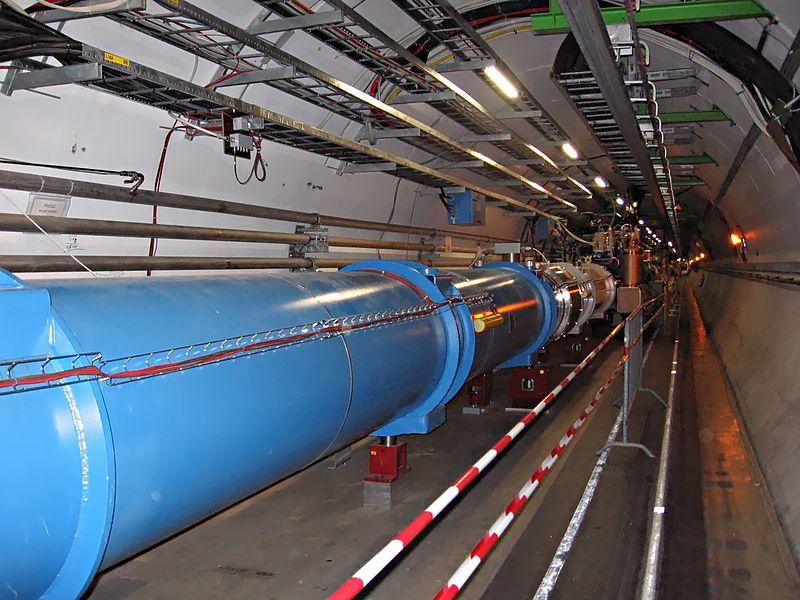

Перенесемся на несколько лет вперед и увидим, что ЦЕРН теперь пожинает плоды своего вклада в подпитку всей этой удивительной творческой инициативы, и теперь в некоторых самых больших в мире вычислительных проектах полагается на Linux. ЦЕРН является пионером в распределенных вычислениях на сеточных вычислительных структурах (grid computing) и руководит проектом LHC Computing Grid (LCG). Это гигантская всемирная сеть, с помощью которой реализовано хранение и управление данными, получаемыми на Большом адронном коллайдере, который, как говорят, генерирует 15 петабайт данных в год. Программное обеспечение, поддерживающее работу среднего слоя системы, работает на Scientific Linux и может устанавливаться на других дистрибутивах, хотя оно было опробовано только на SL. В ЦЕРНе на более чем 50000 собственных серверах и рабочих станциях используюется как Scientific Linux, так и его собственные вариант Scientific Linux CERN.

Рис.1: Большой адронный коллайдер. Фото предоставлено Wikimedia Commons.

Мы, простые смертные, можем, благодаря проекту LHC@home, тоже принять участие.

CERN всегда был сторонником открытости: открытые стандарты, протоколы и открытый доступ к информации. Здесь следуют политике открытого доступа и здесь подписанаБерлинская декларация.

BOINC

Berkeley Open Infrastructure for Network Computing (BOINC) является популярным программным обеспечением, реализующим средний слой для сеточных вычислительных структур (grid computing). Помните, когда "grid" или "сетка" было ключевым словом дня? Как быстро все меняется. Это программное обеспечение было создано для поддержки проекта SETI@Home и, конечно, оно было быстро взято на вооружение в других проектах. Как говорится на сайте BOINC: "Используйте время простоя вашего компьютера (Windows, Mac или Linux) для лечения болезней, изучения глобального потепления, открытия пульсаров и для многих других научных исследований". Просто установите и настройте BOINC, а затем выберите проект или несколько проектов, которые хотите поддержать. Некоторые из них звучат совершенно по-космически, например, Milkyway@home (млечный путь дома) и Orbit@home (орбита дома). Проект FreeHAL связан с искусственным интеллектом, а мировое сообщество World Community Grid (мировое соотбщенисво сеточных структур) проводит "гуманитарные исследования болезней, стихийных бедствий и голода". Основные пакеты уже должны быть в репозиториях дистрибутивов. Можно легко внести свой вклад в развитие науки. >