- •51. Амплитудно-импульсная модуляция. Спектр аим - колебаний. Почему она применена в представленной схеме уравновешивания?

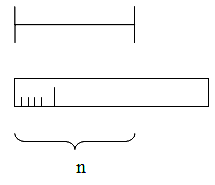

- •Рве 2.28. Импульсная модуляция: а — периодическая последовательность исходных импульсов; б—модулирующий сигнал; в — аим; г — шим; д — фим; е — икм

- •52. Частотное и временное разделение каналов.

- •53. Фильтрация сигналов. Операторы фильтрации.

- •54. Вероятность и информация. Информационное содержание сигнала.

- •55. Энтропия, количество информации по Шеннону.

- •56. Описание непрерывных колебаний во временной и частотной областях.

- •57. Базисные функции. Ортогональные и ортонормированные функции.

- •58. Спектральная плотность случайных колебаний. “Белый шум” и его свойства.

- •59. Случайные колебания и корреляционные функции.

- •60. Способы повышения помехоустойчивости передачи информации.

- •61. Корреляционное разделение каналов и корреляционная фильтрация.

- •62. Демодуляция частотно – модулированных колебаний.

- •63. Виды каналов передачи информации.

- •64. Информация и фазы обращения информации.

- •65. Виды информации. Устранение избыточности информации.

- •66. Структурные меры информации.

- •67. Статистические меры информации. Информационное содержание сигнала.

- •68. Частотная модуляция. Спектры чм – колебаний.

- •69. Какие виды модуляции гармонических колебаний можно обнаружить в радиокомпасе и каковы их спектры?

- •70. Модуляция гармонических колебаний. Виды амплитудной модуляции и как они представлены в арк?

- •71. Дискретизация сигналов. Теорема Котельникова.

- •72. Систематические (семантические) меры информации. Источники и приемники информации.

- •73. Геометрические меры информации. Каким образом они представлены в индикаторах сои?

- •74. Количество информации. Аддитивные меры Хартли.

- •75. Импульсная модуляция, шим, спектр широтно-импульсных колебаний.

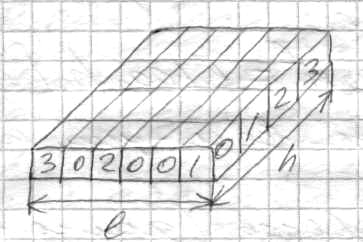

73. Геометрические меры информации. Каким образом они представлены в индикаторах сои?

Количество меры информации при использовании геометрической меры определяется путём измерения длины линии, площади или объема геометрической модели в количестве дискретных единиц (квантах).

n – Мера информации в геометрической структуре.

Можно определить потенциальные, т.е. максимально возможное количество информации в заданных структурных габаритах, которые называют информационной ёмкостью исследуемой части информационной системы, она может быть представлена числом, показывающим количество квантов в полном массиве информации.

Если дискретные отсчеты осуществляются по осям X,T, N через интервалы ΔX, ΔT, ΔN, то непрерывные коэффициенты распадаются на элементы кванты количество которых:

![]() ;

;

![]() ;

;![]()

а количество информации определяемых геометрическим методом:

![]()

в индикаторах СОИ геометрические меры информации представлены в виде дискретных значений шкальных индикаторов и ЖК индикаторов измеряемой величины (давления, высоты, и т.д.)

74. Количество информации. Аддитивные меры Хартли.

Количественная мера информации

Процесс получения информации математически характеризуется изменением распределения вероятности множества различных сообщений. В математическом (операционном) аспекте, это изменение распределения вероятности и есть «информация». Соответственно ее количественная мера (количество информации) и устанавливается как некоторый числовой показатель (функционал), характеризующий отличие апостериорных распределений плотности вероятности различных сообщений от априорного. Такая точка зрения впервые четко была сформулирована К. Шенноном и им же весьма удачно выбрана количественная мера, на основе которой доказаны важнейшие теоремы, определяющие предельно достижимые значения некоторых показателей сообщений и информационных систем .

Количество информации, содержащейся в сообщении, по Шеннону определяется в виде I = Hapr — Haps, (6-64)

где Нарг и Haps — числовые показатели (функционалы), характеризующие априорные и апостериорные распределения вероятностей различных сообщений.

Здесь Нарг и Нара соответственно априорная и апостериорная энтропия системы. Априорная энтропия полностью характеризуется распределением вероятностей состояний системы с учетом статистических связей. Апостериорная энтропия характеризует ту неопределенность системы, которая остается после приема сообщений. Если сообщение однозначно определяет состояние системы, то Нара=0, в противном случае Haps>0.

Аддитивные меры Хартли

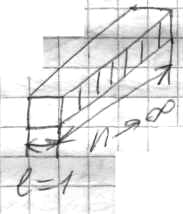

Введем понятие глубины h и длины l – числа (l=1…∞).

Глубиной h назовем количество элементов (знаков) содержащихся в принятом алфавите h соответствует основанию системы счисления и кодирования. В каждый данный момент реализуется один какой-либо знак из h возможных.

Длиной l число назовем количество повторений алфавита необходимых и достаточных для представления чисел нужной величины. l соответствует разности систем счисления и кодирования. При глубине h и длине l количество чисел выразится как:

Q=hl , т.е. ёмкость экспонтенционально зависит от длины числа. Вследствие показательного закона Q(l) число Q не очень удобная мера, для оценки информационной ёмкости, поэтому Р Хартли в 1928 г. ввел аддитивную двоичную логарифмическую меру позволяющею вычислить количество информации в двоичных единицах (битах). Для этого берется не само число Q, а его двоичный логарифм: I=log2Q=log2hl =l log2h - бит;

I – обозначает количество информации по Хартли. Если количество разрядов (длина l числа) равна единице «1» и принята двоичная система счисления для которой глубина h=2:

log221 =1 бит - это и есть единица информации в принятой системе оценки, она соответствует одному элементарному событию которое может произойти или не произойдет. Аддитивная мера удобна тем что она обеспечивает возможность сложения, а также … пропорциональность длины l.

Унарная система

![]()

Двоичная система