1)Понятие об информации.

1.1 Смысл информации.

А) бытовой (сведения, сообщения, которыми обмениваются люди и устройства)

Б) вероятностный (сведенья, которые уменьшаю неопределенность для их получателя)

Вася спрятал в одной руке яблоко, вы стоите перед ним в состоянии неопределенности, мама стоит сзади и видит в какой руке яблоко. Если мама скажет в какой руке яблоко, неопределенность для вас исчезнет. Значит, мама передала для вас информацию. Есть мама подскажет еще раз, то информацию вам она уже не передаст.

Вывод:

Информация зависит от получателя и контекста (время, место).

Информация в таком смысле даже может быть умерена количественно, что и делается в теории информации.

Количество информации, достаточно между 2-мя альтернативами называют 1 бит.

Значит мама передала 1 бит, не зависимо от того, в какой форме было сообщение (словом, местом и т. д). Самая компактная форма кодирования – передавать 0 или 1 для правой или левой руки собственно.

Пример для самостоятельного решения.

Парадокс Монти- Холла (о том, как внесение информации меняет вероятность)

Есть телеигра со следующими правилами:

За одной из 3-х дверей находиться автомобиль, за другими пусто. Вам предлагается выбрать дверь, за которой вы ожидаете машину. После вашего выбора ведущий вскрывает одну из оставшихся дверей, за которой пусто, и предлагает еще сделать выбор уже между 2- мя дверями. Стоит ли менять первоначальный выбор.

Физический и математический смысл.

Информация – величина, обратная к энтропии.

Энтропия в термодинамике - мера хаоса в системе, т. е наибольшей однородности.

Максимальной энтропии обладает объем газа с равномерной температурой. Все его частицы движутся полностью хаотично, никаких процессов в нем без притока энергии извне происходить не может. Энтропия постепенно растет до максимума в любой закрытой системе, любая разница температур выравнивается. Происходит так называемая тепловая смерть системы.

В природе есть много неэнтропийных процессов с уменьшение энтропии. Они происходят в живой природе.

Есть гипотеза о будущей тепловой смерти вселенной. Ее истинность зависит от того, открытая это система или закрытая.

Есть наука синергетика, которая занимается открытыми системами и неэнтропийными процессами.

В математике есть раздел «теория сложностей», автор которого А.М. Колмогоров. Сложность некоторого формального объекта в теории сложности принимается равной минимальной длине алгоритма, который может породить этот объект.

Сложность блюда логично принять равной кратчайшей длине рецепта по его изготовлению. Физическая информация очевидно связана со структурой и поведением (кол – во состояний и переходов между ними) объекта. Очевидно, например, что евроокно информационный проще, чем кубик Рубика.

Примеры информационных явлений (процессов) можно найти в природе на любом уровне, начиная от кристаллов и явлений самоорганизации кристаллических решеток и кончая сложнейшими первыми и генетическими системами, в живой природе.

Современные науки выделяют 3 субстанции в материи: вещество, энергия и информация.

В природе действуют законы сохранения вещества и энергии. Любое взаимодействие между объектами, в которой один объект принимает некоторою субстанцию, а другой ее не теряет называют информационным взаимодействием, а саму субстанцию – информацией.

Тем не менее информация всегда существует в неразрывной связи со своим носителем, вещественным или энергетическим, но при этом информация не зависит от носителя, может неограниченно тиражироваться на многих носителях, при этом стоимость тиражирования имеет тенденцию к уменьшению.

Научно- технические революции, в этом числе информационные: изобретения огня, бронзовый век, железный век, изобретение письменности, изобретение книгопечатанья, машинное производство, отделение и универсализация производства энергии (электроэнергия, электросвязь, изобретение денежной системы.

Мы видим, что каждая революция связана с изменением в способах преобразования, хранения и передачи вещества энергии, информации. Видим, что в списке еще нет революции в обработке информации. Она произошла в середине XX века с изобретением ЭВМ. Этот переворот тесно связан с очередными переворотами в обработке энергии и вещества. ЭВМ изначально использовались для управления космическими полетами, ядерной энергетики и т.д.

Д/з :1) парадокс Монти – Холла.

2) Сколько бит информации содержит сообщение о том когда у человека день рождения, если вы это еще не знали?

3) Сколько бит информации вы сообщаете лифту в доме из этажей, когда нажимаете на кнопку? (чисто бит будет не целым)

1)Разбор парадокса Монти – Холла

При решении этой задачи обычно рассуждают так: ведущий всегда в итоге убирает одну проигравшую дверь, и тогда вероятность появления автомобиля за двумя неоткрытыми дверьми становится равной ½, в зависимости от первоначального выбора.

Вся суть в том, что своим первоначальным выбором участник делит двери А и две другие В и С. Вероятность того, что автомобиль находится за выбранной дверью = 1/3, того, что за другими = 2/3. Для которой из оставшихся дверей сложившаяся ситуация описывается так. Дверь В – 2/3*1/2= 1/3; дверь С – 2/3 * ½ =1/3; где ½ условная вероятность для данной двери при условии, что автомобиль не за дверью, выбранной игроком.

Ведущий, открывая одну из оставшихся дверей всегда проигрышную, сообщая тем самым игроку ровно 1 бит информации, а менее условные вероятности для В и С соответственно на «1» и «0» . В результате выражения принимают вид Р(В)=2/3*1=2/3, Р(С)=2/3*0=0.

Таким образом участнику следует изменить свои первоначальный выбор - в этом случае вероятность выигрыша будет = 2/3.

Одним из простейших объяснений является следующее. Вероятность того, что изначально была выбрана дверь, скрывающая кому равна 2/3 и того никак не связано с тем, что открыл дверь; когда выбрана с вероятностью 2/3. Следовательно, смена выбранной двери обеспечит равную 2/3 вероятность выбора автомобиля.

2)9 бит 3) 2x=n x= log2 n

Кол – во информации необходимо для выбора из n альтернативы (т. е для кодирования одного из n двоичных значений) log2 n. И наоборот, имея n бит, можно закодировать 2 разных значений.

Данные и их представления

Данные – это информация, предоставленная в формализованном виде, пригодном для автоматизированной сборки.

Пример: значения некоторые данные, надо уметь быть записано совершенно разумным способами ( на разных носителях, в разных системах счисления).

Имея некоторые данные, надо уметь правильно их интерпретировать, т. е восстановить из них ту информацию, которая была закодирована. Существуют 2 способа представлять данные аналогичным сигналом и цифровым сигналом. Более общие математические синонимы - непрерывный и декретный.

Аналоговый сигнал - непрерывно изменяющийся во времени, представший непрерывной функцией во времени.

Цифровой сигнал – рассматриваемый на множестве временных отрезков и принимающих значение из множества возможных значений.

Непрерывная функция, которая для любого

x0 на некотором

отрезке и (x 0 64)и для

любого сколь угодно малого Е существует

δ, что при

![]() *

*

![]()

Неформально говоря, это значит, что в любой точке где функция непрерывна, можно вписать ее в график в сколь угодно малый треугольник. (по высоте).

Дискретность явления – его представимость элементами конечного или отчетного множества.

Счетное множество - бесконечное множество, элементы которого можно пронумеровать натуральными числами.

Несчетное множество - множеств информационных чисел, действительные числа.

В математике есть раздел дискретной математике, которая изучает дискретные структуры.

В математическом понимании – дискретный не значит конечный, но в технике значит.

Мир непрерывен или дискретен?

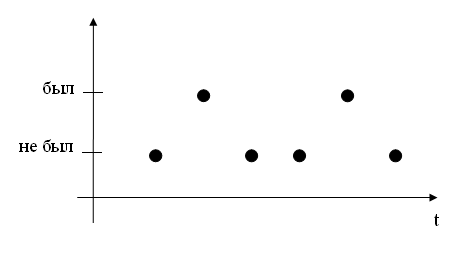

На микроуровне имеется дискретность. Это элементарные частицы. Есть мнение, что время тоже дискретно, т. е имеется наименьший интервал (10-44 C) - он же наименьший период волн. Но с другой стороны любая элементарная частица является волной, а волна – это понятие непрерывно. На макроуровне физический мир непрерывен, но человек в своем восприятии выделяет в нем отдельные объекты, т.е можно считать, что на физическом уровне сигналь всегда непрерывен. Если он интерпретируется непрерывно, то это аналоговый сигнал, а если мы используем конечный набор уровней сигнала, то это цифровой сигнал. Например: будет передавать в эфир отметил о посещении студентом занятий с предыдущего графика, но не сможем сделать сигнал бесконечно коротким и включить и выключить его мгновенно, поэтому реально это будет выглядеть так:

Кроме того всегда есть помехи. Таким образом, для передачи цифровых данных нужно изменять параметры сигнала так, чтобы были различны отдельные значения из конечного набора (здесь, в том числе важно, чтобы помехи не превышали по своей величине различий между значениями).

Процесс изменения параметров аналогового сигнала в соответствии с цифровыми данными называют цифровой модуляцией (в аналоговой связи бывает аналоговая модуляция, когда параметры изменяются в связи с другими аналоговыми сигналами).

Обычно изменяемый параметр – амплитуда. Это называют амплитудой модуляции.

В высокочастотной радиосвязи изменяются в небольших пределах частоту несущего сигнала при постоянной амплитуде.

Основные преимущества цифрового сигнала – устойчивость к ошибкам (мелкие искажения не влияют на возможность однозначно узнавать цифровые значения, хотя крупные могут искать цифровой сигнал, однако для цифрового сигнала существует алгоритм коррекции ошибок, например, в архиваторах есть настройка «добавить данные для восстановления»). Недостаток - любой аналоговый носитель имеет меньшую информационную емкость, если он используется для передачи цифровых данных. Именно поэтому цифровое вещание только кабельное.

Чаще всего используется двоичный цифровой сигнал, иногда троичный. Например, в цифровой электронике может использоваться 3 вольта для код 1 и 0,5 в – 0.

Встречается задача, представления аналоговых данных цифровой сигнал.

Таким образом, мы вспомнили дискретизацию чисел - приближения написанных аналоговых данных в дискретной последовательности, может ее закодировать двоичной и представить на цифровом носителе.

Допустим, на кодирование дано 8 бит, 160=10100000

Параметрами, влияющими на постфакторы дискретизации является частота выбора или разрешения для пространственных данных , например изображения и глубина кодирования – сколько возможных значений выделяется под каждым измерением . Обычно выделяется целое число бит 8 бит- 256 возможных значений16 бит – 65636; 32 бит- порядка 2 млрд. Для кодирование звука применяется обычно 16 бит, иногда 8 или 20. Частота выборки должна быть как минимум в 2 раза больше максимальной записываемой частоты. Если предел отношения человека 20кГц, то частота выборки обычно берется 44 кГц.

Для кодирования 1 пикселя изображения обычно используют 24 бит.

К цифровым данным можно применять сжатие. Есть 2 вида сжатия: сжатие без потерь и сжатие с потерями. Сжатие без потерь основано на поиске повторяющихся последовательностей данных и их кодирования особым образом. Так работают архиваторы.

Формат bmp поддерживает режим RLE, при котором m рядом стоящих пикселей одинакового цвета будут записаны 1 раз с добавлением множителя n.

Современный графический формат для представления без потерь – PNG (Portable Netovork Grafic).

Однако цифровой сигнал с « живых» данных (звук, фото) полученный дискретизацией не содержит повторяющих последовательностей «как линиями из-за помех и погрешности измерений . Для таких данных может применяться сжатие с потерями. Оно учитывает особенности человеческого восприятия и удаляет ту информацию, которую человек не замечает. В изображении происходит сглаживание редких переходов (jped). Удаление малейших очертаний читает в звуке. (mp3. ogg). Алгоритм сжатия типа jpeg используют временное сжатие при котором для длинных похожих сцен записывается только начальный кадр, а затем его изменения (mpeg). Формат …. Используют только покадровое jpeg сжатия поэтому занимает много места.