- •Информация и её свойства, информационные процессы

- •Двоичное кодирование информации в компьютере. Единицы представления и измерения информации

- •Двоичное кодирование текстовой информации

- •Аналоговый и дискретный способы представления изображений и звука. Двоичное кодирование звуковой информации

- •Дискретизация - это преобразование непрерывных изображений и звука в набор дискретных значений в форме кода.

- •Файлы и файловая структура

- •Аппаратное обеспечение вычислительной системы. Базовая аппаратная конфигурация пк

- •Основные компоненты системного блока

- •Процессор и оперативная память

- •Программное обеспечение вычислительной системы

Двоичное кодирование информации в компьютере. Единицы представления и измерения информации

Для автоматизации работы с данными, относящимися к различным типам, очень важно унифицировать их форму представления — для этого обычно используется прием кодирования, то есть выражение данных одного типа через данные другого типа. Своя система существует и в вычислительной технике — она называется двоичным кодированием и основана на представлении данных последовательностью всего двух знаков: 0 и 1. Эти знаки называются двоичными цифрами, по английски — binary digit или, сокращенно, bit (бит). Одним битом могут быть выражены два понятия: 0 или 1 (да или нет, черное или белое, истина или ложь и т. п.).

В компьютере для представления информации используется двоичное кодирование, так как удалось создать надежно работающие технические устройства, которые могут со стопроцентной надежностью сохранять и распознавать не более двух различных состояний:

электромагнитные реле (замкнуто/разомкнуто), широко использовались в первых конструкциях ЭВМ;

участок поверхности магнитного носителя информации (намагничен/размагничен);

участок поверхности лазерного диска (отражает/не отражает);

триггер (может устойчиво находиться в одном из двух состояний, широко используется в оперативной памяти компьютера).

Все виды информации в компьютере кодируются на машинном языке, в виде логических последовательностей нулей и единиц.

Существует много различных систем и единиц измерения данных. Каждая научная дисциплина и каждая область человеческой деятельности может использовать свои, наиболее удобные или традиционно устоявшиеся единицы. В информатике для измерения данных используют тот факт, что разные типы данных имеют универсальное двоичное представление и потому вводят свои единицы данных, основанные на нем. Наименьшей единицей представления данных является бит (двоичный разряд), а наименьшей единицей измерения является байт (8 бит). Поскольку одним байтом, как правило, кодируется один символ текстовой информации, то для текстовых документов размер в байтах соответствует лексическому объему в символах. Более крупная единица измерения — килобайт (Кбайт). Условно можно считать, что 1 Кбайт примерно равен 1000 байт. Условность связана с тем, что для вычислительной техники, работающей с двоичными числами, более удобно представление чисел в виде степени двойки и потому на самом деле 1 Кбайт равен 210 байт (1024 байт). В килобайтах измеряют сравнительно небольшие объемы данных.

Более крупные единицы измерения данных:

1 Мбайт = 1024 Кбайт = 1020 байт

1 Гбайт = 1024 Мбайт = 1030 байт

1 Тбайт = 1024 Гбайт = 1040 байт

Двоичное кодирование текстовой информации

Начиная с 60-х годов, компьютеры всё больше стали использоваться для обработки текстовой информации. Традиционно, для кодирования одного символа используется 1 байт (8 битов). С помощью 8-разрядного двоичного числа можно закодировать 256 различных символов. Этого хватит, чтобы закодировать все символы английского и русского языков, как строчные, так и прописные, а также знаки препинания, символы основных арифметических действий и некоторые общепринятые специальные символы, например символ «§».

Кодирование текстовой информации заключается в том, что каждому символу присваивается десятичный порядковый номер от 0 до 255. Каждому номеру соответствует 8-разрядное двоичное число от 00000000 до 11111111. Человек различает символы по их очертаниям, а компьютер – по их кодам. При вводе в компьютер текстовой информации происходит её двоичное кодирование, изображение символа преобразуется в его двоичный код. Пользователь нажимает на клавиатуре клавишу с изображением символа, а в компьютер поступает определенная последовательность из 8 электрических импульсов (двоичный код символа). В процессе вывода символа на экран компьютера происходит обратный процесс – декодирование, то есть преобразование кода символа в изображение.

Присвоение символам конкретных кодов зафиксировано в специальной кодовой таблице. Для того чтобы весь мир одинаково кодировал текстовые данные, нужны единые таблицы кодирования. Исторически наибольшее распространение получила американская система кодирования ASCII (American Standard Code for Information Interchange — стандартный код информационного обмена США).

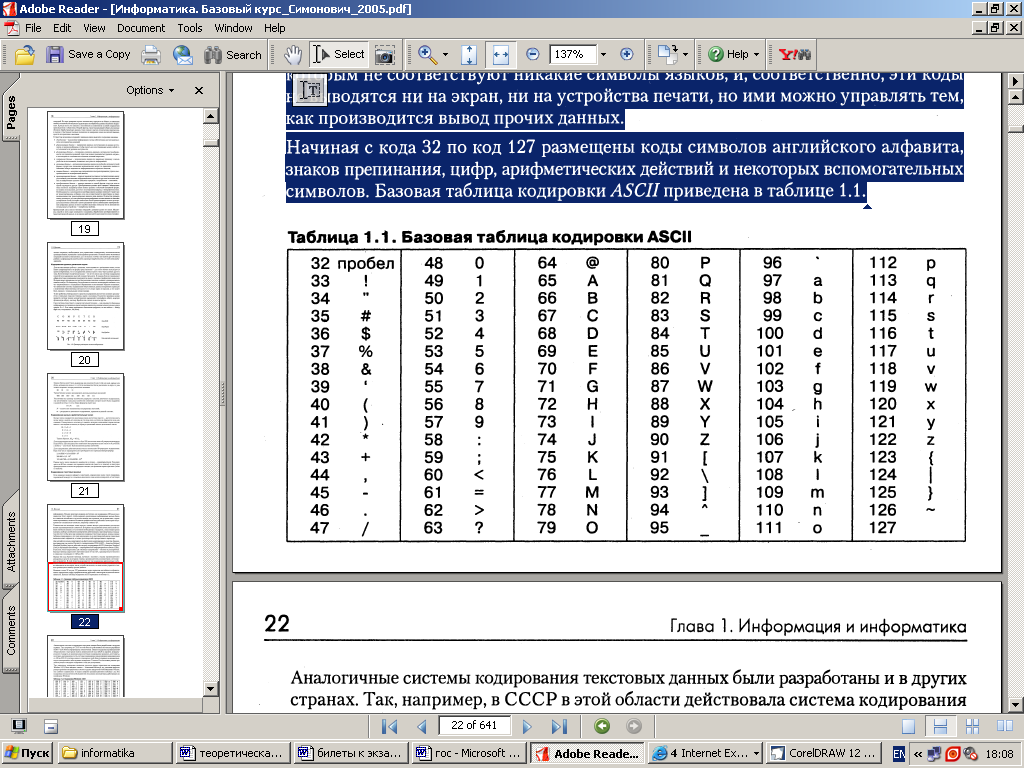

В системе ASCII закреплены две таблицы кодирования — базовая и расширенная. Базовая таблица закрепляет значения кодов от 0 до 127, а расширенная относится к символам с номерами от 128 до 255. Первые 33 кода базовой таблицы, начиная с нулевого, соответствуют не символам, а операциям (перевод строки, пробел и т.д.) Начиная с кода 33 по код 127 размещены коды символов английского алфавита, знаков препинания, цифр, арифметических действий и некоторых вспомогательных символов. Базовая таблица кодировки ASCII приведена в таблице.

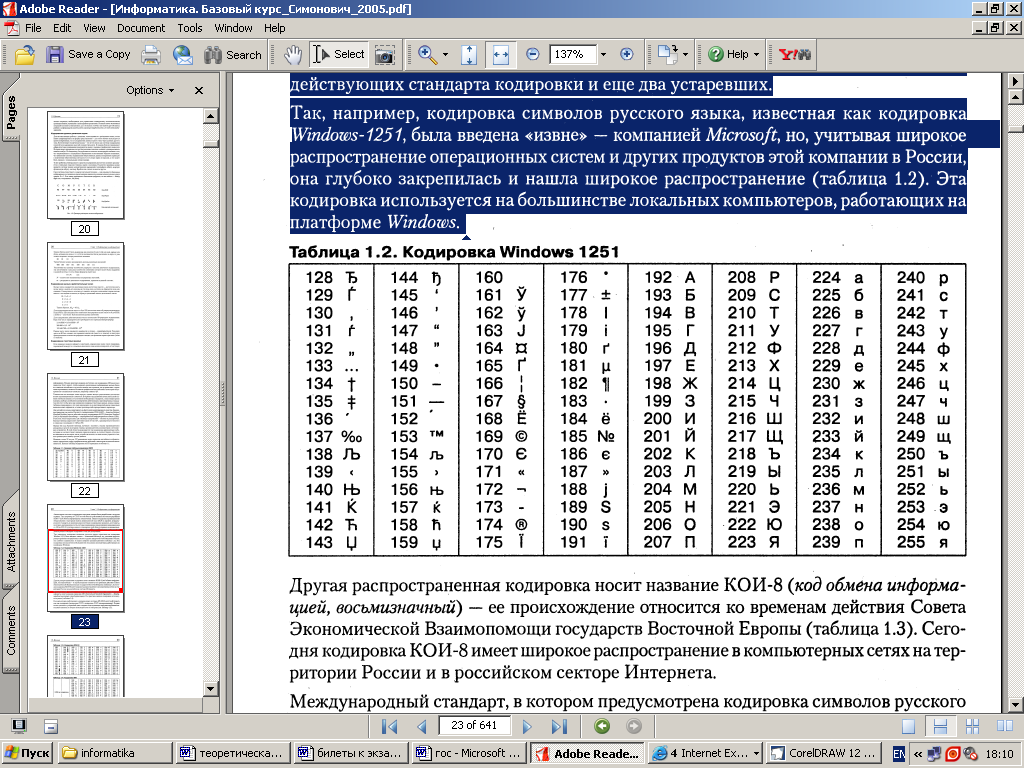

Национальным системам кодирования отводится вторая, расширенная часть системы кодирования, определяющая значения кодов со 128 по 255. Отсутствие единого стандарта в этой области привело к множественности одновременно действующих кодировок. Только в России можно указать три действующих стандарта кодировки и еще два устаревших. Так, например, кодировка символов русского языка, известная как кодировка Windows-1251 была введена «извне» — компанией Microsoft, но, учитывая широкое распространение операционных систем и других продуктов этой компании в России, она глубоко закрепилась и нашла широкое распространение. Эта кодировка используется на большинстве локальных компьютеров, работающих на платформе Windows:

Если проанализировать организационные трудности, связанные с созданием единой системы кодирования текстовых данных, то можно прийти к выводу, что они вызваны ограниченным набором кодов (256). В то же время очевидно, что если, например, кодировать символы не восьмиразрядными двоичными числами, а числами с большим количеством разрядов, то и диапазон возможных значений кодов станет намного больше. Такая система, основанная на 16-разрядном кодировании символов, получила название универсальной — UNICODE. 16 разрядов позволяют обеспечить уникальные коды для 65536 различных символов — этого достаточно для размещения в одной таблице символов большинства языков планеты. Переход на данную систему долгое время сдерживался из-за недостаточных ресурсов средств вычислительной техники (в системе кодирования UNICODE все текстовые документы автоматически становятся вдвое длиннее). Во второй половине 90-х годов технические средства достигли необходимого уровня обеспеченности ресурсами, и сегодня мы наблюдаем постепенный перевод документов и программных средств на универсальную систему кодирования.