- •Глава 5. Нейросетевые методы распознавания и аппроксимации

- •5.1 Принципы организации и классификация нейронных сетей

- •5.2 Формальный нейрон. Однослойный персептрон

- •5.3 Многослойный персептрон

- •5.3.1 Модель сети

- •5.3.2 Обучение многослойного персептрона

- •Да: перейти на шаг 11. Нет: Перейти на шаг 13.

- •Да: Окончание поиска: нет продвижения к решению. Перейти на шаг 13.

- •Алгоритмы сопряженных градиентов представляют собой подкласс квадратично сходящихся методов. Для алгоритмов сопряженных градиентов шаг 6 обобщенного градиентного алгоритма имеет вид:

- •5.3.3 Следящий алгоритм обучения мнс

- •5.4 Радиально-базисные нейронные сети

- •5.5 Нейронные сети Хопфилда

- •5.5.1 Модель сети Хопфилда

- •5.5.2 Обучение сети Хопфилда распознаванию образов

- •5.5.3 Эффект разнасыщения

- •5.6 Нейронная сеть Хэмминга

- •5.7 Машина Больцмана

- •5.8 Двунаправленная ассоциативная память

- •5.9 Нейросетевой селектор максимума

- •5.10 Карта признаков самоорганизации Кохонена

- •5.10.2 Интерпретация результатов классификации нс Кохонена

- •Блок кпск-азу может быть рекомендован для использования в системах классификации в случае, когда:

- •5.10.3 Выбор метрики и учет информативности признаков

- •Шаг 3. Произвести обучение блока кпск-азу на всей выборке X

- •5.11 Квантование обучающих векторов

- •5.11.1 Модель сети

- •5.11.2 Алгоритм обучения lvq1

- •5.11.3 Алгоритм обучения lvq2

- •5.11.4 Алгоритм обучения lvq3

- •5.11.5 Алгоритм обучения olvq1

- •5.12 Контрастирование нейронных сетей

- •Алгоритм построения и оптимизации модели объекта.

- •Алгоритм контрастирования многослойной нейронной сети.

5.5.2 Обучение сети Хопфилда распознаванию образов

Одной из задач, решаемых с помощью НС, является задача распознавания образов. Сеть из N нейронов может восстанавливать образы размера N, запомненные в сети, по ключу, т. е. по неполной или неточной информации об этих образах. Это позволяет создавать на основе НС блоки ассоциативной памяти в вычислительных системах. Эталонные образы кодируются словами длины N, состоящими из 1 и -1. Переход нейрона из состояния 1 в -1 (и наоборот) будем считать ступенчатым.

Работу НС, содержащей нейроны, состояние которых определяется действием внешних стимулов, и эффекторы, выходы которых являются реакцией на стимул, можно рассматривать как пофрагментную классификацию действующих стимулов. Множество предсинаптических потенциалов, соответствующее позитивной реакции нейронаxi(t) = 1, cоздает компактную область вокруг вектораwij.

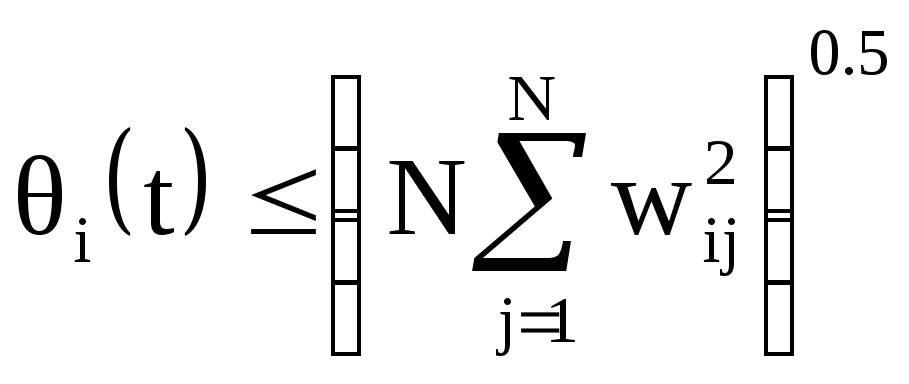

Эта область не пустая лишь при выполнении условия:

.

.

Комбинируя значения весовых коэффициентовwijи порогов θiможно создавать НС, способные к классификации образов без каких-либо ограничений. Нахождение значений величинwij и θi(t), которые обеспечивают необходимые реакции на заданном множестве стимулов, составляет задачу обучения НС.

Ассоциирование (или распознавание) образа достигается сетью путем эволюции из начального состояния, соответствующему введенному образу, в конечное состояние, которым является ассоциация образа с запомненным ранее образом. Основная задача построения сети состоит в наделении ее распознающими свойствами, проявляющимися в том, что при подаче на вход сети возмущенной версии образа, сеть на выходе способна восстанавливать оригинал из шума. То есть, имея М образов-эталонов необходимо найти такую матрицу связейw, которая заставляла бы сеть проявлять распознающие свойства относительно этих эталонов. Нахождение такой матрицы составляет процесс обучения НС, а правило вычисления матрицыwявляется обучающим правилом. Продуктивность НС определяется количеством эталонов М, которые могут быть запомнены и распознаны сетью, состоящей из N нейронов, и тем, насколько хорошо происходит распознавание, то есть отделение эталонов от шума при данном количестве эталонов М.

Заметным шагом на пути к увеличению продуктивности псевдоинверсных НС было предложение Хопфилда рассматривать их с энергетической точки зрения. Процесс распознавания можно представить как "сдвиг" сети в минимумы некоторой энергетической функции Е в пространстве состояний. Предложенное Хопфилдом определение этой функции имеет вид:

E(t) = - 0,5xT(t)(wx(t)-θ(t)),

где x(t) - вектор состояния системы,T– знак транспонирования, θ(t) - внешнее поле, определяющее порог чувствительности,w- оператор, учитывающий расстояние между состояниями системы.

Проекционный алгоритм обучения (псевдоинверсный алгоритм) НС Хопфилда заключается в том, что мы осуществляем проекцию обучающего множества на множество весов НС, что позволяет обучать сеть один раз перед использованием, и не требует выполнения итеративного процесса коррекции весов, как, например, в алгоритмах обучения персептронов.

Пусть имеется М эталонных образовxk, k = 1, ..., М. Положив θi=0, i=1,...,N,можем записать выражение для нахождения весов сети:

![]() .

.

Начиная работу в состоянииx0, сеть может попасть в одно из следующих трех положений:

- прийти в устойчивое состояние, соответствующее эталонному образу, который по хэмминговому расстоянию (по числу компонентов, в которых различаются два вектора) является наиболее близким к x0;

- прийти в устойчивое состояние, не соответствующее никакому эталону, т. е. к ложному образу;

- оказаться вовлеченной в колебательный процесс.

Результаты моделирования сети показывают, что сеть работает хорошо, т. е. без ошибок восстанавливает эталонные образы из случайных, если в нее записывается не более, чем 0,15N эталонных образов.

Для большинства задач возможности одноразового внесения информации в ассоциативную память оказывается недостаточно, т.к. требуется в процессе работы добавлять в память новую информацию - проекционный алгоритм (см. выше) оказывается непригодным. Для решения таких задач используют итеративный проекционный алгоритм обучения.

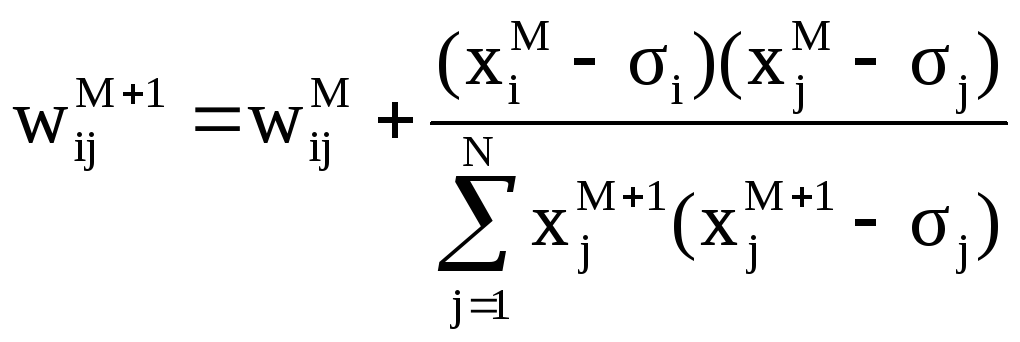

Пусть мы имеем обученную для M наборов значений НС Хопфилда, тогда для внесения в память M+1 набора значений, значения весов можно установить:

, где

, где![]() .

.

Для упрощения вычислительной процедуры предложены и другие правила установки весов, среди которых особо следует выделить:

![]() .

.