|

Тема № 1. Общие сведения о теории информации и кодирования | ||

|

|

Занятие № 2. Структурная схема информационной системы | |

|

|

| |

|

|

Учебные вопросы: | |

|

1 |

Дискретные ансамбли и источники сообщений. |

30 мин. |

|

2 |

Непрерывные ансамбли и источники сообщений |

20 мин. |

|

3 |

Дискретные и непрерывные каналы передачи информации |

20 мин. |

|

4 |

Кодирование информации |

10 мин. |

|

|

|

|

|

|

Литература: | |

|

|

Кудряшов Б.Д. Теория информации: учебник для вузов, с.12-16, 205-206. | |

Введение

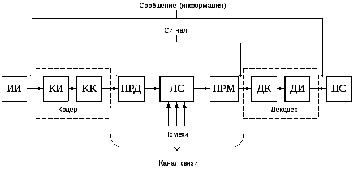

Процесс передачи информации представим посредством модели в виде схемы:

Информация в виде исходного сообщения с выхода источника информации (ИИ) поступает на вход кодера, включающего кодер источника (КИ) и кодера канала (КК). Кодер обеспечивает преобразование сообщения в первичный сигнал- множество элементарных символов.

Далее сигнал поступает на передатчик (модулятор) (ПРД), назначение которого - преобразовать первичные сигналы в сигналы, удобные для передачи по каналу.

Можно сказать, что назначением кодера и модулятора является согласование источника информации с каналом.

Сигналы в канале связи подвергаются воздействию помех. Под помехами будем понимать все те воздействия, которые искажают передаваемые сигналы и приводят к тому, что принятые сигналы отличаются от переданных.

В приемнике информации (ПРМ) принятые из канала сигналы демодулируются- переводятся в первичные сигналы. Далее они преобразуются в копии сообщений с использованием декодера канала (ДК) и декодера источника (ДИ).

Рассмотрим содержание основных элементов данной модели.

1. Дискретные ансамбли и источники сообщений

Первым элементом обобщенной схемы системы передачи (хранения) информации (рис 1) является источник информации.

Источники информации могут принимать множество различных форм. Как правило, первичные сообщения - речь, музыка, изображения, измерения параметров окружающей среды и т.д. - представляют собой функции времени неэлектрической природы. С целью передачи по каналу связи эти сообщения преобразуются в электрический сигнал, изменения которого во времени отображают передаваемое сообщение.

Например, в радиовещании источник выдает звуковой сигнал. В телевизионном вещании выходом источника является, кроме звука, подвижное изображение. Выходы этих источников являются аналоговыми сигналами, и поэтому они называются аналоговыми источниками. В связи с этим представляет интерес информационный анализ непрерывных (аналоговых) сообщений и кодирующих эти сообщения непрерывных сигналов.

В противоположность этому компьютеры и устройства хранения информации, такие как магнитные или оптические диски, имеют дискретный выход (обычно двоичные или ASCII символы), и поэтому их называют дискретными источниками. В дискретных источниках значительная часть передаваемых сообщений по своей природе не является сигналами - это массивы чисел, текстовые или иные файлы и тому подобное.

Изучение информационных характеристик источников начнем с рассмотрения дискретного источника.

Формально источник дискретных сообщений можно описать набором следующих параметров:

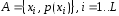

-

алфавит

источника

—

некоторое дискретное множество, т.е.

множество, содержащее конечное или

счетное количество элементов;

—

некоторое дискретное множество, т.е.

множество, содержащее конечное или

счетное количество элементов;

-

—

элементы алфавита (элементарные

сообщения);

—

элементы алфавита (элементарные

сообщения);

-

— мощность множества

— мощность множества (количество

элементов в

(количество

элементов в

).

).

-

распределение

вероятностей

элементов множества

Множество

чисел

,

, ,

задаетраспределение

вероятностей

на дискретном множестве

,

задаетраспределение

вероятностей

на дискретном множестве

,

если все числа

,

если все числа неотрицательны и удовлетворяют условию

нормировки

неотрицательны и удовлетворяют условию

нормировки

Конечное

множество

вместе

с заданным на нем распределением

вероятностей

вместе

с заданным на нем распределением

вероятностей ,

, называетсядискретным

вероятностным ансамблем

или коротко - дискретным

ансамблем

и обозначается символом

называетсядискретным

вероятностным ансамблем

или коротко - дискретным

ансамблем

и обозначается символом

.

.

Иногда

элементы алфавита мы будем снабжать

подстрочными индексами, например

.

Такой индекс представляет собой номер

элемента в алфавите. Тогда описание

дискретного источника может быть

записано в виде

.

Такой индекс представляет собой номер

элемента в алфавите. Тогда описание

дискретного источника может быть

записано в виде ,

где

,

где -

объем алфавита.

-

объем алфавита.

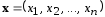

Сообщение,

которое выдает дискретный источник,

представляет собой вектор

произвольной длины

произвольной длины ,

составленный из элементов заданного

алфавита

,

составленный из элементов заданного

алфавита .

.

Если

источник имеет фиксированную скорость,

задается скорость источника

как число символов, генерируемых таким

источником за 1 секунду.

как число символов, генерируемых таким

источником за 1 секунду.

Элементы случайной последовательности, которую выдает источник - вещественные числа, поэтому такие последовательности называются случайными процессами.

Номер

элемента в последовательности

трактуется

как момент времени, в который появилось

данное значение. Вообще говоря, множество

значений времени может быть непрерывным

либо дискретным, множество значений

случайной последовательности также

может быть непрерывным либо дискретным.

Сейчас мы рассматриваем только дискретные

процессы дискретного времени.

трактуется

как момент времени, в который появилось

данное значение. Вообще говоря, множество

значений времени может быть непрерывным

либо дискретным, множество значений

случайной последовательности также

может быть непрерывным либо дискретным.

Сейчас мы рассматриваем только дискретные

процессы дискретного времени.

Проще всего задать случайный процесс, предположив, что его значения в различные моменты времени независимы и одинаково распределены. Источник, выход которого удовлетворяет условиям статистической независимости символов в выбранной последовательности, называется источником без памяти.

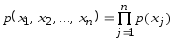

Совместная

вероятность последовательности длины

для

статистически независимого источника

определяется по формуле

для

статистически независимого источника

определяется по формуле

,

,

где

-

вероятность появления

-

вероятность появления в

момент времени

в

момент времени .

.

Для

описания такого процесса достаточно

указать вероятности

для всех

для всех .

.

Для описания более сложных моделей необходимо сделать некоторые упрощения. Обычно предполагают стационарность случайного процесса.

Дискретный

источник называется

стационарным,

если совместные вероятности двух

последовательностей длины

п, допустим

и

и

одинаковые для

одинаковые для и при всех сдвигах

и при всех сдвигах

.

Другими словами, совместные вероятности

для последовательностей источника

произвольной длины инвариантны по

отношению к произвольному сдвигу во

времени.

.

Другими словами, совместные вероятности

для последовательностей источника

произвольной длины инвариантны по

отношению к произвольному сдвигу во

времени.

Числовые характеристики, в частности, математическое ожидание стационарных процессов не зависят времени. Рассматривая стационарные процессы, мы сможем вычислять независящие от времени информационные характеристики случайных процессов.

Источник без памяти, порождающий стационарный процесс, называют дискретным постоянным источником (ДПИ).

При доказательстве основных положений теории информации Шенноном использовалась модель, называемая эргодическим источником сообщений. Предполагается, что создаваемые им сообщения математически можно представить в виде эргодической случайной последовательности. Такая последовательность, как известно, удовлетворяет условиям стационарности и эргодичности. Первое означает, что вероятности отдельных знаков и их сочетаний не зависят от расположения последних по длине сообщения. Из второго следует, что статистические закономерности, полученные при исследовании одного достаточно длинного сообщения с вероятностью, близкой к единице, справедливы для всех сообщений, создаваемых источником. Из статистических характеристик в данном случае нас интересует средняя неопределенность в расчете на один знак последовательности.

Стационарный источник сообщений, выбирающий каждый знак формируемой последовательности независимо от других знаков (т.е. источник без памяти), всегда является эргодическим.

На практике, однако, часто встречаются источники, у которых вероятность выбора одного знака сообщения зависит от того, какие знаки были выбраны источником до этого (источники с памятью). Поскольку такая связь, как правило, распространяется на ограниченное число предыдущих знаков, для описания функционирования источника целесообразно использовать цепи Маркова.

Цепь

Маркова порядка n

характеризует последовательность

событий, вероятности которых зависят

от того, какие n

событий предшествовали данному. Эти n

конкретных событий определяют состояние

источника, в котором он находится при

выдаче очередного знака. При объеме

алфавита знаков

число

число

различных

состояний источника не превышает

различных

состояний источника не превышает .

.