- •Расчетные задания на тестирование

- •Метод перебора.

- •Метод перебора.

- •1. Математическая постановка задачи оптимизации.

- •2. Понятие о численных методах оптимизации. Методы поиска нулевого, первого и второго порядков. Пассивные и активные (последовательные) методы поиска.

- •3. Конечно шаговые и бесконечно шаговые методы поиска. Сходимость методов. Условия останова методов поиска.

- •4. Теорема существования решения оптимизационной задачи.

- •7. Необходимые условия экстремума первого порядка (гладкие функции многих переменных).

- •9.Пассивные методы поиска экстремума.

- •10.Метод перебора.

- •11. Алгоритм оптимального пассивного поиска.

- •12.Теорема об оптимальности пассивного поиска.

- •14. Метод поразрядного поиска.

- •15. Метод дихотомий

- •16. Метод деления отрезка пополам

- •17. Метод золотого сечения

- •20. Метод средней точки

- •26 Метод симплекса.

- •27 Метод циклического покоординатного спуска.

- •29 Градиентные методы

- •30 Градиентный метод с постоянным шагом.

- •31 Градиентный метод с дроблением шага.

- •Метод наискорейшего спуска

- •Методы покоординатного спуска

- •Метод покоординатного спуска с постоянным шагом

- •Метод покоординатного спуска с дроблением шага

- •Метод Гаусса-Зейделя

- •Постановка задач линейного программирования

- •Способы перехода от одной формы задачи лп к другой

- •Базисное решение задачи лп Симплексный метод решения задач линейного программирования

- •Графический метод решения задачи лп

- •Симплекс-метод решения задачи лп

- •Метод искусственных переменных

30 Градиентный метод с постоянным шагом.

Основная проблема в градиентных методах – это выбор шага ak. Достаточно малый шаг ak обеспечивает убывание функции, то есть выполнение неравенства:

f(xk - ak( xk))) < f(xk),

но может привести к неприемлемо большому количеству итераций, необходимых для достижения точки минимума. С другой стороны, слишком большой шаг может вызвать неожиданный рост функции (невыполнение условия убывания) либо привести к колебаниям около точки минимума. Однако проверка условия убывания на каждой итерации является довольно трудоемкой, поэтому в методе градиентного спуска с постоянным шагом задают a=ak постоянным и достаточно малым, чтобы можно было использовать этот шаг на любой итерации. При этом приходится мириться с возможно большим количеством итераций. Утешением является лишь то, что трудоемкость каждой итерации, в этом случае, минимальна (нужно вычислять только градиент ).

31 Градиентный метод с дроблением шага.

В методе градиентного спуска с дроблением шага величина шага aк выбирается так, чтобы было выполнено неравенство:

f(xk-ak)-f(xk)£-dak||||2,

где 0<d<1 – произвольно выбранная постоянная (одна и та же для всех итераций). Это требование на выбор шага aк более жесткое, чем условие убывания, но имеет тот же смысл: функция должна убывать от итерации к итерации. Однако при выполнении неравенства функция будет уменьшаться на гарантированную величину, определяемую правой частью неравенства.

Процесс выбора шага протекает следующим образом. Выбираем число a>0, одно и то же для всех итераций. На к-й итерации проверяем выполнение неравенства при aк=a. Если оно выполнено, полагаем aк=a и переходим к следующей итерации. Если нет, то шаг aк дробим, например уменьшаем каждый раз в два раза, до тех пор, пока оно не выполнится.

____________________Вопрос 32____________________

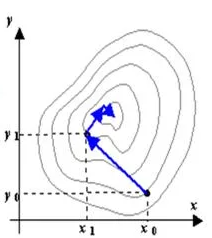

Метод наискорейшего спуска

Суть метода состоит в следующем. Из выбранной точки (x0,y0)спуск осуществляют в направлении антиградиента до тех пор, пока не будет достигнуто минимальное значение целевой функции Q(x, y) вдоль луча (рис. 6.8.4-1). В найденной точке луч касается линии уровня. Затем из этой точки спуск проводится в направлении антиградиента (перпендикулярном линии уровня) до тех пор, пока соответствующий луч не коснется в новой точке проходящей через нее линии уровня, и т.д.

Выразим целевую функцию Q(x, y)через шагl. При этом представим целевую функцию на определенном шаге как функцию одной переменной, т.е. величины шага

![]()

Величина

шага на каждой итерации определяется

из условия минимума функции

![]() :

:

![]() =

min(

=

min(![]() (l))

lk

= l*(x

k,

y

k),

l >0.

(l))

lk

= l*(x

k,

y

k),

l >0.

Метод работает аналогично методу градиентного спуска с постоянным шагом с поправкой на то, что шаг постоянно рассчитывается по вышеуказанной формуле. В этом методе функция минимизируется по направлению, в котором она убывает быстрее всего.

____________________Вопрос 33____________________

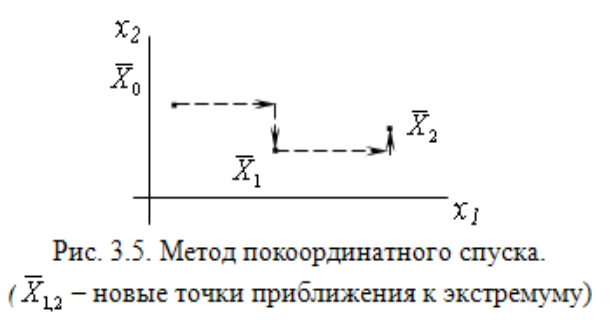

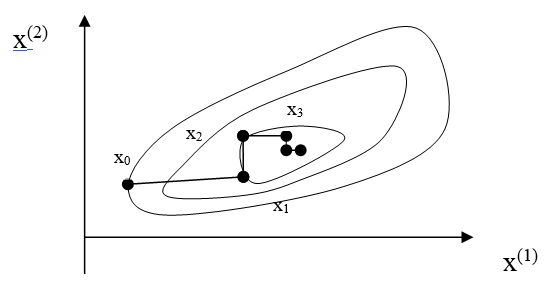

Методы покоординатного спуска

Сущность метода.

Поиск экстремума ведется в направлении осей координат, т.е. в процессе поиска изменяется только одна координата. Таким образом, многомерная задача сводится к одномерной.

Алгоритм метода.

Первый цикл:

1 шаг. x1 = var, х2 = х20, х3 = х30, хn = хn0.

Ищем экстремум функции f(х1). Положим, экстремум функции в точке х11.

2 шаг. x1 = х11, x2 = var, х3 = х30, хn = хn0.

Экстремум f(х2) равен х21.

n шаг. x1 = х11, x2 = х21, x3 = х31,xn = var.

В

результате выполнения n

шагов найдена новая точка приближения

к экстремуму

![]() .

.

Далее проверяем критерий окончания счета:

если

![]() – решение

найдено, в противном случае выполняем

еще один цикл.

– решение

найдено, в противном случае выполняем

еще один цикл.

____________________Вопрос 34____________________