- •Министерство образования и науки, молодёжи и спорта украины

- •Тема 1. Предмет теории информации и количественная мера информации

- •1.2 Этапы обращения информации

- •1.3 Система передачи информации

- •1.4 Задачи и постулаты прикладной теории информации

- •1.5. Количественная оценка информации дискретного источника. Энтропия.

- •1.6 Фундаментальные свойства энтропии

- •Тема 2. Основные виды энтропии дискретных источников. Условная и взаимная энтропии.

- •2.1 Условная энтропия.

- •2.2 Основные свойства условной энтропии.

- •2.3 Взаимная энтропия. Свойства энтропии объединения.

- •Тема 3. Эффективное кодирование источника дискретных сообщений в канале без помех.

- •3.1 Избыточность информации, причины ее появления.

- •3.2 Способы сокращения избыточности.

- •3.3 Теорема Шеннона для канала без помех.

- •4.1 Общие понятия и элементы теории кодирования

- •4.2 Цели кодирования

- •4.3 Оптимальные неравномерные коды

- •4.4 Коды Шеннона-Фэно

- •4.5 Коды Хаффмена

- •4.6 Особенности эффективных кодов.

- •Тема 4. Кодирование источника дискретных сообщений в канале с помехами. Общие принципы помехоустойчивого кодирования.

- •5.1 Кодирование информации для канала с помехами. Теорема Шеннона для канала с помехами.

- •5.2 Общие принципы использования избыточности

- •5.3 Связь корректирующей способности кода с кодовым расстоянием

- •6.1 Корректирующие свойства кодов с избыточностью.

- •6.2 Классификация корректирующих кодов

- •Тема 5. Регулярные методы построения двоичных помехоустойчивых кодов

- •7.1 Линейные коды. Общие медоды построения.

- •7.2 Определение числа добавочных разрядов r.

- •7.3 Построение образующей(порождающей) матрицы |om|.

- •7.4 Порядок кодирования

- •7.5 Порядок декодирования

- •7.6 Систематические коды. Код Хэмминга.

- •7.7 Обнаружение и исправление ошибок в коде Хэмминга

- •8.1 Двоичные циклические коды

- •8.2 Некоторые свойства циклических кодов

- •8.3 Матричное описание циклических кодов

- •8.4 Выбор образующего полинома

- •8.5 Декодирование циклических кодов

- •Тема 6. Построение кодов заданой помехоустойчивости. Применение недвоичных помехоустойчивых кодов.

- •9.1 Матричное описание циклических кодов.

- •9.2 Коды Боуза — Чоудхури — Хоквингема (бчх)

- •9.3 Систематический вид циклического кода.

- •9.4 Коды Рида–Соломона и их применение.

- •9.5 Циклический избыточный код crc

- •Тема 7. Информационные характеристики источников непрерывных сообщений. Источники с максимальной энтропией. Максимальная пропускающая способность канала связи с помехами.

- •10.1 Информационные характеристики источников непрерывных сообщений

- •10.2 Энтропия равномерного закона распределения

- •10.3 Энтропия гауссового закона распределения.

- •11.1 Пропускная способность канала связи с помехами для непрерывных сообщений

- •Тема 8. Методы кодирования информации со сжатием.

- •12.1 Подстановочные или словарно-ориентированные алгоритмы сжатия информации. Методы Лемпела-Зива.

- •13.1 Описание алгоритма сжатия lzw

- •Декодирование по lzw

- •Достоинства и недостатки lzw

- •13.2 Применение lz-алгоритмов упаковки данных

- •14.1 Кодирование длин повторений

- •14.2 Дифференциальное кодирование

- •Тема 9. Методы кодирования со сжатием и с потерями информации..

- •15.1 Методы сжатия с потерей информации

- •15.2 Точность. Помехи и искажения. Приближенное восстановление

- •15.5 Кодирование преобразований. Стандарт сжатия jpeg

- •Или же, в матричной форме,

- •Тема 10. Методы кодирования физических сигналов в компьютерных сетях.

- •16.1 Кодирование на физическом уровне.

- •16.2 Самонихронизирующиеся коды - коды rz и Манчестер-II

- •16.3 Несамосинхронизирующиеся коды. - код nrz

- •16.4 Высокоскоростные коды - код mlt-3 и pam 5

- •Еще более высокоскоростной код - код pam 5

- •16.5 Требуемая полоса частот для передачи данных и ширина спектра сигнала

- •Ширина спектра сигнала

2.2 Основные свойства условной энтропии.

Свойство 1. Если ансамбли сообщений А и В взаимонезависимы, то условная энтропия А относительно В равна безусловной этропии А, и наоборот условная энтропия В относительно А равна безусловной этропии В

![]()

Доказательство. Если сообщения А и В взаимонезависимы, то условные вероятности отдельных символов равны безусловным:

![]()

Так как р (аi)* р (bj/ai) = p (ai, bj), то выражение для H(B/A) представим в виде:

![]()

подставив в полученное выражение ,

![]()

получим

![]()

так как

![]()

Свойство 2: Если ансамбли сообщений А и В настолько жестко статистически связаны, что появление одного из них непременно подразумевает появление другого, то их условные энтропии равны нулю:

![]()

Доказательство. Воспользуемся свойствами вероятностей, согласно которым при полной статистической зависимости р(bj/ai) = 1, слагаемые р (bj/ai)*log(р (bj/ai) в выражении для энтропии также равны нулю. Если нулю равны отдельные слагаемые, то и сумма равна нулю, откуда

![]()

Выводы:

1. Энтропия сообщения, составленного с учетом неравновероятности символов меньше, чем энтропия сообщения, составленного из равновероятных символов.

2. Энтропия сообщения, составленного с учетом взаимозависимости символов, меньше, чем энтропия того же сообщения, составленного из независимых символов.

3. Максимальную энтропию имеют сообщения, составленные из равновероятных и независимых символов, т. е. те, у которых условная энтропия равна нулю, а вероятность появления символов алфавита pi=1/N.

2.3 Взаимная энтропия. Свойства энтропии объединения.

Энтропия объединения или взаимная энтропия используется для вычисления энтропии совместного появления статистически зависимых сообщений либо энтропии взаимосвязанных систем.

Например, при передаче по каналу связи с шумами цифры 5, из 100 раз цифра 5 была принята 90 раз, цифра 6 — восемь раз, цифра 4 — два раза. Неопределенность возникновения комбинаций вида 5—4; 5—5; 5—6 при передаче цифры 5 может быть описана при помощи энтропии объединения Н (А, В).

Понимание энтропии объединения (иногда употребляют термин «взаимная энтропия») облегчается, если расуждения сводятся к некоторому условному каналу связи. На примере передачи информации по каналу связи также удобнее проследить взаимосвязь понятий условной энтропии Н (В/А) и взаимной энтропии H(А, В).

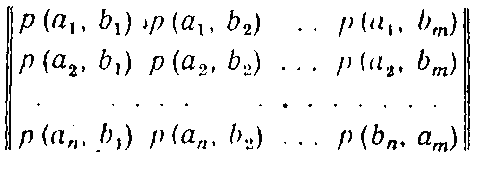

Итак, пусть (а1, а2, ..., аi .... аn) есть выборочное пространство А, или символы характеризующее источник сообщений, a (b1, b2, …, bj,…,bm) выборочное пространство В, или символы, характеризующее приемник сообщений. При этом а есть сигнал на входе шумящего капала, а b - сигнал на его выходе. Взаимосвязь переданных и принятых сигналов описывается вероятностями совместных событий вида p(a,b), а взаимосвязь выборочных пространств А и В описывается матрицей вида:

Если матрица описывает канал связи, то число строк матрицы равно числу столбцов m=n и пределы суммирования по i и по j одинаковы. При описании взаимодействия систем равенство m=n необязательно.

Независимо от равенства или неравенства числа строк числу столбцов матрица объединения обладает свойством:

В свою очередь,

![]()

т. е.

![]()

Это свойство позволяет вычислять энтропию источника и приемника сообщений непосредственно по матрице объединения :

До знака логарифма суммирование производится по i и j, так как для нахождения безусловных вероятностей необходимо производить суммирование по одной координате (имеется в виду матричное представление вероятностей), а для нахождения соответствующей энтропии суммирование производится по другой координате.

Условные вероятности 'при помощи матрицы объединения находятся следующим образом:

Э нтропия

объединения ансамблей А и В при помощи

матрицы объединения вычисляется путем

последовательного суммирования по

строкам илиgо

столбцам всех вероятностей вида р(а,

b),

умноженных на логарифм этих же вероятностей

нтропия

объединения ансамблей А и В при помощи

матрицы объединения вычисляется путем

последовательного суммирования по

строкам илиgо

столбцам всех вероятностей вида р(а,

b),

умноженных на логарифм этих же вероятностей

Размерность этой энтропии - «бит/два символа»

Размерность «бит/два символа» объясняется тем, что взаимная энтропии представляет собой неопределенность возникновения пары символов, т.е. неопределенность на два символа. В случае отсутствия зависимости между символами выражение для H(A,B) принимает вид выражения H(A) или H(B) , и соответсвенно размерность будет «бит/символ».

Исследуем выражение для взаимной энтропии

Из теории вероятностей известно, что (смотрим на основные соотношения в начале лекции)

![]()

Используя это свойство, выражение для взаимной энтропии можно записать как

Но

![]()

и ,

![]()

тогда первое слагаемое выражение принимает вид

![]()

Второе слагаемое, есть не что иное, как H(В/А), что позволяет выражение записать в виде

![]()

Энтропия объединения передаваемого ансамбля А и принимаемого ансамбля В равна сумме безусловной энтропии H(A) и условной энтропии Н (В/А).

Последняя в данном случае представляет ту добавочную информацию, которую дает сообщение В после того, как стала известна информация, содержащаяся в сообщении А. Таким образом, условная энтропия представляет собой неопределенность того, что при приеме b было послано а, а взаимная энтропия отражает неопределенность возникновения пары вида ab.

Энтропия объединения обладает свойством симметрии.

H(A,B)=H(B,A)

Свойство симметрии энтропии объединения хорошо иллюстрируется матрицей, изображенной на рисунке.

Действительно, если просуммировать все элементы матрицы объединения по строкам и но столбцам по схеме рисунка а затем сложить полученные результаты, то обе суммы будут равны единице. Свойство симметрии позволяет записать соотношения между условной энтропией и энтропией объединения следующим образом:

Если построена матрица вероятностей р(a,b), описывающая взаимосвязь двух произвольных выборочных пространств, в частности взаимосвязь входа и выхода шумящего канала связи, то остальные информационные характеристики могут не задаваться, так как матрица взаимной энтропии обладает информационной полнотой.

Взаимная информация между асамблем сообшений источника А и приемника В выражается формулами

При отсутствии статистической зависимости между элементами ансамблей А и В условные вероятности превращаются в безусловные

![]()

В этом случае

![]()

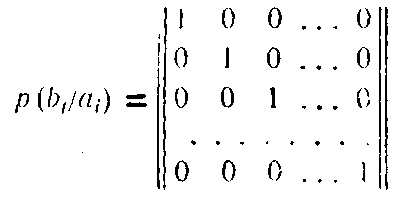

При полной статистической зависимости между элементами ансамблей А и В (например, когда результат одного события однозначно определяет информацию о другом событии)

Н(В/А) = Н (А/В) = 0,

а взаимная энтропия

![]()

В случае передачи информации по каналам связи полная статистическая зависимость между передаваемыми и принимаемыми сигналами говорит об отсутствии помех, канальная матрица приобретает вид

условные вероятности правильного приема равны единице, остальные - нулю, что превращает в нуль все частные условные энтропии.

![]()

аналогично

![]()

и, следовательно, и общая условная энтропия превращается в нуль и выражение для Н(А,В) приобретает вид

![]()

Выводы:

1. Энтропия объединенной системы А, В равна безусловной энтропии одной из них плюс условная энтропия второй относительно первой.

2. Матрица «объединения», описывающая взаимодействие систем или ансамблей сообщений при помощи вероятностей совместных событии, обладает свойством информационной полноты ( а сумма ее элементов равна 1).

3. Взаимная энтропия ансамблей произвольных выборочных пространств обладает свойством взаимной симметрии.

4. В случае статистической независимости элементов ансамблей взаимная энтропия любого количества ансамблей ровна сумме их безусловных энтропий.

5. При полной статистической зависимости ансамбля источника сообщений и ансамбля приемника сообщений их взаимная энтропия равна безусловной энтропии источника сообщений.