MonografiaOxana_tanya

.pdf

|

|

Таблиця 5.4 |

|

Комплекс заходів, що спрямовані на усунення деяких видів |

|||

|

фінансових погроз |

||

|

|

|

|

Клас |

|

|

|

фінансових |

Вид загрози |

Можливі фінансові заходи |

|

погроз |

|

|

|

|

|

|

|

|

|

стимулювання передоплати |

|

|

наявність і зростання |

зниження термінів надання комерційного |

|

|

простроченої дебіторської |

кредиту |

|

|

збільшення періоду кредиту, що надається |

||

|

заборгованості |

||

|

постачальниками |

||

|

зростання рівня |

||

|

прискорення інкасації дебіторської |

||

Низький |

незавершеного |

||

заборгованості |

|||

рівень |

виробництва |

||

зниження розміру страхових товарно- |

|||

ліквідності |

наявність прострочених |

||

матеріальних запасів |

|||

|

|

||

|

банківських кредитів |

реалізація високоліквідної частини |

|

|

наявність простроченої |

довгострокових фінансових вкладень |

|

|

кредиторської |

проведення операцій фінансового лізингу |

|

|

заборгованості |

оренда устаткування, що раніше |

|

|

|

намічається до придбання |

|

|

|

пролонгація кредитів |

|

|

|

|

|

|

|

податкова реструктуризація |

|

|

|

оптимізація цінової політики |

|

|

|

зниження рівня постійних витрат |

|

|

дефіцит інвестиційних |

зниження рівня змінних витрат |

|

Низький |

реструктуризація засновницьких відносин |

||

ресурсів |

|||

рівень |

скорочення об'ємів інвестиційної |

||

наявність прострочених |

|||

прибутковості |

діяльності |

||

банківських кредитів |

|||

|

зміна дивідендної політики |

||

|

|

||

|

|

скорочення програм участі найнятих |

|

|

|

робітників у прибутку |

|

|

|

скорочення об'єму соціальних, |

|

|

|

екологічних й інших зовнішніх програм |

|

|

|

|

|

|

|

прискорення інкасації дебіторської |

|

|

|

заборгованості |

|

|

|

зниження термінів надання товарного |

|

|

недостатність оборотних |

кредиту |

|

|

коштів |

зниження ціни складноліквідних запасів |

|

Низька |

залучення |

товарно-матеріальних цінностей до рівня |

|

«непривабливих» |

ціни попиту із забезпеченням подальшій їх |

||

динамічність |

|||

кредитних ресурсів |

реалізації |

||

|

|||

|

зниження автономності |

зниження страхових запасів товарно- |

|

|

підприємства |

матеріальних цінностей |

|

|

|

реструктуризація портфеля |

|

|

|

короткострокових фінансових кредитів з |

|

|

|

перекладом частини з них у довгострокові |

|

|

|

|

|

151

6 ВИКОРИСТАННЯ НЕЙРОМЕРЕЖЕВИХ ТЕХНОЛОГІЙ

УФІНАНСОВОМУ АНАЛІЗІ

6.1Нейромережева класифікація типів криз, що впливають на рівень фінансового стану підприємства

Раніше розглянуті моделі дозволяють надати кількісну та якісну оцінку фінансовому стану. Але для формування повної картини стану підприємства не достатньо його тільки оцінити. Є необхідність у передбаченні майбутньої фінансової ситуації.

Реалізація фінансового плану також багато в чому залежить від класу, виду й інтенсивності дії перешкод, які можуть змінюватися. Це вимагає застосування при аналізі та оцінці руху фінансових потоків моделей, які гнучко адаптуються до особливостей нових даних. Такі моделі можна отримати у рамках нейромережевого підходу.

Нейронна мережа – це сукупність нейронів, що певним чином пов'язані між собою і функціонують за заданими правилами [47, 66, 83].

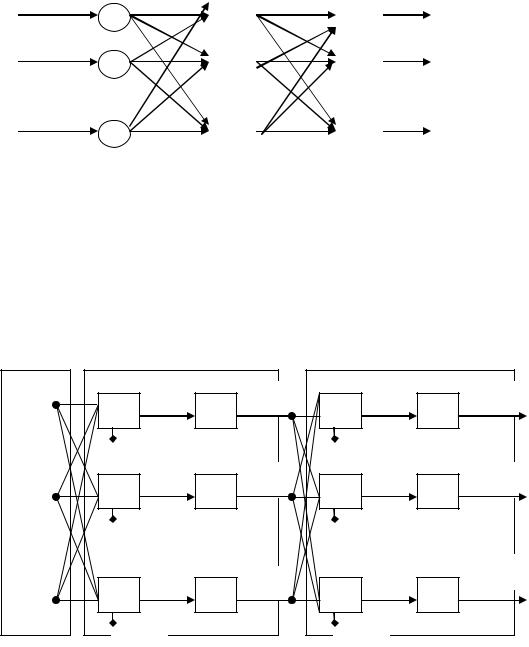

Структура штучного нейрона зображена на рисунку 6.1 і включає такі елементи: входи, синапси, суматор, нелінійний перетворювач, вихід.

Входи на схемі позначені символами x1, x2, …, xn; вагові коефіцієнти, які визначають дію синапсів представлені відповідно набором (w1, w2, …, wn);

символом S позначений суматор; b – величина зрушення, яка визначає поріг або рівень збудження нейрона; s – результат суми зважених вхідних сигналів і величини зрушення, яка визначає стан нейрона; f(s) – нелінійний перетворювач, який реалізує нелінійну функцію від аргументу s; у – значення початкового сигналу, яке залежить від дії нелінійного перетворювача.

Математична модель нейрона, що відповідає вказаній схемі (рис.

6.1), має вигляд:

152

swi xi b,

i 1n

y f (s) .

Модель нейрона реалізує скалярну функцію векторного аргументу. У

загальному випадку вхідний сигнал, вагові коефіцієнти і значення зрушення можуть набувати різних числових значень. Вихід (y)

визначається типом функції активації, які можуть бути граничними,

сигнатурними, сигмоїдальними, напівлінійними, лінійними, радіальними базисними, трикутними та інше [47, 66, 83].

w1 w2 … wn

x1 |

|

|

|

s |

|

x2 |

|

y |

f(s) |

||

xn |

|

|

b

Рис. 6.1. Структурна схема штучного нейрона

Математична модель нейрона повністю описується ваговими коефіцієнтами wi і передавальною функцією f(s). Для кожного вектора вхідних сигналів ставиться відповідне числове значення у. Сукупність нейронів утворює нейронну мережу, а кількість нейронів і характер зв'язків між ними обумовлюють топологію мережі. Нейронні мережі розрізняються за характером зв'язків між нейронами, особливостями моделі функціонування нейрона, особливостям навчання мережі [66, 83].

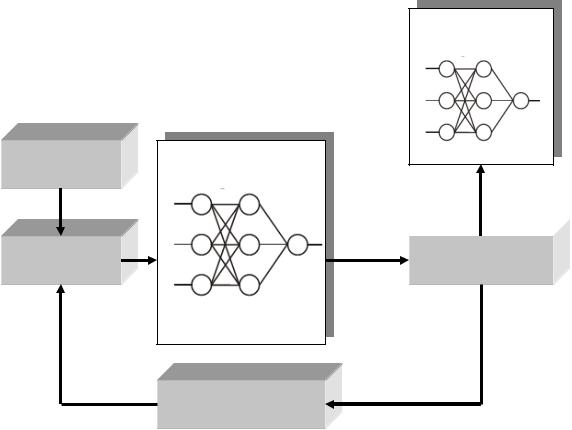

Для вирішення завдань прогнозування і класифікації використовуються багаторівневі нейронні мережі. Приклад організації багаторівневої нейронної мережі наведений на рисунку 6.2. Ця нейронна

153

мережа містить такі шари: вхідний, проміжний (латентний), вихідний. Така нейронна мережа відноситься до класу персептронів.

Вхідний шар |

Латентний шар |

Вихідний шар |

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

ю |

|

|

|

|

ю ... |

ю ... |

|||

|

|

|

|

|

|

|

|

|

|

Рис. 6.2. Трирівнева нейронна мережа

Відповідна математична модель такого персептрона наведена на рисунку 6. 3, де визначені вхідні сигнали першого рівня, суматори,

величини зрушень, змінні стани нейронів, функції активації латентного і вихідного шару, вихідні сигнали.

x1 |

|

s11 |

y11 |

|

|

f1 |

|

|

|

b11 |

|

|

|

s21 |

y21 |

x2 |

|

f1 |

|

|

|

b21 |

|

|

|

sn1 |

yn1 |

xn |

|

f1 |

|

|

|

|

|

|

|

bn1 |

|

|

s12 |

y12 |

|

|

f2 |

||

|

b12 |

|

|

|

s22 |

y22 |

|

|

f2 |

||

|

b22 |

|

|

|

sn2 |

yn2 |

|

|

f2 |

||

|

|||

|

bn2 |

|

Рис. 6. 3 Структура математичної моделі трирівневого персептрона

Окрім багаторівневих нейронних мереж зазначають такі, як лінійні мережі, мережі, в яких застосовуються радіальні базисні функції, мережі Кохонена, імовірнісні нейронні мережі, узагальнені регресійні нейронні мережі, мережі Хопфілда, мережі Хеммінга та інші [47, 83]. Вони

154

відрізняються архітектурою, концепцією і принципами функціонування,

але основні компоненти нейронних мереж однакові.

Розглянемо основні принципи роботи цих мереж.

Лінійна мережа є найпростішим видом нейромережевих моделей.

Лінійна мережа представлена тільки вхідними і вихідним нейронами, не містить проміжних шарів. При побудові лінійної мережі використовується гіперплощина, яка в завданнях регресії повинна проходити через задані точки, а в завданнях класифікації ця гіперплощина є лінійною дискримінантною функцією.

Мережа радіальних базисних функцій (RBF) містить прихований шар нейронів з радіально симетричною активаційною функцією, кожний з яких призначений для зберігання окремого еталонного вектора (у вигляді вектора ваг). Для побудови цієї мережі необхідне виконання наступних умов: наявність еталонів, поданих у вигляді вагових векторів нейронів прихованого шару; наявність способу вимірювання відстані вхідного вектора від еталону; наявність спеціальної функції активації, що задає вибраний спосіб вимірювання відстані.

Мережі Кохонена відносяться до мереж стрічного розповсюдження,

нейронів, що складаються з вхідного шару і шарів нейронів Кохонена і Гросберга. Часто для вирішення складних завдань розпізнавання і кластеризації ця мережа за своїми характеристиками істотно перевершує мережі з одним прихованим рівнем. У мережах Кохонена відбувається некероване навчання (без вчителя): мережа вчиться розпізнавати кластери серед нерозмічених повчальних даних, що містять тільки вхідні значення.

Крім того, мережа Кохонена розташовує споріднені кластери поблизу один від одного у вихідному шарі, формуючи топологічну карту.

Імовірнісні нейронні мережі (PNN) – вид нейронних мереж для завдань класифікації, де щільність вірогідності приналежності до класів оцінюється за допомогою ядерної апроксимації. У методі ядерних оцінок в точці, відповідній кожному спостереженню, розміщується деяка проста

155

функція, потім всі вони складаються, і в результаті виходить оцінка для загальної щільності вірогідності. Як правило, як ядерні функції беруться гаусові функції. Якщо повчальних прикладів достатня кількість, то такий метод дає добре наближення до дійсної щільності вірогідності.

Узагальнені регресійні мережі (GRNN) використовуються для вирішення завдань регресії, і в них також використовується ядерна апроксимація.

Нейронні мережі Хопфілда і Хеммінга відносяться до класу оптимізуючих нейронних мереж. Нейронна мережа Хопфілда працює за принципом асоціативної пам'яті та дозволяє визначити номер еталону,

найближчий до пред'явленого вхідного вектора.

Вибір структури штучної нейронної мережі здійснюється відповідно до особливостей і складності завдань. Порівняльний аналіз переваг і недоліків окремих нейроних мереж наведений у таблиці 6.1.

Таблиця 6.1

Порівняльний аналіз переваг та недоліків окремих нейронних мереж

Тип мережі |

Переваги |

Недоліки |

|

Багаторівневий |

Невеликі, швидко |

Повільно навчаються |

|

персептрон (MLP) |

працюють |

||

|

|||

|

|

|

|

Радіальні базисні |

Швидко вчаться |

Невеликі за розмірами, не можуть |

|

функції (RBF) |

вирішувати задачі екстраполяції |

||

|

|||

Лінійні |

Прості, швидко вчаться |

Не можуть вирішувати нелінійні |

|

задачі |

|||

|

|

||

|

Швидко вчаться, мають |

Дуже великі, повільно працюють, не |

|

Байєсові (вірогіднісні) |

можуть вирішувати задачі |

||

хорошу теоретичну базу |

|||

|

екстраполяції |

||

|

|

Процес побудови нейронної мережі включає такі етапи:

1Вибір типу мережі для вирішення поставленого завдання.

2Навчання нейронної мережі, тобто визначення чисельних значень ваг (численных значений весов) кожного з нейронів на підставі експертної або ретроспективної інформації.

3Перевірка нейронної мережі, яка пройшла навчання, на даних контрольного прикладу.

156

4 |

Використання мережі, яка успішно пройшла навчання і |

тестування, для вирішення завдання.

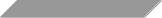

Процес навчання нейронної мережі відображено на рисунку 6.4.

База даних

Вибір прикладу

Мережа

навчена

Застосування

нейроної мережі Мала

помилка

Розрахунок

Розрахунок помилки

помилки

Велика

помилка

Настроювання ваг нейронної мережі

Рис. 6.4. Процес навчання нейроної мережі

Оскільки для проектованої нейронної мережі невідомі значення параметрів, тобто значення вагових коефіцієнтів і величини зрушення, то слід їх визначити так, щоб прогнозні значення вихідних показників не істотно відрізнялися від дійсних. У нейронних мережах застосовуються спеціальні алгоритми навчання, які дозволяють настроїти параметри моделі, перш за все – ваги, відповідним чином. Існує декілька способів навчання нейронних мереж: з вчителем; без вчителя; змішана, які засновані на деяких правилах навчання, таких, як корекція за величиною помилки, правило Больцмана, правило Хебба, метод змагання. Для навчання різних нейронних мереж застосовується ряд алгоритмів, таких, як

157

метод зворотного розповсюдження погрішності, лінійний дискримінантний аналіз, алгоритм Больцмана, векторне квантування та інші [47]. У таблиці 6.2 подані найпоширеніші алгоритми навчання мережі.

|

|

|

|

|

|

Таблиця 6.2 |

|

|

Відомі алгоритми навчання нейронних мереж |

|

|||||

|

|

|

|

|

|

|

|

Парадигма |

Навчаюче |

Архітектура |

|

Алгоритм навчання |

Задачі |

|

|

правило |

нейронної мережі |

|

|||||

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Класифікація |

|

|

|

Одношаровий |

та |

Алгоритми |

навчання |

образів |

|

|

Корекція |

персептрона |

Апроксимація |

||||

З вчителем |

багатошаровий |

|

|||||

помилки |

|

Зворотне |

поширення; |

функцій |

|

||

|

персептрон |

|

|

||||

|

|

|

Adaline и Madeline |

Передбачення |

|||

|

|

|

|

||||

|

|

|

|

|

|

керування |

|

|

|

|

|

|

|

|

|

|

Больцман |

Рекурентна |

|

Алгоритм |

навчання |

Класифікація |

|

|

|

Больцмана |

|

образів |

|

||

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

Багатошарова |

|

Лінійній |

|

Аналіз |

даних; |

|

Хебб |

прямого |

|

|

класифікація |

|

|

|

|

дискримінантний аналіз |

|

||||

|

|

поширення |

|

образів |

|

||

|

|

|

|

|

|

Категоризація |

|

|

Змагання |

Змагання |

|

Векторне квантування |

всередині |

класу; |

|

|

|

|

|

|

|

стиснення даних |

|

|

|

Мережа ART |

|

ART Map |

|

Класифікація |

|

|

|

|

|

образів |

|

||

|

|

|

|

|

|

|

|

|

Корекція |

Багатошарова |

|

|

|

Категоризація |

|

Без вчителя |

прямого |

|

Проекція Самона |

всередині |

класу; |

||

помилки |

|

||||||

|

поширення |

|

|

|

аналіз даних |

|

|

|

|

|

|

|

|

||

|

|

Прямого |

|

Метод |

головних |

Аналіз |

даних: |

|

Хебб |

поширення |

або |

||||

|

компонентів |

стиснення даних |

|||||

|

|

змагання |

|

||||

|

|

|

|

|

|

|

|

|

|

Мережа Хопфілда |

Навчання |

асоціативної |

Асоціативна |

|

|

|

|

пам'яті |

|

пам'ять |

|

||

|

|

|

|

|

|

||

|

Змагання |

Змагання |

|

Векторне квантування |

Категоризація: |

||

|

|

стиснення даних |

|||||

|

|

|

|

|

|

||

|

|

SOM Кохонена |

|

SOM Кохонена |

Категоризація: |

||

|

|

|

аналіз даних |

|

|||

|

|

|

|

|

|

|

|

|

|

Сети ART |

|

ART1, ART2 |

Категоризація |

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Класифікація |

|

|

Корекція |

|

|

|

|

образів |

|

|

|

|

Алгоритм |

навчання |

Апроксимація |

||

Змішана |

помилки та |

Мережа RBFN |

|

||||

|

RBFN |

|

функцій |

|

|||

|

змагання |

|

|

|

|

||

|

|

|

|

|

Передбачення |

||

|

|

|

|

|

|

||

|

|

|

|

|

|

керування |

|

158

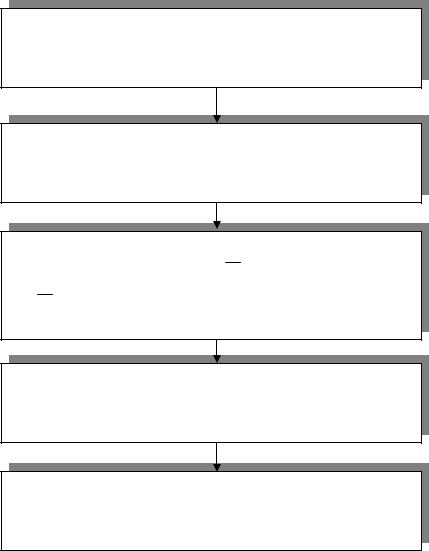

Найчастіше використовується для навчання багаторівневого

персептрона метод зворотного розповсюдження помилки, який діє на основі принципу навчання з вчителем і використовує алгоритм градієнтного спуску для мінімізації квадратичної помилки (рис. 6.5). При проведенні навчання нейронної мережі дуже важливо звертати увагу на загрозу перенавчання, яка виявляється у тому, що величина контрольної помилки починає зростати. Тобто, на безлічі даних, за допомогою яких йде навчання нейронної мережі, величина погрішності допустима і достатньо низька, а на нових, контрольних даних, модель працює погано.

Оскільки при моделюванні складних процесів можливе використання різних типів нейронних мереж, то після проведення їх навчання і тестування, слід визначити якнайкращу серед моделей.

Найбільш інформативною і важливою статистикою для вибору моделі при рішенні задач прогнозування на основі нейронних мереж є величина (S.D. ratio), яка визначається як відношення стандартного відхилення помилки прогнозу до стандартного відхилення вихідних даних. Чим ближче до 0

значення цієї величини, тим краще якість моделі, побудованої на основі нейронної мережі. Величина, яка дорівнює різниці між одиницею і розміром S.D. ratio, – частка поясненої дисперсії вихідних показників.

При рішенні задач класифікації використовуються статистики, що визначають, скільки спостережень кожного класу було класифіковано правильно, скільки неправильно, скільки взагалі не класифіковано.

Використовується також функція Perfomance, що визначає частку правильно класифікованих випадків.

Таким чином, враховуючи наведені вище правила щодо вибору типа і архітектури нейронної мережі, алгоритмів її навчання, можна вибрати найбільш якісні для прогнозування і класифікації моделі, що будуть використані для оцінки фінансового стану підприємства і визначення типу кризи під впливом різних перешкод.

159

Задати синапатичну матрицю випадкових чисел

Відправити на вхід прихованого шару набір навчаючих даних( X C )

Розрахувати вхід схованого шару:

Y C F ( X C )

де X C – зважений вхід схованого шару; F – сигмоїдальна функція

Розрахувати помилки для вхідного та схованого шарів

Помилки допустимі

Рис. 6.5. Алгоритм навчання нейроної мережі зворотного поширення

Слід також відмітити, що процедура побудови нейронної мережі досить складна і вимагає значних розрахунків, проведення чисельних обчислювальних експериментів. Тому побудова і аналіз моделей нейронних мереж здійснюється за допомогою сучасних пакетів програм,

що реалізовують відповідні технології. Це такі програмні продукти, як

NeuroSolutions (NeuroDimension Inc.), NeuroShell (Ward Systems Groupe), Statistica Neural Networks (StatSoft Inc.) та інші [18, 47, 83].

За допомогою пакету Statistica Neural Networks (StatSoft Inc.) [18, 83],

який об'єднує у собі зручний інтерфейс і широкі можливості вибору різних типів нейронних мереж, побудована модель оцінки і аналізу реалізації

160