Chast_1-Osnovy_informatiki

.pdf

1 . Информационные процессы и средства их реализации

H A |

(β) , K, |

H A |

(β) , т. е. значения, равные условной энтропии опыта β при |

|||||||||

|

2 |

|

|

k |

|

|

|

|

|

|

|

|

условии, что опыт α имеет исходы A1 , |

A 2 , |

K, Ak . Это среднее значение ес- |

||||||||||

тественно |

назвать средней условной |

энтропией опыта |

β |

при |

||||||||

условии |

выполнения |

|

опыта α , |

или, короче, условной энтропи- |

||||||||

ей |

β при |

условии |

выполнения |

|

α ; будем обозначать |

его |

через |

|||||

H α (β) : |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

H α (β) = p( A1 )H A |

(β) + p( A2 )H A |

2 |

(β) + K + p( Ak )H A |

(β) . |

|

|

||||

|

|

|

|

|

|

1 |

|

|

k |

|

|

|

Таким образом, окончательно имеем

H (αβ) = H (α) + H α (β) .

Это и есть общее правило для определения энтропии сложного опыта αβ .

Его тоже можно назвать правилом сложения энтропий, аналогично приведенному выше правилу, относящемуся к тому частному случаю, когда опыты α и β независимы. Средняя условная энтропия H α (β) , вычисление которой не предполагает известным исход α , глубоко отражает взаимную зависимость опытов α и β .

Укажем некоторые важнейшие свойства величины H α (β) . Очевидно,

что это есть неотрицательное число. Ясно, что если все вероятности p( A1 ) ,

p( A 2 ) , K, p( A k ) отличны от нуля, т. е. если опыт α имеет действительно k

исходов, |

то |

H α (β) = 0 |

|

|

в том |

и |

только в |

том |

случае, |

если |

||

H A |

(β) = H A |

2 |

(β) = K = H A |

k |

(β) = 0 , т. е. если при любом исходе опыта α ре- |

|||||||

|

1 |

|

|

|

|

|

|

|

|

|

||

зультат опыта β становится полностью определенным. |

При этом мы |

|||||||||||

имеем |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

H (αβ) = H (α) . |

|

|

|

||

Если |

же |

|

опыты α |

и |

β |

являются |

независимыми, |

то |

||||

H A |

(β) = H A |

2 |

(β) = K = H A |

|

(β) = H (β) и |

|

|

|

|

|||

|

1 |

|

|

k |

|

|

|

|

|

|

||

H α (β) = H (β) .

В этом случае формула H (αβ) = H (α) + H α (β) переходит в более простую:

H (αβ) = H (α) + H (β) .

Очень существенно, что во всех случаях условная энтропия H α (β) за-

ключается между нулем и энтропией H (β) опыта β (безусловной): 0 ≤ H α (β) ≤ H (β) .

16

1 . Информационные процессы и средства их реализации

Таким образом, случаи, когда исход опыта β полностью определяется исхо-

дом α и когда опыты α и β независимы, являются в определенном смысле

крайними.

Вернемся снова к величине H (β) , характеризующей степень неопреде-

ленности опыта β . Равенство этой величины нулю означает, что исход опыта

β заранее известен. Какое-либо измерение или наблюдение α , предшест-

вующее опыту β , может ограничить количество возможных исходов опыта β и тем самым уменьшить степень его неопределенности. При этом α можно рассматривать как вспомогательный опыт, также имеющий несколько допустимых исходов. Тот факт, что осуществление α уменьшает степень неопре-

деленности β , находит свое отражение в том, что условная энтропия H α (β)

опыта β при условии выполнения α оказывается меньше (точнее – не боль-

ше) первоначальной энтропии H (β) того же опыта. При этом если опыт β не зависит от α , то осуществление α не уменьшает энтропии β , т. е.

H α (β) = H (β) ; если же результат α полностью предопределяет исход β , то энтропия β уменьшается до нуля: H α (β) = 0 . Таким образом, разность

I (α,β) = H (β) − H α (β)

указывает, насколько осуществление опыта α уменьшает неопределенность

β , т. е. как много нового можно узнать об исходе опыта β , производя изме-

рение (наблюдение) α ; эту разность называют количеством информа-

ции относительно опыта β , содержащимся в опыте α , или,

короче, информацией о β , содержащейся в α . Таким образом, обес-

печивается возможность численного измерения информации. Энтропия есть абстрактная «мера неопределенности»; ценность этого

понятия в значительной мере заключается в том, что оно позволяет оценить влияние на определенный опыт β какого-либо другого опыта α как «раз-

ность энтропий» I (α,β) = H (β) − H α (β) . Так как понятие информации, свя-

занное с определенными изменениями в условиях опыта β , является, так ска-

зать, «более активным», чем понятие энтропии, то для лучшего уяснения смысла энтропии полезно свести это последнее понятие к первому. Энтро-

пию H (β) опыта β можно определить как информацию относительно

β , содержащуюся в самом этом опыте (ибо осуществление самого опыта β , разумеется, полностью определяет его исход и, следовательно,

H β (β) = 0 ), или как наибольшую информацию относительно β ,

17

1 . Информационные процессы и средства их реализации

какую только можно иметь («полную информацию» относительно

β ). Иначе говоря, энтропия H (β) опыта β равна той информации, которую

получим, осуществив этот опыт, т. е. средней информации, содер-

жащейся в одном исходе опыта β .

Заметим, что выражение для энтропии

H (β) = − p(B1 ) log p(B1 ) − p(B2 ) log p(B2 ) − K− p(Bl ) log p(Bl )

имеет вид математического ожидания случайной величины, принимающей значения − log p(B1 ) , − log p(B2 ) , K, − log p(Bl ) с вероятностями, равными соответственно p(B1 ) , p(B2 ) , K, p(Bl ) . В связи с этим можно считать, что при осуществлении определенного исхода Bi нашего опыта полученная ин-

формация, равна − log p(Bi ) . В таком случае, если, например, опыт β имеет всего два возможных исхода B1 и B2 с вероятностями 0, 99 и 0,01, то при осуществлении исхода B1 будет получена очень небольшая информация

− log 0, 99 ≈ 0,017 бит. Это представляется вполне естественным: в самом де-

ле, и до опыта было известно, что почти наверное осуществится исход B1 ,

так что результат опыта мало что изменил в имеющихся сведениях о резуль-

татах опыта β . Наоборот, если осуществляется исход B2 , то полученная ин-

формация будет равна − log 0,01 = 6,6 бит, т. е. будет гораздо больше, чем в первом случае; это естественно, так как сведения, полученные в результате опыта, здесь много более интересны (осуществилось событие, которое было трудно ожидать). Однако получение такого большого количества информации при многократном повторении опыта возможно очень редко; поэтому среднее количество информации, содержащееся в одном исходе, оказывается здесь меньшим, чем в том случае, когда вероятности обоих исходов равны. Заметим еще, что в практических задачах всегда представляет интерес только это среднее количество информации; представление же о количестве информации, связанном с отдельными исходами опыта, практически никогда не употребляется.

Информация относительно опыта β , содержащаяся в опыте α , все-

гда равна информации относительно α , содержащейся в β . Так как слож-

ные события αβ и βα не отличаются одно от другого, то H (αβ) = H (βα) ,

т. е.

H (α) + H α (β) = H (β) + H β (α) .

Поэтому

18

1 . Информационные процессы и средства их реализации

I (α,β) = H (β) − H α (β) = H (α) − H β (α) = I (β, α) .

Таким образом, информацию I (α,β) , которую содержит опыт α относитель-

но опыта |

β , |

можно также назвать взаимной информацией |

двух |

|||

опытов |

α |

и |

β друг |

относительно |

друга. Равенство I (α,β) и |

|

I (β, α) подчеркивается следующей простой формулой, которая во многих |

||||||

случаях оказывается весьма удобной |

|

|

||||

|

|

|

I (α,β) = H (α) + H (β) − H (αβ) . |

|

||

Эта формула |

вытекает |

из того, что |

H α (β) = H (αβ) − H (α) |

(ибо |

||

H (αβ) = H (α) + H α (β) ); в ее правую часть опыты α и β входят совершенно |

||||||

симметрично. |

|

|

|

|

|

|

Формулу |

|

|

|

|

||

|

|

|

|

I (α,β) = I (β, α) |

|

|

можно также записать в следующем виде: |

|

|

||||

|

|

|

|

I (α,β) = H (α) − H β (α) . |

|

|

Из нее следует, |

что информация I (α,β) , содержащаяся в опыте α относи- |

|||||

тельно опыта β , не превосходит энтропии H (α) опыта α − обстоятельст-

во, которое часто оказывается полезным. Впрочем, последнее предложение, разумеется, нельзя считать неожиданным: естественно, что информация, ко-

торую содержит опыт α о другом опыте β , не превосходит информации,

содержащейся в α относительно самого себя − энтропии H (α) этого опыта. Таким образом, энтропия H (α) может быть определена как наи-

большая информация, которая может содержаться в опыте α («полная информация», содержащаяся в α ).

Из формулы I (α,β) = H (α) − H β (α) вытекает также, что информация

I (α,β) точно равна энтропии H (α) опыта α в том и только в том случае,

когда условная энтропия H β (α) |

равна нулю, т. е. когда результат опыта β |

|

полностью |

определяет исход |

вспомогательного опыта α . Если же |

H β (α) ≠ 0 , |

то информация I (α,β) будет ровно на величину H β (α) меньше |

|

энтропии H (α) . В частности, если опыты α и β независимы (и только в этом случае) информация I (α,β) будет равна нулю.

19

1 . Информационные процессы и средства их реализации

1.3. Общая характеристика информационных процессов

Обмен информацией между источником и получателем производится в форме сообщений. Одно и то же информационное сообщение (статья в газете, объявление, письмо, чертеж, радиопередача и т. п.) может содержать разное количество информации для разных получателей – в зависимости от их текущих знаний, от уровня понимания этого сообщения и интереса к нему. Информация является для ее получателя источником знаний о внутреннем и внешнем мире. Следовательно, информация отражает реальный мир, который познается в процессе получения информации, т. е. до момента получения информации что-то было неизвестно или не определено, и благодаря полученной информации неопределенность была снята.

Таким образом, под информацией в широком смысле можно понимать сведения об объектах, процессах и явлениях реального мира, их свойствах, состояниях и отношениях, которые уменьшают имеющуюся о них степень неопределенности, неполноты знаний.

Информация является основным объектом информационных процессов

– процессов, связанных с поиском, обработкой, хранением и передачей информации.

Поиск информации

Поиск информации − это извлечение хранимой информации.

Примеры методов поиска информации: непосредственное наблюдение; общение со специалистом по интересующему вопросу; чтение соответствующей литературы; просмотр телепрограмм; запрос к информационным системам, базам и банкам данных. В процессе поиска встречается полезная и бесполезная, достоверная и ложная, объективная и субъективная информация. Для того чтобы получить наиболее полную информацию, необходимо использовать разнообразные методы ее поиска.

Обработка информации

Обработка информации − это преобразование информации из одного вида в другой, осуществляемое по строгим формальным правилам.

Правила обработки могут быть самыми разнообразными, при этом входная (исходная) информация преобразуется в выходную. Приведем примеры обработки информации.

20

1 . Информационные процессы и средства их реализации

Примеры |

Входная |

Выходная |

Правило |

|

информация |

информация |

|||

|

|

|||

|

|

|

|

|

Таблица |

Множители |

Произведение |

Правила |

|

умножения |

арифметики |

|||

|

|

|||

|

|

|

|

|

Постановка диаг- |

Жалобы пациента, |

Диагноз |

Правила логических |

|

ноза болезни |

результаты анализа |

операций |

||

|

||||

|

|

|

|

При обработке информации не всегда необходимо знать, по каким правилам входная информация преобразуется в выходную. Возможность автоматизированной обработки информации основывается на том, что при обработке информации, как правило, не используется ее содержание.

Хранение информации

Хранение информации – это способ распространения информации в пространстве и времени.

Способ хранения информации зависит от ее носителя (например, книга

– библиотека, картина – музей, фотография – альбом). Примеры средств хранения информации:

Для человека |

Для общества |

Электронные средства |

|

|

|

|

Библиотеки, видеотеки, фоно- |

Базы и банки данных, информаци- |

Память |

теки, архивы, патентные бюро, |

онно-поисковые системы, элек- |

|

музеи, картинные галереи |

тронные энциклопедии, медиатеки |

|

|

|

Хранение больших объемов информации оправдано только при условии, если поиск нужной информации можно осуществить достаточно быстро, а данные получить в доступной форме.

Передача информации

Информация передается в форме сообщений от некоторого источника информации к ее получателю посредством системы связи между ними.

Совокупность технических средств используемых для передачи сообщений от источника к получателю, называется системой связи.

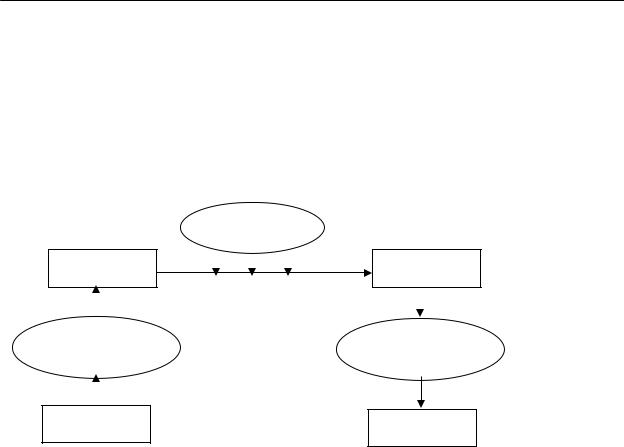

Общая схема системы связи представлена на рис. 1.1.

Канал связи − совокупность технических устройств, обеспечивающих передачу сигнала от передатчика к приемнику.

21

1 . Информационные процессы и средства их реализации

Кодирующее устройство предназначено для кодирования информации (преобразования исходного сообщения от источника информации к виду, удобному для передачи информации).

Декодирующее устройство предназначено для преобразования полученного сообщения в исходное.

|

Помехи |

Передатчик |

Приемник |

|

Канал связи |

Кодирующее |

Декодирующее |

устройство |

устройство |

Источник |

Получатель |

|

Рис. 1.1. Общая схема системы связи.

В процессе передачи из-за помех информация может теряться и искажаться, например, искажение звука в телефоне, атмосферные помехи в радио, искажение или затемнение изображения в телевидении, ошибки при передаче в телеграфе. Рассмотрим в качестве примера систему телефонной связи:

Источник информации |

Человек говорящий |

|

(сообщения) |

||

|

||

|

|

|

Кодирующее устройство |

Микрофон − преобразует звук в электрические |

|

сигналы |

||

|

||

|

|

|

Канал связи |

Телефонная сеть (провод) |

|

|

|

|

|

Та часть трубки, которую подносим к уху (здесь |

|

Декодирующее устройство |

электрические сигналы снова преобразуются в |

|

|

звук) |

|

|

|

|

Получатель информации |

Человек слушающий |

|

(сообщения) |

||

|

||

|

|

22

1 . Информационные процессы и средства их реализации

Кодирование информации

В своей деятельности человек часто использует модель объекта, явления или процесса. Под моделью понимается некоторый объект, отображающий исследуемый объект с сохранением его наиболее существенных свойств.

Информационная модель − знаковая модель, описывающая информационные процессы в системах самой разнообразной природы. При построении информационной модели объекта или явления необходимо определить вид представления информации.

Представление информации может осуществляться с помощью языков, которые являются знаковыми системами. Каждая знаковая система строится на основе определенного алфавита и правил выполнения операций со знаками. Примеры алфавита: алфавит кириллических букв, алфавит латинских букв, алфавит десятичных цифр. Особое значение имеют наборы, состоящие всего из двух знаков: пара знаков {+, −}, пара цифр {0, 1}, пара ответов {да, нет}. Алфавит, состоящий из двух знаков, называется двоичным алфавитом. В вычислительной технике широко используется двоичное кодирование с ал-

фавитом {0, 1}. Эти знаки называются двоичными цифрами, по-английски − binary digit, или сокращенно bit (бит). Одним битом могут быть представлены два понятия: 0 или 1 (да или нет, черное или белое, истина или ложь и т. п.). Если количество битов увеличить до двух, то уже можно будет представить четыре различных понятия:

00 |

01 |

10 |

11 |

Тремя битами можно представить восемь различных понятий:

000 |

001 |

010 |

011 |

100 |

101 |

110 |

111 |

С увеличением на единицу количества разрядов в системе двоичного кодирования, увеличивается в два раза количество понятий, которые могут быть представлены в данной системе. Общая формула имеет вид:

N = 2 m ,

где N − число независимых кодируемых понятий; m − разрядность двоично-

го кодирования, принятая в данной системе. Наиболее распространенными кодами являются ASCII (American standard code for information interchange −

американский стандартный код для обмена информацией) и КОИ-8 (код обмена информацией длиной 8 битов).

С точки зрения информатики наиболее важными представляются следующие свойства информации: объективность, полнота, достоверность, адекватность, доступность и актуальность информации.

23

1 . Информационные процессы и средства их реализации

Объективность и субъективность информации. Понятие объективно-

сти является относительным, так как методы получения и обработки информации, как правило, являются субъективными. Более объективной является та информация, в которую методы вносят меньшую субъективную составляющую. Например, в результате наблюдения фотоснимка природного объекта или явления формируется более объективная информация, чем в результате наблюдения выполненного человеком рисунка того же объекта. В ходе информационного процесса степень объективности информации всегда понижается.

Полнота информации. Полнота информации во многом характеризует качество информации и определяет достаточность данных для принятия решений или для создания новых данных на основе имеющихся. Чем полнее данные, тем проще подобрать методы поиска, обработки и передачи информации, вносящие минимальные погрешности в ход информационного процесса.

Достоверность информации. Данные формируются при регистрации сигналов, но не все сигналы являются «полезными» − всегда присутствуют посторонние сигналы некоторого уровня, в результате чего полезные данные сопровождаются определенным «информационным шумом». Чем более четко полезный сигнал различается на фоне посторонних сигналов, тем более достоверной будет информация.

Адекватность − свойство информации однозначно соответствовать объекту или явлению. Неадекватная информация может возникать при создании новой информации на основе неполных или недостоверных данных.

Доступность информации – мера возможности получить конкретную информацию. На степень доступности информации влияют как доступность данных, так и доступность адекватных методов для их интерпретации.

Актуальность информации – это степень соответствия информации текущему моменту времени. Поскольку информационные процессы растянуты во времени, то достоверная и адекватная, но устаревшая информация может приводить к ошибочным решениям.

24

1 . Информационные процессы и средства их реализации

1.4.Технические средства реализации информационных процессов

1.4.1.Электронные вычислительные машины

Вычислительной техникой называются устройства, предназначенные для использования в системах автоматической и автоматизированной обработки данных. Совокупность взаимосвязанных устройств вычислительной техники вместе с соответствующим программным обеспечением называется

электронной вычислительной машиной (ЭВМ), вычислительной системой

(ВС) или вычислительным комплексом (ВК). Таким образом, ЭВМ – это включающая необходимые аппаратные и программные средства система, предназначенная для автоматизации процесса обработки информации и вычислений.

С середины 60-х годов XX века подход к созданию вычислительных машин существенно изменился. Вместо независимой разработки аппаратуры и средств программного обеспечения стала проектироваться система, состоящая из совокупности аппаратных и программных средств. При этом на первый план выдвинулась концепция их взаимодействия. Рассмотрим основные понятия, связанные с архитектурой и структурой ЭВМ. Архитектуру ЭВМ следует отличать от ее структуры.

Под архитектурой ЭВМ понимается совокупность общих принципов организации аппаратно-программных средств и их характеристик, определяющая функциональные возможности ЭВМ при решении соответствующих классов задач.

Архитектура определяет принципы организации ЭВМ, алгоритмы взаимодействия компонентов ЭВМ, описание которых выполняется в той мере, в какой это необходимо для обеспечения взаимодействия компонентов. Так, пользователю ЭВМ безразлично, какие электронные элементы использованы для реализации аппаратных средств, с помощью аппаратных средств или программ реализуются команды и т. д. Важно другое: как те или иные структурные особенности ЭВМ связаны с возможностями, предоставляемыми пользователю, как связаны между собой характеристики отдельных устройств, входящих в состав ЭВМ, и какое влияние они оказывают на общие характеристики машины. Иными словами, архитектура ЭВМ отражает круг проблем, относящихся к общему проектированию и построению вычислительных машин и их программного обеспечения.

25